- 1图像去噪方法总结(最全,最详细),持续更新中......_图像去噪算法

- 2HarmonyOS开发(十二):ArkTS组件通用事件_鸿蒙arkts开发 监听返回

- 3IOS The linked library ‘xxxx.a/Framework‘ is missing

- 4【数学基础】 foundation of mathematics :Jensen不等式_mathematic求置信度

- 5Heygen,数字人分身生成网站_heygen前端代码分析

- 6Vision Transformer源码详解_vision transformer代码

- 7权值量化与霍夫曼编码_权值量化表

- 8PyTorch实战:聊天机器人

- 9拥抱AI大模型之美,帮你探索OpenAI大语言模型的能力(基础实战篇)_大模型 openai_key

- 10Python手册(Machine Learning)--statsmodels(列联表和多重插补)_python statsmodels

联邦学习、区块链论文笔记2_区块链 联邦学习 激励机制

赞

踩

论文题目:InFEDge: A Blockchain-Based Incentive Mechanism in Hierarchical Federated Learning for End-Edge-Cloud Communications

期刊:IEEE JOURNAL ON SELECTED AREAS IN COMMUNICATIONS.

时间: DECEMBER 2022

作者:Xiaofei Wang , Senior Member, IEEE, Yunfeng Zhao ,Chao Qiu , Member, IEEE,Zhicheng Liu , Jiangtian Nie , Member, IEEE, and Victor C. M. Leung , Life Fellow, IEEE

关键字:分层联邦学习、云边端、区块链、激励机制

1.背景

分层联邦学习(HFL)在保留联邦学习(FL)隐私保护的优点的同时,减轻了通信开销,同时具有高带宽和丰富的计算资源的优势。但分层联邦学习很难平衡该系统开销和模型性能,需要引入一个激励机制。激励机制能够通过补偿参与者解决上述问题,但是一些限制包括多维属性、不完整的信息、不可靠的参与者等,这些将降低所设计激励机制的性能和效率。

2.创新

本文提出了层级联邦学习环境下基于区块链的激励机制。主要解决了上述激励机制的设计限制。

首先考虑多维度的个体属性建模了激励问题并证明该模型存在唯一的纳什均衡解。

其次,在不完整信息情况下,将问题转换为一个契约博弈并求得最优解。

最后,利用区块链提供经济激励,防止不可靠的参与者的干扰并通过智能合约进一步确保数据隐私,提供可信、更快、透明的资源交易系统。

分层联邦学习的好处:HFL inherits the property of protecting data privacy while enabling

distributed training on massive end devices (a.k.a., client). Further, it leverages its advantages to train the global model with high accuracy and fast convergence at the lower layer, benefiting from high bandwidth and sufficient computation resources at the edge servers. Intuitively, HFL can avoid frequent cloud aggregations without performance degradation and be quickly applied in various fields (e.g., industrial or Internet scenarios) for AI-based services. Moreover, coordina-

tion by the edge servers in proximity allows for more efficient communication and computation resource allocation among clients.

分层联邦学习存在的问题:massive model parameters need to be exchanged in multiple layers and multiple update iterations in a typical HFL system, regardless of synchronous update [14] and its variants [15] or asynchronous update [16]. Due to the high real-time and reliable communication requirements of the future scenarios, the networks with a high communication load will be overwhelmed by the large number of parameter uploads from clients in HFL. Further, training models in HFL systems at corresponding nodes consume multiple limited resources

and face heavy communication and computation overheads. The extreme operations of greatly reducing the number of parameter uploads or data training will significantly decline model performance. Hence, how to strike an optimal balance between system overhead and model performance remains to be tackled in the HFL system.

3.系统模型

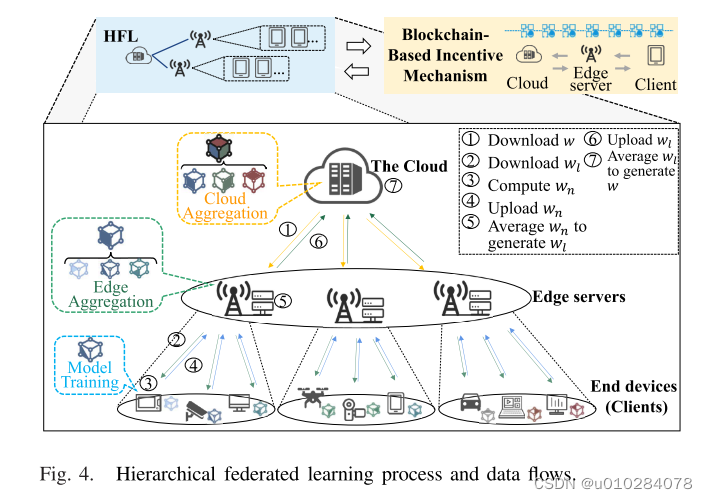

HFL框架由1个云服务器,L个边缘服务器和N个客户端组成。

(1)云:云发布任务,目的是获得满意的模型并且获得相应收益。因此,云向边缘服务器支付费用并间接激励客户端参与训练。

(2)边缘:每个边缘服务器连接一堆客户端,每个客户端只连接到一个边缘并且在训练期间保持不变。边缘服务器作为HFL的中间层,需要聚合模型参数并且平衡云和客户端的收益。

(3)客户端:共有N个客户端,每个客户端n连接到边缘服务器μ(n)。每个客户端有一个数据集,数据质量为θn,可以通过本地数据集测试得到,质量与准确率的关系 θn = −η/log( ξn)。

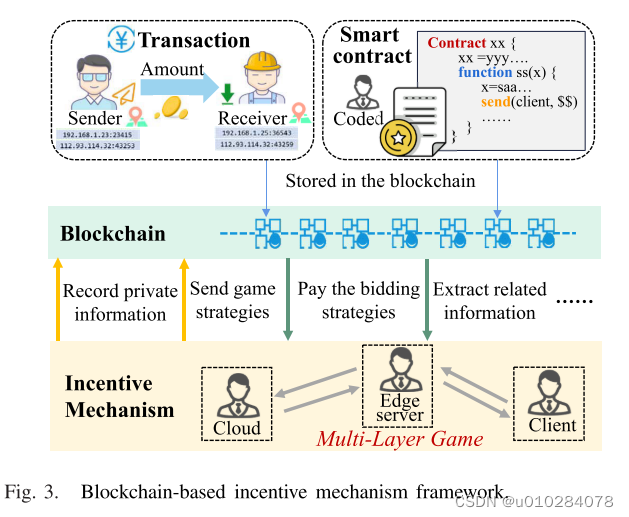

(4)区块链:引入基于区块链的激励机制保障公共权威和公平性, 事务存储在包含时间戳和引用的块中,并以链的形式增长。

4. 训练过程

每次全局迭代包括边缘聚合和云聚合。每个客户端进行Tw次本地更新后,边缘服务器进行一次聚合。进行Te次边缘聚合后,云端聚合边缘传输的模型。假设云每轮聚合Tc次。

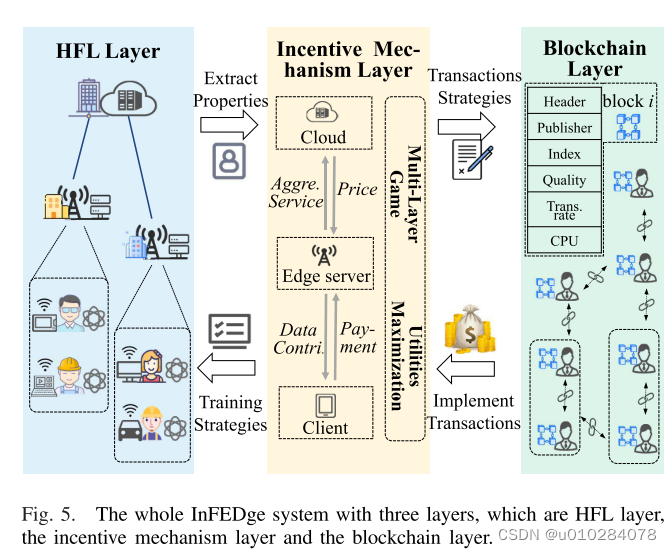

5.基于区块链的激励机制设计

利用区块链设计公平、透明可信的激励机制。 区块链用于验证关键参数和管理激励机制下的参与者经济激励,相关数据存储在区块链上。

(1)HFL层

HFL层的参与者将他们的关键参数更新(例如,数据质量、通信条件和计算能力)上传到区块链。此外,根据激励机制和经济激励的指导策略实施模型训练。

(2)blockchain层

不仅验证和维护相关更新,而且根据激励机制的输出策略实施经济激励的发布。使用智能合约实现所提出的激励机制。

(3)激励机制层

通过读取相应的参数,计算出相应的策略,以指导HFL的培训过程以及如何提供适当的经济激励。

整个INFEDGE系统能够更好地管理参与者,保证模型训练过程中所贡献数据的质量和数量,提高模型的性能。 此外,它还防止恶意参与者攻击系统和隐私泄露。

6.激励过程建模