- 12023年第十三届APMCM亚太地区大学生数学建模竞赛C题深度剖析(基于多元线性回归+时间序列模型)_apmcm亚太地区大学生数学建模竞赛2023年c题

- 2《苍穹外卖》电商实战项目(java)知识点整理(P1~P65)【上】_电商项目csdn

- 3运行rviz时出现[ERROR]: Could not load model、Cannot locate resource package错误_could not load pixmap 'package://rviz/icons/rotate

- 4【哈希表】(三) 实际应用 - 哈希映射

- 5利用AI来优化生产力,实现企业“提质增效“的目标_为了提质增效某公司决定启用人工智能

- 6HuggingFace(一) | 一起玩预训练语言模型吧_automodelforsequenceclassification.from_pretrained

- 7基于开源项目kkFileView打造文件预览_预览源文件来自未授信的目录,请停止访问!

- 8shortcut icon图标移动端和PC端设置_shortcut icon用法

- 9❤ 一张图看懂神经网络的符号参数(+向量化的注意事项)_小于号在神经网络中是什么运算

- 10openharmony开发最新4.0版本---数据库连接(基于api10,devstudio4.0) 中首选项preferences的工具类的使用_openharmony datapreferences

【目标检测】2024最新-用Yolov8训练自己的数据集(保姆级教学)_新版yolov8怎么

赞

踩

【2024.1】

1.为打开网页流畅,建议准备梯子,打开Github等网站时会明显加快

2.准备Anaconda,官网:Anaconda | Unleash AI innovation and value

一、代码下载

1.在官网下载 yolov8源代码(建议用梯子)

2.文件名为ultralytics-main(建议保存至D盘:D:\ultralytics-main)

二、环境配置

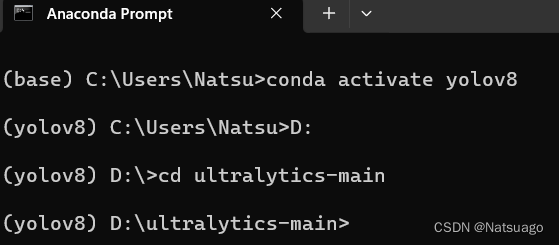

1.在Anaconda中利用conda命令创建环境yolov8,并激活环境

- -- 创建环境

- conda create -n yolov8 python=3.8

-

- -- 激活环境

- conda activate yolov8

2.pip的源换到国内aliyun镜像,会提高下载速度

pip config set install.trusted-host mirrors.aliyun.com

3.安装配置文件:

(1)要求conda环境cd到ultralytics-main目录下:

(2)然后安装配置文件:

pip install -r requirements.txt

4.安装一下yolov8在python>=3.8版本必要安装包:

pip install ultralytics

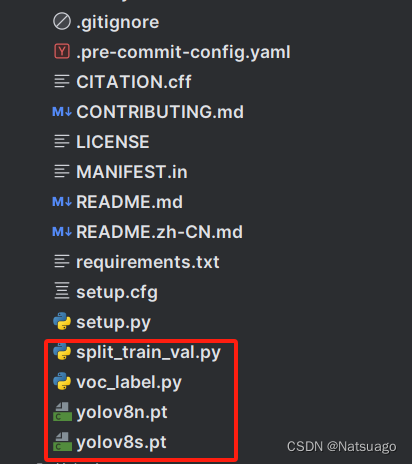

5.下载预训练权重模型:

(1)推荐yolov8s.pt或者yolov8n.pt,模型小,下载快(用梯子)

(2)下载完成后,将模型放在ultralytics-main文件夹下

6.检验环境:

(1)同样先要求conda环境cd到ultralytics-main目录下(参考3.(1))

(2)运行以下指令:

yolo predict model=yolov8n.pt source='ultralytics/assets/bus.jpg'

(3)若运行成功会在D:\ultralytics-main下生成\runs\detect\predict,且文件中会包含一张照片

三、训练模型

【CPU】

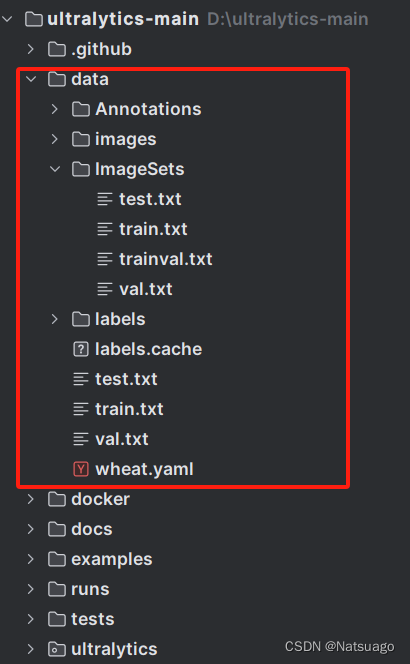

1.准备工作:

(1)在ultralytics-main目录下新建data文件夹;

(2)再在data目录下新建四个文件夹:Annotations文件夹,images文件夹,ImageSets文件夹,labels文件夹

2.准备数据集:

(1)将准备好的图片以.jpg的格式放入images文件夹中

(2)利用labelimg进行标注后将生成的.xml文件保存至Annotations文件夹中

3.数据集的划分:

(1)在ultralytics-main目录下创建一个split_train_val.py文件;

(2)运行文件之后会在imageSets文件夹下将数据集划分为训练集train.txt、验证集val.txt、测试集test.txt,里面存放的就是用于训练、验证、测试的图片名称,代码内容如下:

- import os

- import random

-

-

- trainval_percent = 0.9

- train_percent = 0.9

- xmlfilepath = 'data/Annotations'

- txtsavepath = 'data/ImageSets'

- total_xml = os.listdir(xmlfilepath)

-

- num = len(total_xml)

- list = range(num)

- tv = int(num * trainval_percent)

- tr = int(tv * train_percent)

- trainval = random.sample(list, tv)

- train = random.sample(trainval, tr)

-

- ftrainval = open('data/ImageSets/trainval.txt', 'w')

- ftest = open('data/ImageSets/test.txt', 'w')

- ftrain = open('data/ImageSets/train.txt', 'w')

- fval = open('data/ImageSets/val.txt', 'w')

-

- for i in list:

- name = total_xml[i][:-4] + '\n'

- if i in trainval:

- ftrainval.write(name)

- if i in train:

- ftrain.write(name)

- else:

- fval.write(name)

- else:

- ftest.write(name)

-

- ftrainval.close()

- ftrain.close()

- fval.close()

- ftest.close()

4.转化数据集格式:

(1)在ultralytics-main目录下创建一个voc_label.py文件

(2)运行后会生成转换后labels文件夹下图片的txt文件,还会在data文件夹下得到三个包含数据集路径的txt文件,train.tx,tes.txt,val.txt这3个txt文件为划分后图像所在位置的绝对路径

(3)代码内容如下:

- import xml.etree.ElementTree as ET

- import os

- from os import getcwd

-

- sets = ['train', 'val', 'test']

- classes = ['填写自己的类别']

- abs_path = os.getcwd()

- print(abs_path)

-

-

- def convert(size, box):

- dw = 1. / (size[0])

- dh = 1. / (size[1])

- x = (box[0] + box[1]) / 2.0 - 1

- y = (box[2] + box[3]) / 2.0 - 1

- w = box[1] - box[0]

- h = box[3] - box[2]

- x = x * dw

- w = w * dw

- y = y * dh

- h = h * dh

- return x, y, w, h

-

-

- def convert_annotation(image_id):

- in_file = open('data/Annotations/%s.xml' % (image_id), encoding='UTF-8')

- out_file = open('data/labels/%s.txt' % (image_id), 'w')

- tree = ET.parse(in_file)

- root = tree.getroot()

- size = root.find('size')

- w = int(size.find('width').text)

- h = int(size.find('height').text)

- for obj in root.iter('object'):

- # difficult = obj.find('difficult').text

- difficult = obj.find('difficult').text

- cls = obj.find('name').text

- if cls not in classes or int(difficult) == 1:

- continue

- cls_id = classes.index(cls)

- xmlbox = obj.find('bndbox')

- b = (float(xmlbox.find('xmin').text), float(xmlbox.find('xmax').text), float(xmlbox.find('ymin').text),

- float(xmlbox.find('ymax').text))

- b1, b2, b3, b4 = b

- # 标注越界修正

- if b2 > w:

- b2 = w

- if b4 > h:

- b4 = h

- b = (b1, b2, b3, b4)

- bb = convert((w, h), b)

- out_file.write(str(cls_id) + " " + " ".join([str(a) for a in bb]) + '\n')

-

-

- wd = getcwd()

- for image_set in sets:

- if not os.path.exists('data/labels/'):

- os.makedirs('data/labels/')

- image_ids = open('data/ImageSets/%s.txt' % (image_set)).read().strip().split()

- list_file = open('data/%s.txt' % (image_set), 'w')

- for image_id in image_ids:

- list_file.write(abs_path + '/data/images/%s.jpg\n' % (image_id))

- convert_annotation(image_id)

- list_file.close()

5.编写数据集配置文件:

在ultralytics-main目录下创建 wheat.yaml,代码内容如下:

- train: D:/ultralytics-main/data/train.txt

- val: D:/ultralytics-main/data/val.txt

- test: D:/ultralytics-main/data/test.txt

-

- nc: 5 # 填写类别数

-

- names: ["填写自己的类别"]

-

- # train,val,test的路径根据自己情况而定

6.下载CPU版pytorch:

(1)具体网站(用梯子):Previous PyTorch Versions | PyTorch 选择找到与cpu相关的pip指令,例如:

(2)在conda创建的yolov8环境中输入找到的pip指令,等待下载完成即可

7.命令行运行:

(1)同样先要求conda环境cd到ultralytics-main目录下(参考二、3.(1))

(2)运行训练指令:

yolo train data=data/data.yaml model=yolov8s.pt epochs=300 imgsz=640 batch=8 workers=0 device=cpudata为yaml配置文件,后边填写你的配置文件的绝对路径

model为下载的预训练模型,在主文件下

epochs为训练轮数

imagez为训练时ai看到的图片大小,检查大图片建议使用640,小图片可以320 越大越吃性能

batch为一轮训练中每一次放入图片数量,越大越快效果越好,但是对性能要求越高

device为使用的设备,使用cpu练就写cpu,使用显卡大多数都是0,多显卡就0,1,2...多少显卡往后写多少

【GPU】

1.检查自己电脑的CUDA版本:

(1)点击键盘 win + i ,输入cmd,敲击回车

(2)输入以下指令:

nvidia-smi

(3)显示出以下内容说明系统已安装CUDA:

eg:若未显示此界面,则去CUDA官网下载与系统兼容版本

eg:若未显示此界面,则去CUDA官网下载与系统兼容版本

2.下载pytorch:

(1)只能下载 <= CUDA Version的pytorch版本,这里我们选择找到pip相关指令

(2)具体网站:(用梯子)Previous PyTorch Versions | PyTorch

(3) 在conda创建的yolov8环境中输入找到的pip指令,等待下载完成即可

3. 运行命令行:

(1)参考【CPU】1--5

(2) 同样先要求conda环境cd到ultralytics-main目录下(参考二、3.(1))

(3)运行以下指令:

yolo train data=data/wheat.yaml model=yolov8s.pt epochs=300 imgsz=640 batch=8 workers=0 device=0data为yaml配置文件,后边填写你的配置文件的绝对路径

model为下载的预训练模型,在主文件下

epochs为训练轮数

imagez为训练时ai看到的图片大小,检查大图片建议使用640,小图片可以320 越大越吃性能

batch为一轮训练中每一次放入图片数量,越大越快效果越好,但是对性能要求越高

device为使用的设备,使用cpu练就写cpu,gpu使用显卡大多数都是0,多显卡就0,1,2,3,...多少显卡往后写多少

四、过程细节

1.最终 ultralytics-main 目录下整体情况如下:

eg :红色框内部分为自己添加的部分,runs文件夹的生成参考二、6.(3)

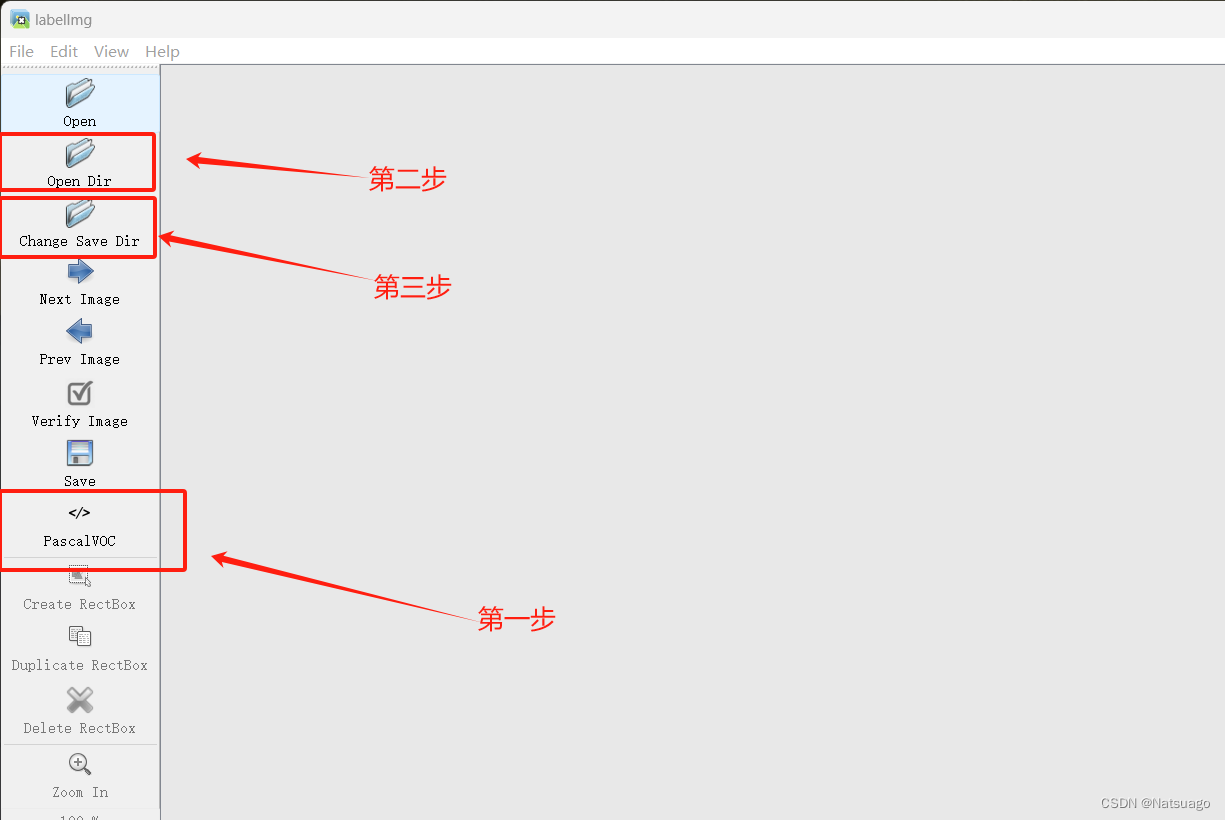

2. 使用labelimg标注数据集转.xml格式

(1)安装并打开labelimg

① 在conda创建新环境labelimg,指令如下:

conda create -n labelimg python=3.10 #如果只安装了一个python版本,python=3.10也可以不加,

② 激活lalelimg环境,指令如下:

conda activate labelimg

③ 在此环境下安装labelimg,指令可如下:

- pip install labelimg -i https://pypi.tuna.tsinghua.edu.cn/simple #不推荐,会出现依赖缺失或者版本不匹配问题

-

- conda install labelimg #推荐用此方法安装

eg:以一种方式安装即可

④ 打开labelimg,指令如下:

labelimg

(2)使用labelimg

① 打开labelimg:

② 使用介绍:

③ 与三、3.数据集划分相关步骤:

Ⅰ选择PascalVOC(即.xml格式)

Ⅱ 点击Open Dir打开文件夹D:\ultralytics-main\data\images中的.jpg格式的图片

Ⅲ Change Save Dir选择文件夹D:\ultralytics-main\data\Annotations

Ⅳ 打好标签以后若先前勾选View-Auto Save mode选项即可自动保存

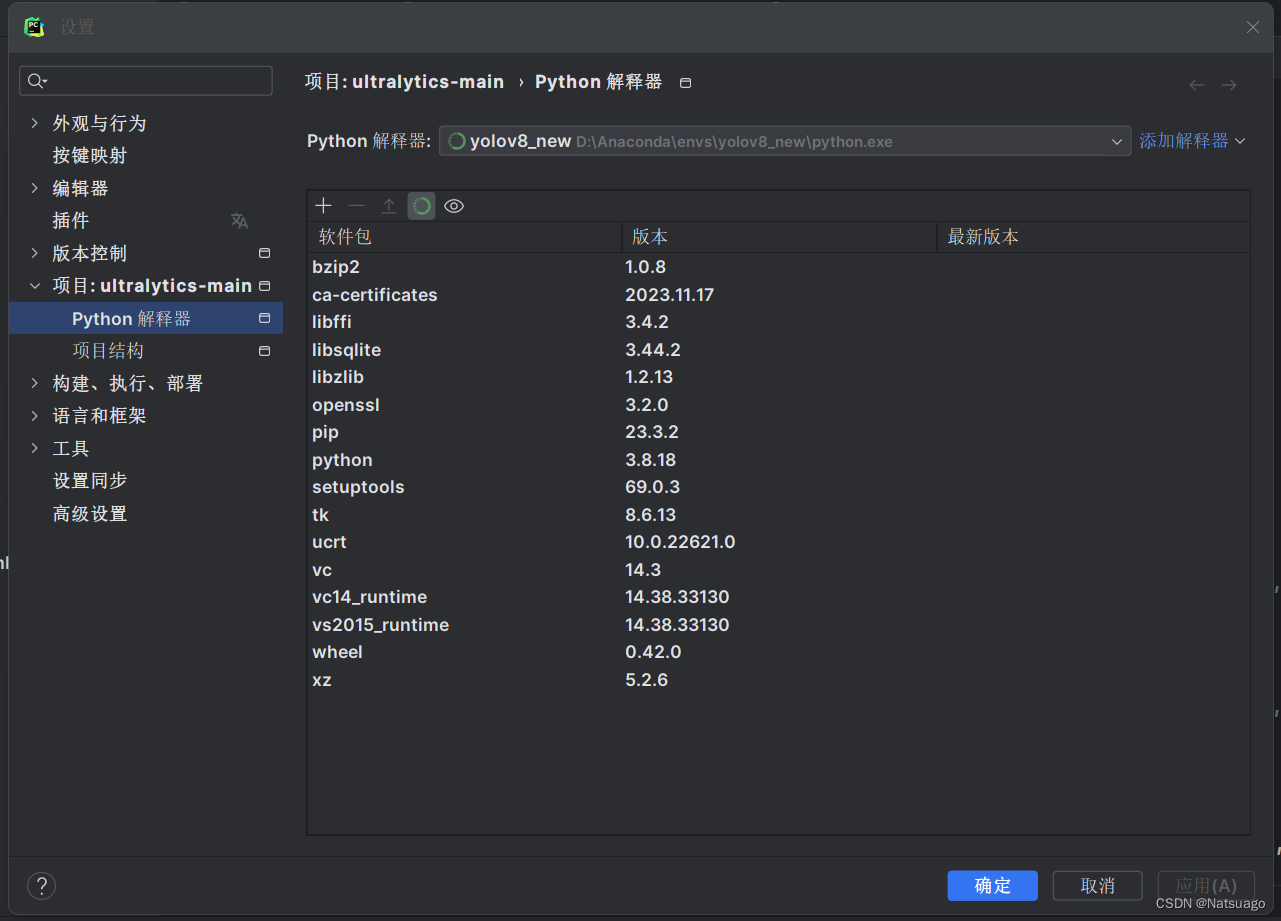

3.Pycharm项目解释器的选择

我使用的是Pycham2023.3.2版本,截止2024.1最新版本,解释器环境选择的conda环境,具体内容如下:

eg:这里我使用的另一个yolov8_new环境,你们选择先前创建的yolov8环境即可,若你们Anaconda路径安装在D盘,则路径大概为"D:\Anaconda\envs\yolov8\python.exe"

eg:这里我使用的另一个yolov8_new环境,你们选择先前创建的yolov8环境即可,若你们Anaconda路径安装在D盘,则路径大概为"D:\Anaconda\envs\yolov8\python.exe"