热门标签

热门文章

- 1MYSQL事务与MVCC_mysql中的事务和mvcc

- 2【自然语言处理(NLP)】基于PaddleNLP的短文本相似度计算_paddle短文本相似度计算

- 3python-django 招聘数据可视化系统_django招聘网站数据可视化

- 4【Python实战】随机图像数据集自动生成(原创)_python randimage

- 5Sora技术分解(dw00)

- 6二手车价格预测 | 构建AI模型并部署Web应用 ⛵_scikitlearn二手车价格预测模型

- 7改进YOLOv7 | 在 ELAN 模块中添加【Triplet】【SpatialGroupEnhance】【NAM】【S2】注意力机制 | 附详细结构图_triplet改进yolo

- 8年度书单盘点 | 史上最卷考研潮过后,这十本书让你不再迷茫

- 9【情商智慧:630】你混得好不好,这些能力很重要_高情商:630年 dddd

- 10美团NLP以及知识图谱文章提炼_iterative strategy for named entity recognition wi

当前位置: article > 正文

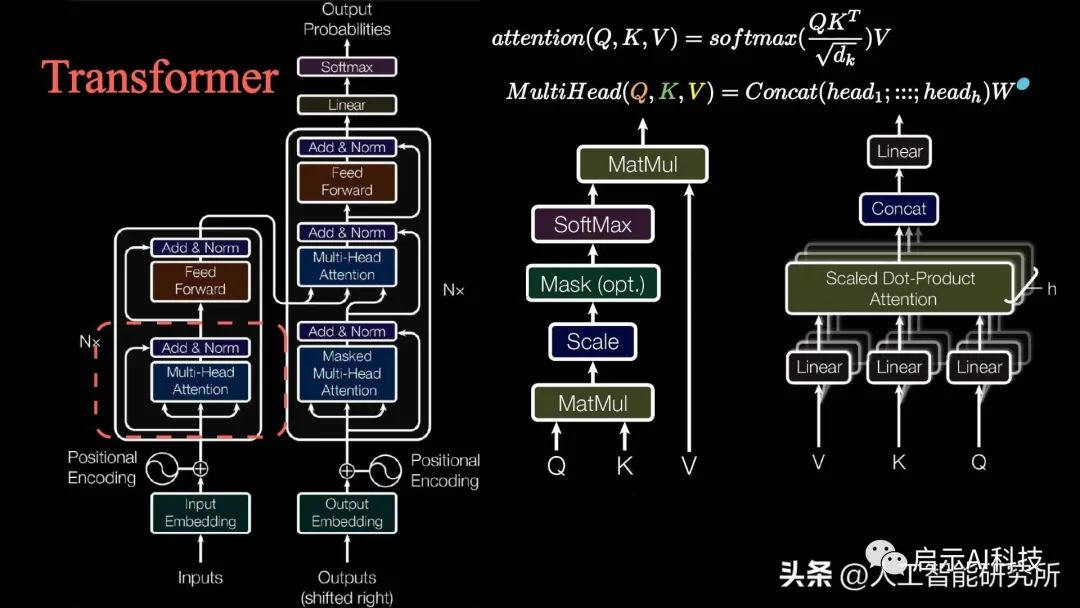

动画详解Transformer模型注意力机制的概念与模型搭建_如何从transformer的多头中取出qkv

作者:花生_TL007 | 2024-03-31 00:49:25

赞

踩

如何从transformer的多头中取出qkv

多头注意力机制

通过上一期的分享,我们了解了transformer模型中的多头注意力机制的概念,且通过7个attention注意力机制的变形,彻底了解了tranformer模型的多头注意力机制,哪里重点介绍了multi-head attention多头注意力机制中的Q K V 三矩阵。

——1——

Transformer模型注意力机制计算

其实QKV矩阵的来历比较简单,如下视频动画讲解了QKV三矩阵的来历

这里我们的输入矩阵I分别乘以权重矩阵Wq,Wk,Wv三个矩阵,就得到了输入transformer模型的QKV三矩阵,QKV三矩阵用在transformer模型计算注意力,根据attention is all you need论文中计算注意力机制的公式,我们通过以上得到的QKV三矩阵来计算注意力机制。

推荐阅读

相关标签