热门标签

热门文章

- 1【腾讯云 TDSQL-C Serverless 产品体验】饮水机式使用云数据库_云数据库 tdsql-c mysql

- 2Fine-tune之后的NLP新范式:Prompt越来越火,CMU华人博士后出了篇综述文章

- 3数学建模之MATLAB使用_matlab建模

- 4ELAdmin后台启动

- 5深度学习:学习路线与规划_深度学习学习路线

- 6基于WEB的产品管理系统_web管理

- 7【机器学习】推荐系统、机器学习面试题整理_交叉熵损失函数具有易于计算梯度

- 8python爬取抖音用户数据_一篇文章教会你用Python抓取抖音app热点数据

- 9【娱乐向】Java古风玛丽苏诗句生成器_古风词句生成器

- 10【雷达信号处理】基于matlab实现雷达信号采集数据处理(时频谱图)附Matlab代码_matlab 如何根据雷达数据产生时频谱图

当前位置: article > 正文

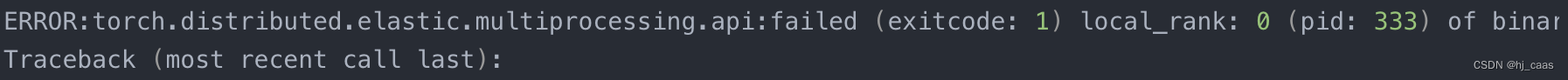

错误:ERROR:torch.distributed.elastic.multiprocessing.api:failed

作者:繁依Fanyi0 | 2024-04-09 04:39:35

赞

踩

error:torch.distributed.elastic.multiprocessing.api:failed (exitcode: 2) loc

在多卡运行时,会出现错误(ERROR:torch.distributed.elastic.multiprocessing.api:failed),但是单卡运行并不会报错,通常在反向梯度传播时多卡梯度不同步。但我是在多卡处理数据进行tokenizer阶段报错,这竟然也会出错,还没涉及到训练,有点不明所以。

1. 错误

2. 解决方法

设置find_unused_parameters=True.

3. 参考

[1] https://blog.csdn.net/QLeelq/article/details/130404416

[2] https://zhuanlan.zhihu.com/p/592515484

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/繁依Fanyi0/article/detail/390401

推荐阅读

相关标签