热门标签

热门文章

- 1Ubuntu18.04安装indicator-sysmonitor显示CPU、网速

- 28_3、mysql读写分离且分库分表_mysql分库分表和读写分离都要做吗

- 3JS获取/格式化日期(附JS获取昨日、今日、上周、本周、上月、本月方法)_js获取格式化时间

- 4Centos安装docker

- 5Property or method “item“ is not defined on the instance but referenced during render._"property or method \"item\" is not defined on the

- 6AIGC大模型之——以文生图介绍_文生图综述

- 7Nacos 配置中⼼_

com.alibaba.cloud - 8django扩展AbstractUser创建两张用户表,用于维护两种对象,比如一方是卖家,一方是买家。报错,已解决_add or change a related_name argument to the defin

- 9ScrollView滚动到底部3种方案(巧解现实产品一个需求)_scrollview滑动到底部

- 10uniapp小程序设置页面横屏_uniapp如何控制页面横屏显示

当前位置: article > 正文

Language Modeling with Gated Convolutional Networks ( GLU )理解_glu模型

作者:知新_RL | 2024-03-27 23:43:00

赞

踩

glu模型

简介

门控线性单元(GLU)是卷积神经网络中的一种门控机制,与循环神经网络的门控循环单元(GRU)不同的的是更加进行梯度容易传播,不易造成梯度消失或者梯度爆炸。而且在计算时间上也大幅度减少。

GLU计算过程

卷积网络就是对输入进行卷积以获得H = f ∗ w,因此没有时间依赖性,这使得在句子的单个单词上更容易并行化。这个计算过程将根据多个先前单词来计算每个上下文。 与递归网络相比,上下文的大小是有限的,但可以表示足够大的上下文并且在实践中表现良好。

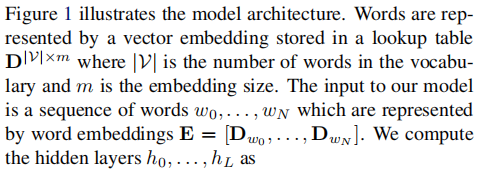

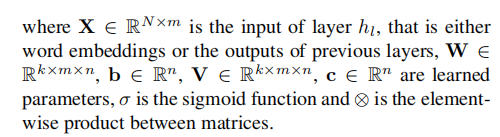

词时使用存储在词嵌入矩阵中的向量表示的,词汇表大小D|V|×m,|V|是词汇表达小,m是嵌入维度,模型的输入是单词序列是 W0,…, Wm, 由词嵌入E = [Dw0,… ,DwN]表示。 计算隐藏层h0,…, hL为:

原文:

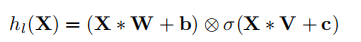

图一为下侧GLU模型架构图

图一为下侧GLU模型架构图

在对输入进行卷积时,要注意hi不包含将来单词的信息。 这是通过移动卷积输入以防止内核看到未来的上下文来解决此问题。具体来说,作者使用k / 2个元素对序列的开头进行零填充,假设第一个输入元素是我们无法预测的,是序列标记的开始,其中k是卷积内核的宽度。

门控机制

门控机制控制信息在网络中流动的路径,并已被证明对递归神经网络很有用。LSTMs通过一个由输入和忘记门控制的独立单元实现长期记忆。这允许信息在可能的许多时间步长中畅通无阻地流动。没有这些门,信息很容易在每个时间步的转换中消失。相反,卷积网络不会遭受相同类型的梯度消失的影响,通过实验发现卷积网络不需要忘记门。

因此,门控线性单元仅具有输出门,该输出门允许网络控制应在层级结构中传播的信息。这种机制对语言建模很有用,因为它允许模型选择与哪些单词或特征相关的单词来预测下一个单词。

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/知新_RL/article/detail/327588

推荐阅读

相关标签