- 1HCIP-HCS华为私有云的使用_华为hcs

- 2西工大noj c语言前四十五道_c语言noj飞机起飞速度代码

- 3001基于Python网站爬虫的设计与实现_网络爬虫系统设计与实现

- 4CSS属性

- 5卷爆了,看 SPViT 把 Transformer 结构剪成 ResNet 结构_替换resnet 结构

- 6功能强大的API函数FindFirstFile使用介绍(附源码)_pb中findfirst()使用哪个函数

- 7【深度优先搜索】【树】【图论】2973. 树中每个节点放置的金币数目_树中每个节点放置的金币个数

- 8AWS IOT Device C SDK 使用(一机一密、一型一密、公钥、私钥、CA、根证书、签名、预签名、验签、哈希、X.509)_aws-iot-device

- 9华为云鸿蒙应用入门级开发者认证即将上线,亮点抢先看

- 10记录下来自己看看——Anaconda Prompt 怎么切换工作路径到E盘 以及更改默认打开路径_anaconda prompt中无法从c盘直接定位到e盘

Kafka入门,这一篇就够了(安装,topic,生产者,消费者)_kafka消费者组topic和sink(2)_kafka topic 消费组

赞

踩

本人从事网路安全工作12年,曾在2个大厂工作过,安全服务、售后服务、售前、攻防比赛、安全讲师、销售经理等职位都做过,对这个行业了解比较全面。

最近遍览了各种网络安全类的文章,内容参差不齐,其中不伐有大佬倾力教学,也有各种不良机构浑水摸鱼,在收到几条私信,发现大家对一套完整的系统的网络安全从学习路线到学习资料,甚至是工具有着不小的需求。

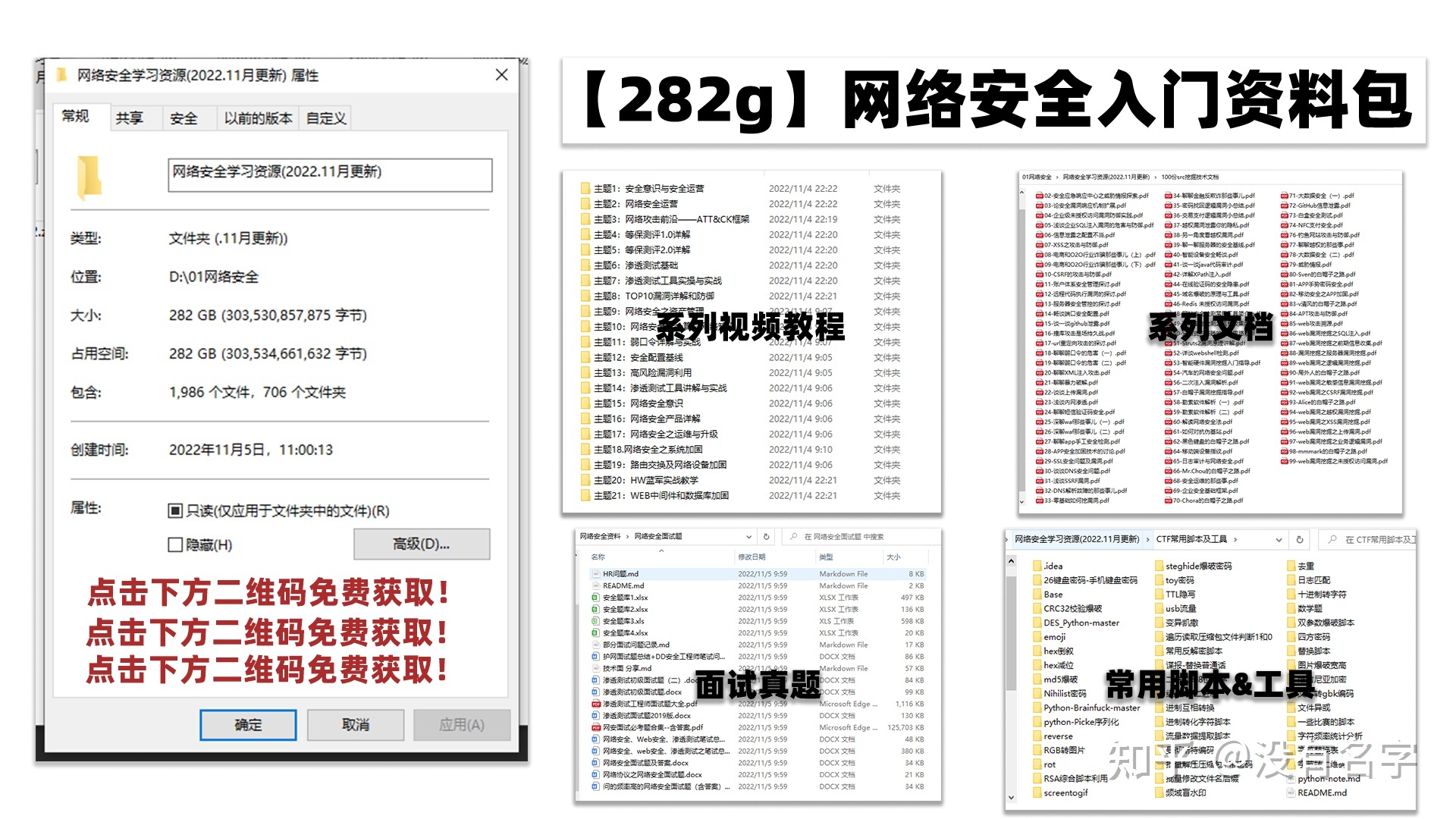

最后,我将这部分内容融会贯通成了一套282G的网络安全资料包,所有类目条理清晰,知识点层层递进,需要的小伙伴可以点击下方小卡片领取哦!下面就开始进入正题,如何从一个萌新一步一步进入网络安全行业。

需要体系化学习资料的朋友,可以加我V获取:vip204888 (备注网络安全)

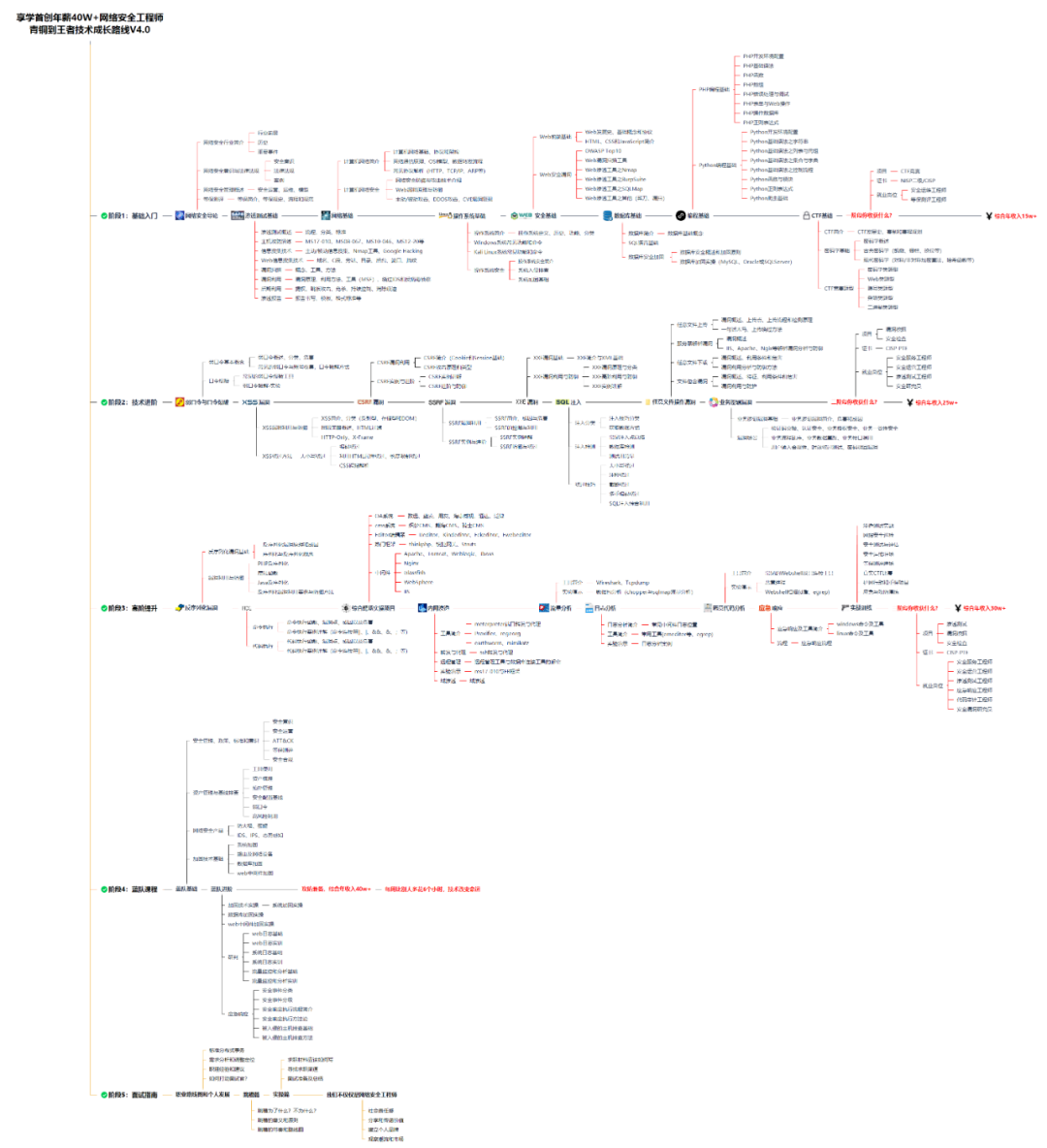

学习路线图

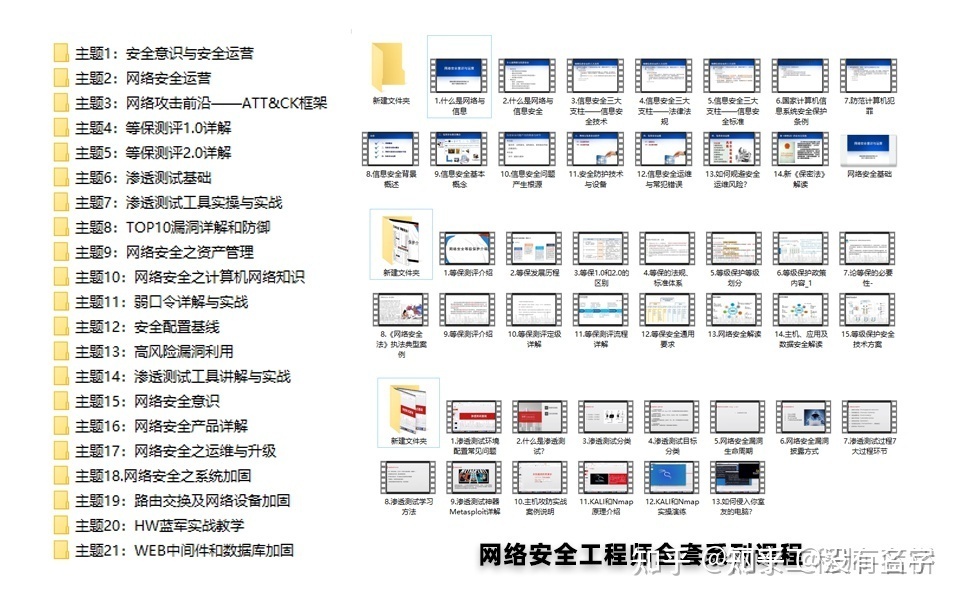

其中最为瞩目也是最为基础的就是网络安全学习路线图,这里我给大家分享一份打磨了3个月,已经更新到4.0版本的网络安全学习路线图。

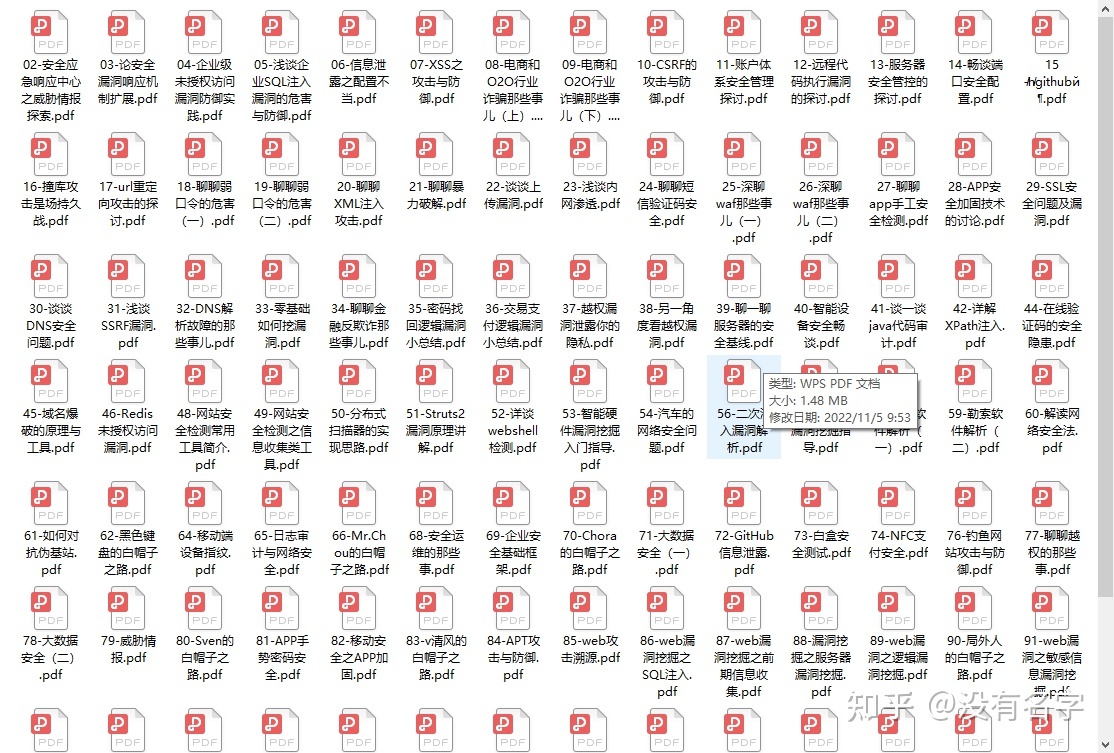

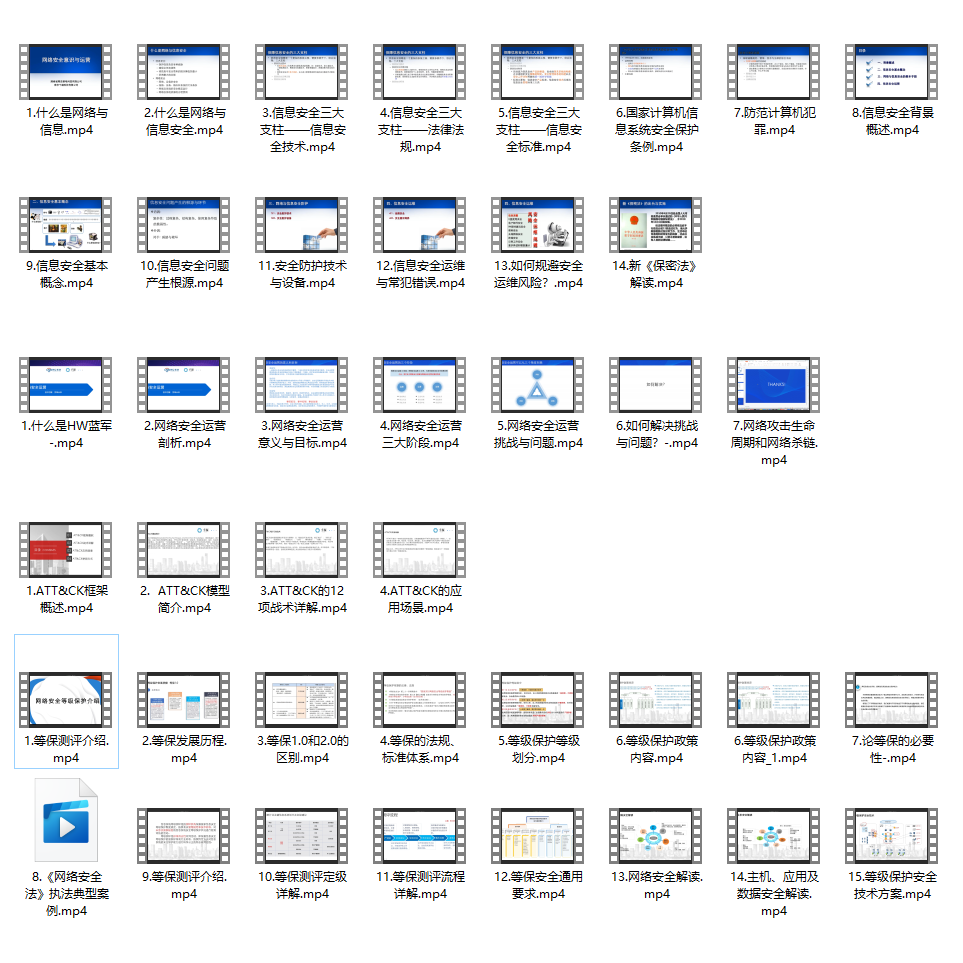

相比起繁琐的文字,还是生动的视频教程更加适合零基础的同学们学习,这里也是整理了一份与上述学习路线一一对应的网络安全视频教程。

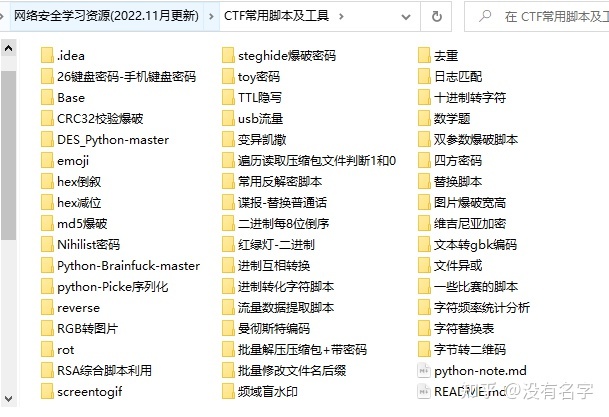

网络安全工具箱

当然,当你入门之后,仅仅是视频教程已经不能满足你的需求了,你肯定需要学习各种工具的使用以及大量的实战项目,这里也分享一份我自己整理的网络安全入门工具以及使用教程和实战。

项目实战

最后就是项目实战,这里带来的是SRC资料&HW资料,毕竟实战是检验真理的唯一标准嘛~

面试题

归根结底,我们的最终目的都是为了就业,所以这份结合了多位朋友的亲身经验打磨的面试题合集你绝对不能错过!

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!

- bin: 脚本目录

- config:配置目录

- libs:第三方依赖库目录

- logs:日志

bin

重要的shell脚本加粗了,之后会用

connect-distributed.sh kafka-dump-log.sh kafka-storage.sh

connect-mirror-maker.sh kafka-features.sh kafka-streams-application-reset.sh

connect-standalone.sh kafka-get-offsets.sh kafka-topics.sh

kafka-acls.sh kafka-leader-election.sh kafka-transactions.sh

kafka-broker-api-versions.sh kafka-log-dirs.sh kafka-verifiable-consumer.sh

kafka-cluster.sh kafka-metadata-shell.sh kafka-verifiable-producer.sh

kafka-configs.sh kafka-mirror-maker.sh trogdor.sh

kafka-console-consumer.sh kafka-producer-perf-test.sh windows

kafka-console-producer.sh kafka-reassign-partitions.sh zookeeper-security-migration.sh

kafka-consumer-groups.sh kafka-replica-verification.sh zookeeper-server-start.sh

kafka-consumer-perf-test.sh kafka-run-class.sh zookeeper-server-stop.sh

kafka-delegation-tokens.sh kafka-server-start.sh zookeeper-shell.sh

kafka-delete-records.sh kafka-server-stop.sh

config

connect-console-sink.properties connect-mirror-maker.properties server.properties

connect-console-source.properties connect-standalone.properties tools-log4j.properties

connect-distributed.properties consumer.properties trogdor.conf

connect-file-sink.properties kraft zookeeper.properties

connect-file-source.properties log4j.properties

connect-log4j.properties producer.properties

配置文件

server.properties

- broker.id: 唯一id值,通过环境变量设置为了1

- log.dirs: kafka集群日志目录,默认是log.dirs=/bitnami/kafka/data

- zookeeper.connect:zookeeper地址端口,格式域名/ip:port,这块是zookeeper:2181,在docker的网络中可以解析为另一容器的ip

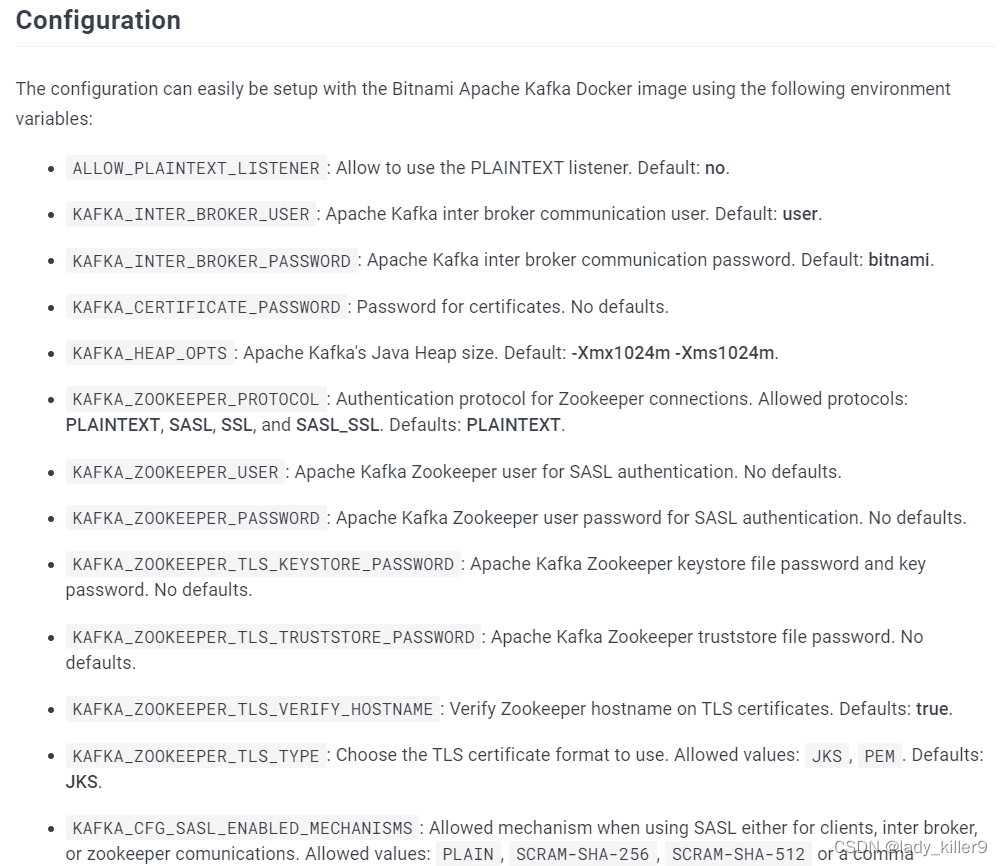

更多配置可以查看参考中Dockerhub链接的Configuration部分

producer.properties

- bootstrap.servers:kafka的ip:port,这里是localhost:9092

- compression.type:压缩类型,默认是none, 一共有四种,none, gzip, snappy, lz4, zstd,推荐排序LZ4 > GZIP > Snappy,详见腾讯云压缩算法对比

consumer.properties

- group.id:消费者组id,默认为test-consumer-group

- auto.offset.reset:offset设置,三种latest, earliest, none,看情况设置

命令行简单使用

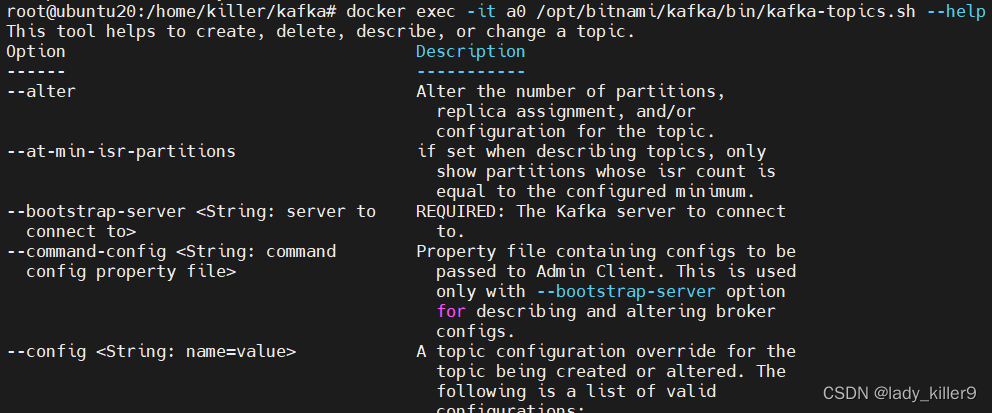

kafka-topics.sh

对主题topic进行增删改查的工具

常用选项如下:

- –bootstrap-server:kafka服务器ip:port,必须的

- –create:创建主题

- –delete:删除主题

- –describe:描述主题

- –list:查看主题列表

- –alter:修改主题的 partitions等

- –topic <String: topic>:主题名

- –topic-id <String: topic-id>:主题id

- –partitions <Integer: # of partitions>:主题的partition

新增

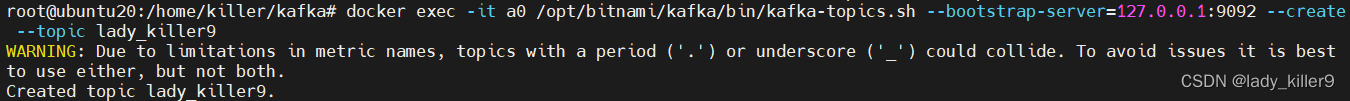

命令

docker exec -it a0 /opt/bitnami/kafka/bin/kafka-topics.sh --bootstrap-server=127.0.0.1:9092 --create --topic lady_killer9

- 1

- 2

截图

查看列表

命令

docker exec -it a0 /opt/bitnami/kafka/bin/kafka-topics.sh --bootstrap-server=127.0.0.1:9092 --list

- 1

- 2

截图

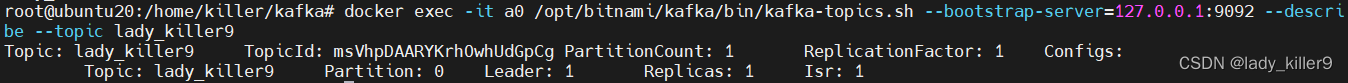

查看详情

命令

docker exec -it a0 /opt/bitnami/kafka/bin/kafka-topics.sh --bootstrap-server=127.0.0.1:9092 --describe --topic lady_killer9

- 1

- 2

截图

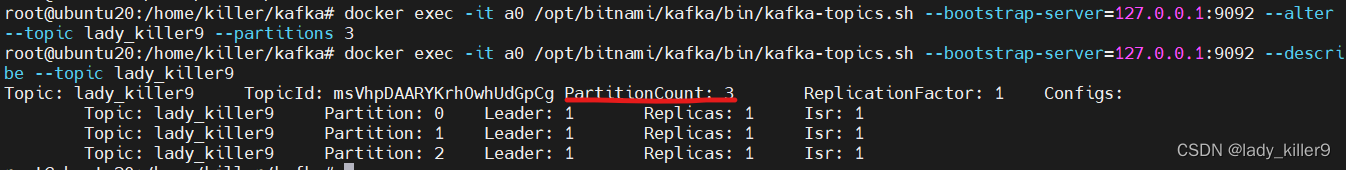

修改

命令

以修改主题partiion数量为例

docker exec -it a0 /opt/bitnami/kafka/bin/kafka-topics.sh --bootstrap-server=127.0.0.1:9092 --alter --topic lady_killer9 --partitions 3

- 1

- 2

截图

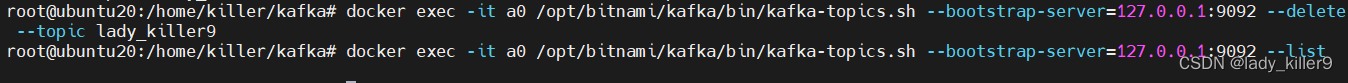

删除

命令

docker exec -it a0 /opt/bitnami/kafka/bin/kafka-topics.sh --bootstrap-server=127.0.0.1:9092 --delete --topic lady_killer9

- 1

- 2

截图

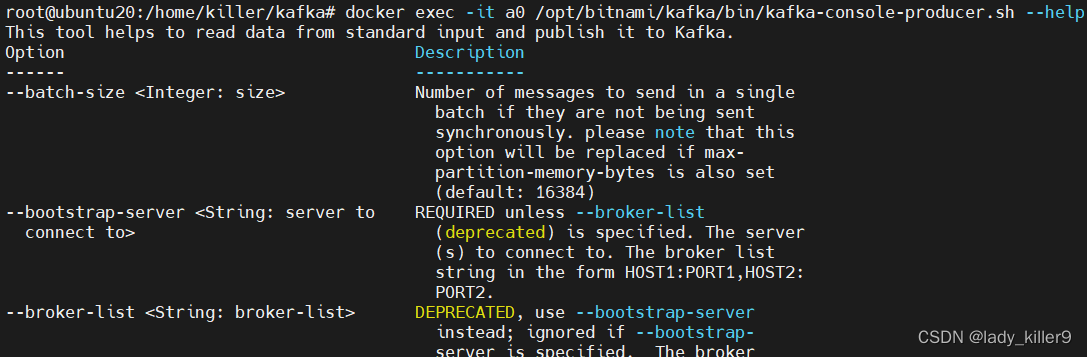

kafka-console-producer.sh

标准输入读数据,发送到Kafka的工具

常用选项如下:

- –bootstrap-server:kafka服务器ip:port,必须的

- –topic <String: topic> :Kafka主题,必须的

- –sync:同步发送

- –compression-codec [String: compression-codec] :压缩方式,‘none’,‘gzip’, ‘snappy’, ‘lz4’, , ‘zstd’,默认gzip.

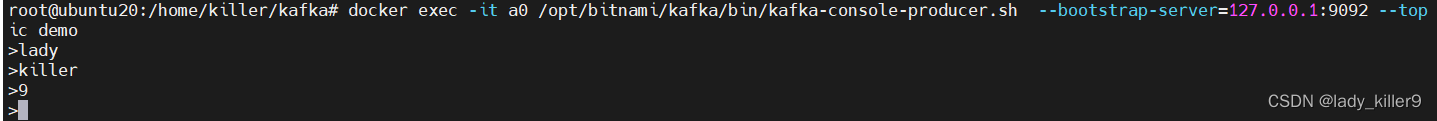

命令

docker exec -it a0 /opt/bitnami/kafka/bin/kafka-topics.sh --bootstrap-server=127.0.0.1:9092 --create --topic demo

docker exec -it a0 /opt/bitnami/kafka/bin/kafka-console-producer.sh --bootstrap-server=127.0.0.1:9092 --topic demo

- 1

- 2

- 3

截图

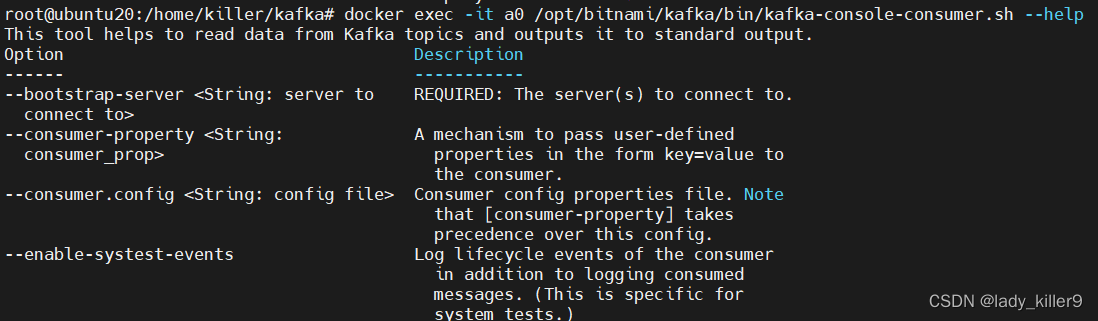

kafka-console-consumer.sh

常用选项如下:

- –bootstrap-server:kafka服务器ip:port,必须的

- –topic <String: topic> :Kafka主题,必须的

- –group <String: consumer group id>:消费者组id

- –key-deserializer <String: deserializer for key>:key反序列化,默认是org.apache.kafka.common.serialization.StringDeserializer

- –value-deserializer <String: deserializer for values>:value反序列化,默认是org.apache.kafka.common.serialization.StringDeserializer

- –offset <String: consume offset>:消费的offset

- –partition <Integer: partition>:消费的分区

命令

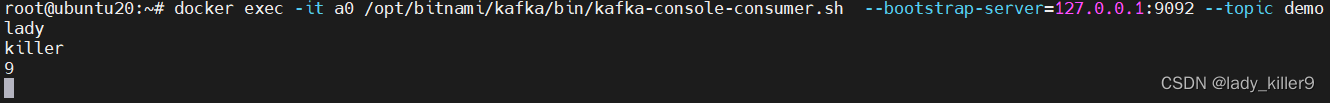

docker exec -it a0 /opt/bitnami/kafka/bin/kafka-console-consumer.sh --bootstrap-server=127.0.0.1:9092 --topic demo

- 1

- 2

截图

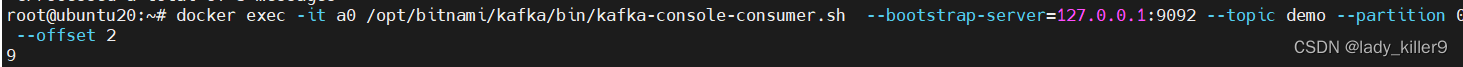

命令

docker exec -it a0 /opt/bitnami/kafka/bin/kafka-console-consumer.sh --bootstrap-server=127.0.0.1:9092 --topic demo --partition 0 --offset 2

- 1

- 2

截图

上手之后我们再来了解一些概念。

概念

集群

已发布的消息保存在一组服务器中,称为Kafka集群。

代理broker

集群中的每一个服务器都是一个代理。

主题topic

每条发布到kafka集群的消息都有一个主题,这个主题被称为topic。每个topic都由一个或者多个分区构成。

分区partition

topic的partition数量可以在创建时配置,partition数量决定了每个消费者组中并发消费者的最大数量。

分区的原则:

- 生产者指定了partition,则直接使用

- 未指定partition但指定了key,通过对key的value进行hash出一个partition

- partition和key都未指定,使用轮询选出一个partition

偏移量offset

任何发布到partition的消息都会被直接追加到partition尾部,每条消息的位置称为offset,offset是一个long型数字,它唯一标记一条消息。消费者可以通过(topic、partition、offset)跟踪记录。

生产者producer

push消息到topc的叫生产者,push后可以获得offset。生产者可以指定partition,但不建议这么做。

消费者组consumer group

包含多个消费者,有一个 group id,可以订阅topic进行消费。消费偏移以消费者组为单位。

消费者consumer

从topic中pull数据,可以指定partition和offset。

FAQ

如何保证一个主题下的数据,一定是有序的(生产与消费的顺序一致)?

Kafka每个partition中的消息在写入是都是有序的,消费时,每个partition只能被每一个group中的消费者消费,因此,topic下只有一个partition时一定有序。

如何设置分区和消费者数?

建议分区数与消费者数一致,防止消费不过来。

给大家的福利

零基础入门

对于从来没有接触过网络安全的同学,我们帮你准备了详细的学习成长路线图。可以说是最科学最系统的学习路线,大家跟着这个大的方向学习准没问题。

同时每个成长路线对应的板块都有配套的视频提供:

因篇幅有限,仅展示部分资料

需要体系化学习资料的朋友,可以加我V获取:vip204888 (备注网络安全)

网上学习资料一大堆,但如果学到的知识不成体系,遇到问题时只是浅尝辄止,不再深入研究,那么很难做到真正的技术提升。

一个人可以走的很快,但一群人才能走的更远!不论你是正从事IT行业的老鸟或是对IT行业感兴趣的新人,都欢迎加入我们的的圈子(技术交流、学习资源、职场吐槽、大厂内推、面试辅导),让我们一起学习成长!