热门标签

热门文章

- 1超详细YOLOv8目标检测全程概述:环境、训练、验证与预测详解_yolov8目标检测流程

- 2AI写作与个人写作:思考性的探究

- 3android stdio 日志追踪,通过检测您的应用生成跟踪日志

- 4cuda-toolkit和cudnn不踩坑安装(Ubuntu系统)_cudatoolkit安装

- 5如何本地部署pritunl-openvpn结合内网穿透实现无公网IP远程访问

- 6522. 最长特殊序列 II(Rust)

- 7C++之模板(三)

- 8数据结构初阶(2)(ArrayList简介、ArrayList()的构造方法、ArrayList的扩容、方法和三种遍历方法、ArrayList实现杨辉三角、ArrayList 的优缺点)_arraylist索引访问

- 9ChatGPT vs 文心一言: 两大AI助手的较量_研发助手chatgpt

- 10android大作业快递代拿软件,安卓大作业——校内快递代取app的一些总结

当前位置: article > 正文

OLLAMA部署qwen:7b,与fastgpt集成_ollama fastgpt

作者:木道寻08 | 2024-06-23 10:10:22

赞

踩

ollama fastgpt

ollama是什么?

Ollama 是一个强大的框架,设计用于在 Docker 容器中部署 LLM。Ollama 的主要功能是在 Docker 容器内部署和管理 LLM 的促进者,它使该过程变得非常简单。它帮助用户快速在本地运行大模型,通过简单的安装指令,可以让用户执行一条命令就在本地运行开源大型语言模型,例如 Llama 2。

安装

安装ollama

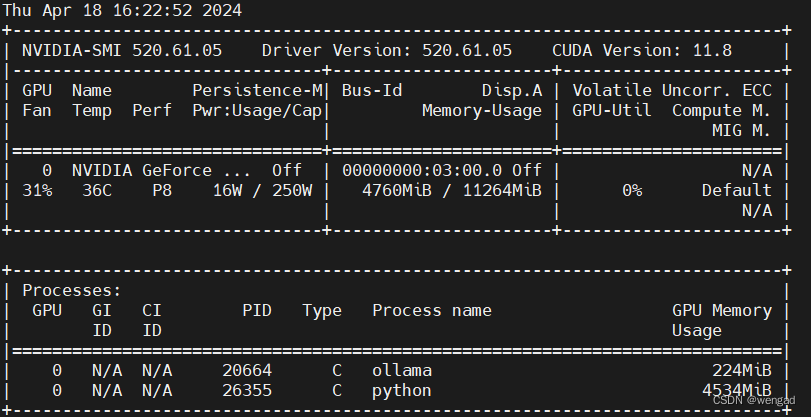

此处是在centos7.6,有一张古老的GTX 1180Ti 11G的显卡,配置和驱动如下:

下载并安装

使用root或者有sudo权限的用户

curl -fsSL https://ollama.com/install.sh | sh

安装好后,执行:service ollama stop 停止服务。

默认是绑定在127.0.0.1的IP,若需要绑定到指定IP,那么采用如下:

export OLLAMA_HOST=xx.xx.xx.71:11434 //这样会启动在指定IP上

ollama serve & //注意,不要用service ollama start来启动,这样环境变量不生效

运行qwen:7b

ollama run qwen:7b

注:第一次运行会下载模型,这个模型有4G多。

成功后ÿ

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/木道寻08/article/detail/749371

推荐阅读

相关标签