- 1设置hive的执行引擎_0506如何将Hue4.0版本中默认执行引擎设置为Hive而非Impala

- 2高校导师在微信群里公然委托关照考研复试,学校通报处理情况!

- 3腾讯AniPortrait开源:音频合成逼真人脸动画,对标阿里EMO_腾讯aniportrait 模型下载

- 4stable diffusion常用的模型_stable diffusion 常用模型

- 5基于Kafka+Flink+Redis的电商大屏实时计算案例

- 6前端自动化测试(二)Vue Test Utils + Jest_vue+jest 测试api

- 7【前端】从零开始学习编写HTML

- 820240624 每日AI必读资讯

- 9数据结构之冒泡排序图文详解及代码(C++实现)_c++冒泡算法代码

- 10Dagger2 在 Android SystemUI 中的应用_android systemui11 dagger2

OpenAI翁荔提出大模型「外在幻觉」:万字blog详解抵抗办法、产幻原因和检测方式...

赞

踩

西风 发自 凹非寺

量子位 | 公众号 QbitAI

大模型幻觉还分内在、外在了——

OpenAI华人科学家翁荔最新Blog,提出LLM外在幻觉(extrinsic hallucination)。

有别于代指模型生成与现实不符、虚构、不一致或者毫无意义的内容,翁荔将LLM“幻觉”问题具体化为模型输出内容是虚构的,并且不基于所提供的上下文或世界知识。

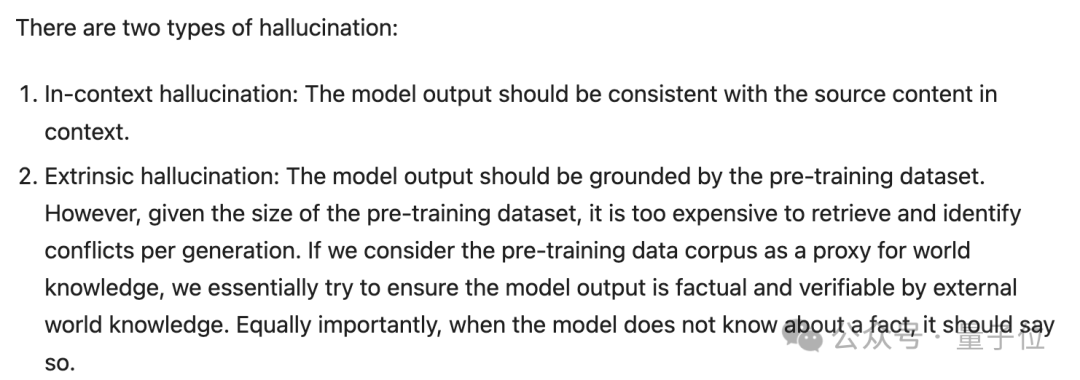

由此,幻觉有两种类型:

上下文内幻觉:模型输出应该与上下文中的源内容一致(出现上下文内幻觉时,输出与源内容不一致)。

外在幻觉:模型输出应该基于预训练数据集。然而,考虑到预训练数据集的规模,检索并识别每次生成的冲突成本过高。如果将预训练数据集看作是世界知识的象征,那么本质上是试图确保模型输出是事实性的并可以通过外部世界知识进行验证。同样重要的是,当模型不了解某个事实时,它应该明确表示不知道。

之前,翁荔还提出过Agent公式:Agent=大模型+记忆+主动规划+工具使用,被一些网友称为是“看到的有关Agent的最好的文章”。

而这次关于大模型幻觉的这篇Blog,同样“重工”,文章超长,足足24篇参考文献:

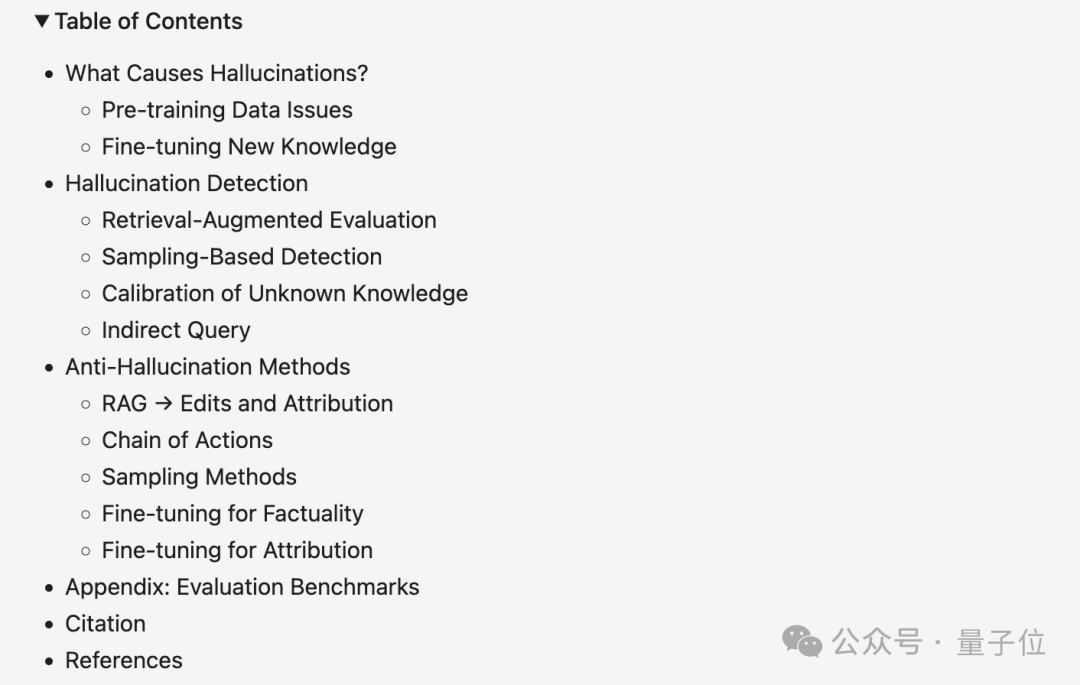

翁荔重点关注外在幻觉,讨论了三个问题:产生幻觉的原因是什么?幻觉检测,抵抗幻觉的方法。

量子位在不改变原意的情况下,对原文进行了编译整理。

量子位已获原作者授权翻译转载。

原文在这里:

https://lilianweng.github.io/posts/2024-07-07-hallucination/

产生幻觉的原因是什么?

考虑到一个标准的可部署LLM需要经过预训练和微调来进行对齐和改进,所以原因分析从这两个阶段入手。

预训练数据问题

预训练数据集旨在代表所有可获得的书面形式的世界知识,因此体量巨大。

从公共互联网爬取数据是最常见的选择,但这就导致可能会出现一些过时、缺失或错误的信息。由于模型可能仅仅通过最大化对数似然来错误地记忆这些信息,所以模型可能会犯错误。

微调新知识

通过监督微调(SFT)和人类反馈强化学习(RLHF)来微调预训练LLM是提高模型某些能力(例如指令跟踪)的常用技术。微调阶段难免引入新知识。

而微调通常消耗的计算资源较少,通过小规模的微调模型是否能可靠地学习新知识还有待商榷。

Gekhman等人在今年的一项研究中讨论了一个问题:用新知识进行LLM微调是否会促使幻觉现象的发生。

他们发现:LLM学习带有新知识的微调示例,要比学习与模型预先存在的知识一致的示例,学得更慢;一旦学习了这些带有新知识的示例,模型产生幻觉的倾向就会增加。

具体来说,给定一个封闭式问答数据集(即EntityQuestions)

Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。