- 1Python对接海康威视机器视觉工业相机_海康相机 python

- 2idea插件开发入门_ideanotifications通知设置

- 3第十四届蓝桥杯JavaB组省赛真题 - 蜗牛_蓝桥杯第十四届javab组

- 4Git 仓库的整体迁移_gitlab移动整体目录代码会受影响吗

- 5TCP/IP协议工作原理和工作流程_tcp工作原理

- 6uniapp_canvas生成海报_微信小程序海报_uniapp小程序生成海报

- 7星途重启:244亿公里外的「旅行者1号」,修好了

- 8Mac Apache php 配置域名_php mac 本机绑定域名

- 9OSPF邻居建立过程详解_ospf建立过程

- 10Linux-磁盘挂载_linux永久挂载磁盘

python ai取名_Python让你成为AI 绘画大师,简直太惊艳了!(附代码)

赞

踩

作者 | 李秋键

责编 | 李雪敬

头图 | CSDN下载自视觉中国

引言:基于前段时间我在CSDN上创作的文章“CylcleGAN人脸转卡通图”的不足,今天给大家分享一个更加完美的绘制卡通的项目“Learning to Cartoonize Using White-box Cartoon Representations”。

首先阐述下这个项目相对之前分享的卡通化的优势:

1、普遍适用性,相对于原来人脸转卡通而言,这个项目可以针对任意的图片进行卡通化转换,不再局限于必须是人脸图片或一定尺寸;

2、卡通化效果更好。

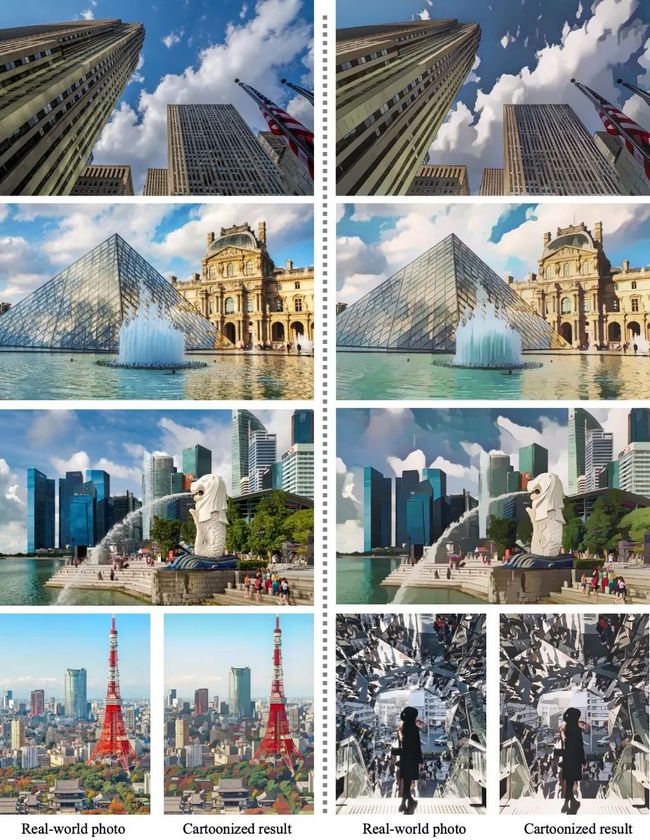

具体效果如下图可见:

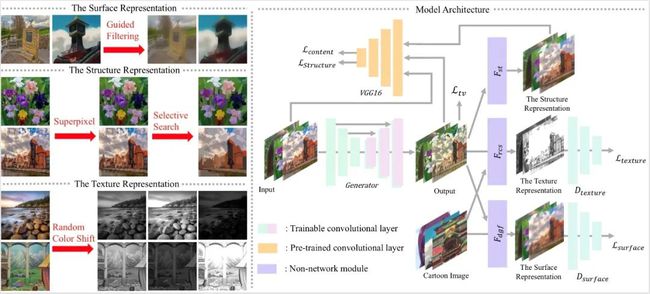

其主要原理仍然是基于GAN网络,但主要三个白盒分别对图像的结构、表面和纹理进行处理,最后得到了优于其他方法的图像转化方法CartoonGAN。

而今天我们就将借助论文所分享的源代码,构建模型创建自己需要的人物运动。具体流程如下。

实验前的准备

首先我们使用的python版本是3.6.5所用到的模块如下:

argparse 模块用来定义命令行输入参数指令。

Utils 是将其中常用功能封装成为接口。

numpy 模块用来处理矩阵运算。

Tensorflow 模块创建模型网络,训练测试等。

tqdm 是显示循环的进度条的库。

网络模型的定义和训练

因为不同的卡通风格需要特定任务的假设或先验知识来开发对应的算法去分别处理。例如,一些卡通工作更关注全局色调,线条轮廓是次要问题。或是稀疏干净的颜色块在艺术表达中占据主导地位。但是针对不同的需求,常见模型无法有效的实现卡通化效果。

故在文章中主要通过分别处理表面、结构和纹理表示来解决这个问题:

(1)首先是网络层的定义:

1.1 定义resblock保证在res block的输入前后通道数发生变化时,可以保证shortcut和普通的output的channel一致,这样就能直接相加了。

def resblock(inputs, out_channel=32, name='resblock'):

with tf.variable_scope(name):

x = slim.convolution2d(inputs, out_channel, [3, 3],

activation_fn=None, scope='conv1')

x = tf.nn.leaky_relu(x)

x = slim.convolution2d(x, out_channel, [3, 3],

activation_fn=None, scope='conv2')

return x + inputs

1.2 定义生成器函数:

def generator(inputs, channel=32, num_blocks=4, name='generator', reuse=False):

with tf.variable_scope(name, reuse=reuse):

x = slim.convolution2d(inputs, channel, [7, 7], activation_fn=None)

x = tf.nn.leaky_relu(x)

x = slim.convolution2d(x, channel*2, [3, 3], stride=2, activation_fn=None)

x = slim.convolution2d(x, channel*2, [3, 3], activation_fn=None)

x = tf.nn.leaky_relu(x)

x = slim.convolution2d(x, channel*4, [3, 3], stride=2, activation_fn=None)

x = slim.convolution2d(x, channel*4, [3, 3], activation_fn=None)

x = tf.nn.leaky_relu(x)

for idx in range(num_blocks):

x = resblock(x, out_channel=channel*4, name='block_{}'.format(idx))

x = slim.conv2d_transpose(x, channel*2, [3, 3], stride=2, activation_fn=None)

x = slim.convolution2d(x, channel*2, [3, 3], activation_fn=None)

x = tf.nn.leaky_relu(x)

x = slim.conv2d_transpose(x, channel, [3, 3], stride=2, activation_fn=None)

x = slim.convolution2d(x, channel, [3, 3], activation_fn=None)

x = tf.nn.leaky_relu(x)

x = slim.convolution2d(x, 3, [7, 7], activation_fn=None)

#x = tf.clip_by_value(x, -0.999999, 0.999999)

return x

def unet_generator(inputs, channel=32, num_blocks=4, name='generator', reuse=False):

with tf.variable_scope(name, reuse=reuse):

x0 = slim.convolution2d(inputs, channel, [7, 7], activation_fn=None)

x0 = tf.nn.leaky_relu(x0)

x1 = slim.convolution2d(x0, channel, [3, 3], stride=2, activation_fn=None)

x1 = tf.nn.leaky_relu(x1)

x1 = slim.convolution2d(x1, channel*2, [3, 3], activation_fn=None)

x1 = tf.nn.leaky_relu(x1)

x2 = slim.convolution2d(x1, channel*2, [3, 3], stride=2, activation_fn=None)

x2 = tf.nn.lea