热门标签

热门文章

- 1java实现spectrogram函数_梅尔频谱(mel-spectrogram)提取,griffin_lim声码器【python代码分析】...

- 2c语言 统计素数并求和_统计素数并求和c语言

- 3gateway配置动态路由的两种方式_gateway动态修改路由

- 4聊聊几款文件同步备份工具,你更喜欢哪一款呢?_rsync和syncthing

- 5IPA包企业证书签名手动替换_ipa包烧签名好能不能更换文件

- 6CentOS各版本区别(DVD/Everything/Minimal/NetInstall等)_centos7dvd和minimal有什么区别

- 7人工智能最全学习路线_人工智能学习路线

- 8idea配置gradle

- 9使用springboot和vue3以及EasyExcel做导出数据(复用)

- 10unity接入facebook SDK时 警告:“OpenSSL not found. Make sure that OpenSSL is installed_openssl not found make sure

当前位置: article > 正文

使用java来进行分词处理_java 分词

作者:IT小白 | 2024-04-08 01:30:15

赞

踩

java 分词

使用java来进行分词处理,首先需要几个jar包,分别是

IKAnalyzer2012_u6.jar,lucene-analyzers-3.6.1.jar,lucene-core-3.6.1.jar和lucene-highlighter-3.6.1.jar。下载jar包的链接为:结巴分词对应的jar包

程序一:

package com.participle; import java.io.IOException; import java.io.StringReader; import org.apache.lucene.analysis.Analyzer; import org.apache.lucene.analysis.TokenStream; import org.apache.lucene.analysis.tokenattributes.CharTermAttribute; import org.wltea.analyzer.lucene.IKAnalyzer; public class Test { public static String str = "IK Analyzer是一个开源的,基于java语言" + "开发的轻量级的中文分词工具包。从2006年12月推出1.0版开始" + "IKAnalyzer已经推出了4个大版本。最初,它是以开源项目Luence为" + "应用主体的,结合词典分词和文法分析算法的中文分词组件。从3.0版" + "本开始,IK发展为面向Java的公用分词组件,独立于Lucene项目,同时" + "提供了对Lucene的默认优化实现"; public static void main(String[] args) throws IOException { Analyzer analyzer = new IKAnalyzer(true); StringReader reader = new StringReader(str); TokenStream ts = analyzer.tokenStream("", reader); CharTermAttribute term = ts.getAttribute(CharTermAttribute.class); while (ts.incrementToken()) { System.out.print(term.toString() + "|"); } reader.close(); } }

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

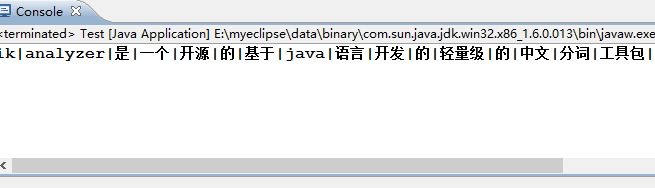

运行结果:

程序二:

package com.participle; import java.io.IOException; import java.io.StringReader; import org.wltea.analyzer.core.IKSegmenter; import org.wltea.analyzer.core.Lexeme; public class Test2 { public static String str = "IK Analyzer是一个开源的,基于java语言" + "开发的轻量级的中文分词工具包。从2006年12月推出1.0版开始" + "IKAnalyzer已经推出了4个大版本。最初,它是以开源项目Luence为" + "应用主体的,结合词典分词和文法分析算法的中文分词组件。从3.0版" + "本开始,IK发展为面向Java的公用分词组件,独立于Lucene项目,同时" + "提供了对Lucene的默认优化实现"; public static void main(String[] args) throws IOException { StringReader re = new StringReader(str); IKSegmenter ik = new IKSegmenter(re, true); Lexeme lex = null; while ((lex = ik.next()) != null) { System.out.print(lex.getLexemeText() + "|"); } } }

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

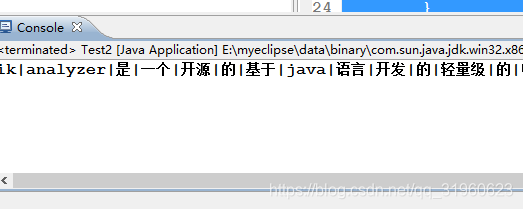

运行结果:

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/IT小白/article/detail/382020

推荐阅读

相关标签