热门标签

热门文章

- 1破解Visio时office失效,激活失败_visio产品激活失败怎么办

- 2机房系统安装服务器,云机房服务器系统安装

- 3优先队列详解(转载)

- 4Llama 2免费托管及API提供_llama-cpp-python

- 5StreamReader和StreamWriter 的使用_go streamreader存文件

- 6YOLOv8改进 | 检测头篇 | 独创RFAHead检测头超分辨率重构检测头(适用Pose、分割、目标检测)_yolov8超分

- 7新手必看|AdSet聚合广告SDK入驻流程_广告sdk接入平台

- 8Pytorch nn.Embedding

- 9使用HBuilder X开发Vue3+node+element-plus_hbuilder vue3

- 10机器学习之优化算法总结_模型不同的样本使用不同的优化函数

当前位置: article > 正文

计算机视觉中的Transformer_计算机视觉 transformer

作者:IT小白 | 2024-04-02 12:43:00

赞

踩

计算机视觉 transformer

计算机视觉中的Transformer

序

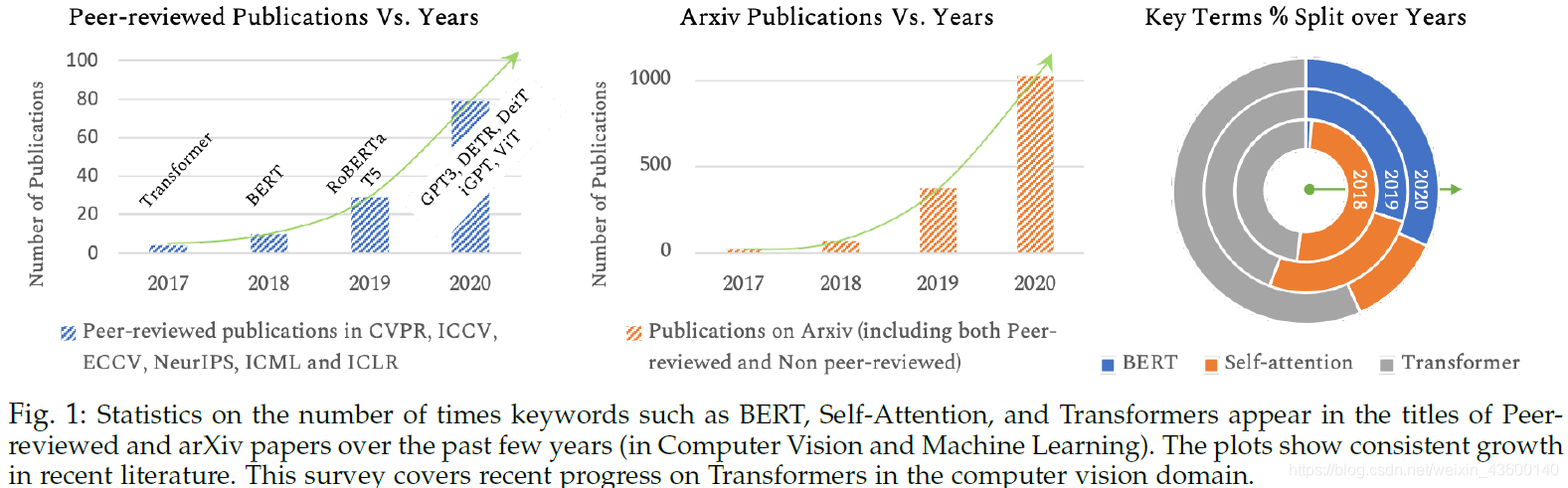

自从2017年Attention Is All You Need论文,Transformer热度持续升高,因为其解决的是"seqence to sequence"属性的问题,所以先是在自然语言处理中席卷各类问题,其代表性工作为BERT。BERT截至今天在Github已有27.2k⭐,火的我没词了…

就好比约5年前,循环神经网络(RNN)先火遍NLP,随后又入侵CV。现在,Transformer也是在席卷了NLP的各类问题后,正在席卷CV的各类问题。前几天连GANsformer都出来了(这名字起的…读起来就很带劲哈声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/IT小白/article/detail/352587

推荐阅读

相关标签

Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。