热门标签

热门文章

- 1(7-2)反馈控制与系统稳定性:使用PID控制机器人的物理运动_pid控制、运动控制

- 2太牛逼了,用ComfyUI中一键完成电商模特换装换背景!商业级教程附上!_comfyui 换装

- 3每日使用技巧-DBeaver-SQL编辑器(上下)_dbeaversql编辑器

- 4IntelliJ IDEA 2024.1.4 提交代码取消token登陆_idea设置git账号密码不用token

- 5IDEA2020.2.4配置Git——拉取远程项目_2020ideagit拉取

- 6大模型微调(finetune)方法总结-LoRA,Adapter,Prefix-tuning,P-tuning,Prompt-tuning_adapter finetune

- 7算法:贪心算法的原理和基本思路_深度优先算法,广度优先算法,贪心算法的主要思路

- 8如何下载贵州省卫星地图高清版大图_贵州地形图img下载

- 9测试开发人均年薪30w+?软件测试工程师如何进阶拿到高薪?_软件测试怎么提高工资

- 10消息重复消费及消息丢失解决办法_c++ 消费模型 消息丢失

当前位置: article > 正文

两步解决Hugging Face下载模型速度慢/连接超时/无法下载问题_huggingface下载慢

作者:黑客灵魂 | 2024-08-07 14:57:48

赞

踩

huggingface下载慢

博主使用的配置是

x86_64 Linux服务器

第一步设置代理镜像:

export HF_ENDPOINT=https://hf-mirror.com第二步(使用代码时,删除引号):

--token参数表示下载的模型是否需要登录验证(部分模型需要token)

huggingface-cli download --token "获取的hf_*******token" --resume-download --local-dir-use-symlinks False "HuggingFace上对应的模型名称" --local-dir "下载到本地的地址"

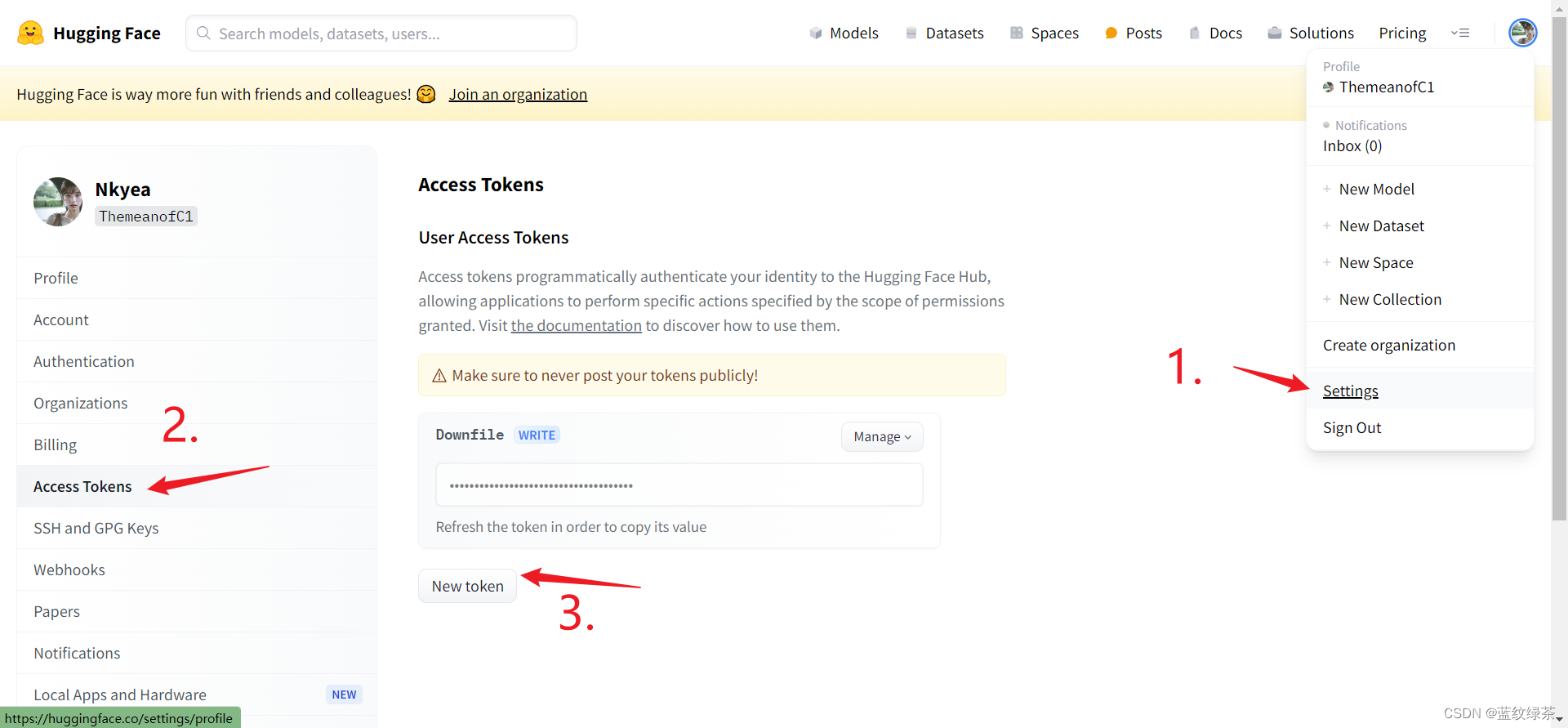

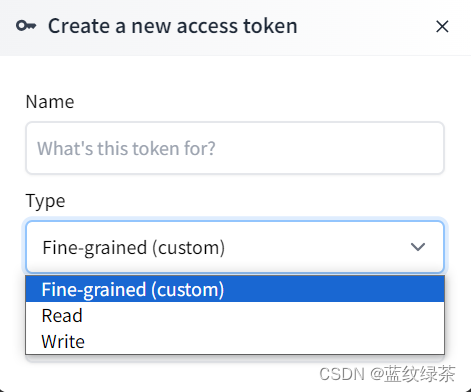

如何获取token

切记设置的权限需要Write

(二)下载方式2

如果需要对模型中的单个文件或者文件夹中的文件下载可使用以下命令

第一步:进入python

第二步:

- from huggingface_hub import login

- login()

第三步:

hf_hub_download(repo_id="meta-llama/Meta-Llama-3-8B-Instruct ", filename="original/*", local_dir="/data")(三)下载方式3

使用黑科技

第一步:

pip install -U hf-transfer第二步:设置环境变量

Linux

export HF_HUB_ENABLE_HF_TRANSFER=1Windows Powershell

$env:HF_HUB_ENABLE_HF_TRANSFER = 1之后使用代码:

huggingface-cli download --token "获取的hf_*******token" --resume-download --local-dir-use-symlinks False "HuggingFace上对应的模型名称" --local-dir "下载到本地的地址"声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/黑客灵魂/article/detail/943090

推荐阅读

相关标签