- 1python内置的有序集合,list元素可变,tuple不可变_有序可变的元素系列

- 2python自然语言处理之spacy详解_python spacy

- 3Pytorch 学习(五):Pytorch 实现多层感知机(MLP)_pytorch def __init__(self, n_i, n_h, n_o):

- 4基于python爬虫的豆瓣电影数据可视化分析

- 5在模型进行inference的时候爆显存_xinferernce csdn

- 6invalid resource directory name 无效的资源目录名

- 7Spring Boot 整合 MyBatis

- 8图数据库neo4j(一)Linux环境下安装

- 9Spring框架简介_spring是一个轻量级java 开发框架,最早由rod johnson创建,目的是为了解决企业级应

- 10LLM模型在医疗健康领域的应用和挑战_ecg信息生成诊断书llm

CVPR 2023 | 无中生有:面向实时点云全景分割的中心聚焦网络

赞

踩

©PaperWeekly 原创 · 作者 | 李笑颜

单位|北京工业大学

论文地址:

https://openaccess.thecvf.com/content/CVPR2023/papers/Li_Center_Focusing_Network_for_Real-Time_LiDAR_Panoptic_Segmentation_CVPR_2023_paper.pdf

代码地址:

https://github.com/GangZhang842/CFNet

简介

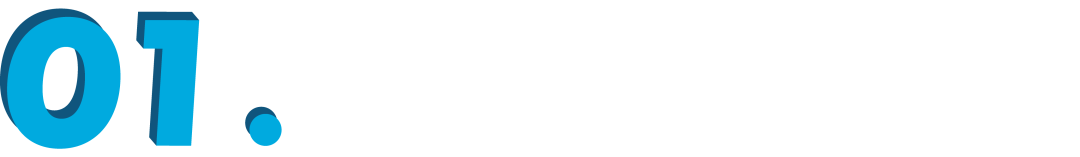

LiDAR 全景分割对 LiDAR 点云中每一个点进行分类并赋予物体实例 ID,它能够帮助自动驾驶车全面理解环境中的物体和场景,需要实时地运行。现有无候选框(proposal-free)方法计算点到物体的实例中心的距离,并依据中心点位置聚类得到物体,该类方法的速度虽然较基于候选框的方法有明显提升,但仍存在两个问题:

1)由于 LiDAR 点云聚集在物体表面,物体的中心点在三维点云中通常不存在实体,因此较难建模;

2)基于中心点的聚类模块的计算成本高昂。因此,现有方法在性能和效率上均有提升空间。

为了实现准确、实时的 LiDAR 全景分割,本文提出一种新型的中心聚焦网络(CFNet):

1)提出了中心聚焦特征编码(CFFE),通过移动三维点来填充物体中心,“无中生有”地显示建模原始 LiDAR 点云与虚拟实例中心之间的关系;

2)提出了一种快速的重复中心删除模块(CDM),以代替现有方法中的聚类模块,为每个实例选择一个中心。

在 SemanticKITTI 和 nuScenes 上的实验表明,我们提出的 CFNet 性能超越了现有 LiDAR 全景分割算法,并且比当前最快的方法快 1.6 倍。

方法

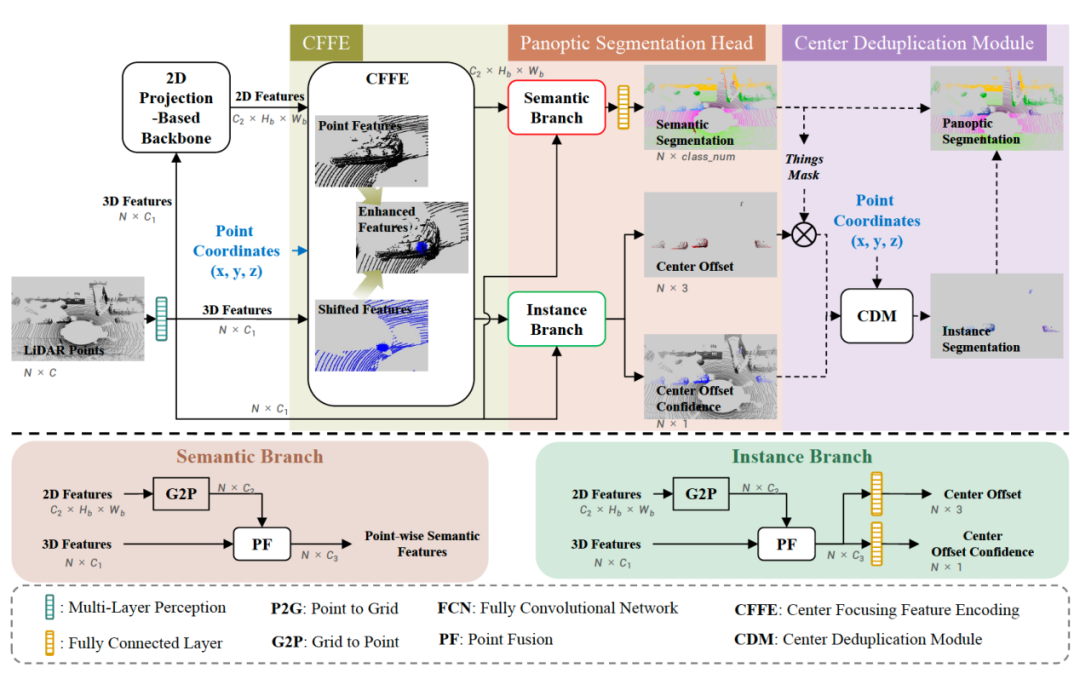

CFNet 的总体框架图如图所示。主要包含四个组成部分:

1)为了加速算法,采用基于 2D 投影的骨干网络提取在 2D 空间上提取特征;

2)为解决不存在的实例中心建模难的问题,中心聚焦特征编码(CFFE)模块模拟并增强了实例中心的特征;

3)全景分割头预测输出结果,包括:现有方法中常用的语义分割、距中心点的偏移量,以及本文新增的偏移量置信度;

4)在推理期间,重复中心删除模块(CDM)为每个物体保留一个中心,进而实现实例分割,并融合生成最终的全景分割结果。

下面,重点介绍其中较为重要的中心聚焦特征编码和重复中心删除模块。

中心聚焦特征编码(CFFE)

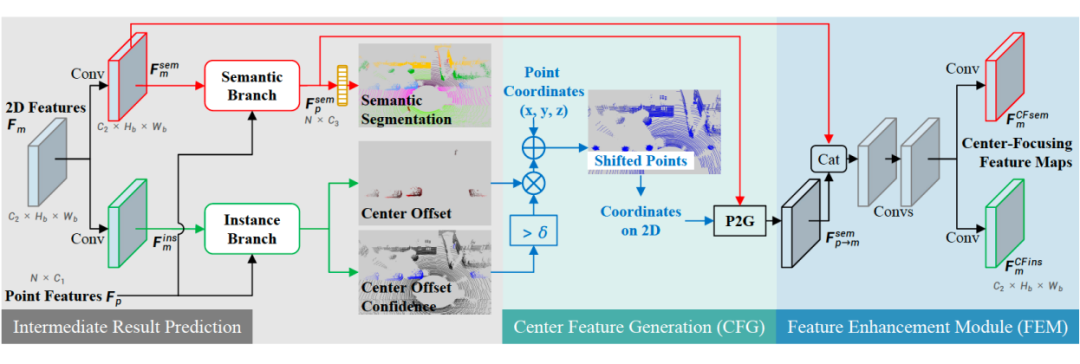

该模块的主要思想是,将物体表面的点移动到物体中心,“无中生有”,形成物体中心的实体点云,再进行特征提取,以显示建模空间中不存在的物体中心。具体地,

1)Intermediate Result Prediction:首先采用原始三维点和二维投影特征,估计一次全景分割结果。其中,语义分割仅用于中间结果的损失计算。

2)Center Feature Generation:将偏移量置信度较高的三维点根据估计的中心点偏移量进行移动,产生移动后的点(shifted points)坐标,即虚拟的中心点位置。将移动后的三维点云特征()通过 P2G 操作投影到二维空间,得到 。

3)Feature Enchancement Module:将上述二维特征与前面的未移动的二维特征()进行拼接,输入后面的网络,进行预测。

重复中心删除模块(CDM)

该模块受检测中的 box nms 操作启发,用于快速去除重复的中心点。使用 CFFE 模块进行特征增强后,估计的偏移量更加准确。根据这种偏移量移动物体表面的点后,三维点将紧凑地聚集在物体中心。CDM 模块将这些三维点按照置信度进行排序,依次取置信度最高的点,并抑制掉距离在d内的其他中心点。

损失函数

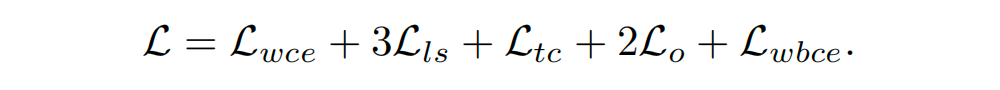

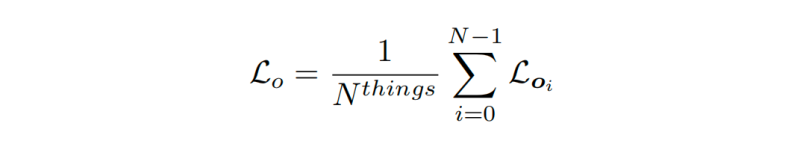

CFNet 总体损失函数为,

主要包含以下几个部分:

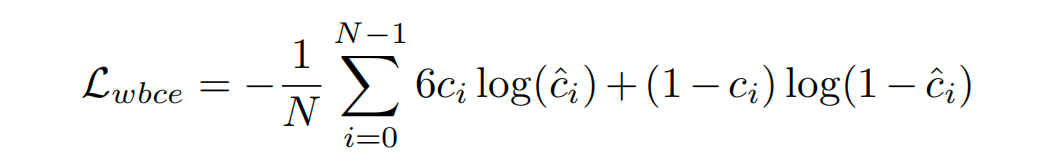

1)语义分割结果产生的损失与 CPGNet [2] 方法相似为 weighted cross-entropy 损失 、Lovasz-Softmax 损失 和变换一致性损失 。

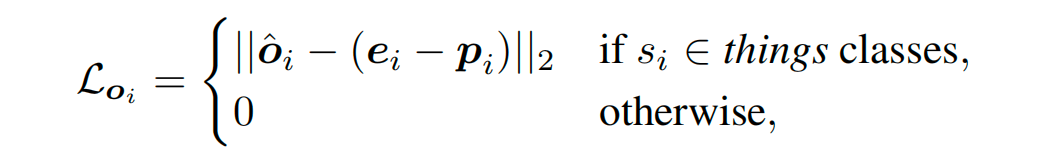

2)距中心点的偏移量产生的损失为 L2 损失 ,计算方法如下

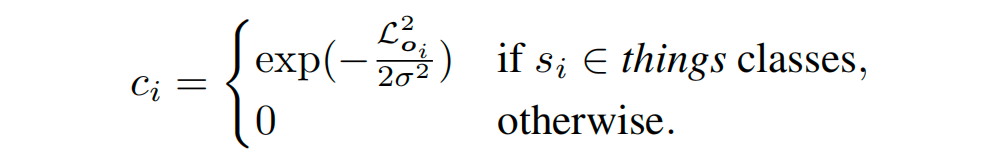

4)偏移量置信度估计是本文新提出的任务,它对应的标签为

即距中心点的偏移量估计误差越大,对应的置信度越低。采用带权重的二元交叉熵损失作为该分支的损失函数,以人为侧重对 things 三维点的刻画。

实验结果

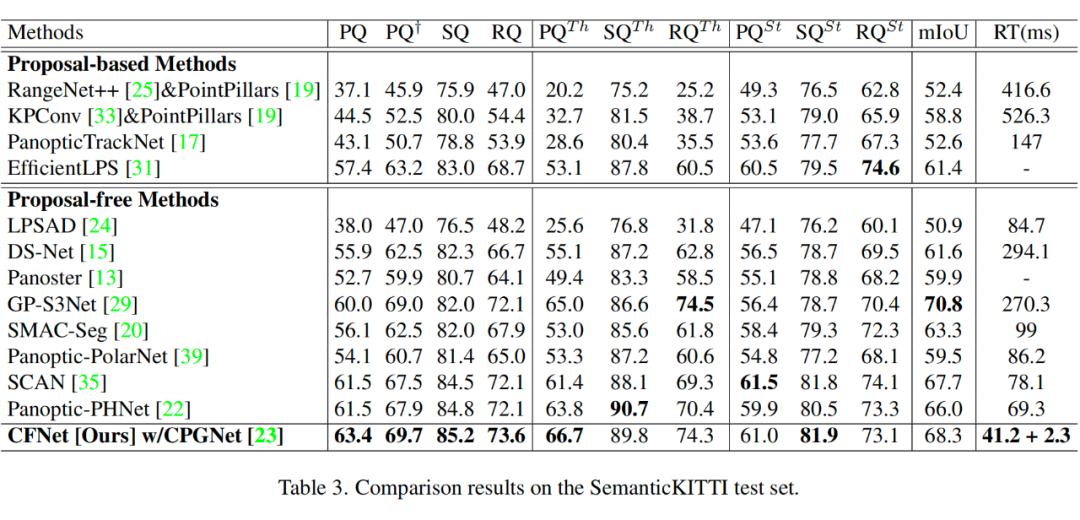

在 SemanticKITTI 测试集上与现有方法的对比结果如下表

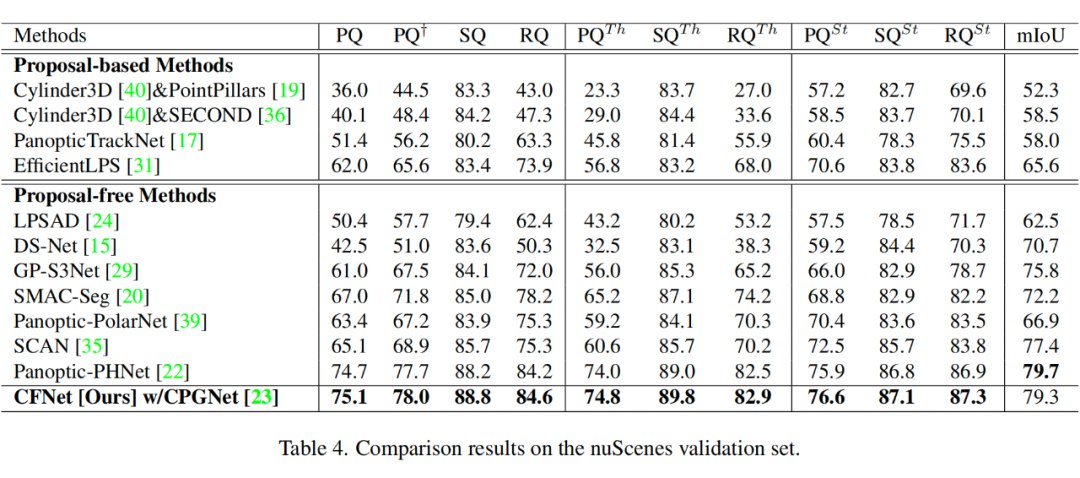

在 nuScenes 验证集上与现有方法的对比结果如下表

参考文献

[1] Xiaoyan Li, Gang Zhang, Boyue Wang, Yongli Hu, and Baocai Yin. Center Focusing Network for Real-Time LiDAR Panoptic Segmentation. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), pages 13425-13434, 2023. 【代码 https://github.com/GangZhang842/CFNet】【PDF https://openaccess.thecvf.com/content/CVPR2023/papers/Li_Center_Focusing_Network_for_Real-Time_LiDAR_Panoptic_Segmentation_CVPR_2023_paper.pdf】

[2] Xiaoyan Li, Li Xiaoyan, Gang Zhang, Hongyu Pan, Zhenhua Wang. "CPGNet: Cascade Point-Grid Fusion Network for Real-Time LiDAR Semantic Segmentation." In Proceedings of the IEEE International Conference on Robotics and Automation (ICRA). 2022.【代码 https://github.com/GangZhang842/CPGNet】【PDF https://arxiv.org/abs/2204.09914】

更多阅读

#投 稿 通 道#

让你的文字被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。