- 1【网页设计】HTML做一个属于我的音乐页面(纯html代码)_html5音乐网页完整代码

- 2如何使用GPT2中文闲聊对话系统,机器人对话,自动对话!_gpt2部署后通过浏览器建立对话

- 3IntelliJ IDEA 中 右键新建时,选项没有Java class的解决方法和具体解释_ie 新建没有class

- 4Ubuntu 20安装code-server_ubuntu code-server

- 5arc浏览器禁用自动跳转HTTPS设置方法

- 6pytorch之诗词生成6--eval

- 7查找nginx配置文件路径_nginx 长搜索路径

- 8PostgreSQL批量清空数据库_pg 批量删除数据

- 9Gradle下载以及安装教程_gradle-5.5.1-bin.zip

- 10使用uni-app把h5网页封装成安卓app_h5封装app

TextRank算法原理简析、代码实现_textrank实现

赞

踩

注:PageRank原理另行查询

在介绍TextRank前,我想先给大家介绍下PageRank,实质上个人认为可以把TextRank当做PageRank2.0。

谷歌的两位创始人的佩奇和布林,借鉴了学术界评判学术论文重要性的通用方法,“那就是看论文的引用次数”。由此想到网页的重要性也可以根据这种方法来评价。于是PageRank的核心思想就诞生了:

- 如果个网页被很多其他网页链接到的话说明这个网页比较重要,也就是PageRank值会相对较高

- 如果一个PageRank值很高的网页链接到一个其他的网页,那么被链接到的网页的PageRank值会相应地因此而提高

TextRank算法

TextRank 算法是一种用于文本的基于图的排序算法。其基本思想来源于谷歌的 PageRank算法, 通过把文本分割成若干组成单元(单词、句子)并建立图模型, 利用投票机制对文本中的重要成分进行排序, 仅利用单篇文档本身的信息即可实现关键词提取、文摘。和 LDA、HMM 等模型不同, TextRank不需要事先对多篇文档进行学习训练, 因其简洁有效而得到广泛应用。

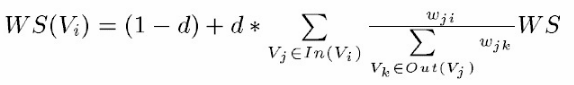

TextRank 一般模型可以表示为一个有向有权图 G =(V, E), 由点集合 V和边集合 E 组成, E 是V ×V的子集。图中任两点 Vi , Vj 之间边的权重为 wji , 对于一个给定的点 Vi, In(Vi) 为 指 向 该 点 的 点 集 合 , Out(Vi) 为点 Vi 指向的点集合。点 Vi 的得分定义如下:

用TextRank提取来提取关键词,用PageRank的思想来解释它:

- 如果一个单词出现在很多单词后面的话,那么说明这个单词比较重要

- 一个TextRank值很高的单词后面跟着的一个单词,那么这个单词的TextRank值会相应地因此而提高

公式的意思:TextRank中一个单词\large i的权重取决于与在\large i前面的各个点\large j组成的\large (j,i)这条边的权重,以及\large j这个点到其他其他边的权重之和

其中, d 为阻尼系数, 取值范围为 0 到 1, 代表从图中某一特定点指向其他任意点的概率, 一般取值为 0.85。使用TextRank 算法计算图中各点的得分时, 需要给图中的点指定任意的初值, 并递归计算直到收敛, 即图中任意一点的误差率小于给定的极限值时就可以达到收敛, 一般该极限值取 0.0001。(个人觉得算法领域很多公式的可解释性不强,大多是为了解决某些限定条件,而人为选择的比较好的优化方式,比如阻尼系数d,(这个d通常取0.85实践出来的,好像没什么数学解释),实质上是为了给数据做一个平滑处理,实质是为了替代为零项)

关键词抽取的任务就是从一段给定的文本中自动抽取出若干有意义的词语或词组。TextRank算法是利用局部词汇之间关系(共现窗口)对后续关键词进行排序,直接从文本本身抽取。其主要步骤如下:

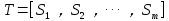

(1)把给定的文本T按照完整句子进行分割,即

(2)对于每个句子,进行分词和词性标注处理,并过滤掉停用词,只保留指定词性的单词,如名词、动词、形容词,即

,其中

是保留后的候选关键词。

(3)构建候选关键词图G = (V,E),其中V为节点集,由(2)生成的候选关键词组成,然后采用共现关系(co-occurrence)构造任两点之间的边,两个节点之间存在边仅当它们对应的词汇在长度为K的窗口中共现,K表示窗口大小,即最多共现K个单词。

(4)根据上面公式,迭代传播各节点的权重,直至收敛。

(5)对节点权重进行倒序排序,从而得到最重要的T个单词,作为候选关键词。

(6)由(5)得到最重要的T个单词,在原始文本中进行标记,若形成相邻词组,则组合成多词关键词。例如,文本中有句子“Matlab code for plotting ambiguity function”,如果“Matlab”和“code”均属于候选关键词,则组合成“Matlab code”加入关键词序列。

python编程实现

因为在了解textrank的时候,参考了jieba分词和TextRank4zh这2个开源库的写法。但是两者无论写法和运算规则都有很大出入,结合公式来说本人觉得jieba做的更符合公式,TextRank4zh更具有准确性,因为TextRank4zh在公式上面做了一定的优化。

Jieba分词TextRank:

- 对每个句子进行分词和词性标注处理

- 过滤掉除指定词性外的其他单词,过滤掉出现在停用词表的单词,过滤掉长度小于2的单词

- 将剩下的单词中循环选择一个单词,将其与其后面4个单词分别组合成4条边。

例如: [‘有’,‘媒体’, ‘曝光’,‘高圆圆’, ‘和’, ‘赵又廷’,‘现身’, ‘台北’, ‘桃园’,‘机场’,‘的’, ‘照片’]

对于‘媒体‘这个单词,就有(‘媒体’, ‘曝光’)、(‘媒体’, ‘圆’)、(‘媒体’, ‘和’)、(‘媒体’, ‘赵又廷’)4条边,且每条边权值为1,当这条边在之后再次出现时,权值再在基础上加1.

- 有了这些数据后,我们就可以构建出候选关键词图G=(V,E),图的概念有基础的人可能会很好理解,不理解其实也没关系,按上面例子,你只用知道这一步我们把2个单词组成的边,和其权值记录了下来。

- 这样我们就可以套用TextRank的公式,迭代传播各节点的权值,直至收敛。

- 对结果中的Rank值进行倒序排序,筛选出前面的几个单词,就是我们需要的关键词了。

关于有向图的数据结构:

- <span style="color:#000000"><code>def addEdge(self, start, end, weight):

- # use a tuple (start, end, weight) instead of a Edge object

- self.graph[start].append((start, end, weight))

- self.graph[end].append((end, start, weight))

- </code></span>

关于TextRank的手写:

jieba.analyse.textrank完整源码如下: