热门标签

热门文章

- 13.vueuse-createFetch实现接口请求及其封装(代替axios)

- 2上海亚商投顾:沪指放量反弹 医药、AI概念股集体走强

- 3Unity禁止移动端多点触控_unity如何限制拖拽的时候多点触控

- 4【LeetCode】30. Substring with Concatenation of All Words(C++)_30. substring with concatenation of all words c++

- 5Android中自定义Textview解决文字和数字换行不整齐_textview 换行对齐

- 6小程序 | 案例---自定义tabBar

- 7用python实现动态进度条(两种形式)_python进度条代码

- 8Entity Framework Core 介绍

- 9Tensorflow2.x框架-神经网络八股扩展-数据增强_image_gen_train.fit

- 10计算机3 2主要学什么,长春职业技术学院的计算机3+2是什么意思?

当前位置: article > 正文

【CVPR 2022】(LDM)High-Resolution Image Synthesis with Latent Diffusion Models

作者:知新_RL | 2024-03-12 20:35:33

赞

踩

latent diffusion models

High-Resolution Image Synthesis with Latent Diffusion Models(CVPR 2022)

https://arxiv.org/abs/2112.10752

GitHub - CompVis/latent-diffusion: High-Resolution Image Synthesis with Latent Diffusion Models

GitHub - CompVis/stable-diffusion: A latent text-to-image diffusion model

贡献:大大减少计算复杂度、提出了cross-attention的方法来实现多模态训练,使得条件图片生成任务也可以实现

论文贡献

- Diffusion model相比GAN可以取得更好的图片生成效果,然而该模型是一种自回归模型,需要反复迭代计算,因此训练和推理代价都很高。论文提出一种在潜在表示空间(latent space)上进行diffusion过程的方法,从而能够大大减少计算复杂度,同时也能达到十分不错的图片生成效果。

- 相比于其它空间压缩方法,论文提出的方法可以生成更细致的图像,并且在高分辨率图片生成任务(如风景图生成,百万像素图像)上表现得也很好。

- 论文将该模型在无条件图片生成(unconditional image synthesis), 图片修复(inpainting),图片超分(super-resolution)任务上进行了实验,都取得了不错的效果。

- 论文还提出了cross-attention的方法来实现多模态训练,使得条件图片生成任务也可以实现。论文中提到的条件图片生成任务包括类别条件图片生成(class-condition), 文图生成(text-to-image), 布局条件图片生成(layout-to-image)。这也为日后Stable Diffusion的开发奠定了基础。

方法

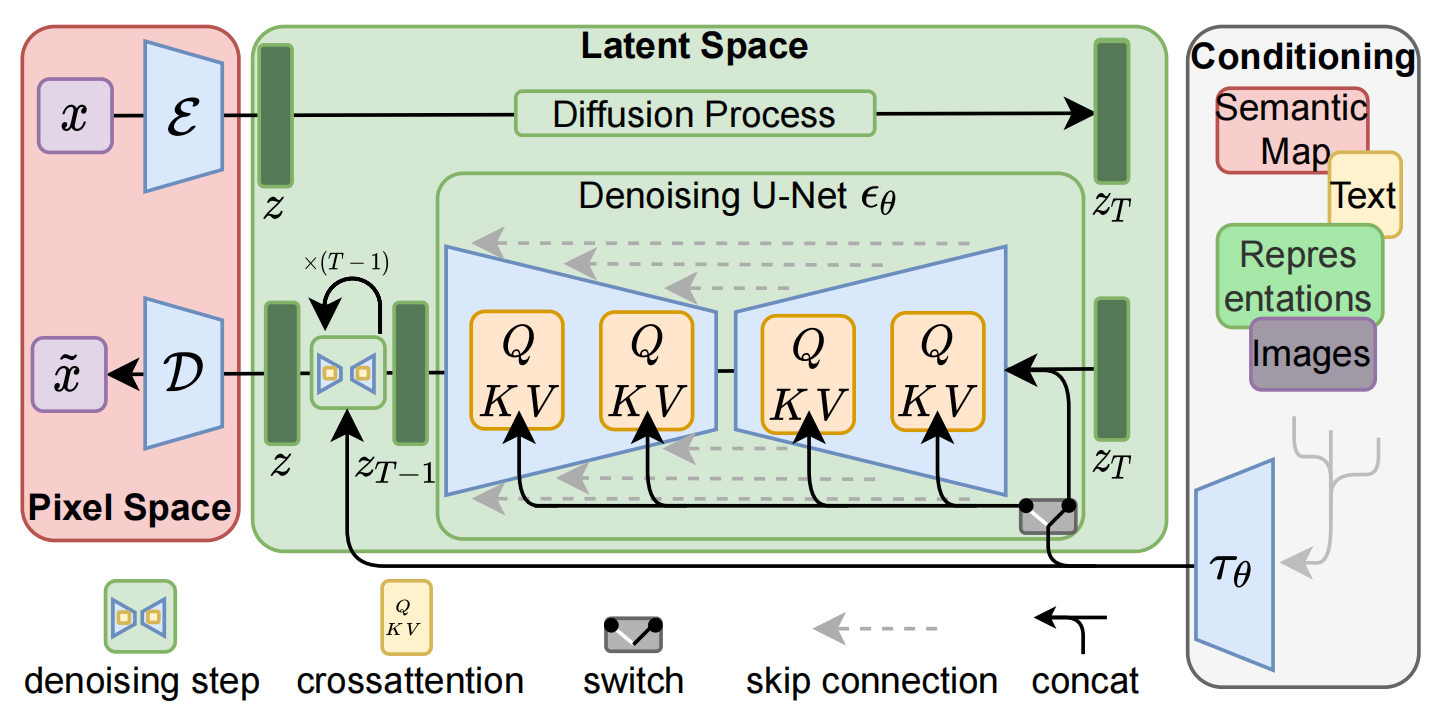

Latent Diffusion Models整体流程如图:

- 首先需要训练好一个自编码模型(AutoEncoder,包括一个编码器 E 和一个解码器 D )。

- 这样一来,我们就可以利用 Encoder 对图片进行压缩,

- 然后在潜在表示空间上做diffusion操作,

- 最后我们再用 Decoder 恢复到原始像素空间即可,

论文将这个方法称之为感知压缩(Perceptual Compression)。个人认为这种将高维特征压缩到低维,然后在低维空间上进行操作的方法具有普适性,可以很容易推广到文本、音频、视频等领域。

在潜在表示空间上做diffusion操作其主要过程和标准的扩散模型没有太大的区别,所用到的扩散模型的具体实现为 time-conditional UNet。但是有一个重要的地方是论文为diffusion操作引入了条件机制(Conditioning Mechanisms),通过cross-attention的方式来实现多模态训练,使得条件图片生成任务也可以实现。

下面我们针对感知压缩、扩散模型、条件机制的具体细节进行展开。

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/知新_RL/article/detail/225723

推荐阅读

相关标签