- 1基于STM32的最小系统电路设计(STM32F103C8T6为例)_stm32微控制器和最小系统电路

- 2推荐3个开源好用的堡垒机_免费堡垒机

- 3安装samba服务器_samba安装

- 4AIGC:重塑创意产业的新纪元

- 5高德地图2.0内网部署 离线瓦片 性能优化_高德地图瓦片服务

- 6计算机工程与科学期刊小木虫,《[小木虫emuch.net]北大中文核心期刊目录(2016版)--2016年4月12日更新》.pdf...

- 7springboot小区物业服务平台 计算机专业毕业设计源码35514_老旧小区改造智能管理系统的编码实现过程

- 8【C++】STL之空间配置器

- 9如何做好springboot监控集成

- 10numpy的下载与安装教程——(解决No module named numpy问题)

【项目实训】基于大模型的小学语数英辅助教育平台 | 开题(1)_小学语文知识库 大模型数据

赞

踩

1 项目背景

随着人工智能技术的飞速进步,教育领域正在迎来一场革命。AI大模型如GPT-3.5的出现不仅为教育提供了新的发展机遇,也对其提出了挑战。这些技术推动着教育变革,为教育提供了更智能化和个性化的方式。

1.1 AI大模型在教育中的应用场景

智能化教学助手:

AI大模型可以充当教学助手,通过自然语言处理和推理能力回答学生问题、提供解释,帮助他们更好地理解知识。这种方式打破了传统教育的限制,让学生随时随地获得高质量的教学服务。同时,AI大模型还可以根据学生的问题分析其学习需求,提供个性化帮助。

个性化学习推荐:

基于学生的学习历史和兴趣,AI大模型可以为每个学生提供个性化的学习推荐。这种方式不仅满足学生个体差异的需求,还激发学生的学习兴趣,提高学习效果。AI大模型会根据学生的学习情况实时调整推荐内容,确保学生处于最适合的学习环境中。

教学内容生成:

AI大模型能够根据海量教育资源和学生需求生成高质量的教学内容。这种方式丰富了教学资源,满足多样化的学习需求。根据学生的学习阶段和学科特点,AI大模型生成符合实际需求的教案、课件、习题等资源,为教师和学生提供多元化的教学方式。

自动化评估与反馈:

AI大模型可以实时评估学生的学习表现,检测和纠正错误。这提高了评估的效率和准确性,帮助学生及时发现并改正问题。AI大模型还会根据学生的学习情况提供针对性的反馈和建议,帮助他们找到适合自己的学习方法。

1.2 一站式辅助教育平台

基于以上应用场景,我们提出了一站式辅助教育平台,旨在实现个性化和智能化的教育过程。该平台将整合题库生成、作文修改及打分、试卷及作业情况分析等功能为教育提供更加智能化和高效的支持。通过结合AI技术和教育实践,我们致力于为学生和教师创造更优质的学习和教学体验,推动教育领域向前迈进。

2技术创新

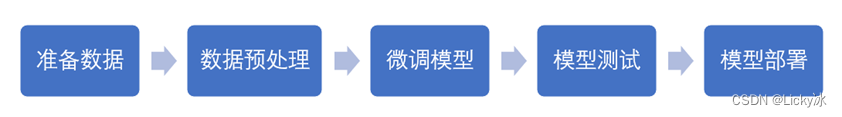

采用微调技术进行模型训练,修改少量参数以适应具体任务:

具体流程如下:

2.1 数据集准备

尝试收集与小学数学题的数据集对大模型进行微调。

2.2 微调模型

目前主流的微调方法包括2019年 Houlsby N 等人提出的 Adapter Tuning,2021年微软提出的 LORA,谷歌提出的 Prompt Tuning,2022年清华提出的 P-tuning v2。我们计划采用LORA方法,理由是其作为轻量级的微调方法,训练的参数量最小,且效果较好。

目前 LORA 已经被 HuggingFace 集成在了 PEFT(Parameter-Efficient Fine-Tuning) 代码库里,如下图所示:

3 工作内容(重点为小学数学的题库生成,作文修改)

我们计划设计一个智慧辅助教育平台来协助老师教学、学生学习,借助语言大模型,来实现题库生成、成绩分析等功能辅助学生和老师,提供更加个性化的智能服务。该平台分为教师端和学生端,为不同群体提供更适合的功能。该智慧辅助教育平台含有的功能如下:

| 功能 | 描述 | |

| 教师端 | 作业收集 | 可以接收到来自学生上传的作业; |

| 作业批改及情况统计 | 教师端可以对学生上传的作业进行批改和评语,并且结合大模型,对学生的作业进行完成情况分析,辅助老师更好地掌握学生的知识掌握情况; | |

| 成绩统计及分析 | 教师可以上传某次考试/测验的成绩表,平台读取进行图表统计,并且结合大模型对成绩进行分析,辅助老师更好地掌握学生的考试情况; | |

| 学生端 | 提交作业 | 学生可以通过文件/图片等形式上传自己的作业; |

| 作文修改及打分 | 结合大模型,修订语文/英语作文并对其进行润色和优化,还有打分机制辅助学生更好地进行作文学习; | |

| 刷题及题库生成 | 结合大模型,可以给出要求生成相关的题目构成题库,也可以拍照上传习题来构成题库;随机调取题库中的题目给学生进行课余的练习,辅助学生巩固知识; |

以上为智慧辅助教育平台的基础功能,利用大模型来辅助教师掌握教学情况调整教学计划,辅助学生了解学习情况不断查漏补缺。智慧辅助教育平台最终通过网页端呈现,小组成员会通过搭建前后端、调用大模型来完成平台的搭建和平台功能的实现。

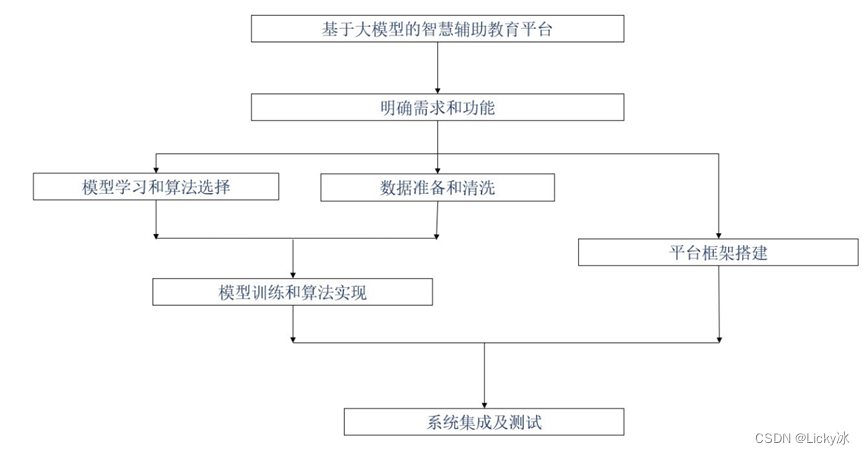

4 技术路线

- 明确需求和功能:明确平台所需要实现的具体功能

- 模型学习和算法选择:学习“百川大模型”等相关模型api,并基于功能选择深度学习相关算法。

- 数据准备和清洗:收集、清洗、标注、集成教育领域的文本、图片、视频流等数据。

- 模型训练及算法实现:利用标注数据对模型进行训练、实现并优化算法,提高模型及算法在具体功能上的性能。

- 平台框架搭建:采用vue+springboot搭建前后端框架、设计用户界面、合理管理数据等。

- 系统集成及测试:集成各功能及前后端组件,进行系统测试和性能优化。

5 实施方案

- 在任务分配上,我们综合考虑每个小组成员的优势、长处、经验进行分工。

- 在项目推进上,我们计划保持充足的沟通交流,了解各个成员的开发状况,通过对每个阶段设置ddl来保证项目的顺利推进。

- 在难题解决上,我们计划集思广益,大家一起筹谋划策,学习交流来攻克遇到的问题,一起讨论碰撞灵感来获得切实可行的创新点。

- 在风险管理上,我们将选择切实可行的技术路线,对新的设想进行充分验证后再投入时间精力进行实现,留出适当的时间来应对潜在的意外情况,若遇到不可避免的麻烦则积极解决。

参考文献

【1】Alexis Baladn, Ignacio Sastre, Luis Chiruzzo, and Aiala Ros. 2023. RETUYT-InCo at BEA 2023 shared task: Tuning open-source LLMs for generating teacher responses. In Proceedings of the 18th Workshop on Innovative Use of NLP for Building Educational Applications (BEA 2023), pages 756–765, Toronto, Canada. Association for Computational Linguistics.

【2】Mark Chen, Jerry Tworek, Heewoo Jun, Qiming Yuan, Henrique Ponde de Oliveira Pinto, Jared Kaplan, Harri Edwards, Yuri Burda, Nicholas Joseph, Greg Brockman, et al. 2021. Evaluating large language models trained on code. arXiv preprint arXiv:2107.03374.

【3】Hugo Touvron, Thibaut Lavril, Gautier Izacard, Xavier Martinet, Marie-Anne Lachaux, Timothée Lacroix, Baptiste Rozière, Naman Goyal, Eric Hambro, Faisal Azhar, et al. 2023a. Llama: Open and efficient foundation language models. arXiv preprint arXiv:2302.13971.

【4】Hongbo Zhang, Junying Chen, Feng Jiang, Fei Yu, Zhihong Chen, Jianquan Li, Guimin Chen, Xiangbo Wu, Zhiyi Zhang, Qingying Xiao, Xiang Wan, Benyou Wang, and Haizhou Li. 2023b. Huatuogpt, towards taming language model to be a doctor. ArXiv, abs/2305.15075.

【5】Siyang Liu, Chujie Zheng, Orianna Demasi, Sahand Sabour, Yu Li, Zhou Yu, Yong Jiang, and Minlie Huang. 2021. Towards emotional support dialog systems. In Proceedings of the 59th Annual Meeting of the Association for Computational Linguistics and the 11th International Joint Conference on Natural Language Processing (Volume 1: Long Papers), pages 3469–3483, Online. Association for Computational Linguistics.