热门标签

热门文章

- 1狂奔的羊驼-llama3生态大爆发_llama 3

- 2C++使用imgui框架的绘制封装-绘制矩形-直线-文字-菜单-(复制即用)_imgui绘制菜单源码

- 3JPA-主键生成策略_strategy = generationtype.identity

- 4为什么虚函数(virtual)不能是static函数_虚函数为什么不能是静态成员函数

- 5【Stable Diffusion】插件 ADetailer,修脸修手无敌_adetailer修手

- 6json文件的格式化_json格式化

- 7HTTP协议_http明文传输吗

- 8软件安全技术【太原理工大学】_名词解释威胁建模

- 9Mac 如何安装git_git mac install

- 10智能新时代的天津故事

当前位置: article > 正文

LLMs之RAG:只需四步骤—基于Ollama后端框架(配置phi3/LLaMA-3模型)结合Dify前端框架(设置知识库文件+向量化存储+应用发布)创建包括实现本地知识库问答/翻译助手等多个应用_llama3本地化rag教程

作者:盐析白兔 | 2024-06-16 13:46:27

赞

踩

llama3本地化rag教程

LLMs之RAG:基于Ollama后端框架(配置phi3/LLaMA-3模型)结合Dify前端框架(设置知识库文件+向量化存储+应用发布)创建包括实现本地知识库问答/翻译助手等多个应用

目录

基于Ollama后端框架(配置phi3/LLaMA-3模型)结合Dify前端框架(设置知识库文件+向量化存储+应用发布)创建包括实现本地知识库问答/翻译助手等多个应用

基于Ollama后端框架(配置phi3/LLaMA-3模型)结合Dify前端框架(设置知识库文件+向量化存储+应用发布)创建包括实现本地知识库问答/翻译助手等多个应用

1、配置依赖

1.1、安装Docker和Docker Compose,

| 安装 | 安装Docker和Docker Compose 参考A3、Windows11系统安装→交互式安装即可,一次性安装Docker和Docker Compose |

1.2、安装并配置Ollama

| 安装并配置Ollama | 安装并配置Ollama参考 地址:LLM之Ollama:ollama的简介、安装和使用方法、案例应用之详细攻略_ollama中文说明书-CSDN博客 地址02:https://yunyaniu.blog.csdn.net/article/details/138235781 |

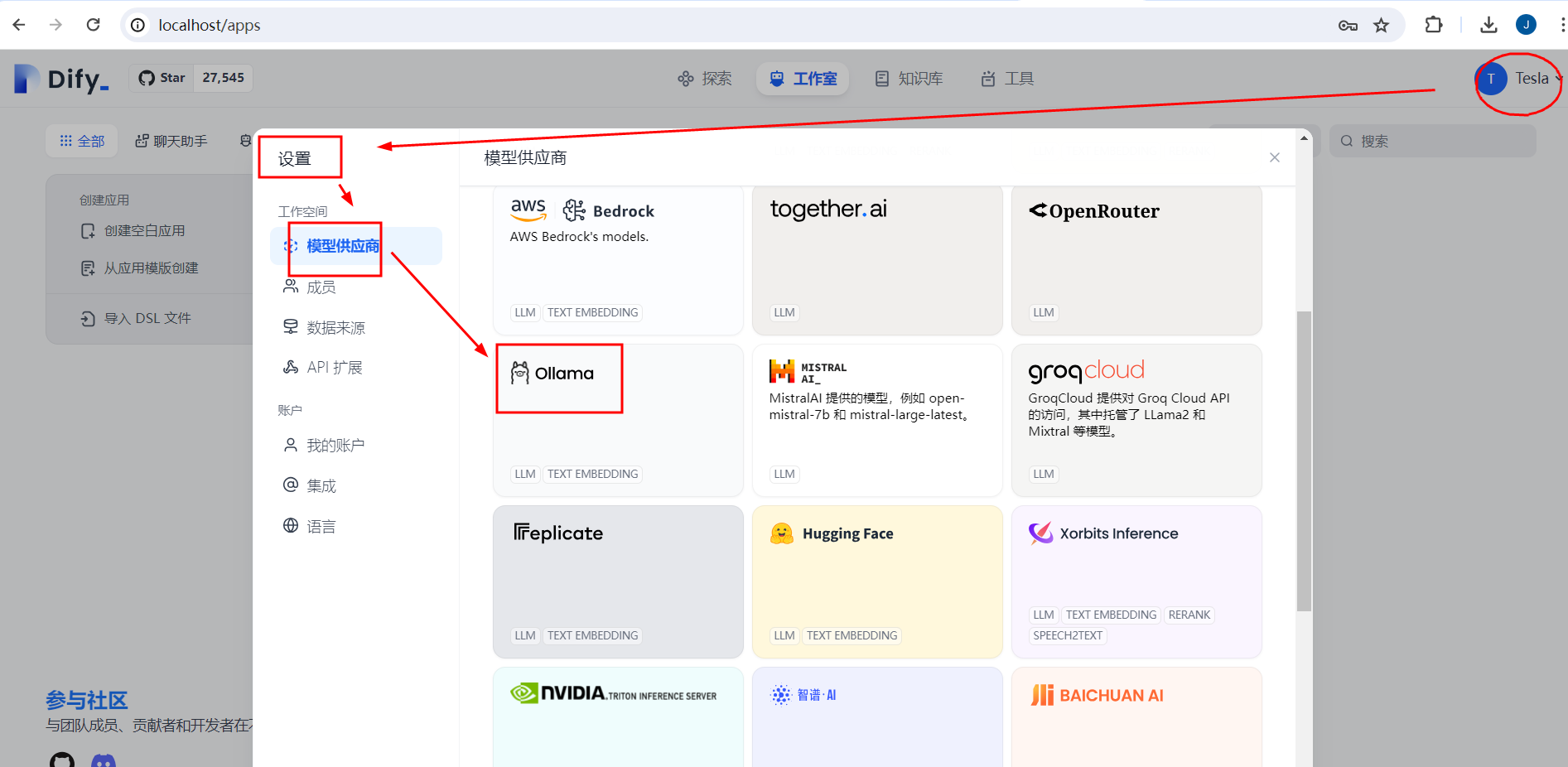

1.3、打开Dify界面并配置模型

| 安装并启动Dify | 参考——1、Dify的安装和启动 |

| 打开界面 | 浏览器中访问http://localhost/install并开始初始化过程,设置账号,之后用此账号登录。 |

2、创建模型基于RAG的对话应用

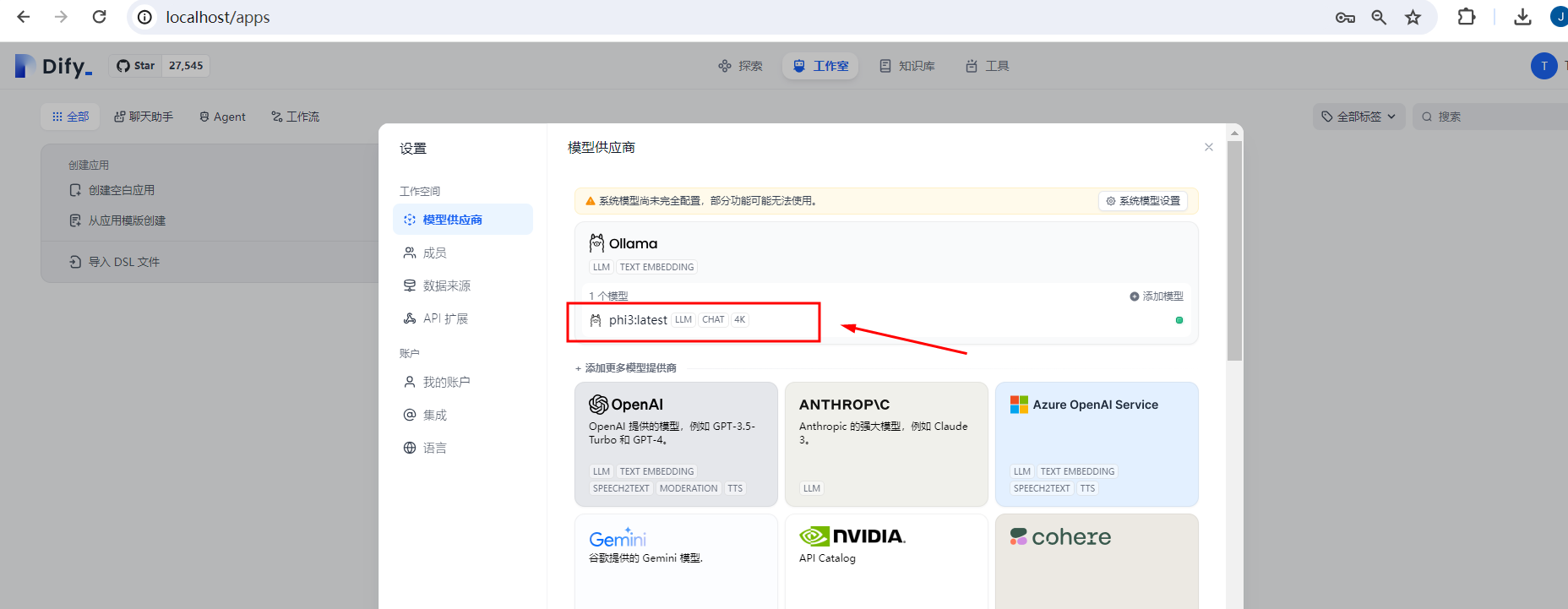

2.1、配置模型

| 配置模型 | 模型名称:phi3:latest |

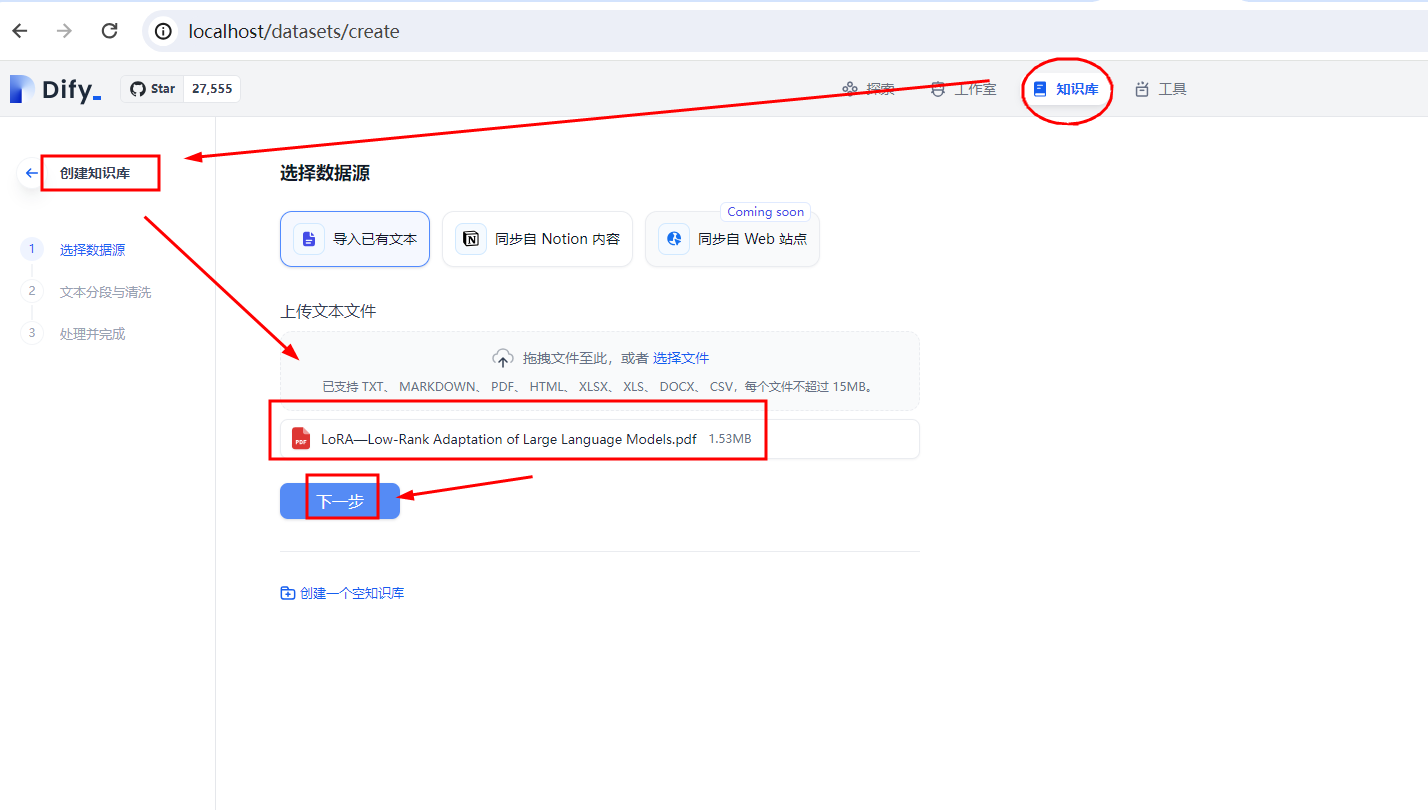

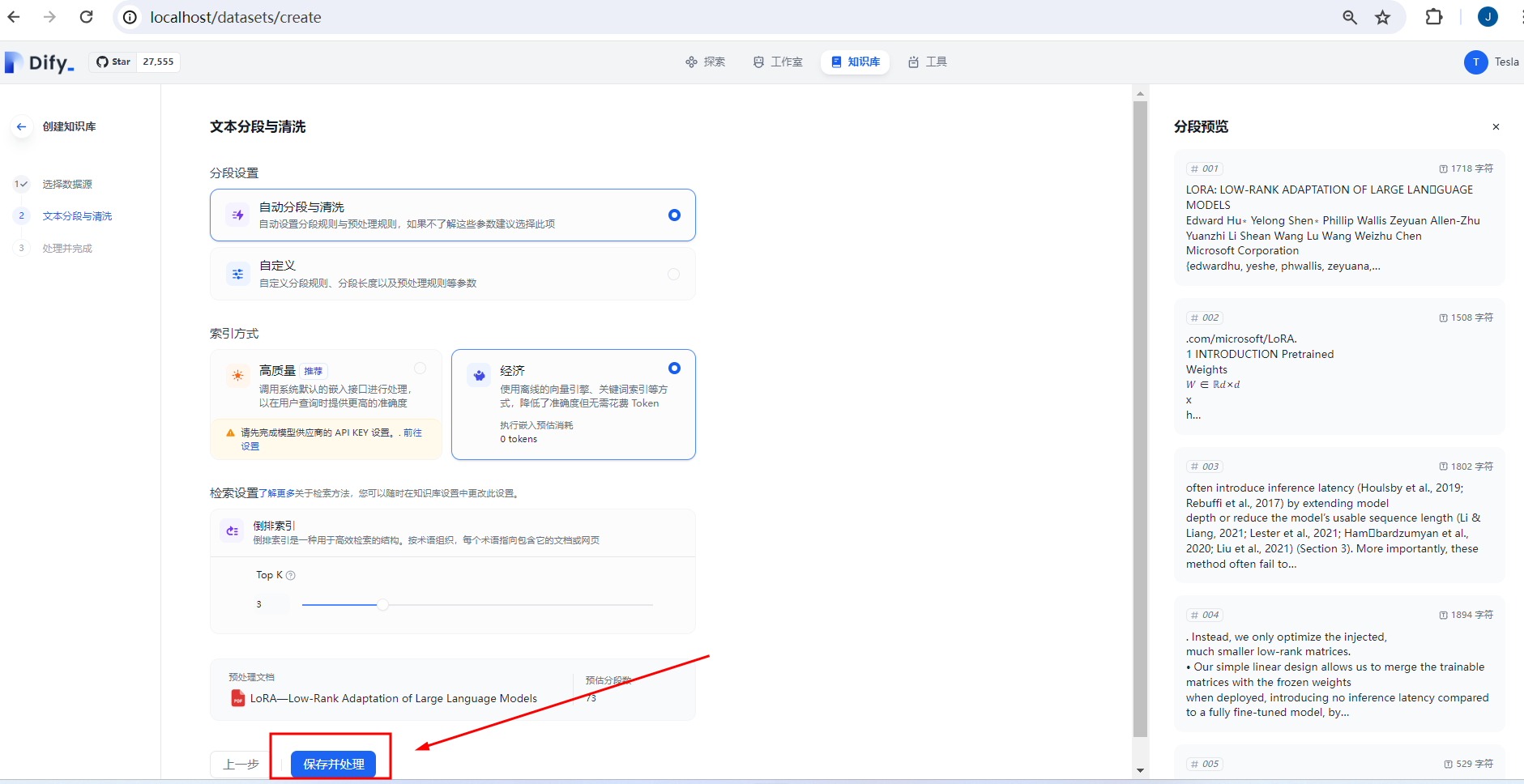

2.2、创建知识库并向量化存储

点击知识库→创建知识库→添加PDF资料→保存并处理

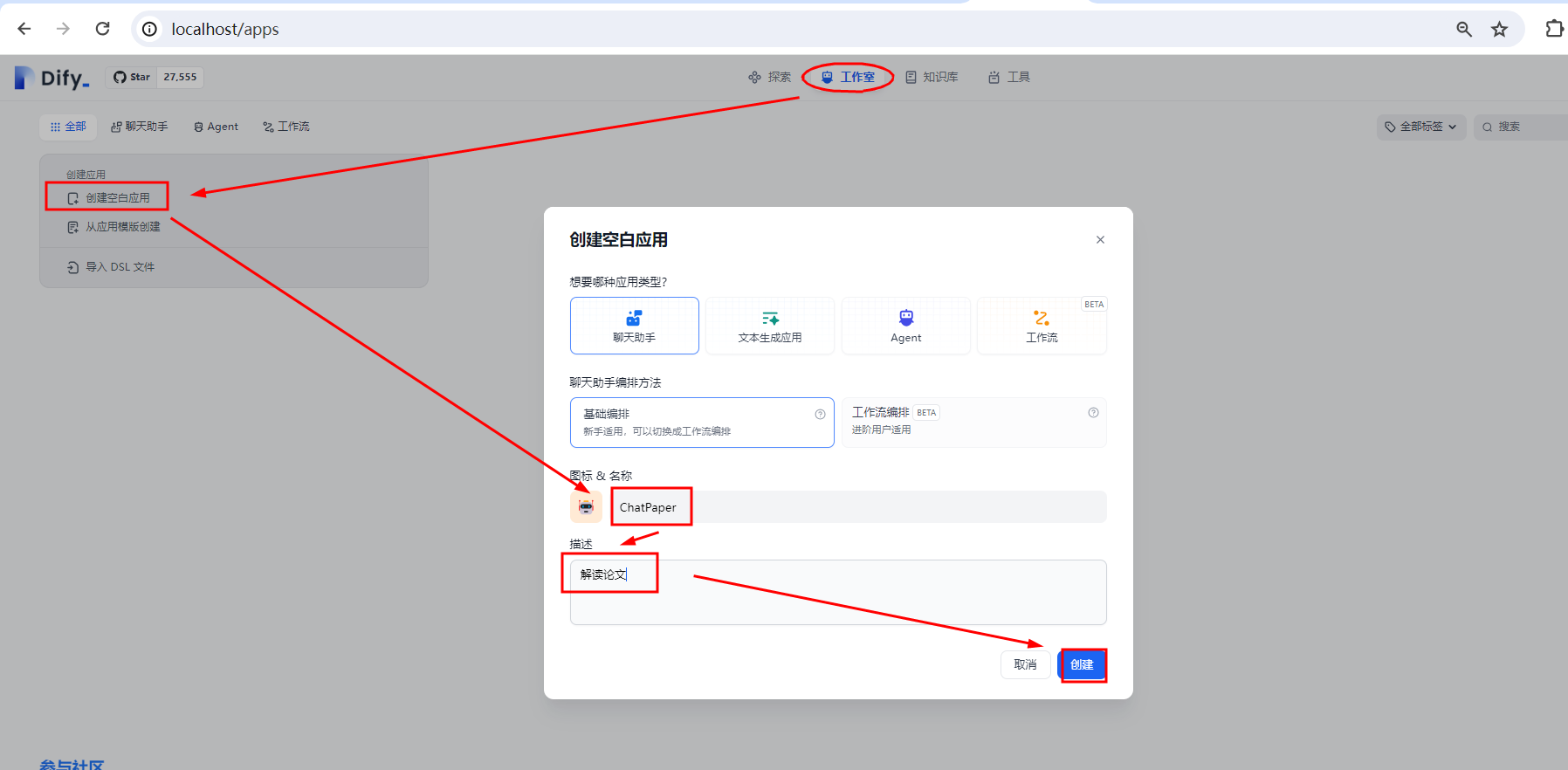

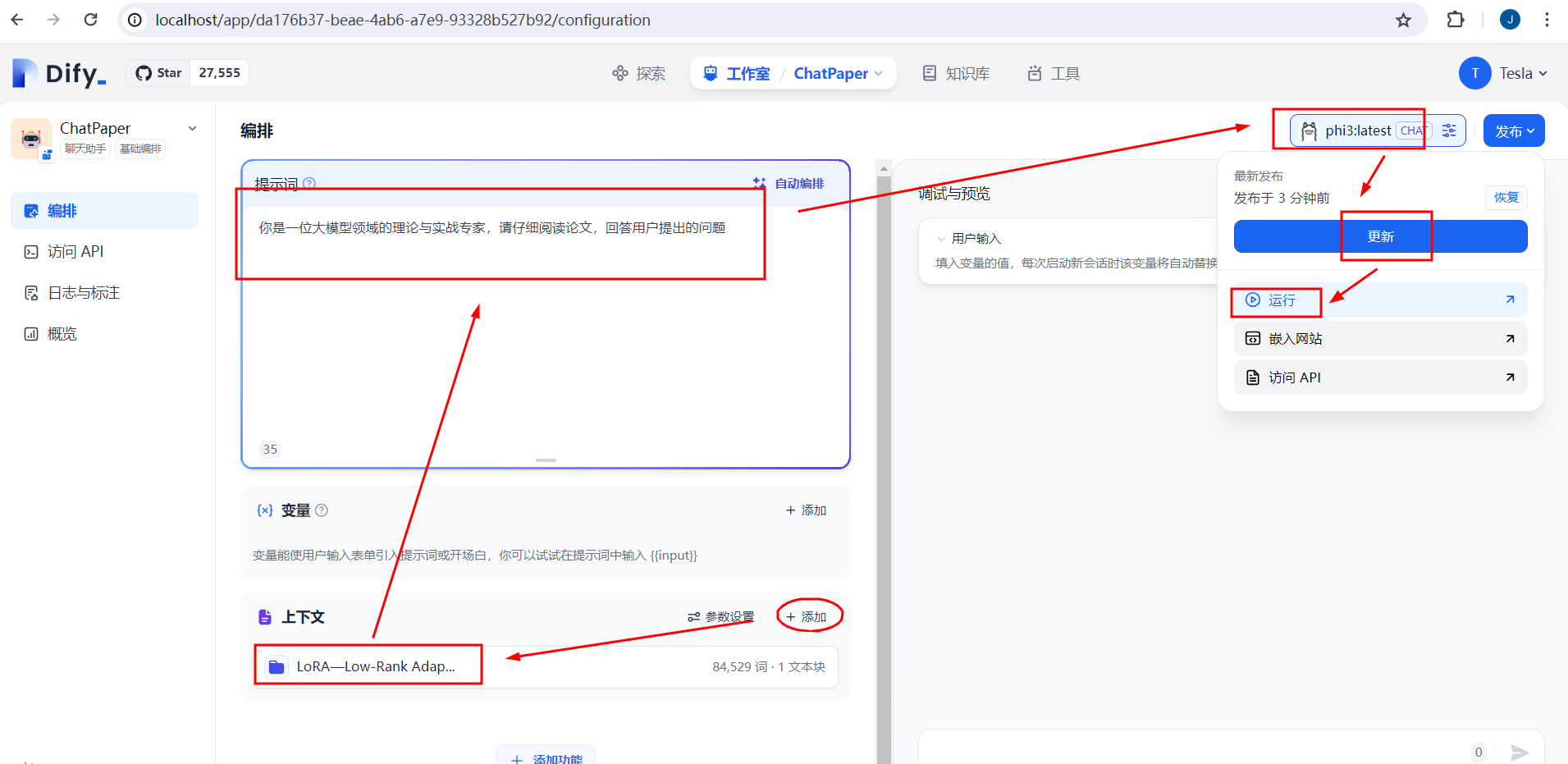

2.3、创建应用并发布

创建应用→设置角色→添加知识库资料→并设置提示词→选择大语言模型→依次点击更新→发布→Start Chat即可!

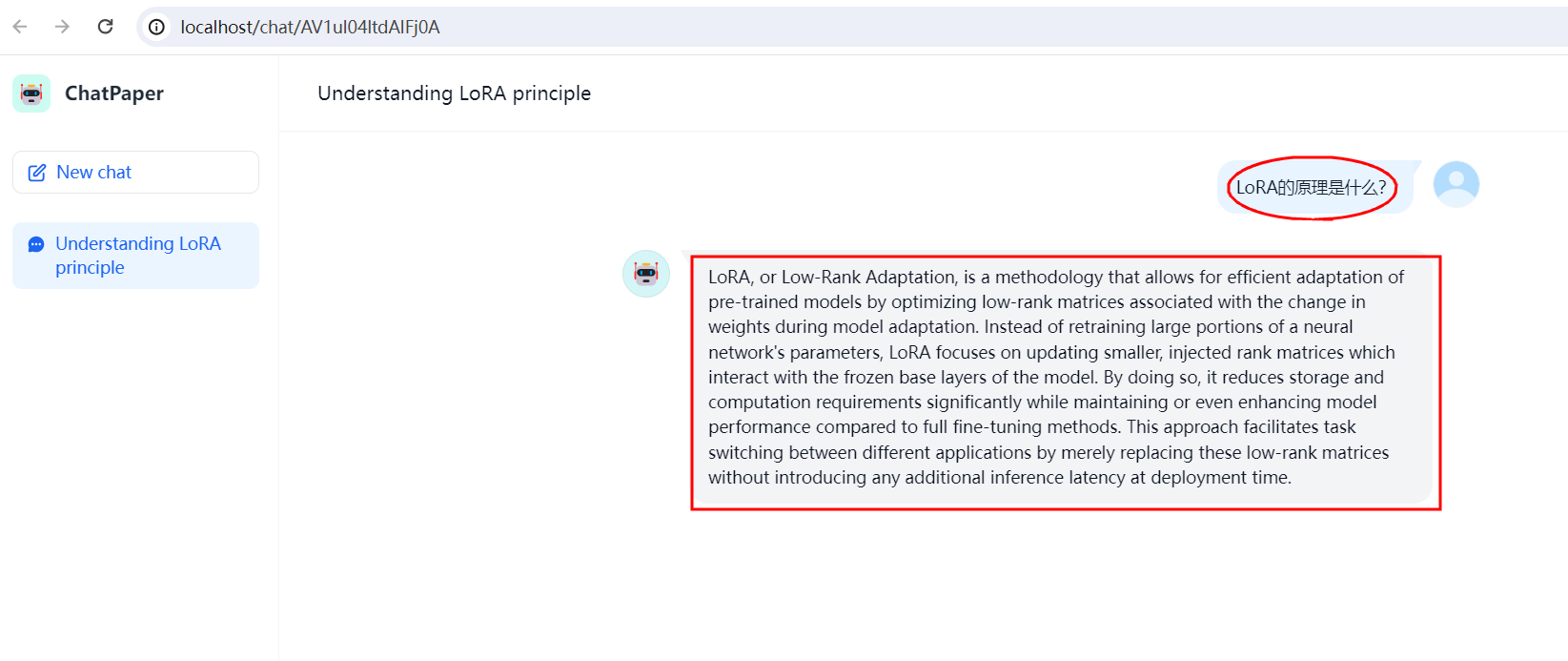

2.4、基于知识库进行对话测试

推荐阅读

相关标签