热门标签

热门文章

- 1十七、网上商城项目(1)_网上商城 项目

- 2本地图形客户端查看git提交历史 使用 TortoiseGit_tortisegit查看历史提交记录

- 3通俗易懂的KMP算法(C++)_kmp算法c++

- 4排序算法与复杂度介绍

- 5测试阶段与测试技术(一)概述_测试阶段技术。

- 6传神论文中心|第11期人工智能领域论文推荐_are long-llms a necessity for longcontext tasks gi

- 7python课设可视化答辩问题_浅析python 可视化

- 8Transfomer-学习笔记_transfomer 同时输入多少个词向量

- 9数据库-ElasticSearch入门(索引、文档、查询)_http获取索引的所有文档(1)_elasticsearch 获取索引

- 10YARA字符串匹配_yara strings

当前位置: article > 正文

李宏毅 ML2021 学习笔记 - W7 Self-supervised Learning_self supervise learning 2021

作者:爱喝兽奶帝天荒 | 2024-07-19 11:02:38

赞

踩

self supervise learning 2021

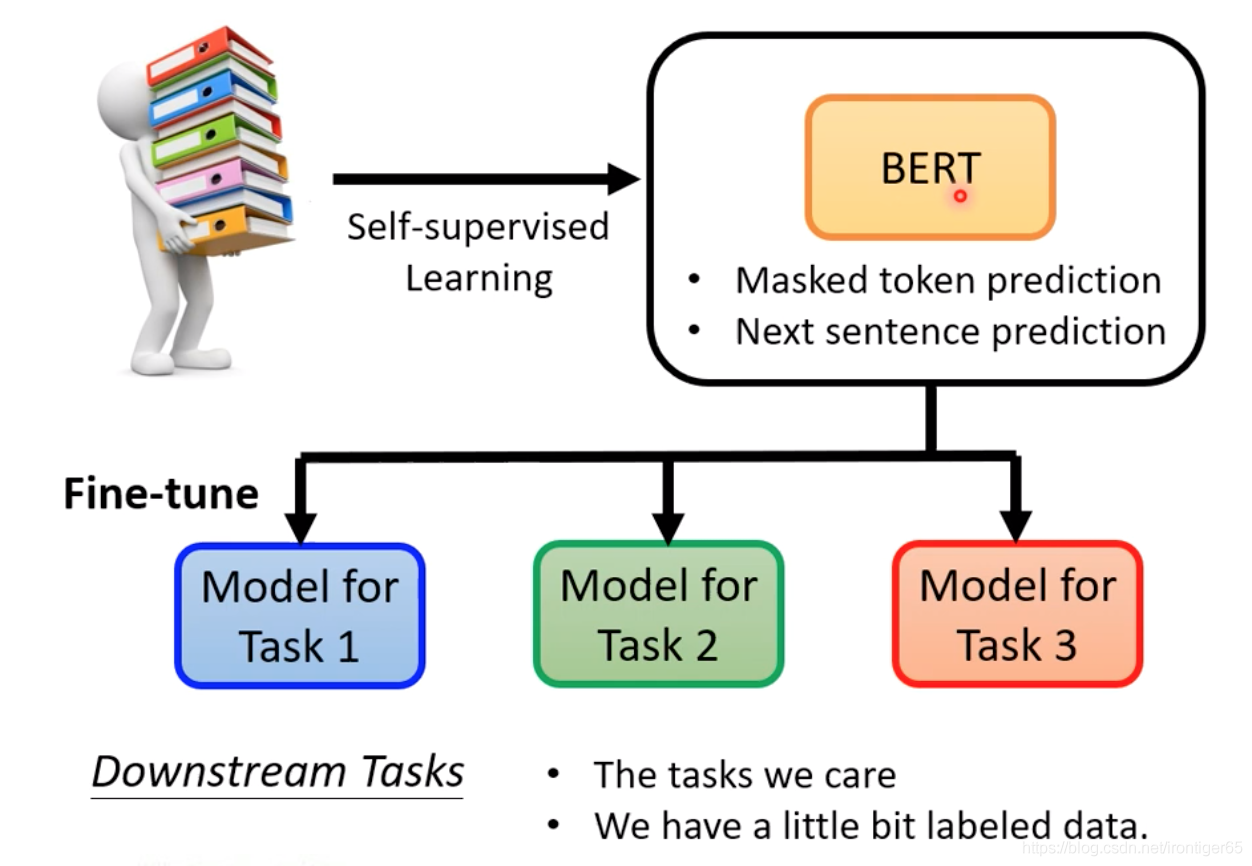

1. BERT

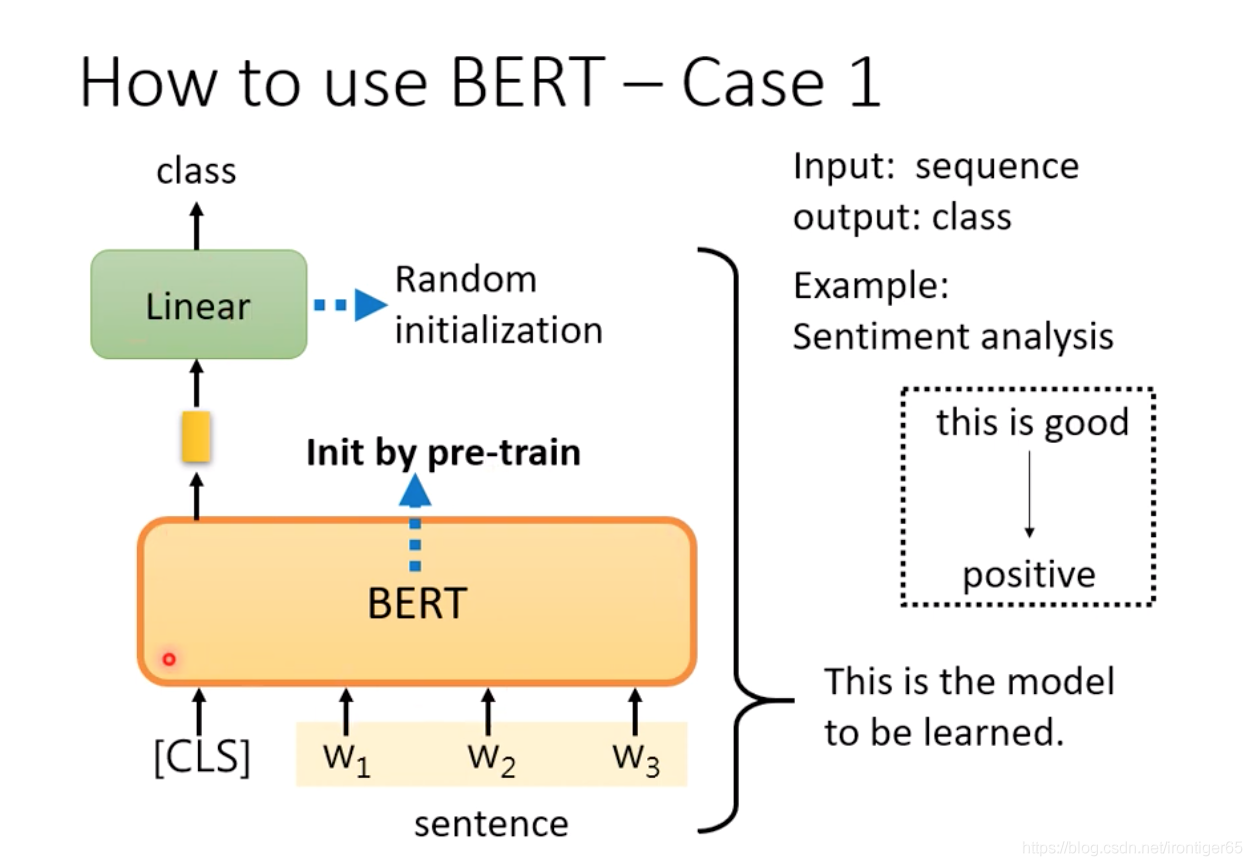

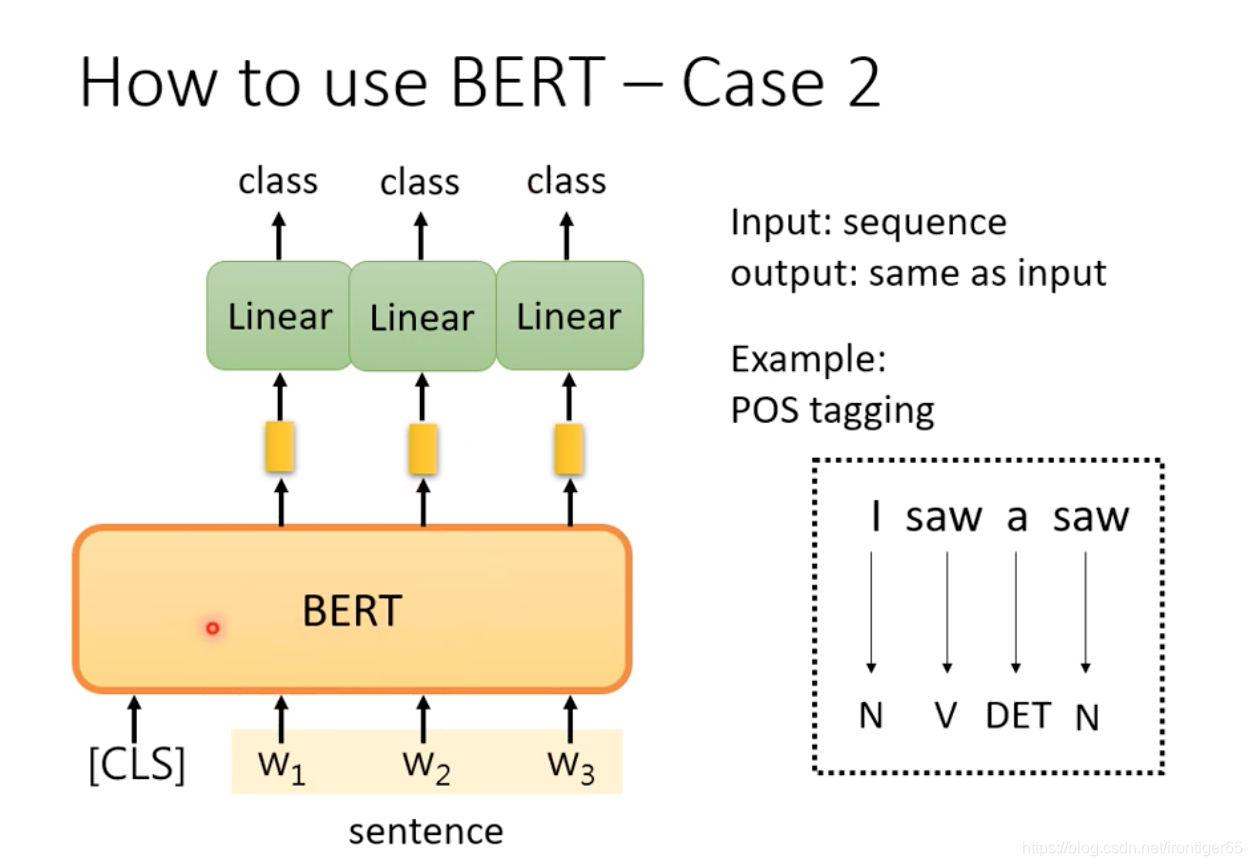

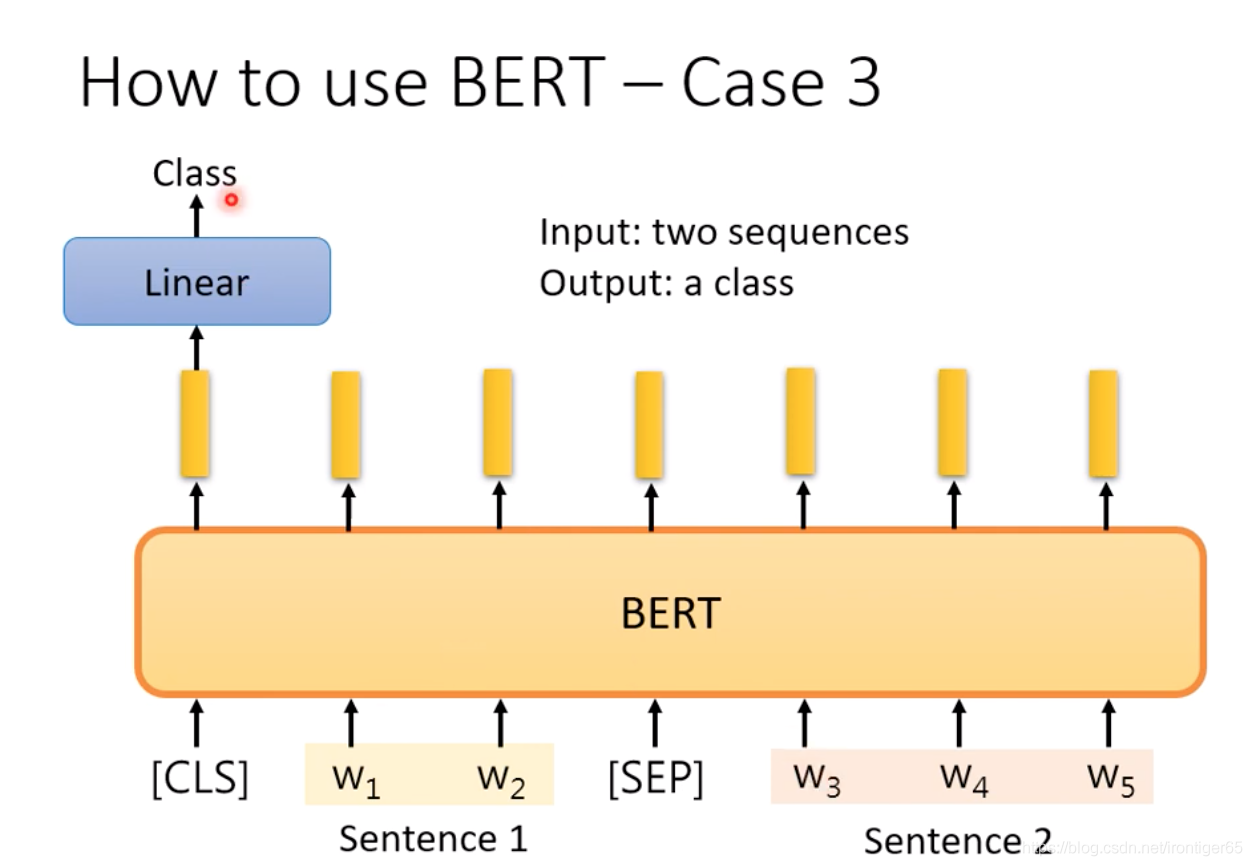

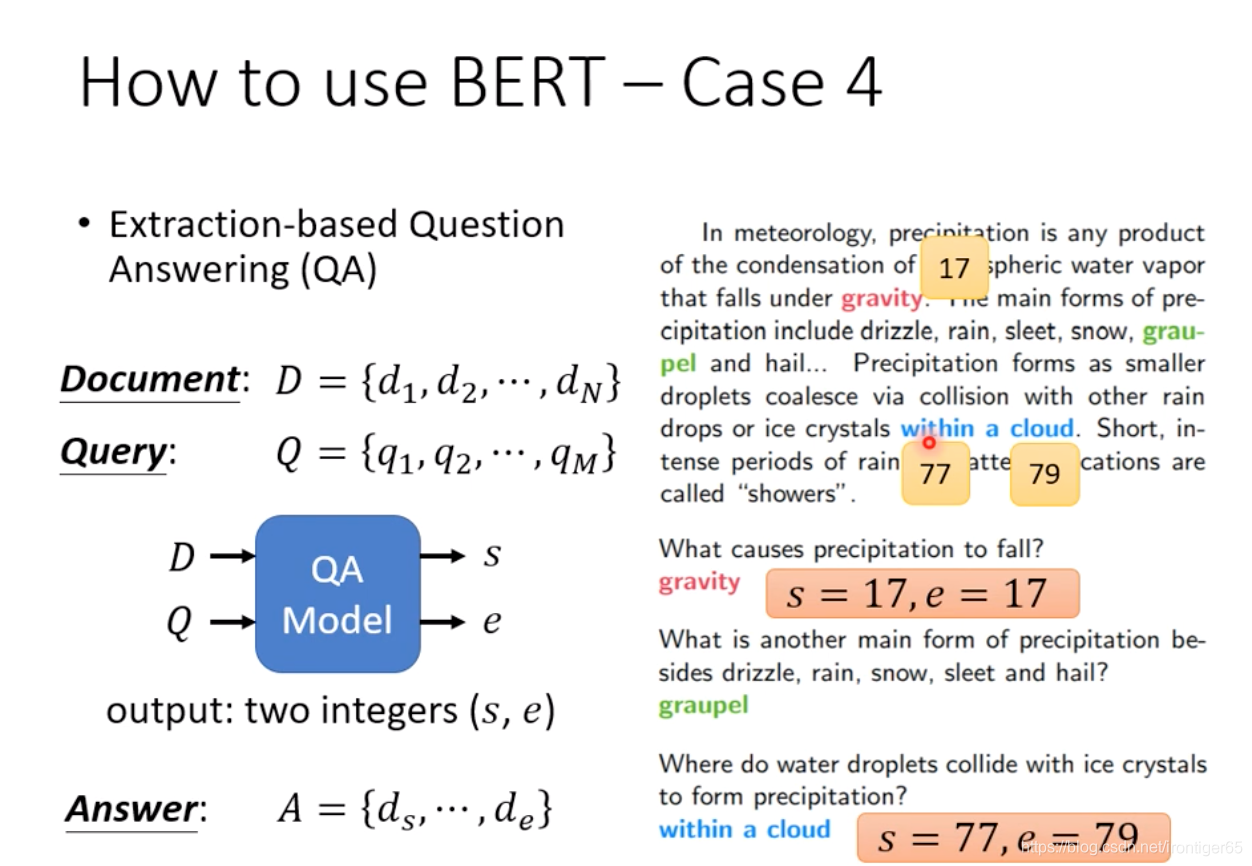

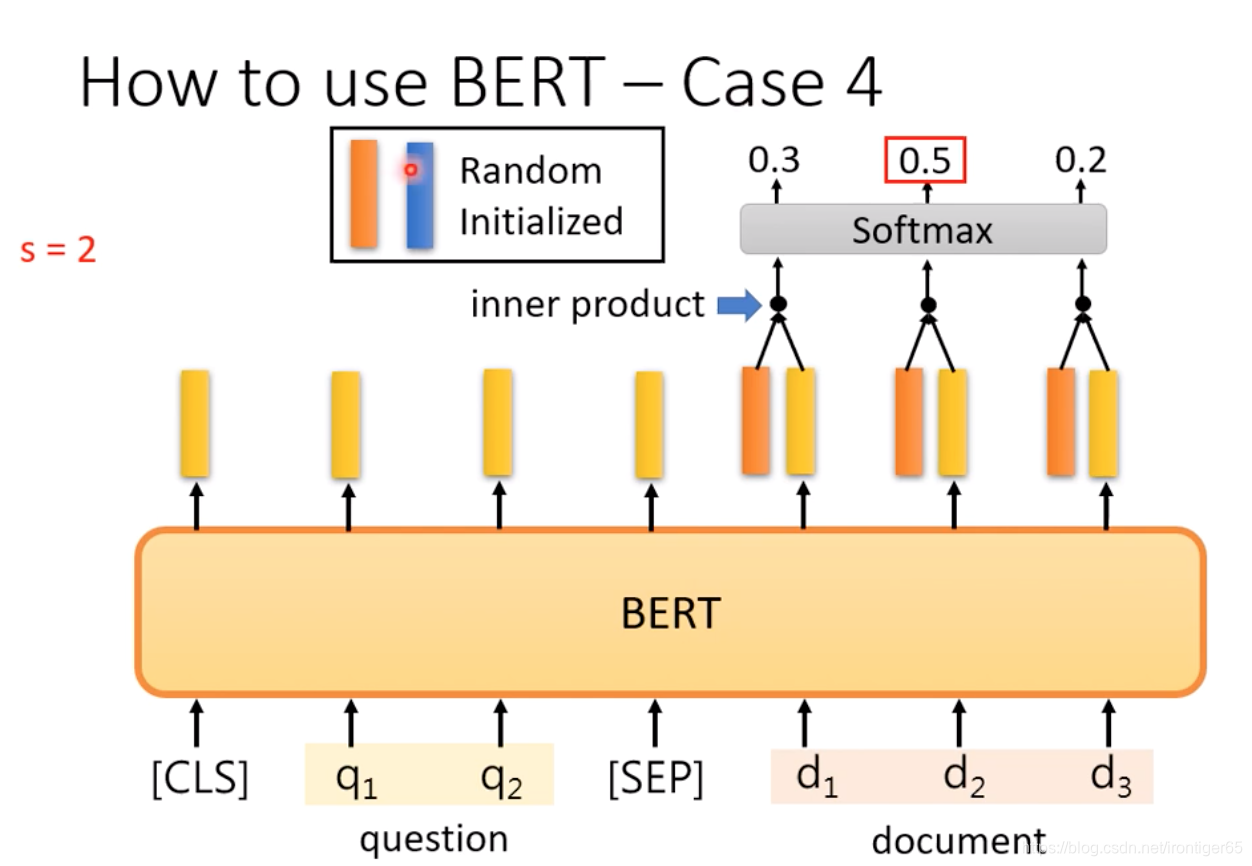

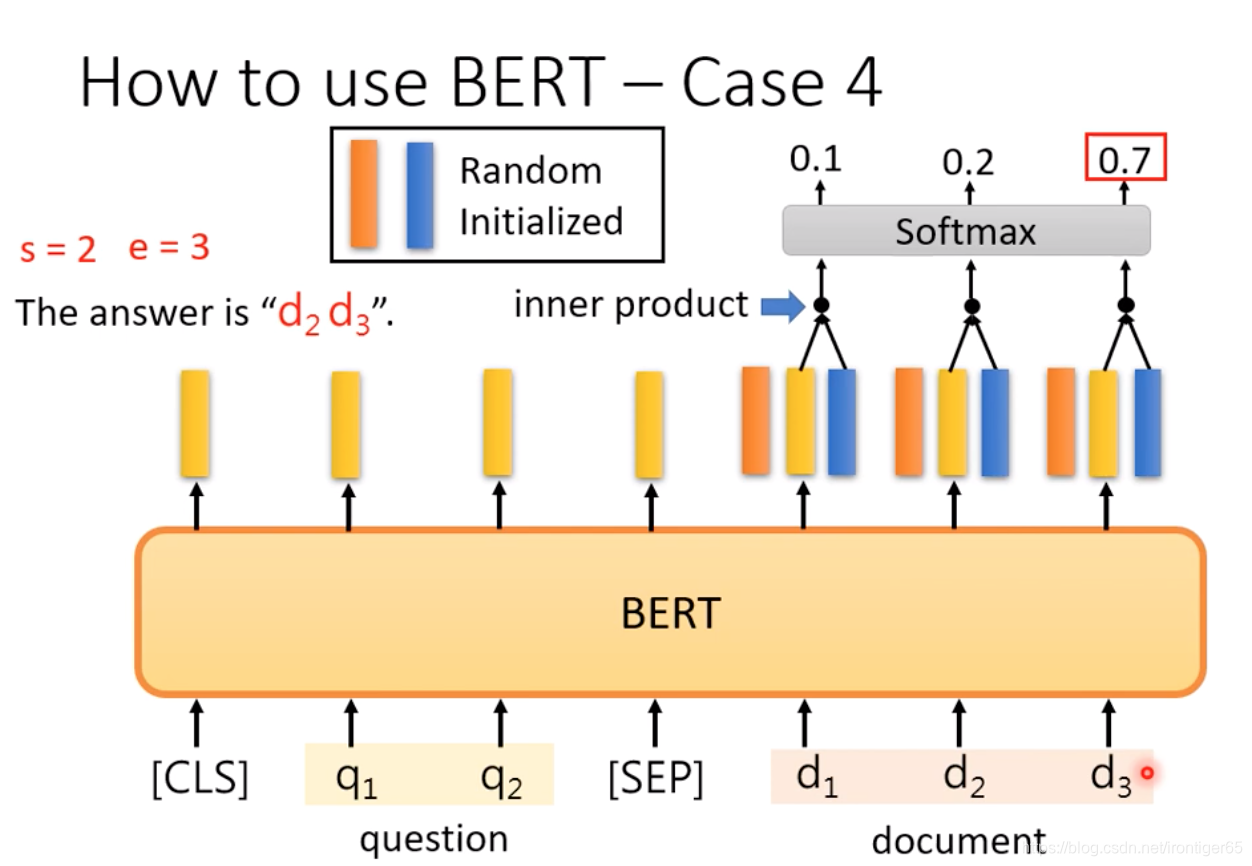

1. How to use BERT

都需要一些labled data

Case 3: NLI (Natural Language Inference)

实做上,bert不能吃无限长度的输入,大概最长512左右。

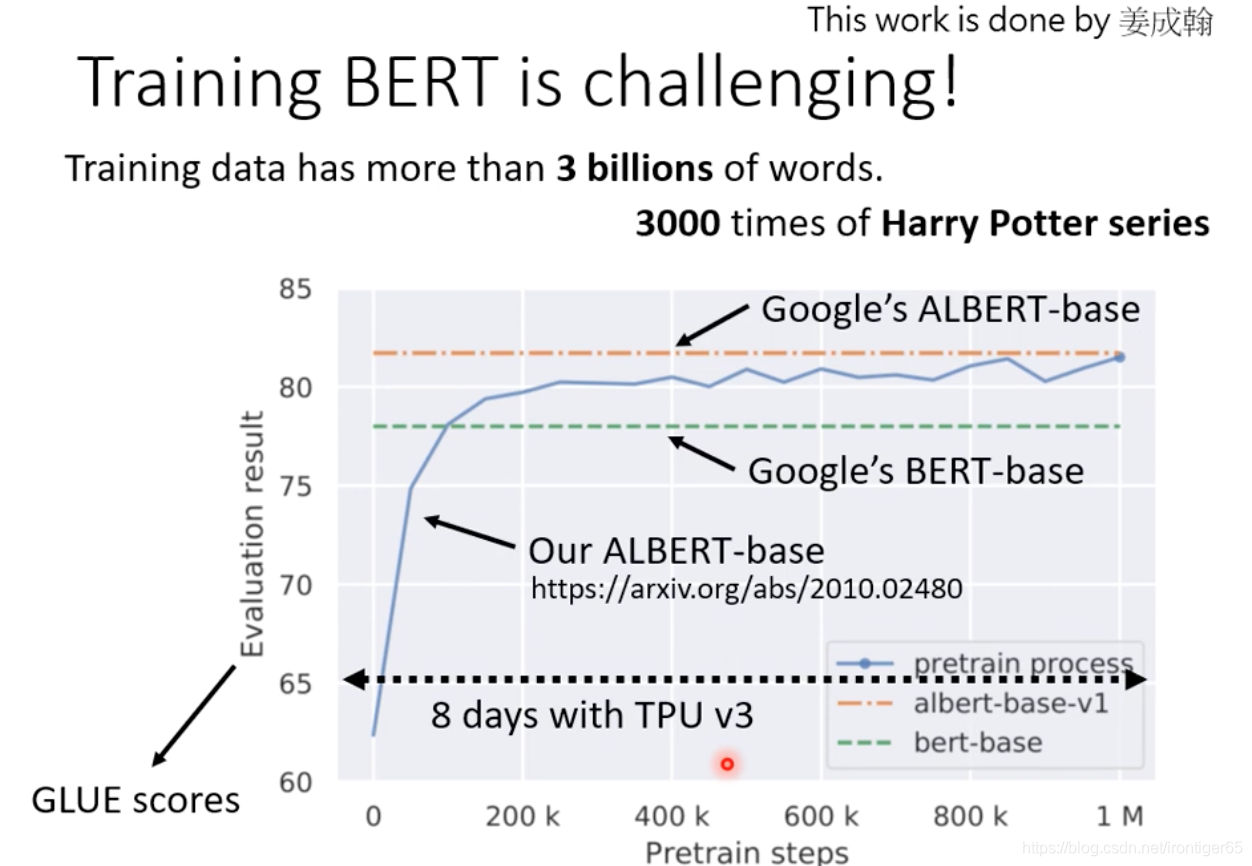

2. Training BERT is challenging

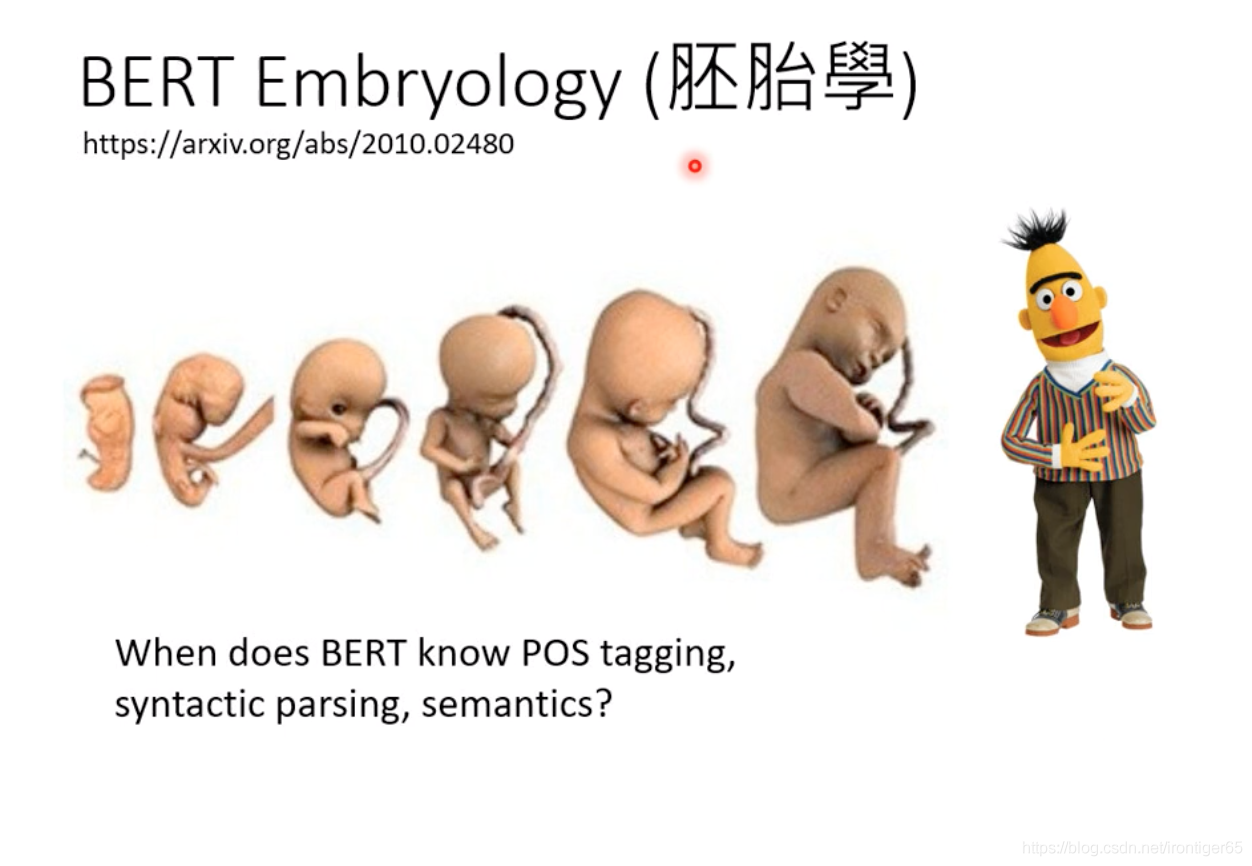

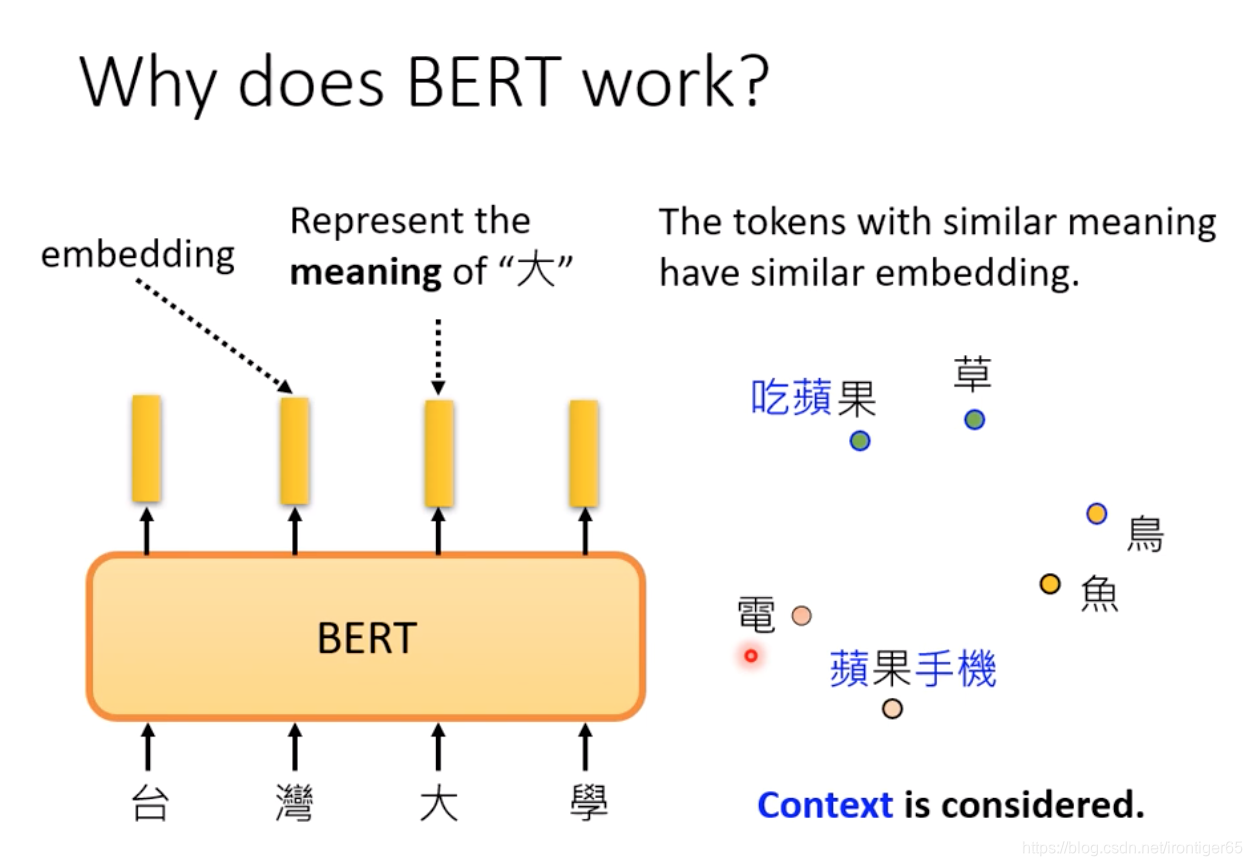

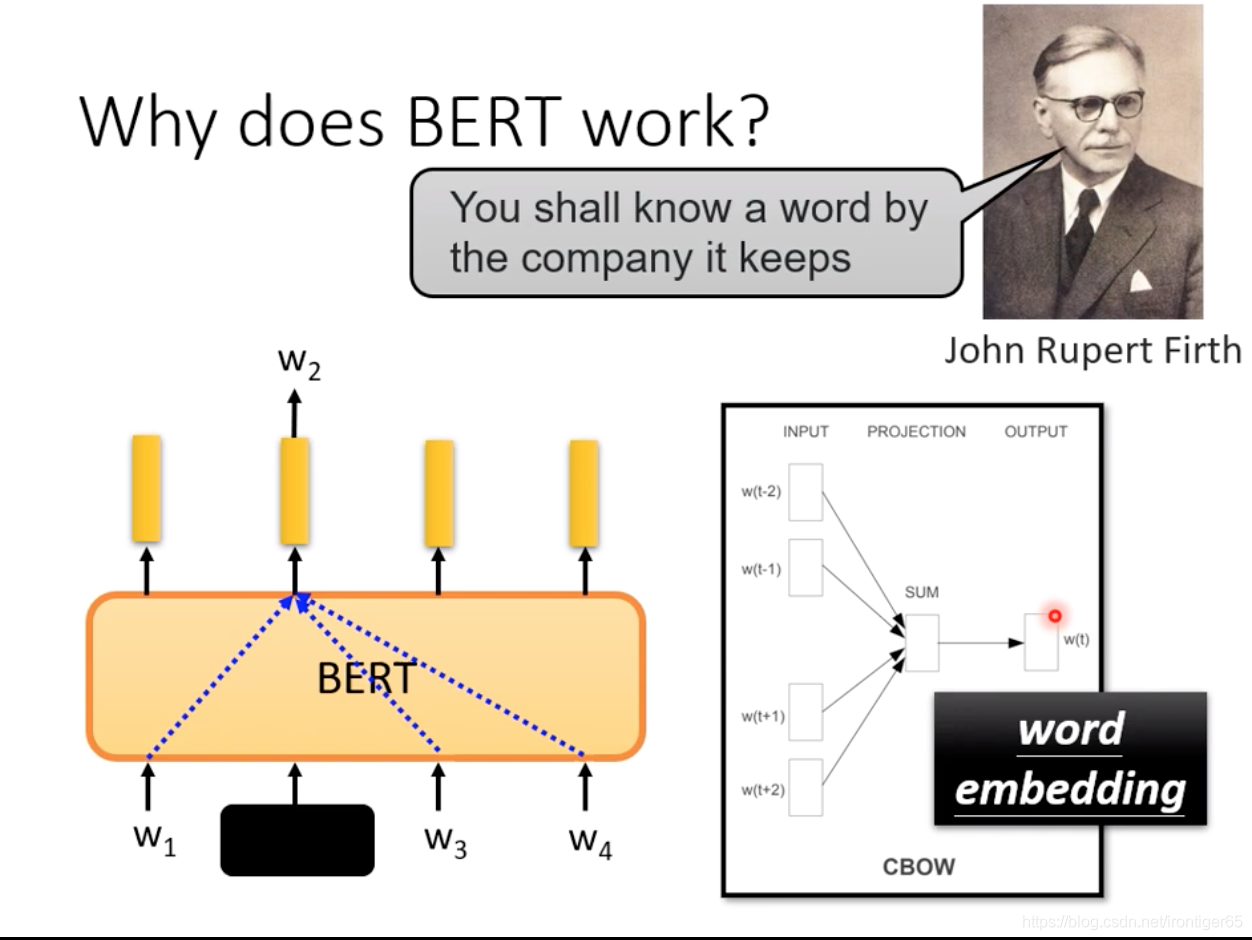

3. Why does BERT work?

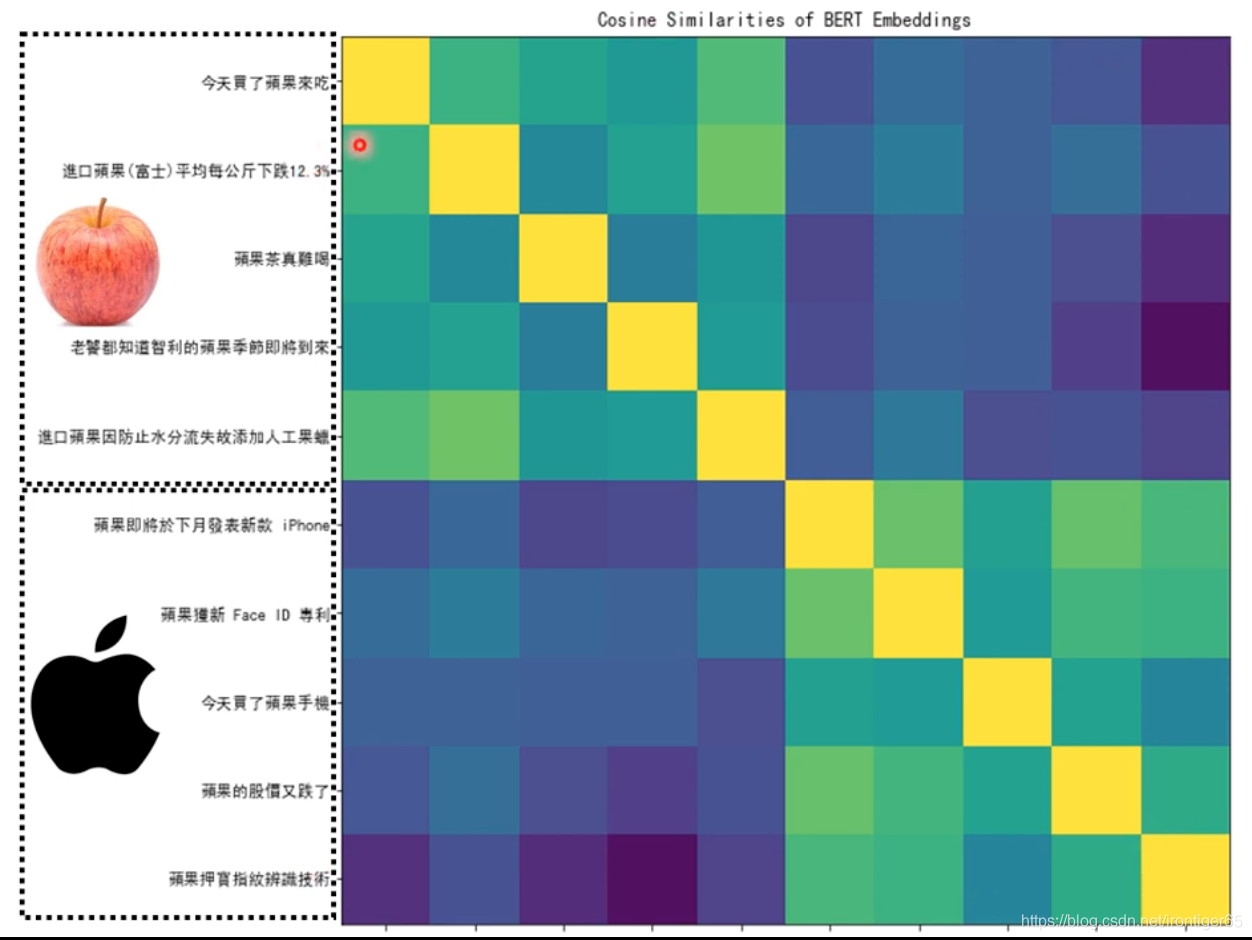

前5个果是水果的果,后5个是苹果电脑的果,计算它们embedding的cosine similarity

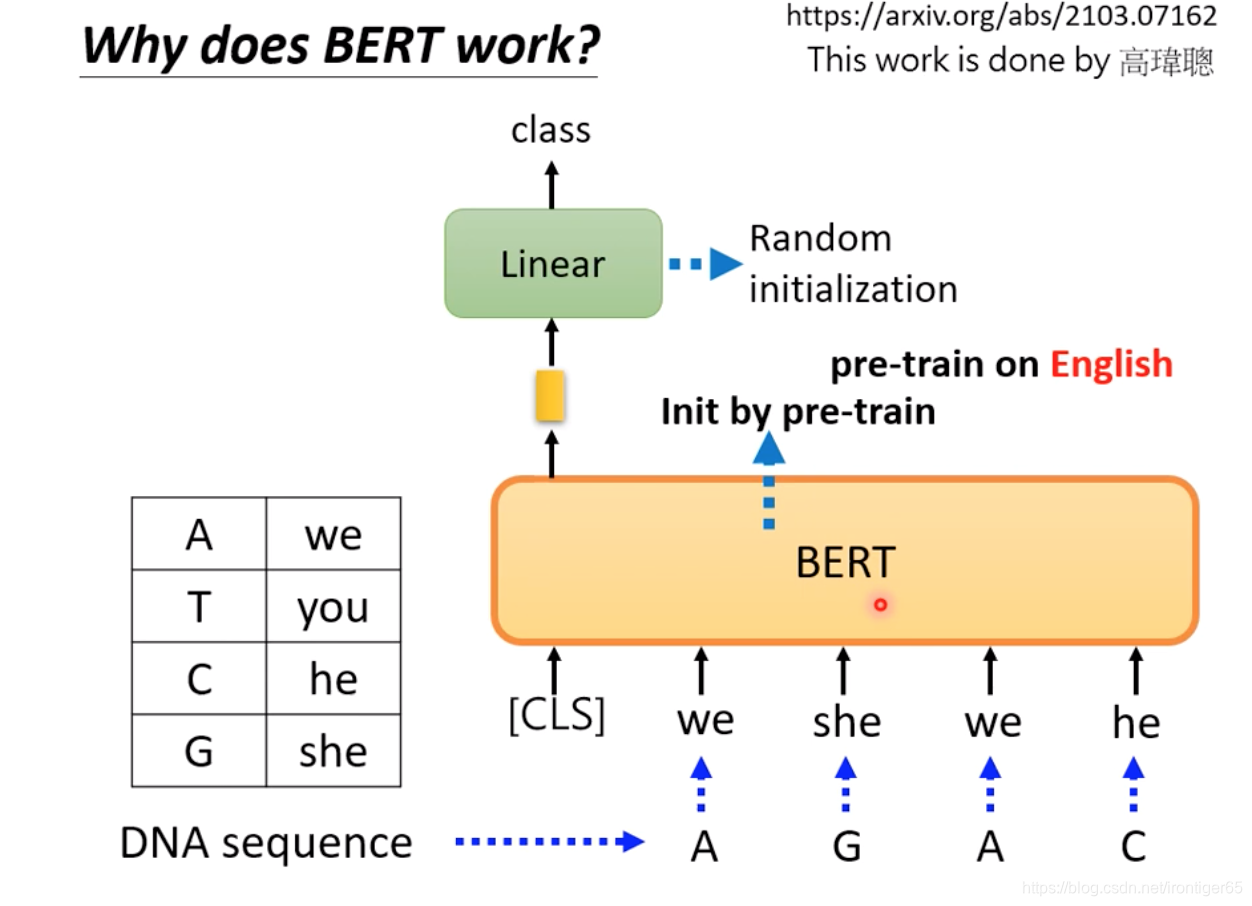

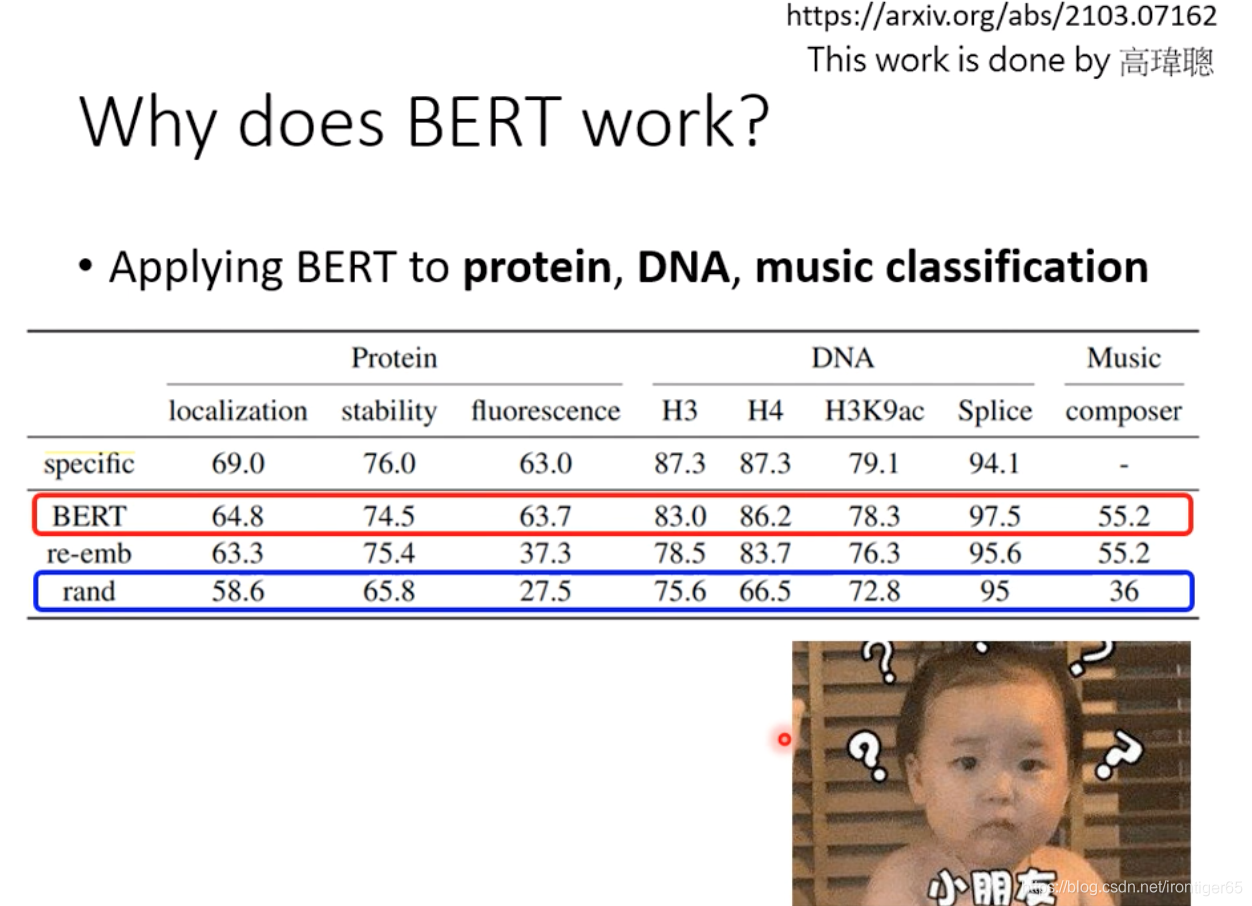

用随机的英文单词代替DNA编码

→ BERT 为什么会好?还有很多研究的空间

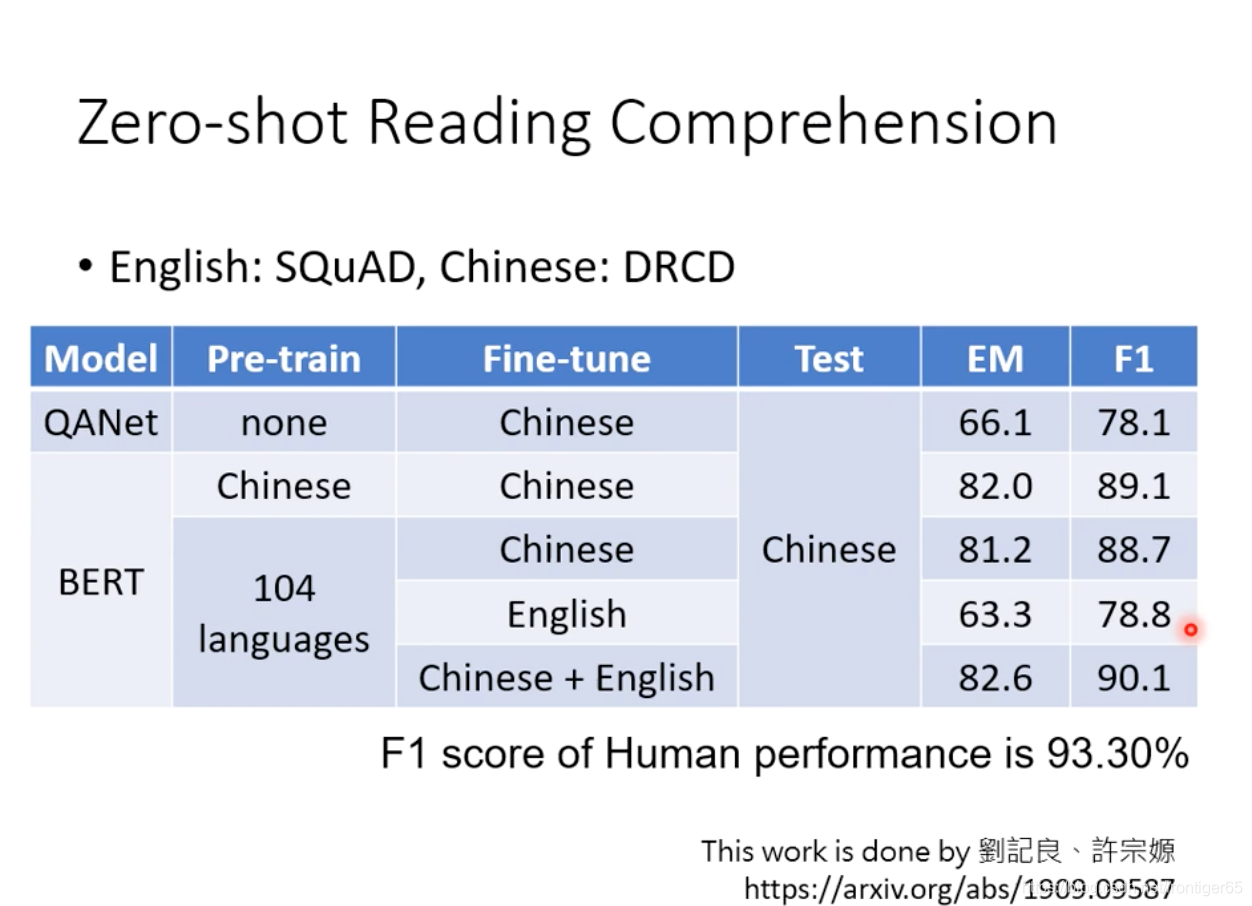

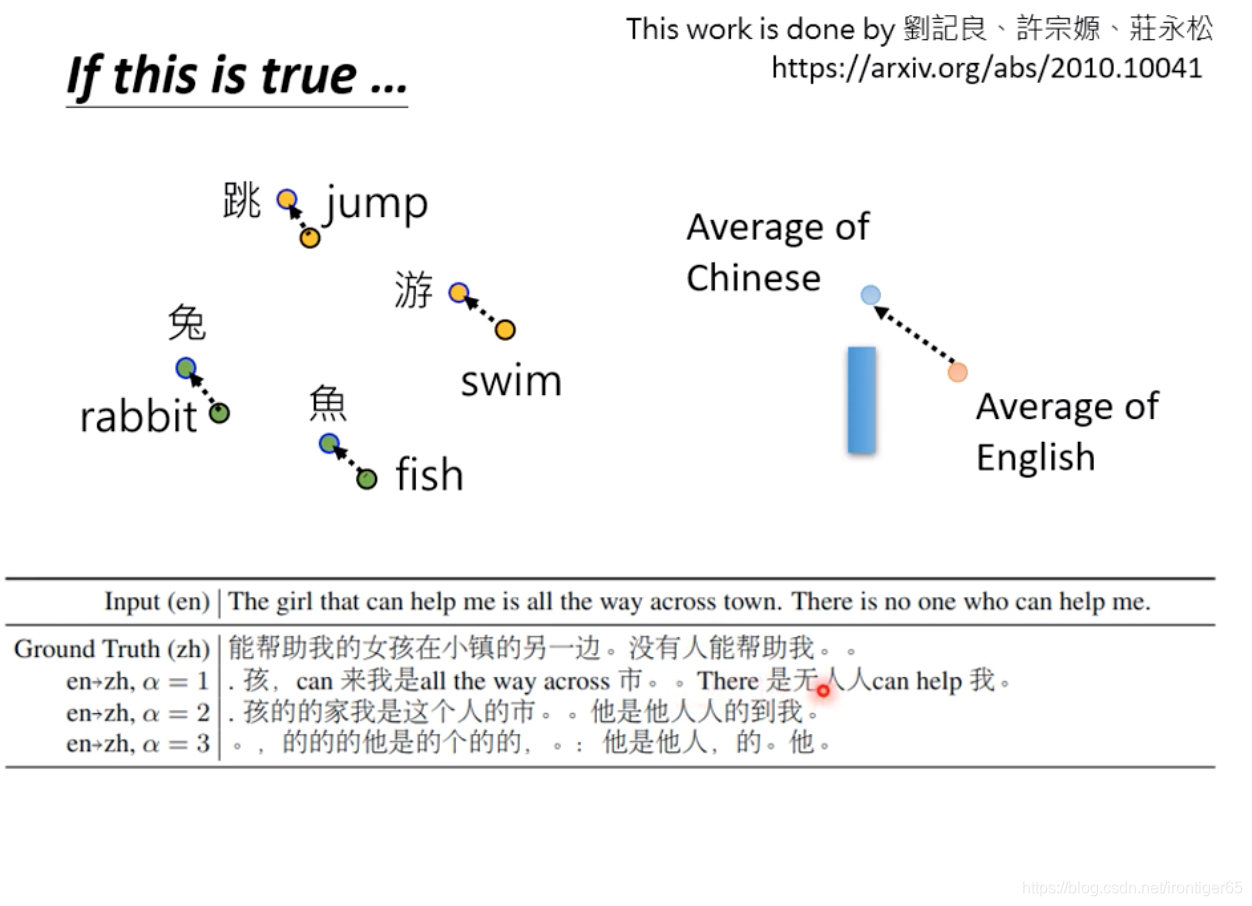

4. Multi-BERT

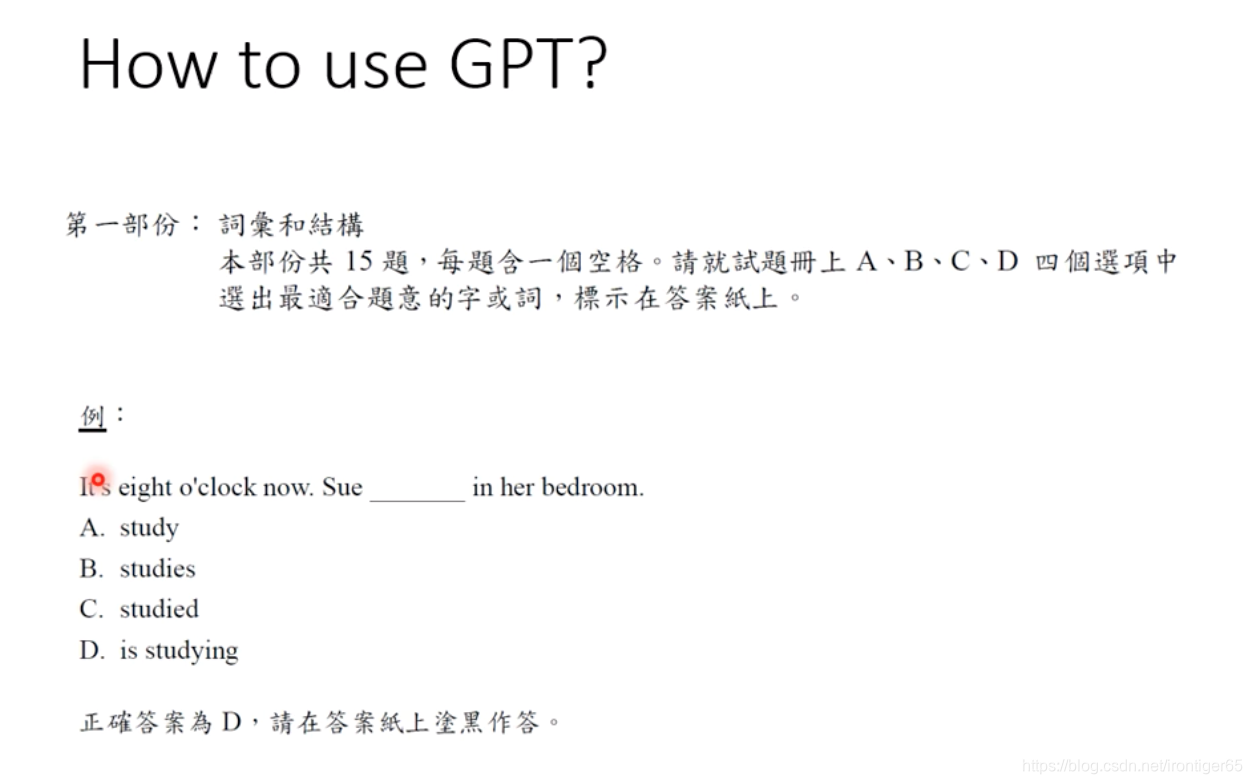

2. GPT

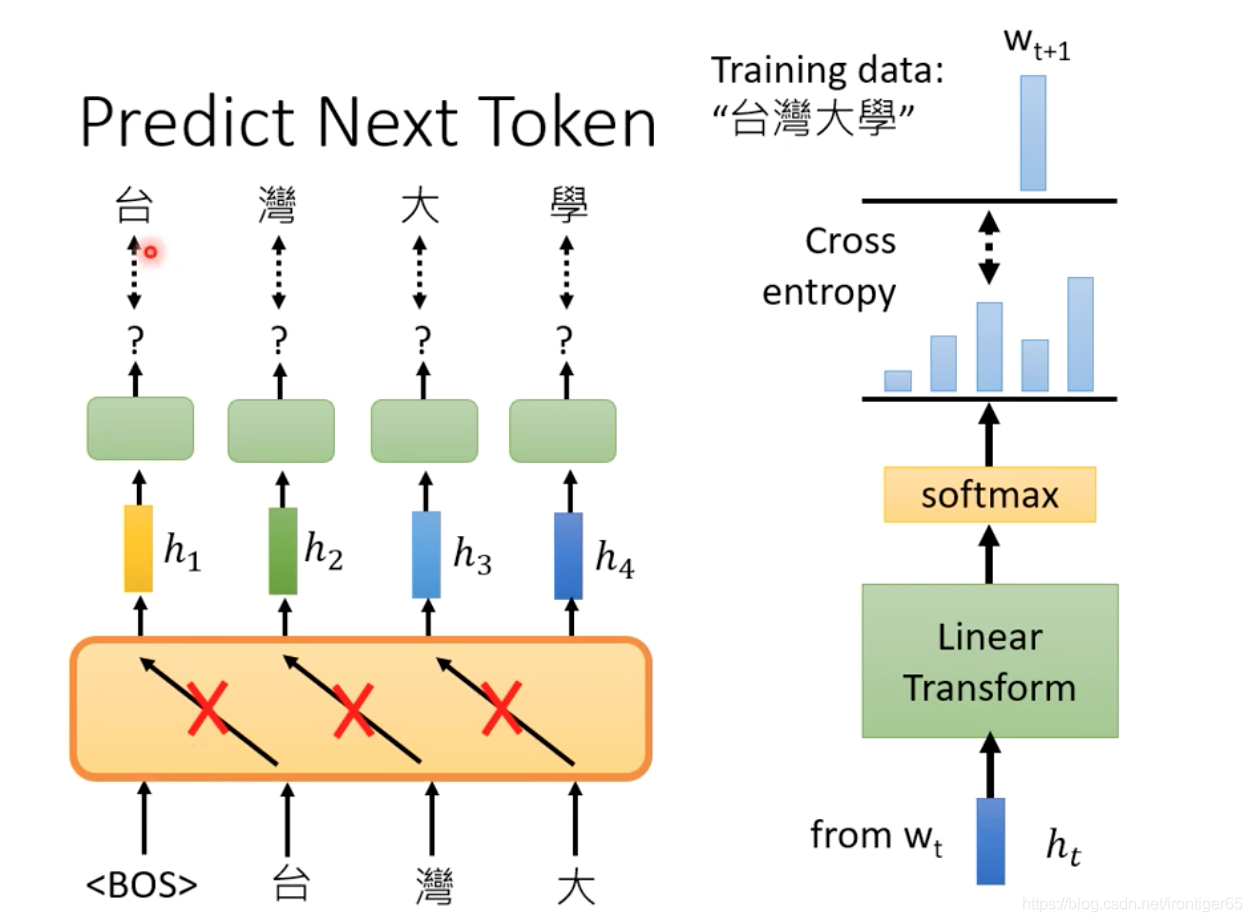

Predit Next Token

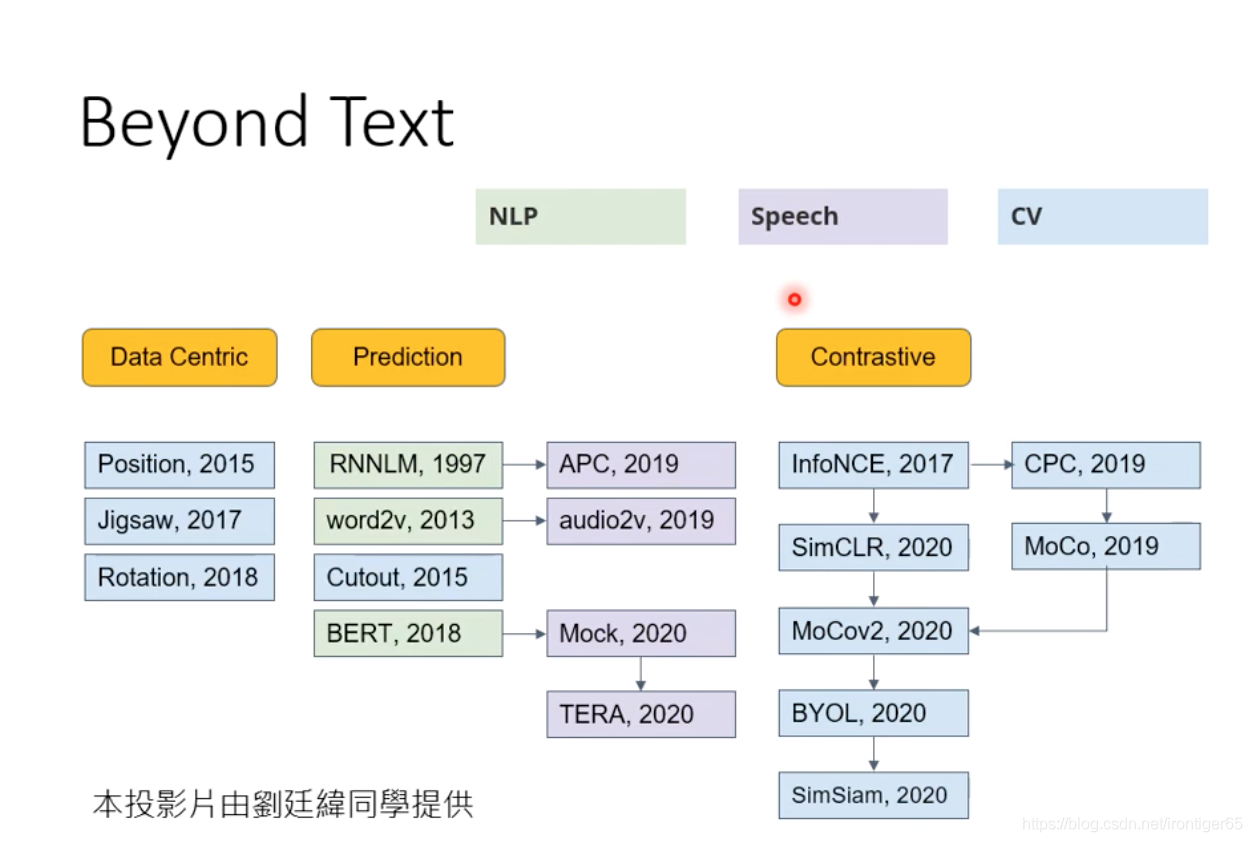

3. 其他self-supervised learning内容

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/爱喝兽奶帝天荒/article/detail/851110

推荐阅读

相关标签