热门标签

热门文章

- 1docker安装,yum安装失败解决方案,阿里云镜像安装

- 2Mask RCNN保存分割后的图片_maskrcnn将分割的图片保存

- 3Win10中pyTorch1.4.0+tensorboard配置后graph显示空白_torch 1.4 对应tensorboard什么版本

- 4车辆信息检测数据集收集汇总_ngvsim数据集车辆id识别

- 5鸿蒙系统国内厂商,谷歌自食其果,华为鸿蒙系统已经被启用,国内厂商或将弃用安卓...

- 6GitHub Desktop安装与使用教程

- 7代码随想录算法训练营第三十三天 | 动态规划理论基础、509. 斐波那契数、70. 爬楼梯、746. 使用最小花费爬楼梯

- 8HTML5果蔬电商购物网站css3+html5模板_h5农产品购物网站开源

- 9fragment 实现按键监听_fragment监听物理按键

- 10分布式时序数据库TimeLyre 9.2发布:原生多模态、高性能计算、极速时序回放分析

当前位置: article > 正文

liunx服务器部署Llama2大模型_在linux服务器上部署llama模型

作者:煮酒与君饮 | 2024-08-08 06:05:50

赞

踩

在linux服务器上部署llama模型

模型:Llama2-chat-13B-Chinese-50W

01 下载安装 Llama2 模型

Huggingface在国内是访问不了的,需要使用代理。在这里推荐使用 clash-for-liunx 配置代理。

-

安装 git-lfs,用于大文件下载

sudo apt-get install git-lfs git lfs install- 1

- 2

-

Huggingface 下载 Llama2 模型

git clone https://huggingface.co/RicardoLee/Llama2-chat-13B-Chinese-50W- 1

这里会下载很久,耐心等待吧。另外,可能会有文件下载失败,需要自己手动下载:

wget --no-check-certificate https://huggingface.co/RicardoLee/Llama2-chat-13B-Chinese-50W/resolve/main/pytorch_model-00001-of-00003.bin wget --no-check-certificate https://huggingface.co/RicardoLee/Llama2-chat-13B-Chinese-50W/resolve/main/pytorch_model-00002-of-00003.bin wget --no-check-certificate https://huggingface.co/RicardoLee/Llama2-chat-13B-Chinese-50W/resolve/main/pytorch_model-00003-of-00003.bin- 1

- 2

- 3

环境配置

安装依赖库:

python -m pip install torch==2.0.0

python -m pip install transformers==4.30.0

python -m pip install sentencepiece==0.1.97

python -m pip install peft==0.10.0

python -m pip install gradio==3.50.0

python -m pip install bitsandbytes

python -m pip install accelerate

python -m pip install scipy

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

同时将把 gradio 里的gradio_demo.py下载到服务器

wget https://github.com/ymcui/Chinese-LLaMA-Alpaca/blob/main/scripts/inference/gradio_demo.py

mv gradio_demo.py ~/Workspace/Llama2/

- 1

- 2

部署

- 查看GPU状态

nvidia-smi

- 1

- 命令行启动

python gradio_demo.py --base_model Llama2-chat-13B-Chinese-50W --tokenizer_path Llama2-chat-13B-Chinese-50W --load_in_8bit --gpus 0

- 1

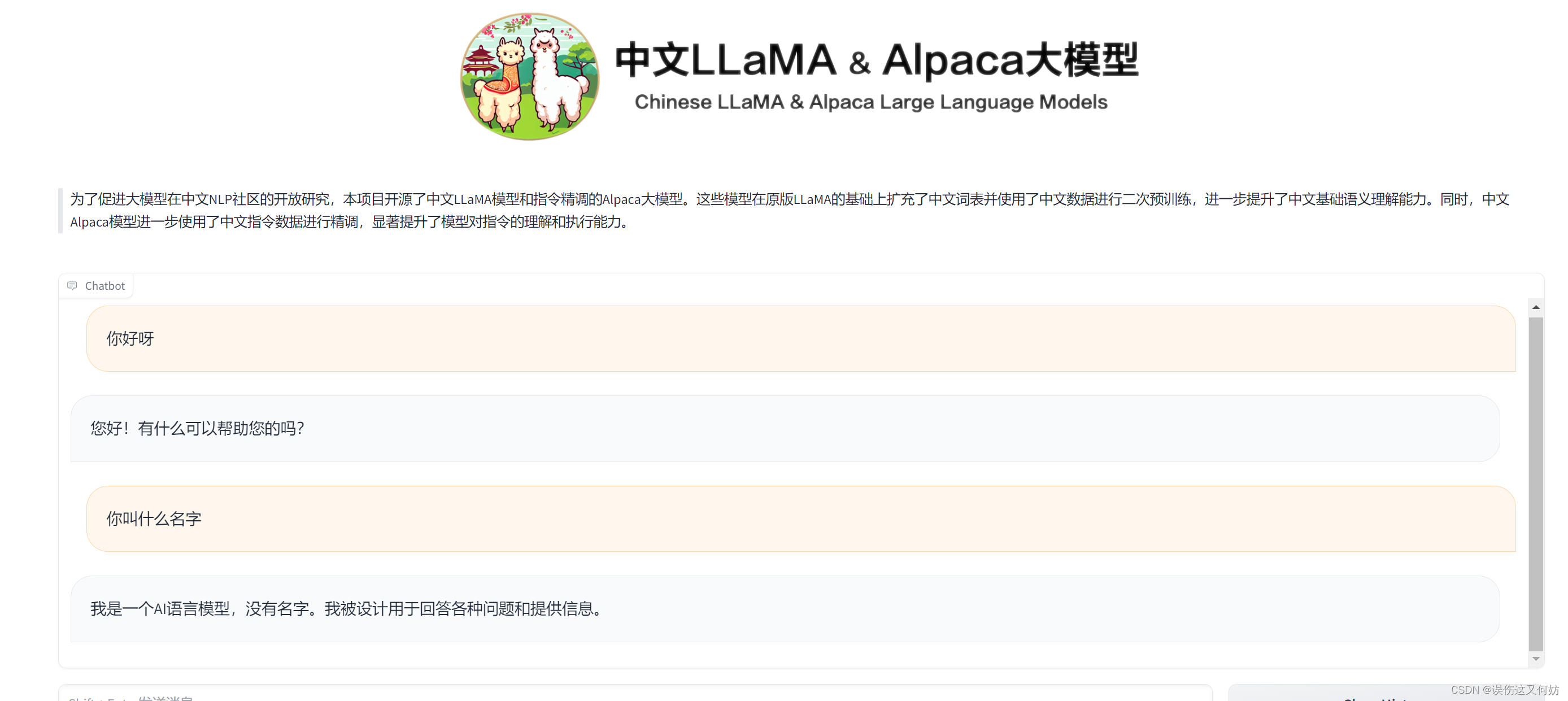

效果展示

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/煮酒与君饮/article/detail/946464

推荐阅读

相关标签