热门标签

热门文章

- 1利用jackson的JsonNode封装工具类快速获取json字符串中任意节点的json数据_jsonnode取值

- 2java全链路追踪,全链路追踪traceId,ThreadLocal与ExecutorService

- 32024年最全【项目精选】基于java出租车计价器设计与实现(源码+论文+视频,2024年最新腾讯、网易必问的20道题大数据开发面试题_网约车java计费引擎

- 4Can‘t use openai in command prompt

- 5mysql数据的导入导出(python)_python 导出 mysql 模型

- 6自动驾驶视觉相机方案推荐_自动驾驶相机选型

- 7Java每日一练_模拟面试题6(JVM的GC过程)

- 8cv::GaussianBlur()

- 9如何使用Postman_postman怎么使用

- 10整理了 47 个 Python 人工智能库(1)_python ai框架

当前位置: article > 正文

Llama3-CN本地端部署_llama3官网

作者:我家自动化 | 2024-08-03 14:36:33

赞

踩

llama3官网

1.下载ollama,网址为https://ollama.com,选择你需要的版本。Ollama是一个开源软件,允许用户在自己的硬件上运行、创建和分享大型语言模型服务。它适用于希望在本地运行模型的用户,因为它不仅可以保护数据隐私,还可以提供更快的响应速度。

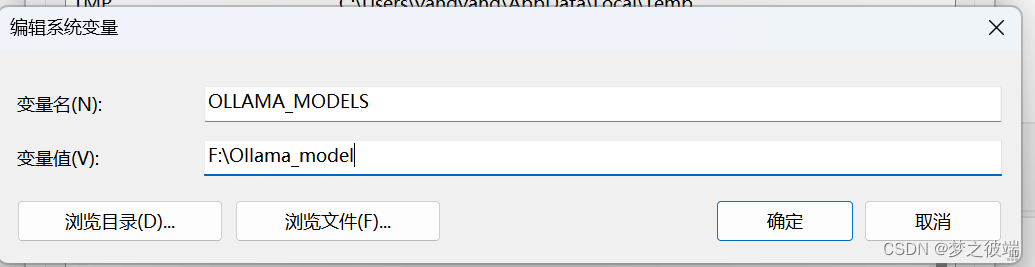

2.修改ollama默认下载位置,默认下载位置一般在“C:\Users\xxx\.ollama”里面,比较耗费C盘空间。此时可以在其他盘中建立文件夹进行替换。然后修改环境变量,重启电脑即可,假如你之前就已经下载过,那么就将之前.ollama/model中的文件全部迁移至新文件夹中。

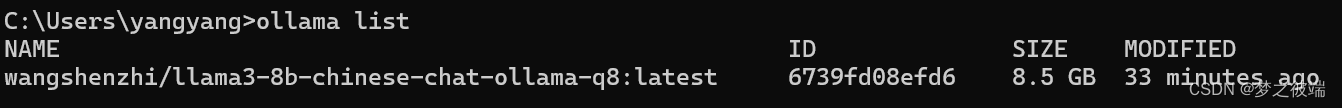

3.重新启动后,打开命令框输入ollama list,查看以往下载的models是否还存在。

4.在Ollma官网下载模型,huggingface也行(但是还是推荐去Ollama下载,不然可能会出现问题),直接在Ollama官网寻找模型即可。

5.运行模型,打开命令行输入ollama run模型名字,点击回车即可运行Llama3。后续还可以安装WebUI。

6.重启后在终端执行ollama list查看以前下载的models 是否还存在。如果不存在就打开进程管理器关闭Ollama进程,然后再重新打开:

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/我家自动化/article/detail/923389

推荐阅读

相关标签