- 1代码管理--svnadmin工具介绍_svnadmin2

- 2Blazor第三方组件库推荐:BootstrapBlazor UI_bootstrap blazor

- 3“互联网寒冬”来袭,软件测试人员该如何度过这次危机?_测试人员如何破冰

- 4Hadoop+Spark 大数据分析(一)之 虚拟机安装及Java环境的配置_vmware虚拟机上基于spark的大数据分析

- 5LSTM微博评论情绪识别二分类项目jieba分词遇到的问题

- 6SpringCloud--Eureka集群

- 7Python驱动的智能客服系统构建实录

- 8YOLO标注工具(适用于YOLO-OBB,可画旋转框)——JieLabel(自带训练和识别工具)

- 9C/C++---字符分布分割得到数字,适用于STM32/ESP32等等_stm32 字符串分割转数组

- 10配置 Druid 数据源及密码加密-SpringBoot 2.7 实战基础_druid默认账号密码

基于PySpark的10亿级数据集LAION-5B元数据快速处理实践(全文分享)_laion-5b license_laion 5b

赞

踩

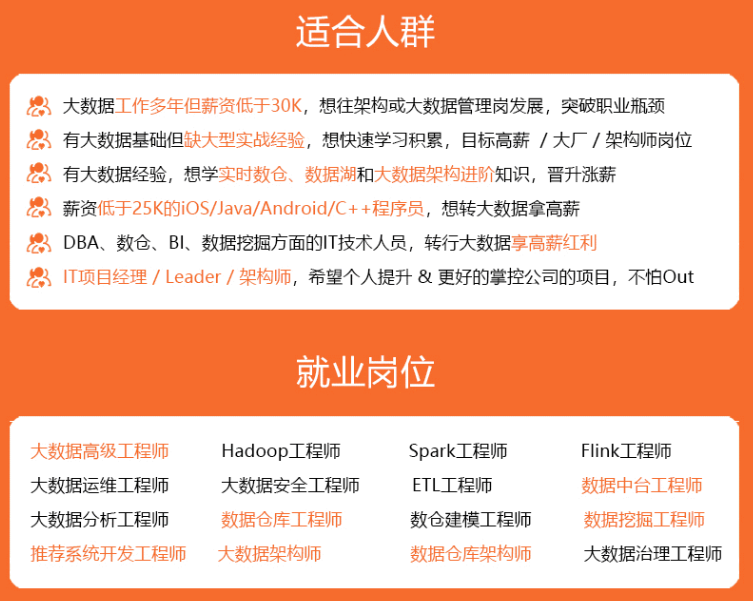

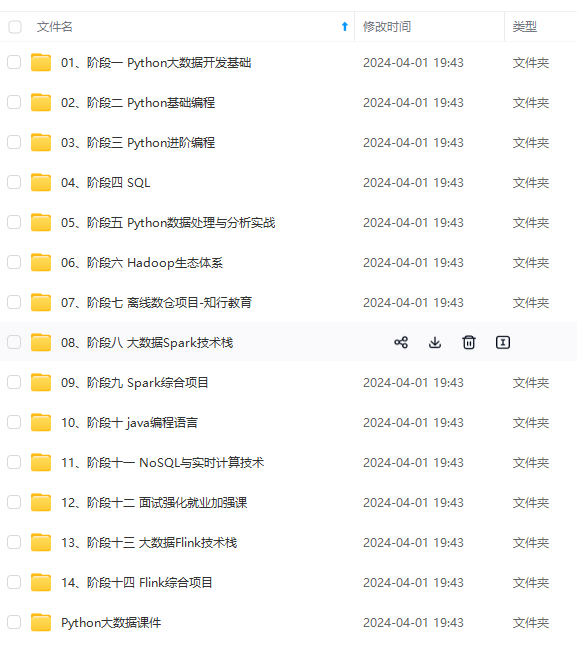

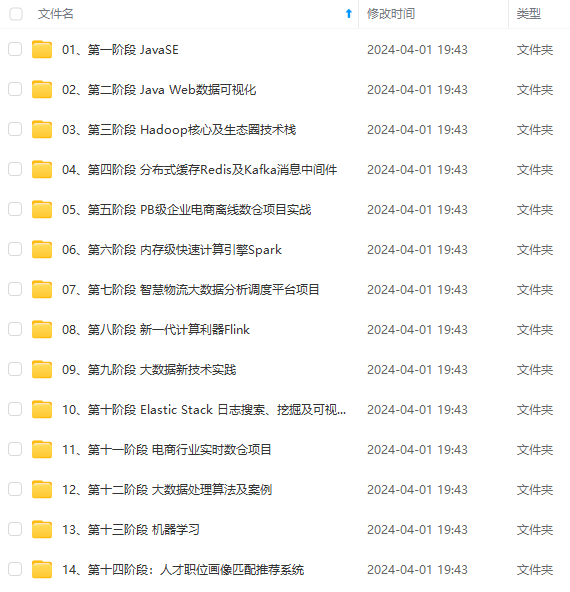

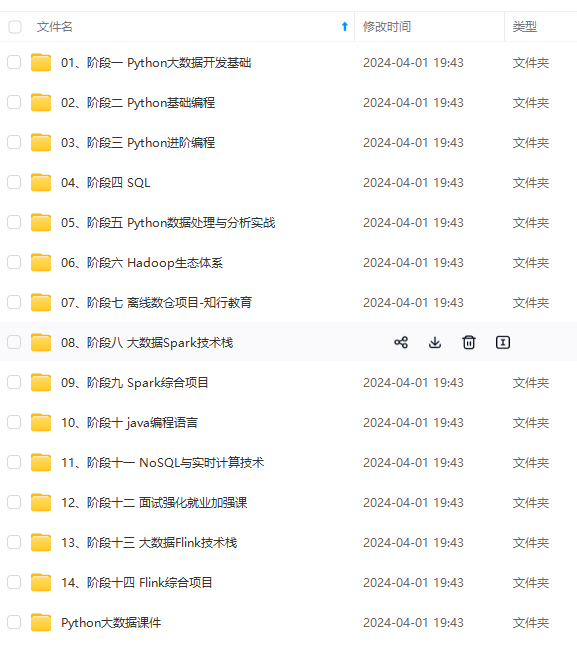

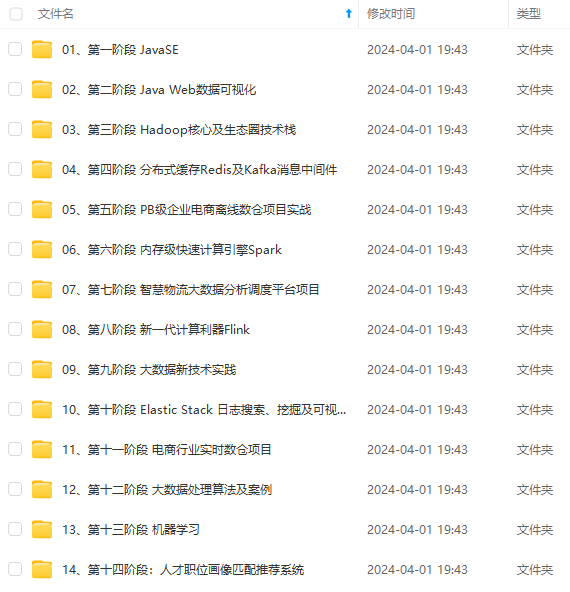

既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上大数据知识点,真正体系化!

由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新

根据官方文件统计,LAION-5B数据有5,860,068,373个样本,按照语言被官方划分为3个子数据集,分别是:

- laion2b-en :2.32 billion of these contain texts in the English language

- laion2b-multi :2.26 billion contain texts from 100+ other languages

- laion1b-nolang :1.27 billion have texts where a particular language couldn’t be clearly detected.

其中每个数据集官方提供了原始图片的URL,可以根据URL下载图片文件,以及些URL上的标签。 这部分元数据被存储在parquet文件中。样例parquet文件结构如下:

data_sample

├── laion2B-en

│ ├── part-00006-5114fd87-297e-42b0-9d11-50f1df323dfa-c000.snappy.parquet

│ ├── part-00014-5114fd87-297e-42b0-9d11-50f1df323dfa-c000.snappy.parquet

│ ├── part-00039-5114fd87-297e-42b0-9d11-50f1df323dfa-c000.snappy.parquet

│ ├── part-00043-5114fd87-297e-42b0-9d11-50f1df323dfa-c000.snappy.parquet

│ ├── part-00078-5114fd87-297e-42b0-9d11-50f1df323dfa-c000.snappy.parquet

│ ├── part-00093-5114fd87-297e-42b0-9d11-50f1df323dfa-c000.snappy.parquet

│ └── part-00123-5114fd87-297e-42b0-9d11-50f1df323dfa-c000.snappy.parquet

└── laion2B-multi

├── part-00001-fc82da14-99c9-4ff6-ab6a-ac853ac82819-c000.snappy.parquet

├── part-00026-fc82da14-99c9-4ff6-ab6a-ac853ac82819-c000.snappy.parquet

├── part-00030-fc82da14-99c9-4ff6-ab6a-ac853ac82819-c000.snappy.parquet

├── part-00034-fc82da14-99c9-4ff6-ab6a-ac853ac82819-c000.snappy.parquet

└── part-00125-fc82da14-99c9-4ff6-ab6a-ac853ac82819-c000.snappy.parquet

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

三、 Parquet元数据处理

在官方下载parquet元数据时,发现以下几个小问题:

- similarity、aesthetic_score等指标分布在多个parquet文件中,字段分散、类型不统一,需要多次下载。使用时需要先关联组合查询,TB级的文件处理速度慢,需要高配置的服务器进行处理;

- parquet文件中图片存储路径规则不明确,通过parquet过滤筛选图片时,无法关联下载图片的存储路径和其它字段

- parquet文件中parquet_id、hash等字段重复,影响图片的唯一索引

- 通过url下载的图片格式未知(有webp、jpg、png、avif等多种格式),影响下载图片的预览和存储

为了满足不同场景的数据使用需求,保证图片唯一索引ID,我们对官方的parquet文件进行了关联合并、字段补充等操作,形成一张字段丰富的“宽表”,数据表结构与字段设计如下:

上表中,最后一列是parquet文件来源,表示字段对应的parquet文件。 这里使用了官方的3处parquet文件,数据预览、下载链接如下:

1. 初始Laion5B

- https://huggingface.co/datasets/laion/laion2B-en

- https://huggingface.co/datasets/laion/laion2B-multi

- https://huggingface.co/datasets/laion/laion1B-nolang

2. Joined: with punsafe and pwatermark

- https://huggingface.co/datasets/laion/laion2B-en-joined

- https://huggingface.co/datasets/laion/laion2B-multi-joined

- https://huggingface.co/datasets/laion/laion1B-nolang-joined

3. Laion-aesthetic

Laion aesthetic is a laion5B subset with aesthetic > 7 pwatermark < 0.8 punsafe < 0.5 See

- https://huggingface.co/datasets/laion/laion1B-nolang-aesthetic

- https://huggingface.co/datasets/laion/laion2B-en-aesthetic

- https://huggingface.co/datasets/laion/laion2B-multi-aesthetic

四、 处理流程及步骤

下面聊聊“宽表”的加工处理过程,有需求的同事可参考对官方的原始parquet进行处理。嫌麻烦的同学,可以交给opendatalab,在网站下载处理好的parquet文件。(https://opendatalab.com/LAION-5B)

因为parquet文件数据量较大,有几个TB,这里我们使用了大数据集群进行了分布式处理。

● 使用的技术栈有:

Spark/Hadooop/Hive/HDFS/Impala

● 集群硬件配置:

服务器3台,48core Cpu, 750GB Memory, 4TB Hard disk

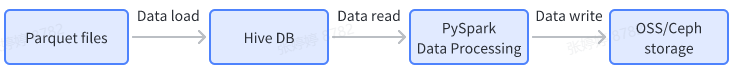

● 数据处理过程和流程图如下:

数据输入:

-

下载官网parquet文件,并load到Hive表

-

解析下载的图片,判断图片类型,形成id, image_path, image_suffix的映射文件

数据处理:

- 读取Hive表数据,通过PySpark对Hive表的数据进行分布式join关联操作

数据输出:

- Hive结果表导出为parquet格式文件,并上传至OSS/Ceph存储

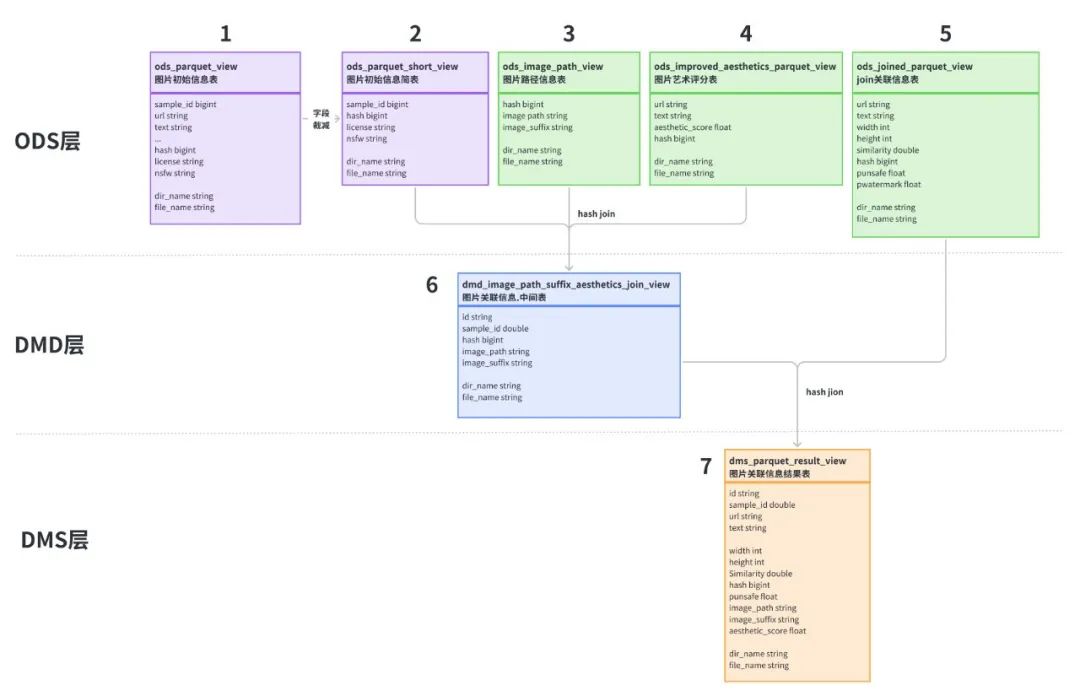

为了方便数据处理,这里对数据表进行简单的分层:

**- ODS层:**原始parquet文件load Hive后的结构化数据表,其中表2是对表1字段进行了裁减,表3是下载图片相关的信息。因为官方parquet文件只提供了下载url链接,我们并不知道图片类型和后缀,所以对下载的图片文件进行程序判定,识别出图片类型,对应image_suffix字段,image_path是图片的存储路径。

**- DMD层:**通过对表2、3、4进行join关联操作,生成中间表6

**- DMS层:**将中间表6与含有punsafe、pwatermark信息的表5进行关联,得到最后的结果表7

数据处理操作和代码示例如下:

4-1. Data load

主要操作是将parquet文件load到Hive表,load操作完成后,得到图中的1、3、4、5四张Hive表。

以初始parquet文件load为例,示例代码如下。

import os from pyspark.sql import HiveContext, SQLContext from pyspark.sql.functions import lit, input_file_name from pyspark.sql.functions import col, udf from pyspark.sql.types import StringType, LongType import mmh3 sc = spark.sparkContext sql_context = SQLContext(sc) # 通过url/text计算hash值 def compute_hash(url, text): if url is None: url = '' if text is None: text = '' total = (url + text).encode("utf-8") return mmh3.hash64(total)[0] # 注册spark udf udf_compute_hash = udf(compute_hash, LongType()) # 提取input_file_name路径中的文件名称 def path_proc(file_path): return str(file_path).split("/")[-1] udf_path_proc = udf(path_proc) # 因数据总量较大,这里按子集分批读取 parquet_path = "/nvme/datasets/laion5b/parquet/laion2B-en" # parquet_path = "/nvme/datasets/laion5b/parquet/laion2B-multi" # parquet_path = "/nvme/datasets/laion5b/parquet/laion2B-nolang" # Hive一级分区名称 head_tail = os.path.split(parquet_path) partition_name = head_tail[1] parquet_df = spark.read.parquet(f"file://{parquet_path}/*.parquet") parquet_df = parquet_df.withColumn("file_name", input_file_name()) parquet_df = parquet_df.withColumn("hash", udf_compute_hash(parquet_df["URL"], parquet_df["TEXT"])) parquet_df = parquet_df.withColumn("dir_name", lit(f"{partition_name}")) parquet_df = parquet_df.withColumn("file_name", udf_path_proc(parquet_df["file_name"])) # 自定义视图名称,并注册视图 view_name = 'parquet_view' parquet_df.createOrReplaceTempView(f"{view_name}") # 数据写入Hive分区表,一级分区名称dir_name,二级分区名称file_name sql_context.sql(f"insert overwrite table laion5b.parquet_view partition(dir_name='{partition_name}', file_name) select SAMPLE_ID,URL,TEXT,HEIGHT,WIDTH, LICENSE,NSFW,similarity,`hash`, file_name from {view_name}")

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

4-2. Data processing

数据处理过程主要包括数据表裁减、hash join操作。

因为表1的数据量较大,存在字段冗余,这里对表1的部分字段进行裁减得到表2。 表2、3、4的join代码如下,先将图片的sample_id、licenese、nsfw、image_suffix、aesthetic_score字段,按hash值进行关联,合并成一张表。 因为需要使用file_name作为Hive表二级动态分区,也避免大量数据join导致OOM,这里按dir_name分别进行join操作,不同的分区修改对应的dir_name即可。

join_sql = """ insert overwrite table laion5b.dmd_image_path_suffix_aesthetics_join_view PARTITION (dir_name = 'laion2B-en', file_name) select A.sample_id, A.`hash`, B.image_path, B.image_suffix, A.license, A.nsfw, C.aesthetic_score, A.file_name    **既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上大数据知识点,真正体系化!** **由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新** **[需要这份系统化资料的朋友,可以戳这里获取](https://bbs.csdn.net/topics/618545628)** )] [外链图片转存中...(img-1wMh9J6Y-1715737156215)] **既有适合小白学习的零基础资料,也有适合3年以上经验的小伙伴深入学习提升的进阶课程,涵盖了95%以上大数据知识点,真正体系化!** **由于文件比较多,这里只是将部分目录截图出来,全套包含大厂面经、学习笔记、源码讲义、实战项目、大纲路线、讲解视频,并且后续会持续更新** **[需要这份系统化资料的朋友,可以戳这里获取](https://bbs.csdn.net/topics/618545628)**

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31