热门标签

热门文章

- 1【Verilog 教程】7.4Verilog CIC 滤波器设计_cic滤波器verilog设计

- 22023华为od机试C卷【路口最短时间问题】Python 实现_定街道是棋盘型的,每格距离相等,车辆通过每格街道需要时间均为 timeperroad;街道

- 3gitee 简易使用 上传文件_gitee手动上传文件

- 4演唱会为什么总是抢不到票?用Python做一个自动抢票脚本!想看谁的就看谁的!_脚本抢票_演唱会脚本抢票

- 5windows11通过scp向Linux发送中文命名文件(三步解决乱码问题)_windows11 使用scp

- 6H5 混合开发(更新中)_h5 和ios 安卓混合开发

- 7使用Zxing生成和解析QRCODE

- 8HarmonyOS(36) DevEco Studio 配置debug和release

- 9大数据之Spark(五):DAGScheduler 的任务划分_spark dag任务分配原则

- 10stc89c52单片机介绍_DIY迷你单片机学习板

当前位置: article > 正文

IDEA 创建scala spark的Mvn项目_idea 创建一个 scala +spark的maven项目

作者:我家自动化 | 2024-06-22 13:23:10

赞

踩

idea 创建一个 scala +spark的maven项目

IDEA 创建scala spark的Mvn项目

对人工智能感兴趣的同学,可以点击以下链接:

现在人工智能非常火爆,很多朋友都想学,但是一般的教程都是为博硕生准备的,太难看懂了。最近发现了一个非常适合小白入门的教程,不仅通俗易懂而且还很风趣幽默。所以忍不住分享一下给大家。点这里可以跳转到教程。

https://www.cbedai.net/u014646662

1.创建一个简单的Mvn项目

1.1新建项目File -> new -> project -> Maven

1.2 点击下一步,填写gid和aid

1.3 点击下一步,点击完成

mvn项目就建好了

1.4 不要忘记你的Mvn配置(File -> Setting 搜索Maven)

2 添加依赖(配置要和你的环境一致)

-

- <properties>

- <scala.version>2.10.5</scala.version>

- <hadoop.version>2.6.5</hadoop.version>

- </properties>

-

- <repositories>

- <repository>

- <id>scala-tools.org</id>

- <name>Scala-Tools Maven2 Repository</name>

- <url>http://scala-tools.org/repo-releases</url>

- </repository>

- </repositories>

-

- <dependencies>

- <dependency>

- <groupId>org.apache.spark</groupId>

- <artifactId>spark-core_2.10</artifactId>

- <version>1.6.0</version>

- </dependency>

- <dependency>

- <groupId>org.apache.spark</groupId>

- <artifactId>spark-sql_2.10</artifactId>

- <version>1.6.0</version>

- </dependency>

- <dependency>

- <groupId>org.apache.spark</groupId>

- <artifactId>spark-streaming_2.10</artifactId>

- <version>1.6.0</version>

- </dependency>

- <dependency>

- <groupId>org.apache.hadoop</groupId>

- <artifactId>hadoop-client</artifactId>

- <version>${hadoop.version}</version>

- </dependency>

- <dependency>

- <groupId>org.apache.hadoop</groupId>

- <artifactId>hadoop-common</artifactId>

- <version>${hadoop.version}</version>

- </dependency>

- <dependency>

- <groupId>org.apache.hadoop</groupId>

- <artifactId>hadoop-hdfs</artifactId>

- <version>${hadoop.version}</version>

- </dependency>

3.添加Scala libraries

File -> Project Structure

选择对应的版本(第一次选择应该下载,不过下载很慢,建议去官网下载Scala,然后选择目录)

点击 OK

项目下就引入scala

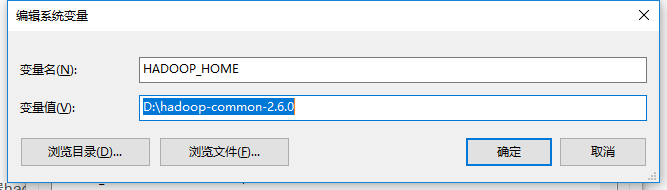

4. 配置hadoop,配置hadoop-common-2.6.0-bin,以免出现null/winutils

hadoop-common-2.6.0-bin下载:https://download.csdn.net/download/u014646662/10816318

配置环境变量:

5.可以写scala程序了

6 编写Scala类

- package cn.com.tengen.test

-

- import java.util.Scanner

-

- import org.apache.spark.SparkContext

- import org.apache.spark.SparkConf

-

-

- class ScalaSparkContext(appName:String="Spark"){

- val sc:SparkContext = getSparkContext()

- def getSparkContext() = {

- val conf = new SparkConf().setAppName(appName)

- conf.setMaster("local")

- val sc = new SparkContext(conf)

- sc

- }

-

- def stop() = {

- println("按回车键结束:")

- val in = new Scanner(System.in)

- in.nextLine()

- sc.stop()

- }

- }

-

-

- object ScalaSparkContext {

- def main(args: Array[String]) {

- val sparkContext = new ScalaSparkContext()

- val sc = sparkContext.sc

- val input = sc.textFile("F:\\stoke_data\\2018-10-08-09-32-44.txt").map(_.toLowerCase)

- input

- .flatMap(line => line.split("[,]"))

- .map(word => (word, 1))

- .reduceByKey((count1, count2) => count1 + count2)

- .saveAsTextFile("aaaa")

- sparkContext.stop()

- }

- }

-

运行后,在控制台中可以看到:

- 18/11/29 14:46:01 INFO Utils: Successfully started service 'SparkUI' on port 4040.

- 18/11/29 14:46:01 INFO SparkUI: Started SparkUI at http://172.16.66.1:4040

就进入web页面

注意:在sc.stop前可以访问

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/我家自动化/article/detail/746648

推荐阅读

相关标签