热门标签

热门文章

- 1Java中的Base64详解_java base64

- 2linux没有 dev ttyusb0,could not open port /dev/ttyUSB0解决办法

- 3AI破局第2季与你一起破局创富

- 4京区航天研究所 哪些比较好的研究所?_航天九院最好的研究所

- 5Pytorch中张量的高级选择操作

- 6list包含某个字符串_Python新人指南[4]——字符串和列表

- 7python爬取b站弹幕并进行数据分析_【Python3爬虫】我爬取了七万条弹幕,看看RNG和SKT打得怎么样...

- 8yarn下载依赖慢的解决方法_yarn 下载很慢

- 9pinger可同时获取多个虚拟手机号码,全部免费!_pingme虚拟号

- 10systemctl restart httpd特别慢的解决办法_执行 systemctl特别慢

当前位置: article > 正文

GAN及其衍生网络中生成器和判别器常见的十大激活函数(2024最新整理)

作者:我家自动化 | 2024-03-18 07:08:29

赞

踩

GAN及其衍生网络中生成器和判别器常见的十大激活函数(2024最新整理)

目录

激活函数(activation function)的作用是对网络提取到的特征信息进行非线性映射,提供网络非线性建模的能力。常见的激活函数有 Sigmoid、Tanh、ReLU、LeakyReLU 和 ELU 等。

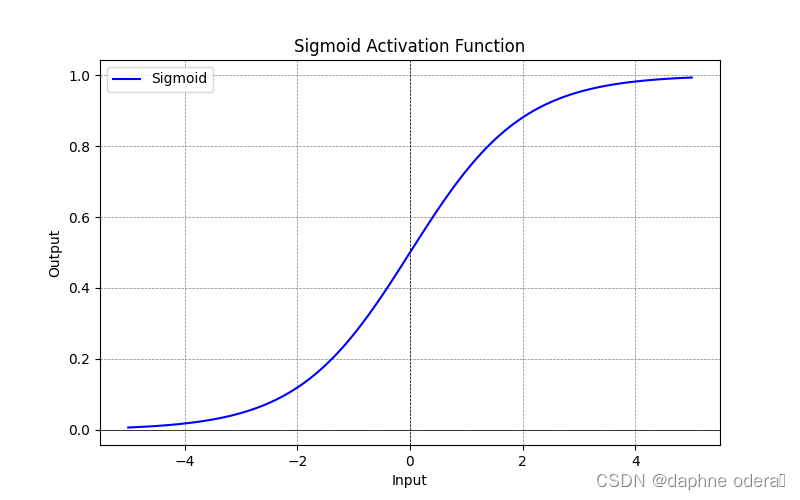

1. Sigmoid 激活函数

Sigmoid 是一种常见的非线性激活函数,输入实数值并将其压缩到 (0,1) 范围内,适用于二元分类任务。其缺点是当输入值较大和较小时,梯度会接近于0从而导致梯度消失问题,函数的输出也不是以0为中心,指数计算复杂度高也更加耗时。其计算公式如下所示:

Sigmoid 激活函数 Pytorch 示例:

- import torch

-

- # 定义输入张量

- x = torch.tensor([0.5, -0.1, 2.0])

-

- # 使用Sigmoid激活函数

- output = torch.sigmoid(x)

-

- print(output)

Sigmoid 激活函数示意图:

2. Tanh 激活函数

双曲正切激活函数(hyperbolic tangent activation function, Tanh)也属于非线性激活函数,它可以将输入实数值映射到 [-1,1] 范围之间,适用于多元分类任务。输出是以零为中心,但是和sigmoid激活函数一样存在饱和问题,并仍未解决梯度消失问题。其计算公式如下所示:

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/我家自动化/article/detail/261245

推荐阅读

相关标签