热门标签

热门文章

- 1基于STM32的最小系统电路设计(STM32F103C8T6为例)_stm32微控制器和最小系统电路

- 2推荐3个开源好用的堡垒机_免费堡垒机

- 3安装samba服务器_samba安装

- 4AIGC:重塑创意产业的新纪元

- 5高德地图2.0内网部署 离线瓦片 性能优化_高德地图瓦片服务

- 6计算机工程与科学期刊小木虫,《[小木虫emuch.net]北大中文核心期刊目录(2016版)--2016年4月12日更新》.pdf...

- 7springboot小区物业服务平台 计算机专业毕业设计源码35514_老旧小区改造智能管理系统的编码实现过程

- 8【C++】STL之空间配置器

- 9如何做好springboot监控集成

- 10numpy的下载与安装教程——(解决No module named numpy问题)

当前位置: article > 正文

【图攻防】《Backdoor Attacks to Graph Neural Networks 》(SACMAT‘21)

作者:我家小花儿 | 2024-07-09 15:38:17

赞

踩

backdoor attacks to graph neural networks

Backdoor Attacks to Graph Neural Networks (SACMAT’21)

Neil Zhenqiang Gong团队工作。

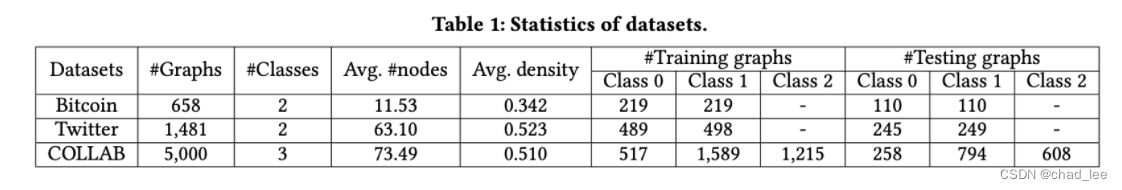

本文主要攻击用于图分类任务的GNN模型,任务场景是交易欺诈、社交网络检测虚假用户、恶意软件检测等,这些任务都是对一个图进行分类。本文的backdoor attack就是在图中注入一个子图结构当作trigger,然后测试集如果出现了相同的子图结构,就会预测到目标label。注入子图的方法也比较简单,就是随机方法。接着文章提出了防御方法,利用Randomized Subsampling实现可验证防御。

攻击者的目标就是backdoored GNN模型应该在clean testing graph上准确度尽可能高,但是在注入了trigger的testing graph上ASR应该尽可能高。

生成trigger方法

首先添加trigger是只修改图结构,比如选择4个节点作为trigger 子图,那么不管这四个节点之前是什么结构,现在就改成这个结构。控制trigger子图的四个参数

Trigger size:trigger子图的节点个数 t t t。

Trigger density:trigger图的稠密度 ρ

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/我家小花儿/article/detail/802861

推荐阅读

相关标签