- 1嵌入式编程中的uint8_t / uint16_t / uint32_t /uint64_t_uint16_t赋值给uint8_t

- 2ArkTS基本概念&装饰器_arkts晵,啙唕说法啘啒唣喚( )。

- 3yolov5 实例分割 jason标注格式转换 && 训练自己的数据集_coco128-seg

- 4vue.js——ElementUI表单向后台提交FormData数据_elementui 提交form

- 5Fiddler+夜神模拟器对安卓app进行抓包,安卓9,安装Magisk和LSPosed_magisk 抓包

- 6算法训练day14||二叉树的递归遍历|二叉树的迭代遍历|二叉树的统一迭代法

- 7计算机体系结构:VLIW

- 8MySQL 篇-深入了解索引的内部结构(哈希表、红黑树与 B+ 树)

- 9假设检验(Hypothesis Testing)的内涵及步骤_假设检验的意义和步骤

- 10注册个人小程序

马斯克开源Grok-1:3140亿参数迄今最大,权重架构全开放,磁力下载_grok-1下载

赞

踩

今天凌晨,马斯克旗下的大型模型公司 xAI 宣布正式开源了一款名为「Grok-1」的混合专家(MoE)模型,该模型包含着 3140 亿个参数,成为当前参数量最大的开源大语言模型之一。

封面图是使用 Midjourney 生成的神经网络的 3D 插图,展示了透明节点和发光连接,以及不同粗细和颜色的连接线展示了不同的权重。

在这一时刻,马斯克当然不会错过嘲讽 OpenAI 的机会,他表示「我们对了解更多关于 OpenAI 的开放部分感兴趣」。

关于模型本身,Grok-1 是从头开始训练的,没有针对特定应用(如对话)进行微调。与此相反,在 X 平台上可用的 Grok 大模型是微调过的版本,其行为和原始权重版本并不相同。

Grok-1 的模型细节包括:

- 基础模型基于大量文本数据进行训练,没有针对任何具体任务进行微调。

3140 亿参数的 MoE 模型,激活权重为 25%。 - xAI 使用 JAX 库和 Rust 语言组成的自定义训练堆栈从头开始训练。

- xAI 遵守 Apache 2.0 许可证来开源 Grok-1 的权重和架构。Apache 2.0 许可证允许用户自由地使用、修改和分发软件,无论是个人还是商业用途。

项目发布截止目前为止已经获得了 8.5 k 星标,并且热度还在持续增加中。

该存储库包含了用于加载和运行 Grok-1 开放权重模型的 JAX 示例代码。用户需要先下载 checkpoint,并将 ckpt-0 目录放置在 checkpoint 中,然后运行示例代码进行测试:

pip install -r requirements.txt

python run.py

- 1

- 2

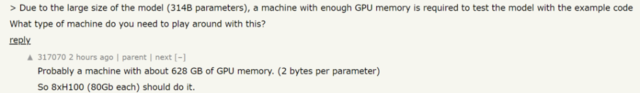

项目说明中明确强调,由于 Grok-1 是一个参数规模庞大的模型(314B 参数),因此需要有足够 GPU 内存的机器才能使用示例代码测试模型。此外,该存储库中 MoE 层的实现效率并不高,选择这种实现方式是为了避免需要自定义内核来验证模型的正确性。

用户可以使用 Torrent 客户端和提供的磁力链接来下载权重文件。

magnet:?xt=urn:btih:5f96d43576e3d386c9ba65b883210a393b68210e&tr=https%3A%2F%2Facademictorrents.com%2Fannounce.php&tr=udp%3A%2F%2Ftracker.coppersurfer.tk%3A6969&tr=udp%3A%2F%2Ftracker.opentrackr.org%3A1337%2Fannounce

- 1

一些技术人员对 314B 参数的 Grok-1 需要的配置表示好奇,根据他们的估算,可能需要一台拥有 628 GB GPU 内存的机器(每个参数 2 字节)。这意味着8块 H100(每块 80GB)的 GPU 就足够了。

在技术社区中,Grok-1 的开源引发了不少讨论。开源社区指出,该模型在前馈层中使用了 GeGLU,并采用了有趣的 sandwich norm 技术进行归一化。甚至连 OpenAI 的员工也表达了对该模型的兴趣。

总的来说,Grok-1 的开源程度超过了一些具有使用限制的开放权重模型,但相比于 Pythia、Bloom 和 OLMo 等模型,其开源程度仍有所不足。这些模型附带了训练代码和可复现的数据集。

DeepMind 的研究工程师 Aleksa Gordié 预测,Grok-1 的能力应该比 LLaMA-2 要强,但目前尚不清楚有多少数据受到了污染。同时,Grok-1 和 LLaMA-2 的参数量也不是一个量级。

一位推特用户 @itsandrewgao 对 Grok-1 的架构细节进行了详细分析,并做出了一系列总结。

至于 Grok-1 的具体能力以及它是如何运作的,目前还有待进一步。

个人简介

Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。