- 1AI落地项目一:量化交易_量化交易项目

- 2深度学习和计算机视觉(CV)介绍_深度学习cv

- 3vm克隆出来的centos虚拟机,ip和主机名相同_修改主机名与虚拟机名保持一致

- 4【愚公系列】2024年03月 《AI智能化办公:ChatGPT使用方法与技巧从入门到精通》 013-用 ChatGPT 生成图片(AI绘画主流工具介绍)

- 5windows的cmd命令中如何使用延迟方法【ping -n 30 127.0.0.1 > null】_ping -n 3 127.0.0.1>nul

- 6[持续更新]计算机经典面试题基础篇Day1

- 7【Golang入门教程】Go语言变量的初始化

- 8ARPA x 京东数科:隐私计算如何赋能未来金融数据共享_京东数科 机密计算

- 9全网最全matlab项目源码github地址列表_源码大全github

- 10使用vim编写golang_vim中编译go语言文件的命令

Python之自然语言处理库snowNLP_python snownlp

赞

踩

一、介绍

SnowNLP是一个python写的类库,可以方便的处理中文文本内容,是受到了TextBlob的启发而写的,由于现在大部分的自然语言处理库基本都是针对英文的,于是写了一个方便处理中文的类库,并且和TextBlob不同的是,这里没有用NLTK,所有的算法都是自己实现的,并且自带了一些训练好的字典。注意本程序都是处理的unicode编码,所以使用时请自行decode成unicode。

GitHub - isnowfy/snownlp: Python library for processing Chinese text

二、snowNLP操作详解

2.1 安装

pip install snownlp 2.2 功能详解

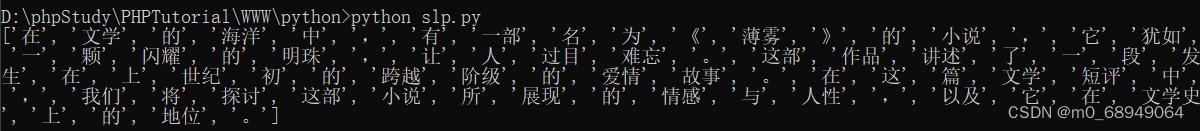

1)中文分词(Character-Based Generative Model)

- # -*- coding:utf-8 -*-

- import sys

- from snownlp import SnowNLP

-

- txt = u'''在文学的海洋中,有一部名为《薄雾》的小说,它犹如一颗闪耀的明珠,让人过目难忘。这部作品讲述了一段发生在上世纪初的跨越阶级的爱情故事。在这篇文学短评中,我们将探讨这部小说所展现的情感与人性,以及它在文学史上的地位。'''

-

- s = SnowNLP(txt)

- print(s.words)

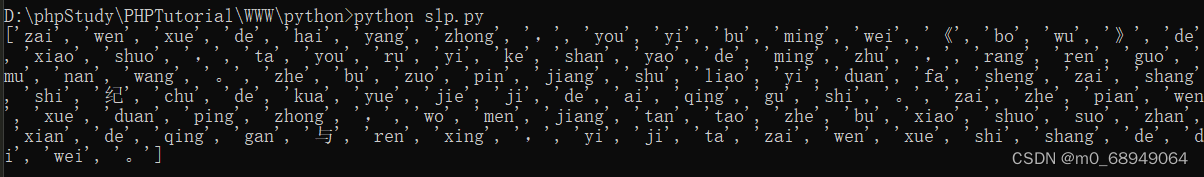

2)词性标注(TnT 3-gram 隐马)

- # -*- coding:utf-8 -*-

- import sys

- from snownlp import SnowNLP

-

- txt = u'''在文学的海洋中,有一部名为《薄雾》的小说,它犹如一颗闪耀的明珠,让人过目难忘。这部作品讲述了一段发生在上世纪初的跨越阶级的爱情故事。在这篇文学短评中,我们将探讨这部小说所展现的情感与人性,以及它在文学史上的地位。'''

-

- s = SnowNLP(txt)

- for i in s.tags:

- print(i)

3)情感分析(朴素贝叶斯算法)

现在训练数据主要是买卖东西时的评价,所以对其他的一些可能效果不是很好。

情感分析的结果是一个0~1之间的数字,数字越大表示这句话越偏向于肯定的态度,数字越小表示越偏向于否定的态度。

- # -*- coding:utf-8 -*-

- import sys

- from snownlp import SnowNLP

-

- txt = u'''在文学的海洋中,有一部名为《薄雾》的小说,它犹如一颗闪耀的明珠,让人过目难忘。这部作品讲述了一段发生在上世纪初的跨越阶级的爱情故事。在这篇文学短评中,我们将探讨这部小说所展现的情感与人性,以及它在文学史上的地位。'''

-

- s = SnowNLP(txt)

- print(s.sentiments)

4)文本分类(Naiv eBayes)

模型训练(若是想要利用新训练的模型进行情感分析,可修改 snownlp/seg/__init__.py 里的data_path指向刚训练好的文件)

- #coding:UTF-8

-

- from snownlp import sentiment

-

- if __name__ == "__main__":

- # 重新训练模型

- sentiment.train('./neg.txt', './pos.txt')

- # 保存好新训练的模型

- sentiment.save('sentiment.marshal')

5)转换成拼音(Trie树实现的最大匹配)

- # -*- coding:utf-8 -*-

- import sys

- from snownlp import SnowNLP

-

- txt = u'''在文学的海洋中,有一部名为《薄雾》的小说,它犹如一颗闪耀的明珠,让人过目难忘。这部作品讲述了一段发生在上世纪初的跨越阶级的爱情故事。在这篇文学短评中,我们将探讨这部小说所展现的情感与人性,以及它在文学史上的地位。'''

-

- s = SnowNLP(txt)

- print(s.pinyin)

6)繁体转简体(Trie树实现的最大匹配)

- # -*- coding:utf-8 -*-

- import sys

- from snownlp import SnowNLP

-

- txt = u'''在文學的海洋中,有一部名為《薄霧》的小說,它猶如一顆閃耀的明珠,讓人過目難忘。 這部作品講述了一段發生在上世紀初的跨越階級的愛情故事。 在這篇文學短評中,我們將探討這部小說所展現的情感與人性,以及它在文學史上的地位。'''

-

- s = SnowNLP(txt)

- print(s.han)

7)提取文本关键词(TextRank算法)

- # -*- coding:utf-8 -*-

- import sys

- from snownlp import SnowNLP

-

- txt = u'''在文学的海洋中,有一部名为《薄雾》的小说,它犹如一颗闪耀的明珠,让人过目难忘。这部作品讲述了一段发生在上世纪初的跨越阶级的爱情故事。在这篇文学短评中,我们将探讨这部小说所展现的情感与人性,以及它在文学史上的地位。'''

-

- s = SnowNLP(txt)

- print(s.keywords(5))

8)提取文本摘要(TextRank算法)

- # -*- coding:utf-8 -*-

- import sys

- from snownlp import SnowNLP

-

- txt = u'''在文学的海洋中,有一部名为《薄雾》的小说,它犹如一颗闪耀的明珠,让人过目难忘。这部作品讲述了一段发生在上世纪初的跨越阶级的爱情故事。在这篇文学短评中,我们将探讨这部小说所展现的情感与人性,以及它在文学史上的地位。'''

-

- s = SnowNLP(txt)

- print(s.summary(5))

10)Tokenization(分割成句子)

- # -*- coding:utf-8 -*-

- import sys

- from snownlp import SnowNLP

-

- txt = u'''在文学的海洋中,有一部名为《薄雾》的小说,它犹如一颗闪耀的明珠,让人过目难忘。这部作品讲述了一段发生在上世纪初的跨越阶级的爱情故事。在这篇文学短评中,我们将探讨这部小说所展现的情感与人性,以及它在文学史上的地位。'''

-

- s = SnowNLP(txt)

- print(s.sentences)

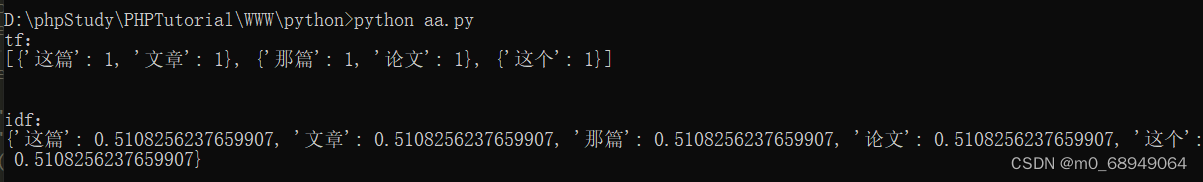

9)tf(词频),idf(逆文档频率:可以用于tf-idf关键词提取)

- # -*- coding:utf-8 -*-

- import sys

- from snownlp import SnowNLP

-

- s = SnowNLP([[u'这篇', u'文章'],

- [u'那篇', u'论文'],

- [u'这个']])

-

- print("tf:")

- print(s.tf)

- print("\n")

-

- print("idf:")

- print(s.idf)

11)文本相似(BM25)

1. 文本的相似度是通过上面的tf和idf来计算的,这里给出的也是词的相似度分析。

- # -*- coding:utf-8 -*-

- import sys

- from snownlp import SnowNLP

-

- s = SnowNLP([[u'这篇', u'文章'],

- [u'那篇', u'论文'],

- [u'这个']])

-

- print(s.sim([u'文章']))

2. 用 sklearn库的句子相似度的计算方法,计算 TF 矩阵中两个向量的相似度,实际上就是求解两个向量夹角的余弦值:点乘积除以二者的模长,公式如下

cosθ=a·b/|a|*|b|

- from sklearn.feature_extraction.text import CountVectorizer

- import numpy as np

- from scipy.linalg import norm

-

- def tf_similarity(s1, s2):

-

- def add_space(s):

- return ' '.join(s)

-

- # 将字中间加入空格

- s1, s2 = add_space(s1), add_space(s2)

- # 转化为TF矩阵

- cv = CountVectorizer(tokenizer=lambda s: s.split())

- corpus = [s1, s2]

- vectors = cv.fit_transform(corpus).toarray()

- # 计算TF系数

- return np.dot(vectors[0], vectors[1]) / (norm(vectors[0]) * norm(vectors[1]))

-

- s1 = '我出生在中国'

- s2 = '我生于中国'

- print(tf_similarity(s1, s2)) # 结果:0.7302967433402214

2.3 情感分析源码解析

- class Sentiment(object):

-

- def __init__(self):

- self.classifier = Bayes() # 使用的是Bayes的模型

-

- def save(self, fname, iszip=True):

- self.classifier.save(fname, iszip) # 保存最终的模型

-

- def load(self, fname=data_path, iszip=True):

- self.classifier.load(fname, iszip) # 加载贝叶斯模型

-

- # 分词以及去停用词的操作

- def handle(self, doc):

- words = seg.seg(doc) # 分词

- words = normal.filter_stop(words) # 去停用词

- return words # 返回分词后的结果

-

- def train(self, neg_docs, pos_docs):

- data = []

- # 读入负样本

- for sent in neg_docs:

- data.append([self.handle(sent), 'neg'])

- # 读入正样本

- for sent in pos_docs:

- data.append([self.handle(sent), 'pos'])

- # 调用的是Bayes模型的训练方法

- self.classifier.train(data)

-

- def classify(self, sent):

- # 1、调用sentiment类中的handle方法

- # 2、调用Bayes类中的classify方法

- ret, prob = self.classifier.classify(self.handle(sent)) # 调用贝叶斯中的classify方法

- if ret == 'pos':

- return prob

- return 1-probclass Sentiment(object):

-

- def __init__(self):

- self.classifier = Bayes() # 使用的是Bayes的模型

-

- def save(self, fname, iszip=True):

- self.classifier.save(fname, iszip) # 保存最终的模型

-

- def load(self, fname=data_path, iszip=True):

- self.classifier.load(fname, iszip) # 加载贝叶斯模型

-

- # 分词以及去停用词的操作

- def handle(self, doc):

- words = seg.seg(doc) # 分词

- words = normal.filter_stop(words) # 去停用词

- return words # 返回分词后的结果

-

- def train(self, neg_docs, pos_docs):

- data = []

- # 读入负样本

- for sent in neg_docs:

- data.append([self.handle(sent), 'neg'])

- # 读入正样本

- for sent in pos_docs:

- data.append([self.handle(sent), 'pos'])

- # 调用的是Bayes模型的训练方法

- self.classifier.train(data)

-

- def classify(self, sent):

- # 1、调用sentiment类中的handle方法

- # 2、调用Bayes类中的classify方法

- ret, prob = self.classifier.classify(self.handle(sent)) # 调用贝叶斯中的classify方法

- if ret == 'pos':

- return prob

- return 1-prob

从上述的代码中,classify函数和train函数是两个核心的函数,其中,train函数用于训练一个情感分类器,classify函数用于预测。在这两个函数中,都同时使用到的handle函数,handle函数的主要工作为对输入文本分词和去停用词。

情感分类的基本模型是贝叶斯模型 Bayes,对于贝叶斯模型,这里就先介绍一下机器学习算法—朴素贝叶斯的公式,详细说明可查看 python版 朴素贝叶斯-基础 - 简书。对于有两个类别c1和c2的分类问题来说,其特征为w1,⋯,wn,特征之间是相互独立的,属于类别c1的贝叶斯模型的基本过程为:

其中: