热门标签

热门文章

- 1鼠标放到QPushButton或者QLabel 部件变色_qlabel hover

- 2SLAM优化位姿时,误差函数的雅可比矩阵的推导。

- 3如何从 iPhone 上恢复已删除的照片教程分享_csdn相册恢复iphone

- 4ubuntu20.04搭建arm交叉编译环境_ubuntu arm交叉编译环境

- 52021-10-31 将一张厚度为0.05m的纸,折叠多少次后,能够超过珠穆朗玛峰(高度为8848000m)_折纸珠穆朗玛峰编程c语言

- 6(实测可用)STM32CubeMX教程-STM32L431RCT6开发板研究串口通信(RS485)_用stm32cubemx、keil接收rs485信号

- 7Docker第五篇-Docker镜像推送公共仓库_docker需要吧redis推送仓库吗

- 8css简洁代码实现 两端对齐_css的两边对齐

- 9MarkDown 的使用—— 入门篇_markdown mindmap

- 10MAC下VS code配置C/C++环境(以C语言为例)_vs for mac c++模版

当前位置: article > 正文

FlashAttention2 安装;报错 RuntimeError: FlashAttention only supports Ampere GPUs or newer.

作者:小蓝xlanll | 2024-03-20 03:14:28

赞

踩

runtimeerror: flashattention only supports ampere gpus or newer.

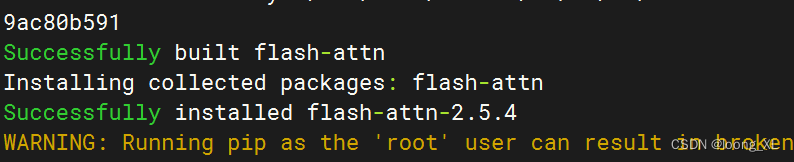

1、FlashAttention2 安装

cuda12.0环境;pytorch 2.1.2+cu118;transformers 4.38.0

pip install flash-attn --no-build-isolation --use-pep517

- 1

2、报错 RuntimeError: FlashAttention only supports Ampere GPUs or newer.

参考:

https://github.com/Dao-AILab/flash-attention

FlashAttention2暂时不支持 T卡,后续支持,如果要使用先用1.X版本

推荐阅读

相关标签