- 1图像分类pytorch-image-models-master代码目录解析_如何使用pytorch-image-models

- 2Idea2023JavaWeb项目创建方法_idea2023.2版本创建javaweb工程

- 3ssm基于微信小程序的电影影评交流平台系统 uni-app_基于微信小程序的影音点评系统的设计与实现

- 4深入浅出Transformer:大语言模型的核心技术

- 5怎么导入别人的android项目

- 6升级win11提示“此电脑不符合安装windows11的最低系统要求”解决方法,适用所有电脑_这台电脑不符合安装此版本的windows

- 7Java循环队列_java 循环队列

- 8Doris-删除数据(Delete)(二十二)_doris delete

- 9唯众本科物联网工程技术专业解决方案_c#物联网课程体系

- 10文件读取 xxe_XXE漏洞那些事儿(JAVA)

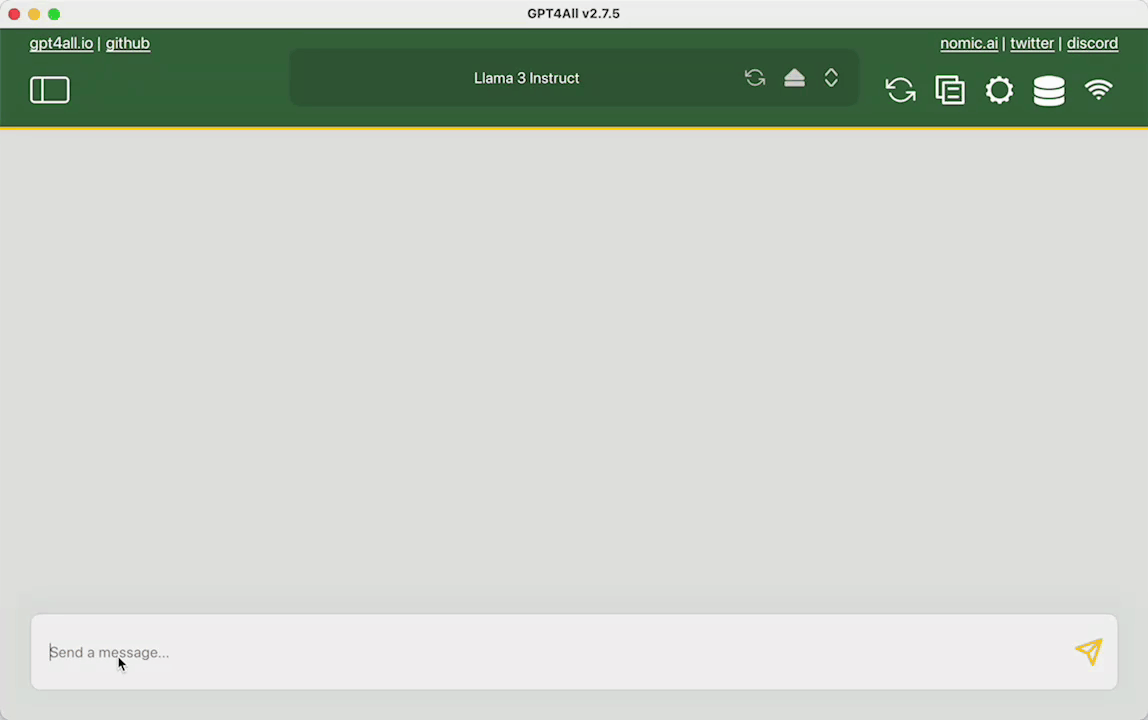

LLMs之GPT4ALL:GPT4ALL的简介、安装和使用方法、案例应用之详细攻略

赞

踩

LLMs之GPT4ALL:GPT4ALL的简介、安装和使用方法、案例应用之详细攻略

目录

LLMs之LLaMA3:基于GPT4ALL框架对LLaMA-3实现模型部署并推理—通过加载训练后LLaMA-3的gguf模型文件然后在GUI界面中实现对话聊天

GPT4ALL的简介

GPT4ALL是一个运行强大自定义大语言模型的生态系统,能够在CPU和NVDIA以及AMD GPU上本地运行。它允许任何个人或企业轻松部署自己的边缘大规模语言模型。

GPT4All是一款面向隐私的软件,用于与在您自己的计算机上运行的大型语言模型进行聊天。

GPT4All 模型是一个 3GB - 8GB 的文件,您可以下载并插入到 GPT4All 软件中。Nomic AI 支持并维护此软件生态系统,以确保质量和安全,并在努力允许任何个人或企业轻松部署自己的边缘大型语言模型的同时发挥领先作用。

官网地址:GitHub - nomic-ai/gpt4all: gpt4all: run open-source LLMs anywhere

0、新功能

2023年10月19日:GGUF 支持发布,支持:

Mistral 7b 基础模型,在 gpt4all.io 上更新的模型库,包括 Rift Coder v1.5 在内的几个新的本地代码模型

Nomic Vulkan 支持 GGUF 中的 Q4_0 和 Q4_1 量化。

离线构建支持以运行旧版本的 GPT4All 本地 LLM 聊天客户端。

2023年9月18日:Nomic Vulkan 发布,支持在 NVIDIA 和 AMD GPU 上进行本地 LLM 推断。

2023年7月:稳定支持 LocalDocs,这是一个允许您私下和本地聊天与您的数据的功能。

2023年6月28日:基于 Docker 的 API 服务器推出,允许从与 OpenAI 兼容的 HTTP 端点进行本地 LLM

1、特点

>> 能够在支持AVX指令集的CPU上运行,不需要GPU也能运行

>> 提供3-8GB之间的多种预训练模型,用户可以下载后直接使用

>> 保障用户隐私,模型运行于本地不上传用户数据

>> 提供跨平台支持,可在Windows、MacOS、Linux三个平台上运行

2、功能

>> 聊天软件客户端,可以与预加载模型进行对话

>> 提供Python和TypeScript绑定,开发者可以基于此扩展功能

>> 支持LocalDocs功能,可以将文件索引并与模型对话

>> 提供Docker容器化部署,运行模型提供HTTP接口

>> 支持GPU加速,利用CUDA运行模型获得更好性能