热门标签

热门文章

- 1virtualenv 创建虚拟环境_create a virtual environment

- 2【调试工具】Windows和Android端测试工具 - iperf3_iperf3安卓客户端

- 3小兴教你做平衡小车-stm32程序开发(I2C控制OLED显示屏)_stm32 i2coled

- 4Cookie,Session,JWT_cookie有效期一般多久

- 5非root(各种权限受限制的乙方用户)用户安装mysql-8.0.32_非root用户安装mysql8

- 6Leetcode 238_leetcode238

- 7银河麒麟V10之达梦8安装配置_银河麒麟v10 sp3安装达梦v8

- 8stm32f103c8t6学习笔记(学习B站up江科大自化协)-看门狗【WDG】_stm32f103c8t6看门狗

- 9“波吉向你发出学习邀请”,数据结构之单双向链表_建立一个非递减有序单链表(不少于5个元素结点),输出该链表中重复的元素以及重复次

- 10【圆梦云出品】weiphp使用视频教程,无广告

当前位置: article > 正文

hbase:meta,,1 is not online on sfbg101,16020,1635497350221_hbase:meta,,1is not online on

作者:小舞很执着 | 2024-07-15 14:31:51

赞

踩

hbase:meta,,1is not online on

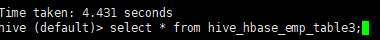

hbase没有这张表,我其实已经删除hdfs里面的数据,在hive的元数据里面还保存有这个表的元数据

那么就删除hive里面的这个表的元数据信息

重新建hbase表

还是报错

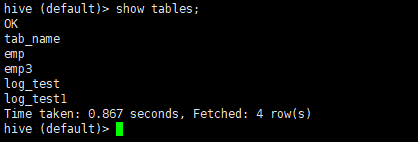

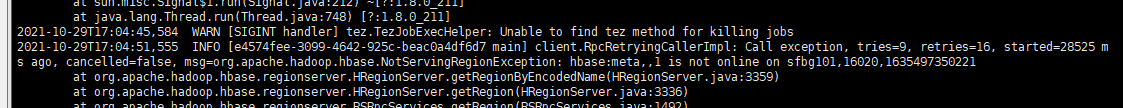

查看 tailf hbase-root-regionserver-sfbg101.log

报错

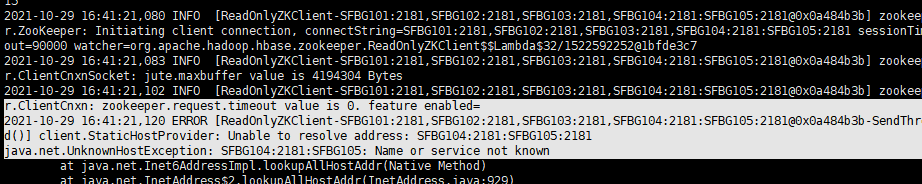

在hase-site.xml里面配置错误

把:改成逗号,分发各个节点

然后重启hbase集群

这次查看tailf hbase-root-regionserver-sfbg101.log 没有报错信息

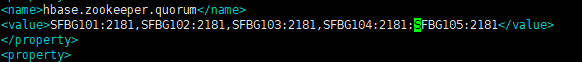

tailf hive.log 查看hive日志

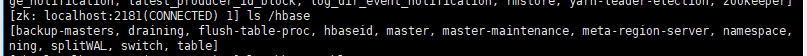

突然想起,hbase存在在hdfs上的元数据删除掉了,那么存在zookeeper里面的元数据没有删除掉

先试试吧zookeeper里面的元数据删除试试

deleteall /hbase

重启hbase集群,重启hvie,创建hbase映射表,成功

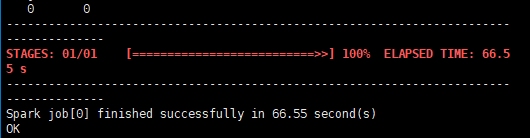

向hbase插入数据

由于配置hadoop的ha,所以删除hadoop的data和log目录,但是之前配置过集群,所以还存在元数据保存在zookeeper里面,但是hdfs里面的hbase的数据都删除掉了,重新生成的是新的数据,且又增加了两个节点,所以报错,最后把这个zookeeper里面删除掉了之后,就可以成功了

hive on spark 可以配置hive的日志文件,进行查看

这个刚开始出现的问题是提示sfbg101的16020端口不在线上就是它找不到,至于为啥找不到

不知道,查看16020端口,lsof -i:16020就可以查看对应的进程号,jps查看发现是HRegionServer

的端口,所以是启动的,最后想了想,应该是元数据的问题。

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/小舞很执着/article/detail/829815

推荐阅读

相关标签