热门标签

热门文章

- 1【Git】回退单个文件到指定版本_git单个文件回到指定版本

- 2Unity程序基础框架__UI管理模块_unity ui管理器

- 3【TOP解刊】新晋中科院1区IEEE,跻身CCF-C类,国人友好,审稿极快!_ieee internet of things journal分区

- 4MapReduce(二): Job的运行状态_hadoop jobstate什么情况下是running

- 5gitblit服务器搭建

- 6Github新手使用教程_github下载后怎么使用

- 7区块链探秘:从基础到深度,全面解读区块链技术与应用_区块链的最新技术

- 8python爬虫实战之异步爬取数据_python 异步采集

- 9鸿蒙DevEco Studio 简单实现:使用页面路由实现登录跳转和返回功能。_鸿蒙deveco studio设计手机登录页面

- 10ArrayList集合的排序_第2关:用comparable接口实现arraylist集合的排序

当前位置: article > 正文

BART BERT ELMO UNILM之间差别_bart与bert

作者:小小林熬夜学编程 | 2024-06-17 03:19:10

赞

踩

bart与bert

这里只针对情感分析这一个下游任务进行分析:

BART、ELMO 都是生成模型,只能与一定数目固定的标签做细粒度情感分析

BART 是通过 NSP 预训练任务,将标签作为下句,判断上句和下句是否存在关系,进而判断这个标签是否属于这句话,缺点是假如有60个标签,那就需要判断60次,运行速度堪忧。

ELMO 则是通过 MLM 预训练任务,给句子结尾进行 Mask

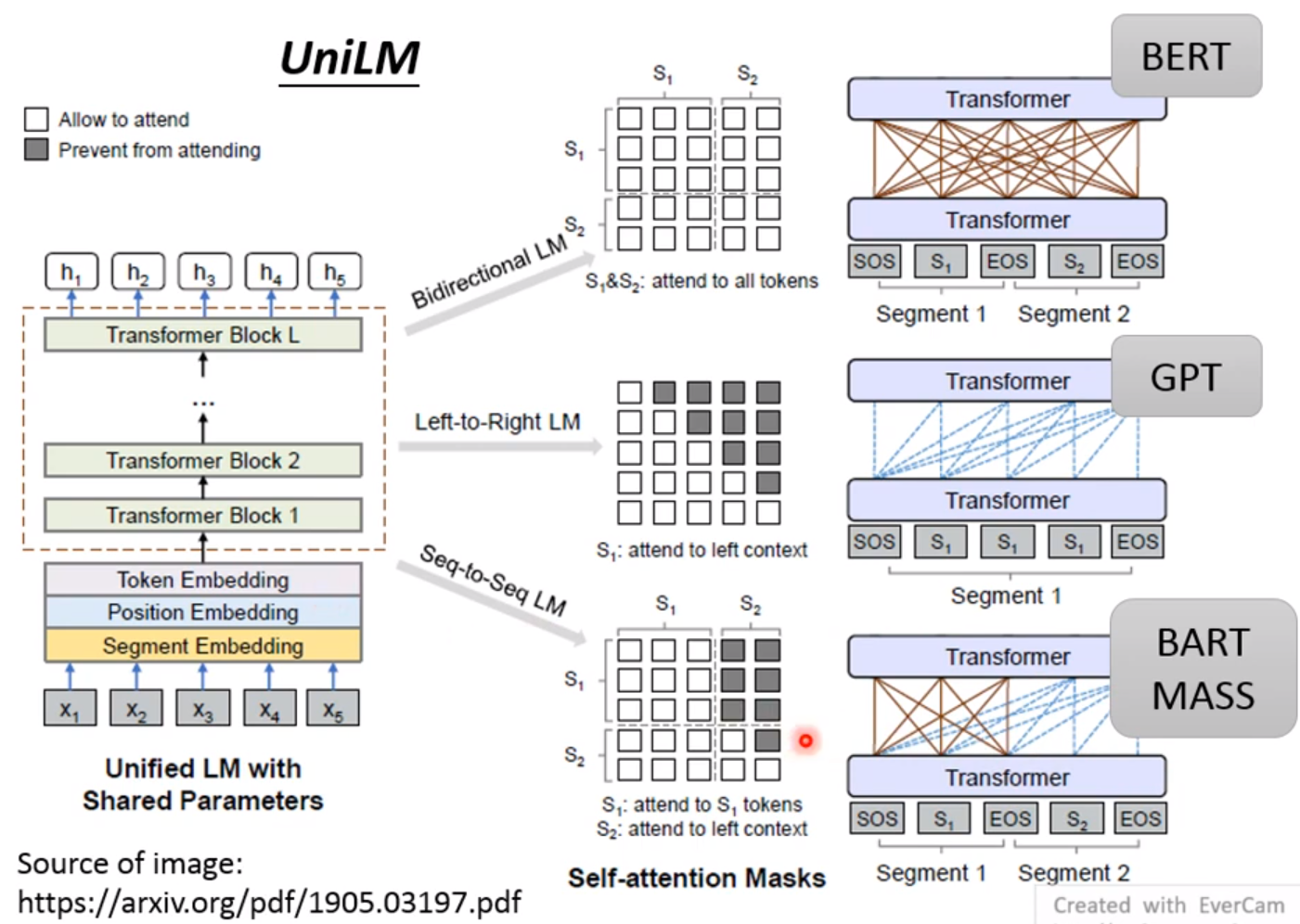

或者看下李宏毅老师这个图

BERT 的transformer之间全连接,看上下文,没法用做生成式任务,因为在前面就看到后面的了

BART 是看前面预测后面

GPT 是前一个词生后一个词

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/小小林熬夜学编程/article/detail/729428

推荐阅读

相关标签