- 1linux安装fastdfs 讲解

- 2Ngram:多语言模型插值_ngram 插值

- 3开发平台支持Arm Cortex-M的微控制器上人工智能训练_板上人工智能

- 4循环神经网络系列-GRU原理、优化、改进及代码实现(时序预测/分类/回归拟合,Matlab)_修改gru模型应该改源码的哪些部分

- 5自然语言处理(02/10):自然语言处理任务和应用程序

- 6完整的loader引导代码详解_loader 引导配置详解

- 7干货 | 循环神经网络(RNN)和LSTM初学者指南

- 8SQL语句大全(详解)_sql 语句

- 9tokenizers Tokenizer类_skip_special_tokens

- 10某音商品详情数据接口(Douyin.item_get)_python 抖音商品价格

AlexNet学习笔记_resample2d

赞

踩

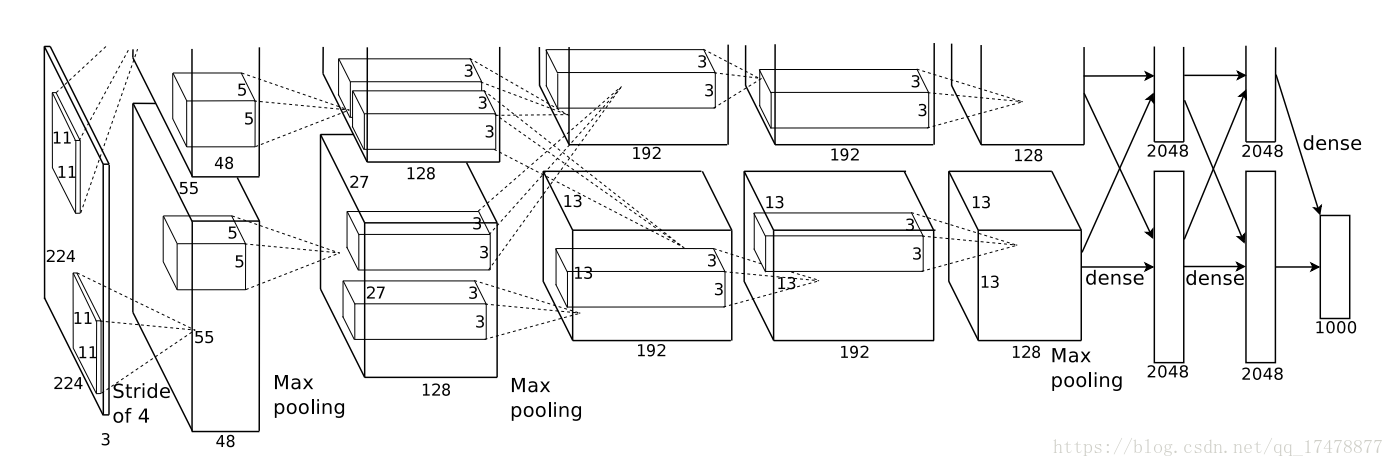

1.网络结构

上图从左到右:

第0层是输入层:输入大小为227×227×3大小的RGB图像

第1层是卷积层:(1)使用96个11×11×3的卷积核,s=4,p=0,输入为上一层的输出(下同),输出数据维度为55×55×96

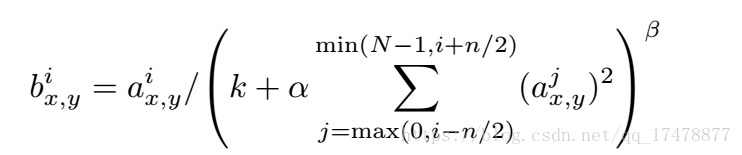

(2)Local response normalization

(3)Relu(),输出数据维度为55×55×96

ReLU本来是不需要对输入进行标准化,但本文发现进行局部标准化能提高性能。

其中

(4)Max pooling,最大池化,s=2,f=3,输出数据维度是27×27×96

第2层是卷积层:(1)使用256个5×5×48的卷积核,s=1,p=2,输入为上一层的输出(下同),输出数据维度为27×27×256

(2)Local response normalization

(3)Relu(),输出数据维度为27×27×256

(4)Max pooling,最大池化,s=2,f=3,输出数据维度是13×13×256

第3层是卷积层:(1)使用384个3×3×256的卷积核,s=1,p=1,输入为上一层的输出(下同),输出数据维度为13×13×384

(2)Relu(),输出数据维度为13×13×384

本层无标准化,无池化

第4层是卷积层:(1)使用384个3×3×192的卷积核,s=1,p=1,输入为上一层的输出(下同),输出数据维度为13×13×384

(2)Relu(),输出数据维度为13×13×384

本层无标准化,无池化

第5层是卷积层:(1)使用256个3×3×192的卷积核,s=1,p=1,输入为上一层的输出(下同),输出数据维度为13×13×256

(2)Relu(),输出数据维度为13×13×256

(3)Max pooling,最大池化,s=2,f=3,输出数据维度是6×6×256

第6、7、8层都是全连接层,分别有4096,4096,1000个神经元