热门标签

热门文章

- 1小白安装pytorch以及pytorch geometirc库以及在Pycharm中使用教程_pytorch自带geometirc

- 2KubeEdge v0.2发布,全球首个K8S原生的边缘计算平台开放云端代码

- 3pytorch中的while for 循环 导出onnx的问题

- 4AI赋能写作:ChatGPT让论文大放异彩

- 5xampp无法打开phpmyadmin解决方案

- 6Java快速入门之基本语法_java字符型c=65 system.out.println(c++);

- 7C++:模板总结_类模板默认参数

- 8Docker介绍及其在WSL中的应用_wsl docker

- 9OneForAll-强大的子域名收集工具_oneforall subdomain

- 10StreamWriter和StreamReader_streamwriter 创建文件吗

当前位置: article > 正文

多层注意力网络机制(Hierarchical Attention Network)_多层注意力机制

作者:小小林熬夜学编程 | 2024-04-01 15:05:57

赞

踩

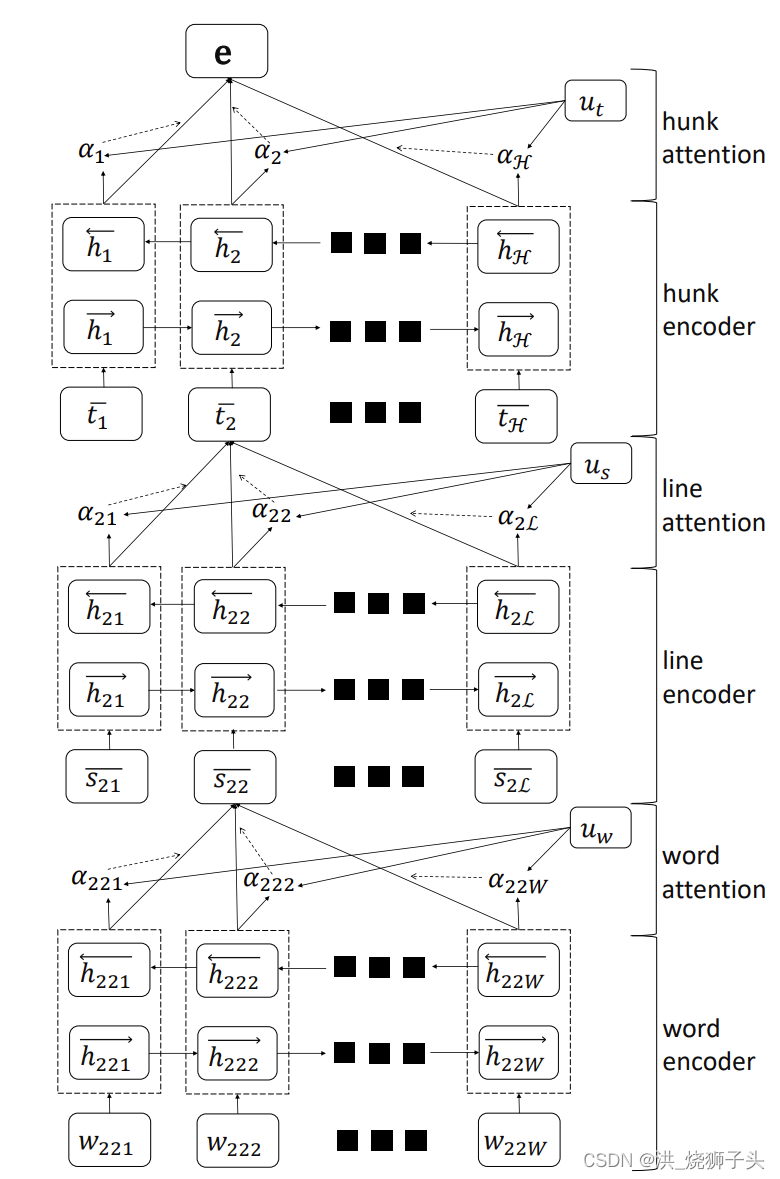

多层注意力机制

该层次attention模型总共分为3层

-

word sequence encoder + word-level attention layer

-

line encoder + line-level attention layer

-

hunk sequence encoder + hunk attention layer

模型结构如下:

Word encoder.给定一行

Word encoder.给定一行

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/小小林熬夜学编程/article/detail/349372

推荐阅读

相关标签

Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。