热门标签

热门文章

- 1IntelliJ IDEA总结(2) -- IntelliJ IDEA中git导入项目不显示maven侧边栏的问题及解决方法_git 显示maven

- 2SD相见恨晚的提示词插件,简直堪称神器!_sd最强提示词插件

- 3小区停车计费管理系统(1)(源码+开题)

- 4JAVA利用websocket实现多人聊天室、私信(附源码)_java实现聊天室框架图 有房间概念

- 5android 超链接是什么意思,Android TextView与HTML结合以及设置超链接

- 6ChatGPT文献综述撰写教程--【数字化转型与企业创新】(附结果数据)_chatgpt写综述

- 7决策树学习笔记整理_采用决策树分类法,预测该客户的拖欠贷款类别

- 8[ 云计算 | AWS 实践 ] Java 应用中使用 Amazon S3 进行存储桶和对象操作完全指南_java amazons3

- 9 Snackbar源码分析

- 10Java集合整理(Arraylist、Vector、Linklist)_arraylsit和linklist和vector

当前位置: article > 正文

centos搭建hadoop伪分布式_centos hadoop伪分布式安装教程

作者:小丑西瓜9 | 2024-04-07 21:10:57

赞

踩

centos hadoop伪分布式安装教程

一、环境准备

Centos7虚拟机一台

jdk1.8

hadoop-3.1.3

附华为开源镜像站下载地址:https://mirrors.huaweicloud.com/java/jdk/

二、java 环境安装

使用root用户登录并创建文件夹

cd /opt

mkdir app

mkdir soft

- 1

- 2

- 3

将下载好的jdk和hadoop安装包上传到虚拟机的/opt/soft目录下

1、创建hadoop用户和用户组

#创建用户组

groupadd hadoop

#创建用户

useradd hadoop

#hadoop用户设置密码

passwd hadoop

#将/opt目录的所有者修改为hadoop,否则没有权限操作

chown -R hadoop:hadoop /opt

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

2、编辑/etc/sudoers

#vim /etc/sudoers找到“root ALL=(ALL) ALL”一行,

#在下面插入新的一行,内容是“hadoop ALL=(ALL) ALL”

vim /etc/sudoers

#加入下面的内容

hadoop ALL=(ALL) ALL

- 1

- 2

- 3

使用:wq! 进行保存并退出编辑。必须加!否则编辑不成功。

#切换成hadoop用户

su hadoop

- 1

- 2

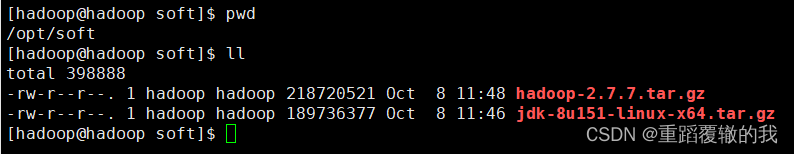

准备好的安装包及安装包位置

后续的环境搭建和操作均在hadoop用户下进行操作

3、解压jdk

tar -zxvf jdk-8u151-linux-x64.tar.gz -C ../app/

- 1

4、对解压后的jdk包进行重新命名。

cd ../app

#注意更换为自己jdk的包名称

mv jdk1.8.0_151/ java

- 1

- 2

- 3

5、配置java的环境变量

vim ~/.bashrc

#加入下面的内容

export JAVA_HOME=/opt/app/java

export JRE_HOME=${JAVA_HOME}/jre

export CLASSPATH=.:${JAVA_HOME}/lib:${JRE_HOME}/lib

export PATH=${JAVA_HOME}/bin:$PATH

#然后使配置生效

source ~/.bashrc

#验证java配置是否生效

java -version

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

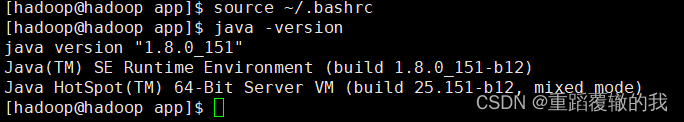

出现下面图片表示安装成功。

三、hadoop伪分布式安装

1、解压hadoop安装包并配置hadoop环境变量

cd /opt/soft

tar -zxvf hadoop-2.7.7.tar.gz -C ../app/

#对解压后的包进行重新命名

cd ../app

mv hadoop-2.7.7/ hadoop

- 1

- 2

- 3

- 4

- 5

配置hadoop的环境变量

#编辑~/.bashrc

vim ~/.bashrc

#添加以下内容

export HADOOP_HOME=/opt/app/hadoop

export PATH=${HADOOP_HOME}/sbin:${HADOOP_HOME}/bin:$PATH

#使环境变量文件生效

source ~/.bashrc

- 1

- 2

- 3

- 4

- 5

- 6

- 7

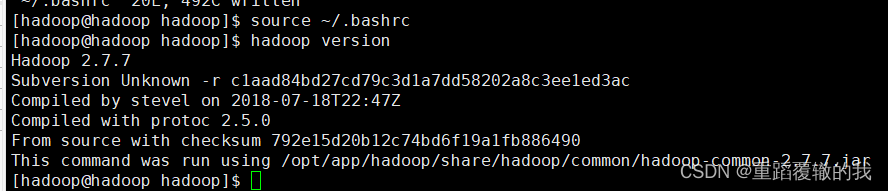

验证环境变量是否设置成功。

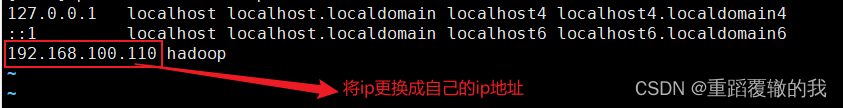

2、修改hosts文件并修改hostname

#修改虚拟机主机名称

sudo hostnamectl set-hostname hadoop

#查看当前虚拟机名称

hostname

#编辑hosts

sudo vim /etc/hosts

- 1

- 2

- 3

- 4

- 5

- 6

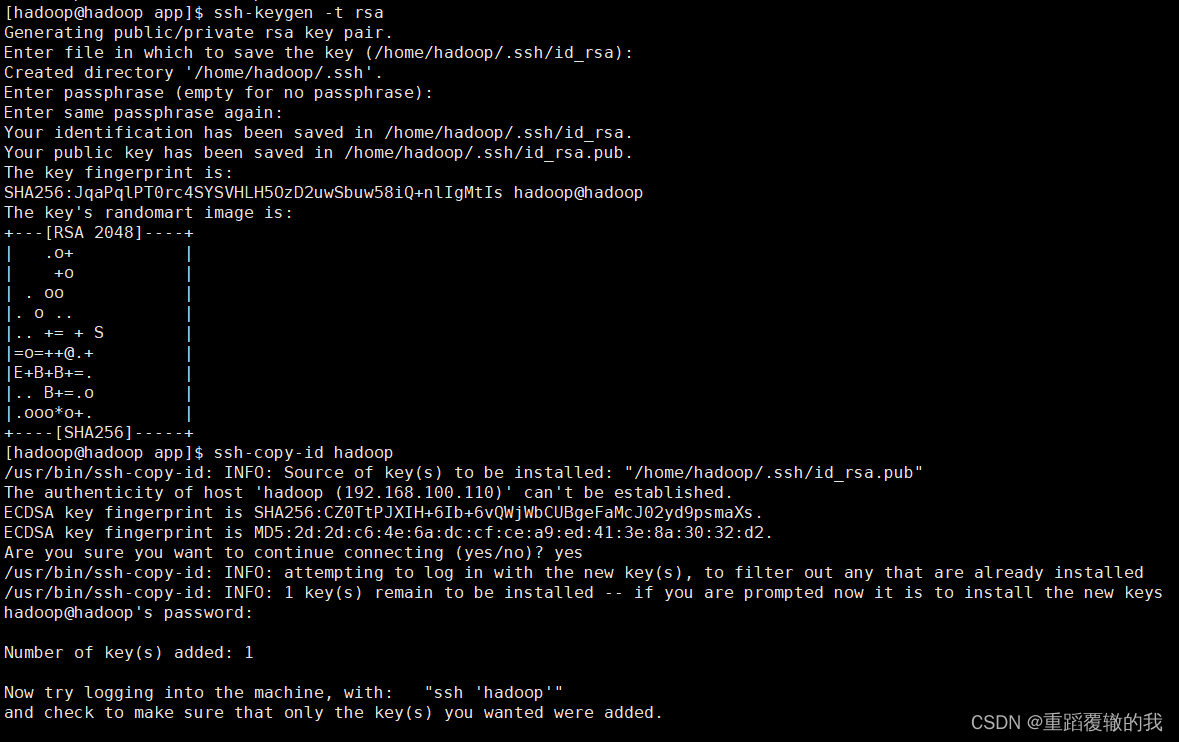

3、进行免密登录

# 执行该命令后遇到提示信息,一直按回车就可以

ssh-keygen -t rsa

# 将你的公共密钥填充到一个远程机器上的authorized_keys文件中

ssh-copy-id hadoop

- 1

- 2

- 3

- 4

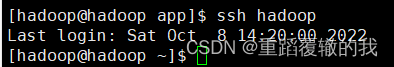

测试ssh是否免密成功

ssh hadoop

- 1

4、配置hadoop-env.sh

cd ./hadoop/etc/hadoop

vim hadoop-env.sh

#在文件中添加或者修改,并保存

export JAVA_HOME=/opt/app/java

- 1

- 2

- 3

- 4

5、修改core-site.xml

vim core-site.xml

- 1

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://hadoop:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>file:/opt/app/hadoop/tmp</value>

</property>

</configuration>

#注意将ip和路径更换称自己的定义的

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

6、修改hdfs-site.xml

<configuration> <property> <name>dfs.namenode.secondary.http-address</name> <value>hadoop:50090</value> </property> <property> <name>dfs.replication</name> <value>1</value> </property> <property> <name>dfs.namenode.name.dir</name> <value>file:/opt/app/hadoop/tmp/dfs/name</value> </property> <property> <name>dfs.datanode.data.dir</name> <value>file:/opt/app/hadoop/tmp/dfs/data</value> </property> </configuration> #注意将ip和路径更换称自己的定义的

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

7、修改mapred-site.xml

#注意将ip和路径更换称自己的定义的 <configuration> <property> <name>mapreduce.framework.name</name> <value>yarn</value> </property> <property> <name>mapreduce.jobhistory.address</name> <value>hadoop:10020</value> </property> <property> <name>mapreduce.jobhistory.webapp.address</name> <value>hadoop:19888</value> </property> <property> <name>yarn.app.mapreduce.am.env</name> <value>HADOOP_MAPRED_HOME=/opt/app/hadoop</value> </property> <property> <name>mapreduce.map.env</name> <value>HADOOP_MAPRED_HOME=/opt/app/hadoop</value> </property> <property> <name>mapreduce.reduce.env</name> <value>HADOOP_MAPRED_HOME=/opt/app/hadoop</value> </property> </configuration>

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

8、修改yarn-site.xml

<configuration>

<property>

<name>yarn.resourcemanager.hostname</name>

<value>hadoop</value>

</property>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

</configuration>

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

9、修改slaves

vim slaves

#修改为

hadoop

- 1

- 2

- 3

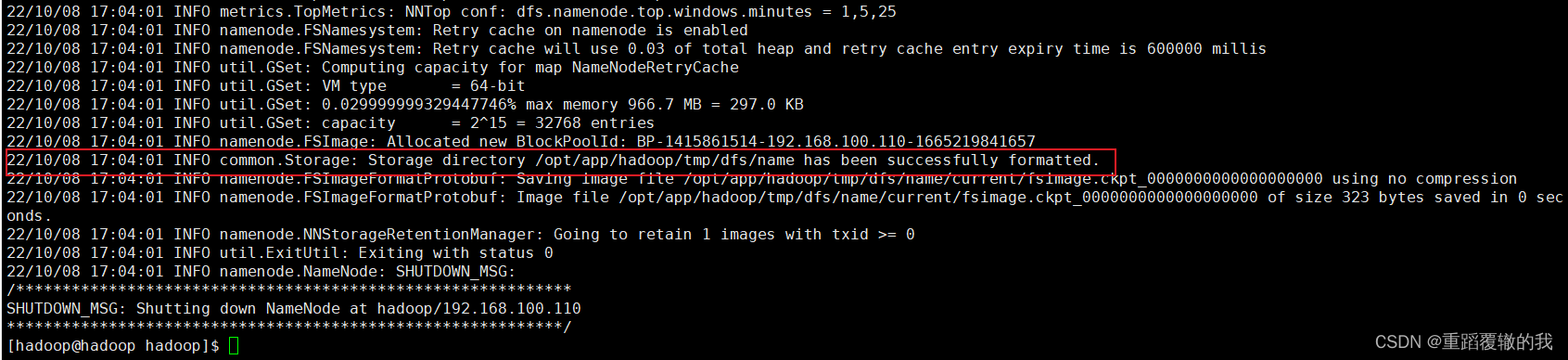

10、格式化namenode

hdfs namenode -format

- 1

以下表示格式化成功。

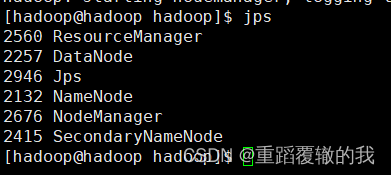

11、启动hadoop

start-all.sh

#或者分别启动hdfs和yarn

start-dfs.sh

start-yarn.sh

- 1

- 2

- 3

- 4

jps进行验证是否启动成功,出现以下5个进程表示启动成功。

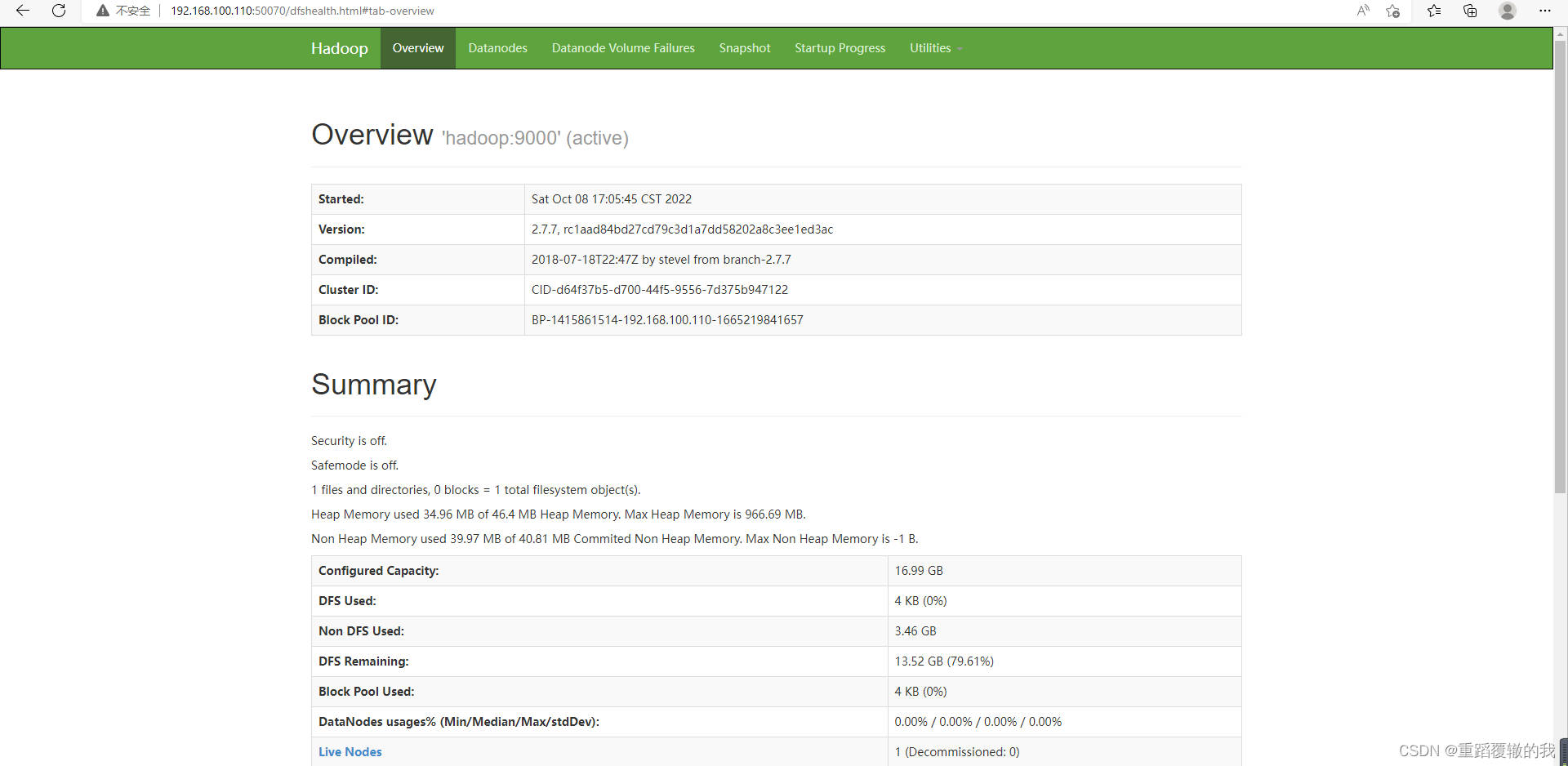

12、访问hadoop的webui查看状态

ip:9870进行访问

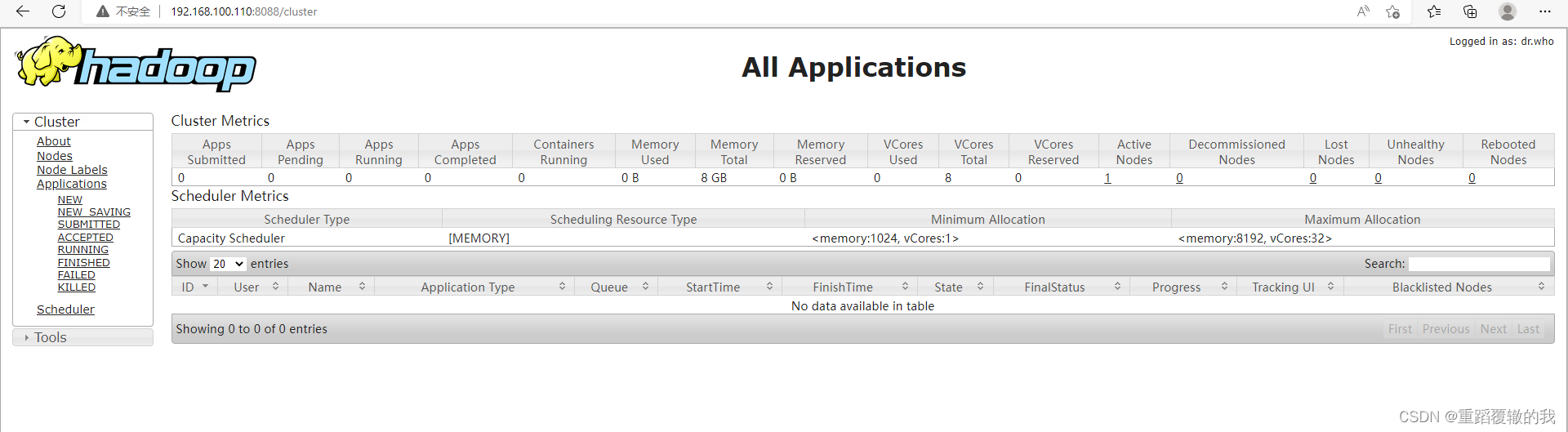

yarn的访问

ip:8088

到此hadoop伪分布式就算搭建成功了。

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/小丑西瓜9/article/detail/380636

推荐阅读

相关标签