- 1WEB、Client、Mobile测试有什么异同_client app 、mobile app是什么意思

- 2飞书 Android 升级 JDK 11 引发的 CI 构建性能问题

- 3android studio配置git_mac androidstudio 怎么配置git

- 4USB xHCI中断_android xhci短包

- 5安装反射大师具体步骤与使用教程_反射大师官网

- 6OpenCV 环境变量参考

- 7LaTeX中的表格_latex中表格

- 8linux升级内核后网卡丢失,【已解决】Ubuntu18.04 更新内核到4.19 后出现的网卡驱动失灵...

- 9sql server累计求和函数_浅解比SQL更好用的SPL(一)

- 10Goc圆形滑轨、地铁标志、同心圆(比赛模拟题)、外半径与内半径(2019NH教师GoC)题答案_goc题目

端到端自动驾驶合集

赞

踩

最近的端到端驱动方法可以分为两个主流:模仿学习和强化学习。强化学习(RL)是机器学习中最有趣的领域之一,其中代理通过遵循策略与环境交互。在环境的每一个状态下,它都会根据策略采取行动,从而获得奖励并过渡到新状态。RL的目标是学习使长期累积回报最大化的最优策略。在模仿学习中,专家(通常是人类)为我们提供了一组演示,而不是试图从稀疏的奖励中学习或手动指定奖励函数。然后,代理尝试通过模仿专家的决策来学习最优策略。下面为大家汇总了近三年的一些端到端工作,虽然不多,但确实是一个很值得研究的领域!

用于端到端自动驾驶多模态融合transformer

论文名称:Multi-Modal Fusion Transformer for End-to-End Autonomous Driving

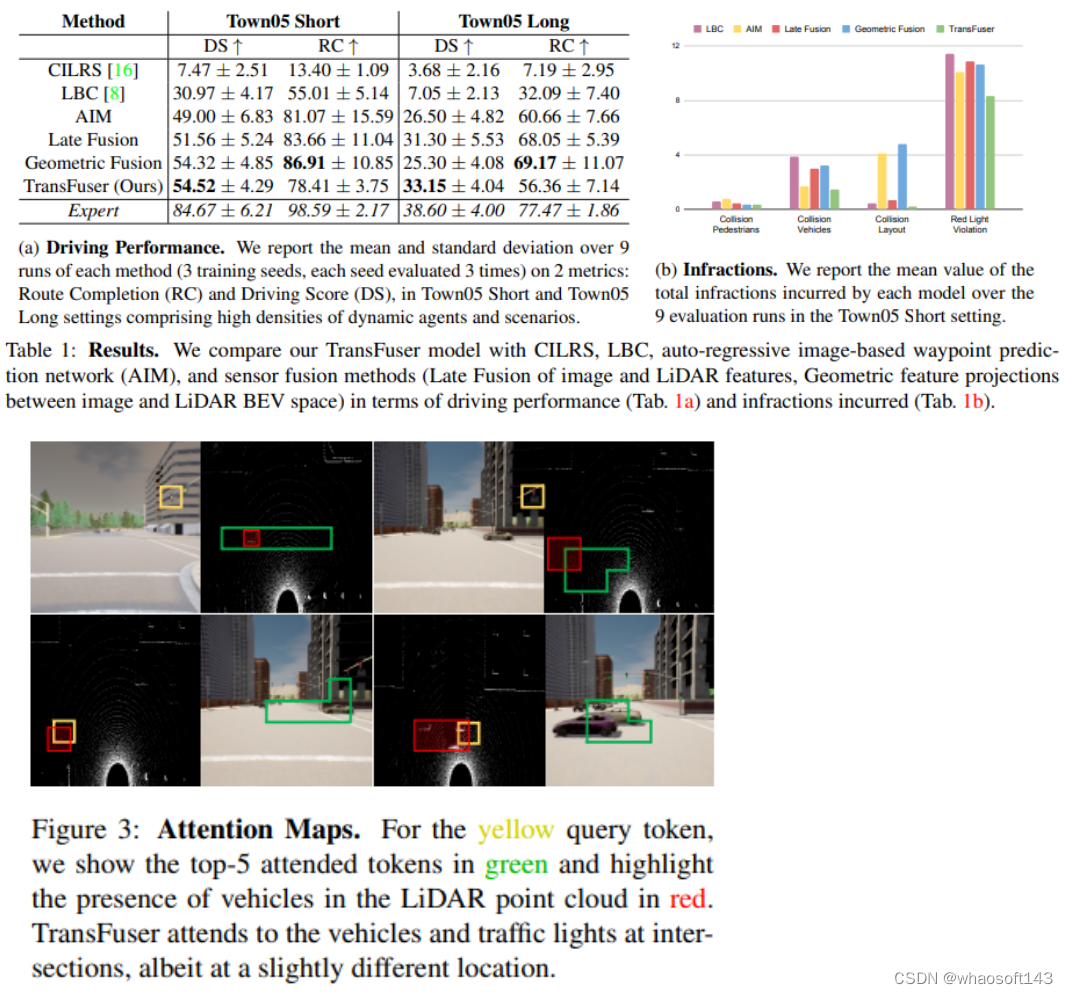

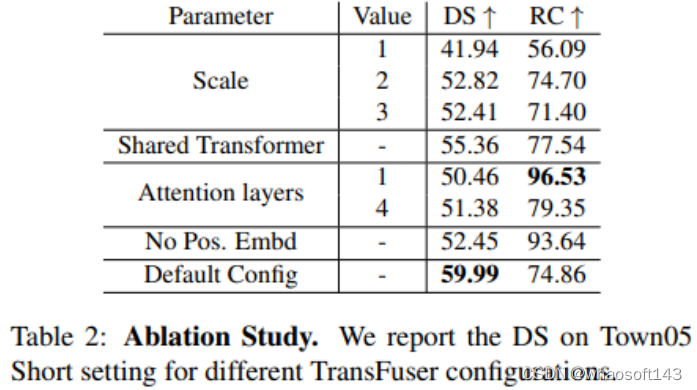

如何将互补传感器的表示集成到自动驾驶中?基于几何的传感器融合在目标检测和运动预测等感知任务中显示出巨大的前景。然而,对于实际驾驶任务,3D场景的全局上下文是关键,例如,交通灯状态的变化可以影响几何上远离该交通灯的车辆的行为。因此,单独的几何结构可能不足以有效地融合端到端驱动模型中的表示。本文证明了基于现有传感器融合方法的模拟学习策略在高密度动态代理和复杂场景的存在下表现不佳,这些场景需要全局上下文推理,例如在不受控制的交叉口处处理来自多个方向的迎面而来的交通。因此,作者提出了一种新的多模态融合transformer:TransFuser,以利用注意力来集成图像和激光雷达表示。使用CARLA城市驾驶模拟器在涉及复杂场景的城市环境中通过实验验证了论文方法的有效性。与基于几何的融合相比,本文的方法实现了最先进的驾驶性能,同时减少了76%的碰撞。

Contribution

(1) 论文证明,基于现有传感器融合方法的模仿学习策略无法处理城市驾驶中的对抗性场景,例如,十字路口的无保护转弯或来自闭塞区域的行人;(2) 提出了一种新的多模态融合transformer(TransFuser),以将3D场景的全局上下文结合到不同模态的特征提取层中;(3) 在复杂的城市环境中通过实验验证了本文的方法,包括CARLA中的对抗场景,并实现了最先进的性能;代码和经过训练的模型可在:

https://github.com/autonomousvision/transfuser

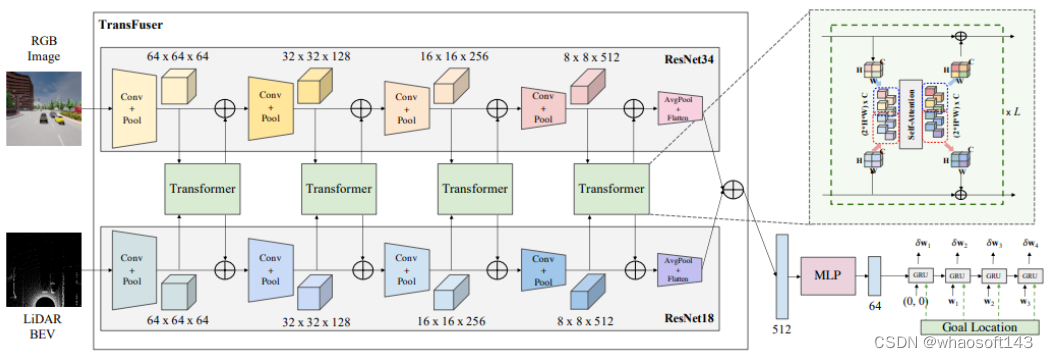

模型结构

将单视图RGB图像和LiDAR BEV表示作为多模态融合变换器(TransFuser)的输入,该transformer使用多个transformer模块来融合两种模态之间的中间特征图。该融合在整个特征提取器中以多个分辨率(64×64、32×32、16×16和8×8)应用,从而从图像和LiDAR BEV流输出512维特征向量,并通过逐元素求和进行组合。该512维特征向量构成对3D场景的全局上下文进行编码的环境的紧凑表示。然后,在将其传递到自回归航路点预测网络之前,通过MLP对其进行处理。使用一个单层GRU,然后是一个线性层,该层处于隐藏状态,并预测差异ego-vehicle路线点{δ}=,在ego-vehicle的当前坐标系中表示。

实 验

实 验

论文将本方法的驱动性能与几个基线进行比较,进行违规分析以研究不同的故障案例,可视化TransFuser的注意力图,并进行消融研究以突出我们模型不同组件的重要性。论文考虑沿一组预定义的路线在各种区域导航的任务,例如高速公路、城市地区和住宅区。路线由全球规划器提供的GPS坐标中的一系列稀疏目标位置和相应的离散导航命令(例如,跟随车道、左转/右转、改变车道)定义。论文的方法只使用稀疏的GPS位置来驾驶,每条路线由若干场景组成,在预定义位置初始化,测试代理可以处理不同类型的对抗性情况,例如避障、交叉口无保护转弯、车辆闯红灯、行人从闭塞区域出来在任意位置横穿道路,代理需要在指定的时间限制内完成路线,同时遵守交通规则并应对高密度的动态代理。

指标:(1) 路线完成(RC),完成的路线距离百分比,(2) 驾驶分数(DS),是由违规乘数加权的路线完成度,该乘数考虑了与行人、车辆和静态元素的碰撞、路线偏离、车道违规、闯红灯和行驶停止标志和(3)违规计数

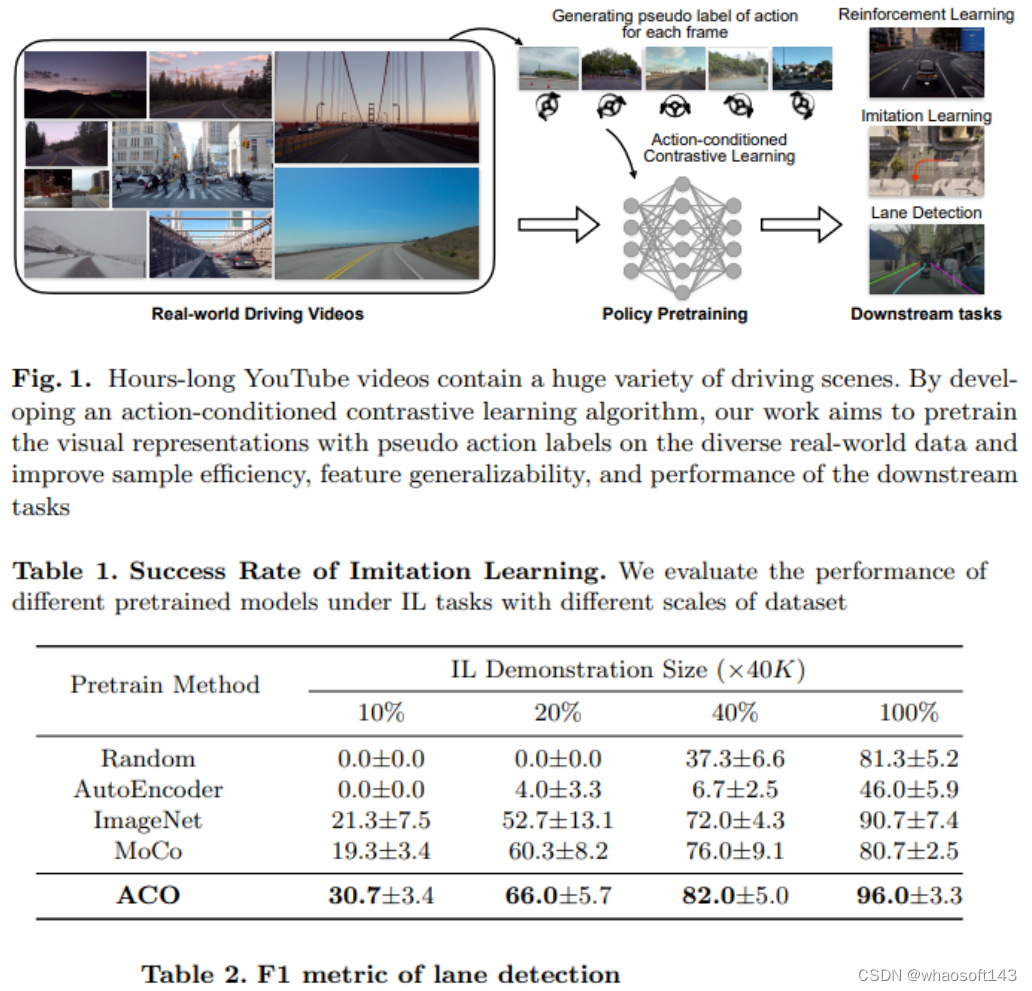

论文名称:Learning to Drive by Watching YouTube Videos: Action-Conditioned Contrastive Policy Pretraining

论文名称:Learning to Drive by Watching YouTube Videos: Action-Conditioned Contrastive Policy Pretraining

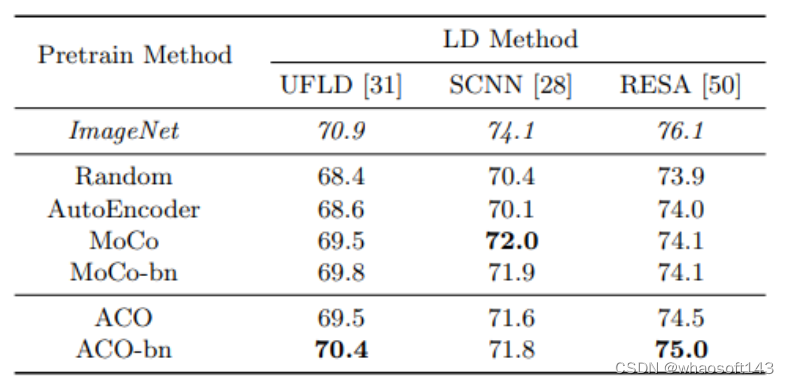

深度视觉运动策略学习旨在将原始视觉观察映射到行动,在机器人操纵和自动驾驶等控制任务中取得了很好的结果。然而,它需要与培训环境进行大量的在线交互,这限制了它的实际应用。与流行的用于视觉识别的无监督特征学习相比,用于视觉运动控制任务的特征预训练的研究要少得多。在这项工作中,我们的目标是通过观看长达数小时的未分级YouTube视频来预处理驾驶任务的政策表示。具体来说,我们用少量标记数据训练一个逆动态模型,并使用它来预测所有YouTube视频帧的动作标签。然后开发了一种新的对比策略预训练方法,以从带有伪动作标签的视频帧中学习动作条件特征。实验表明,所得到的动作条件特征对于下游的强化学习和模仿学习任务获得了实质性的改进,优于从先前的无监督学习方法和ImageNet预处理的权重!

本文评估了各种任务的行动条件预训练的有效性,例如端到端自动驾驶中通过模仿学习(IL)和强化学习(RL)进行的策略学习,以及车道检测(LD),实验结果表明,ACO成功地学习了下游任务的可推广特征。贡献总结如下:

1.提出了一种对大量真实世界驾驶视频进行政策预训练的新范式;

2.开发了一种新的行动条件对比学习方法ACO,以学习与行动相关的特征;

3.在下游策略学习任务中的各种预训练方法的实验表明,所提出的方法产生的特征在驱动任务中获得了足够的性能增益;

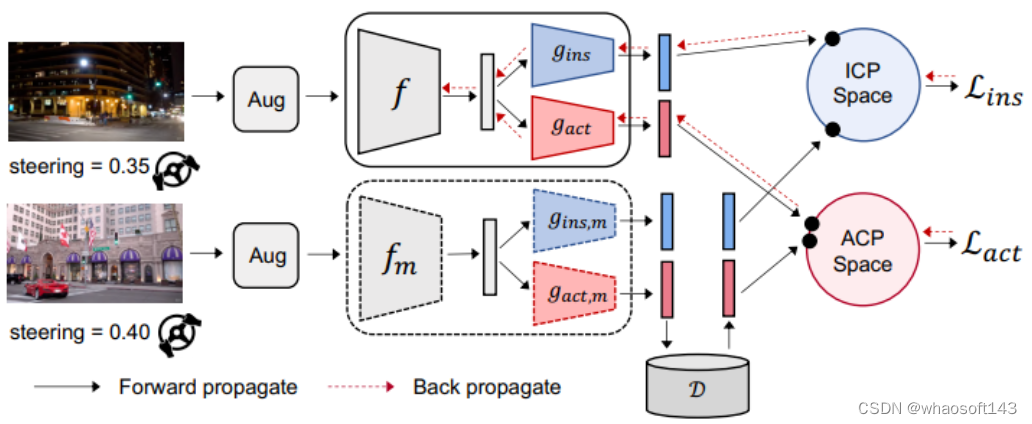

主要思路

本文目的是学习视觉运动策略学习的可推广视觉特征(通过对大量未经修正的真实驾驶视频进行预训练),作者提出了一种新的对比学习算法,称为行动条件集中学习(ACO)。ACO的本质是定义了两种类型的对比对:实例对比对(ICP)和动作对比对(ACP)。单个图像的两个视图形成正ICP,而不同图像的两视图形成负ICP,只有使用ICP进行预训练才能使表示包括下游策略学习任务的不必要信息。

本文目的是学习视觉运动策略学习的可推广视觉特征(通过对大量未经修正的真实驾驶视频进行预训练),作者提出了一种新的对比学习算法,称为行动条件集中学习(ACO)。ACO的本质是定义了两种类型的对比对:实例对比对(ICP)和动作对比对(ACP)。单个图像的两个视图形成正ICP,而不同图像的两视图形成负ICP,只有使用ICP进行预训练才能使表示包括下游策略学习任务的不必要信息。

例如,天气和照明条件等视觉线索对形成ICP至关重要,但对自动驾驶的决策几乎没有贡献。为了将特征集中在与策略相关的属性上,我们引入了另一种类型的对比对,称为动作对比对(ACP)。正ACP由两幅不同的图像组成,显示了驾驶员行为相似的场景。例如,上图中的两个真实世界快照形成了一个正ACP,都显示了驾驶员左转时的第一个视图图像。ACO基于ICP和ACP学习表示,其中ICP侧重于学习歧视性一般视觉特征,ACP侧重于政策相关特征。上图说明了ACO的训练流程,在上面的分支中,首先对给定的图像进行两次扩充,以创建查询和关键视图并形成ICP。本文还创建了另一个基于ACP的学习流程,为了创建ACP,数据集中的每一帧都用伪动作标签进行标记。动作标签用于在不同图像之间形成ACP,并计算用于策略特征学习的ACP损失。

实 验

作者评估了两个主要策略学习任务的预训练特征:端到端驾驶中的模仿学习(IL)和强化学习(RL),还评估了一个相关的视觉识别任务:车道检测(LD)。

论文首先从YouTube上抓取驾驶视频,收集了134个视频,总长度超过120小时。这些视频涵盖了不同天气条件(晴、雨、雪等)和地区(农村和城市地区)的不同驾驶场景。我们每一秒采样一帧,得到130万帧的数据集。将YouTube驾驶数据集分成70%数据的训练集和30%数据的测试集,并在训练集上进行ACO的训练。

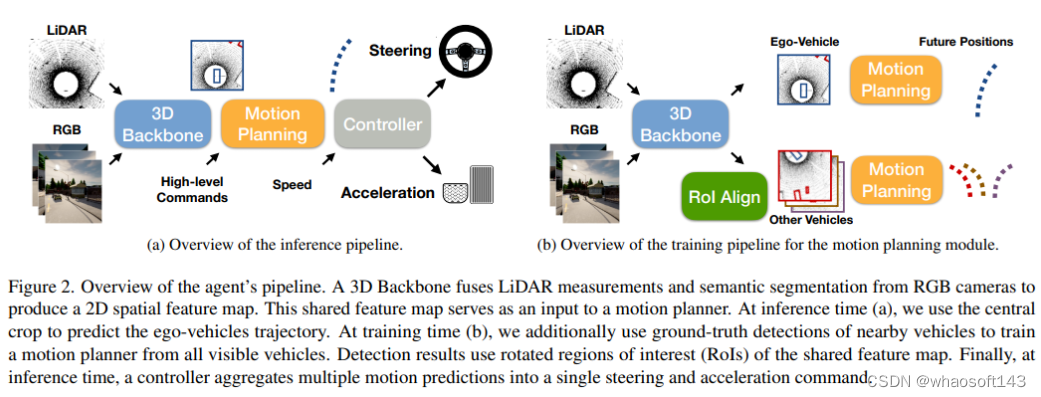

Learning from All Vehicles

Learning from All Vehicles

这篇论文提出了一个系统来训练驾驶政策,不仅从ego-vehicle,而且从它观察到的所有车辆收集到的经验。该系统使用其他代理的行为来创建更多样的驾驶场景,而无需收集额外数据。从其它车辆学习的主要困难是没有传感器信息,论文使用一组监督任务来学习对控制车辆的视点不变的中间表示。这不仅在训练时提供了更丰富的信号,还允许在推理过程中进行更复杂的推理。学习所有车辆的驾驶方式有助于预测测试时的行为,并避免碰撞,在闭环驾驶模拟中评估了该系统。本文的系统大大超过了公共CARLA排行榜上的所有现有方法,驾驶得分提高了25分,路线完成率提高了24分!

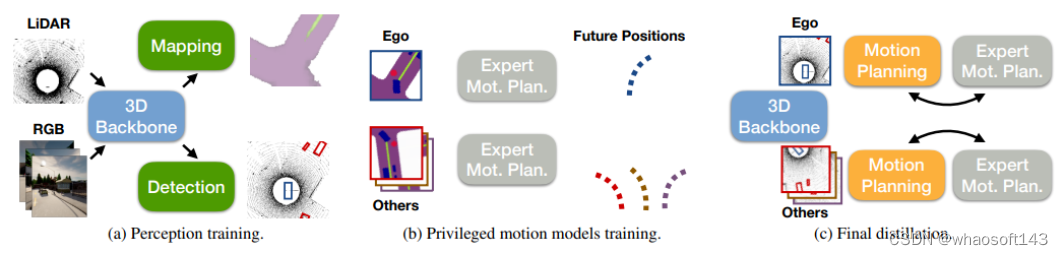

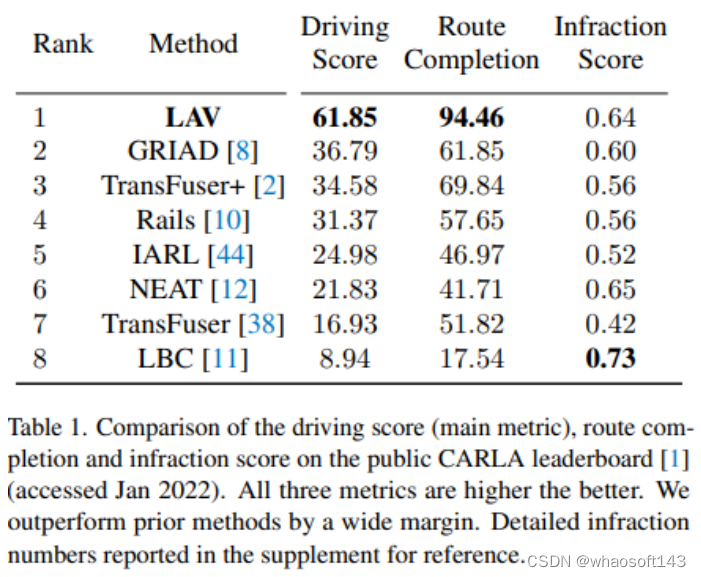

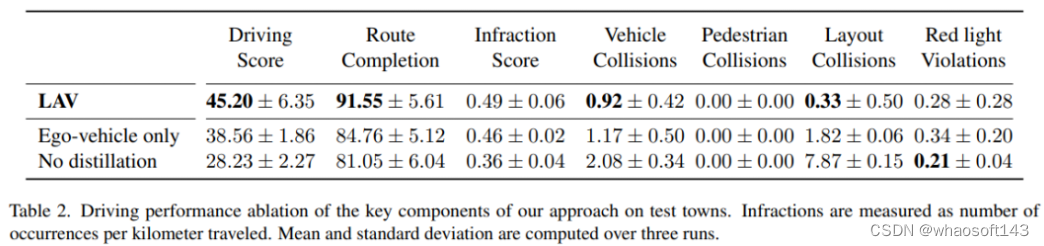

本文的框架,从所有车辆学习(LAV),在一个联合识别、预测和规划堆栈中处理感知和运动的部分可观测性,论文使用特权蒸馏方法将感知和行动的部分可观测性挑战解耦。LAV首先学习感知模型,该感知模型使用来自3D检测和分割任务的辅助监督来输出视点不变表示。根据定义,该辅助任务不区分自我车辆和场景中的其他车辆,因此学习视点不变表示。它处理传感器的部分可观测性,同时,LAV学习特权运动规划器。使用未来的路线点来表示运动计划,而不是预测转向和加速度,这仅适用于自车车辆。使用GT计算机视觉标签作为特权运动规划器的输入,计算机视觉标签确保视点不变,路点提供运动的不变表示。特权运动规划器预测所有附近车辆的轨迹,并推断其高级命令。最后使用特权蒸馏将两个模型结合在一个联合框架中,该最终蒸馏使用感知模型的视点不变视觉特征从所有车辆学习运动预测模型,提取的策略仅从原始传感器输入驱动。论文在CARLA驾驶模拟器中验证了方法,在提交时,在CARLA公共排行榜上排名第一,它获得61.85的驾驶分数和94.46的路线完成率。这两种方法在所有方法中都是最高的,并且大大超过了现有的最先进方法,分别将驾驶分数和路线完成率提高了25和24分。

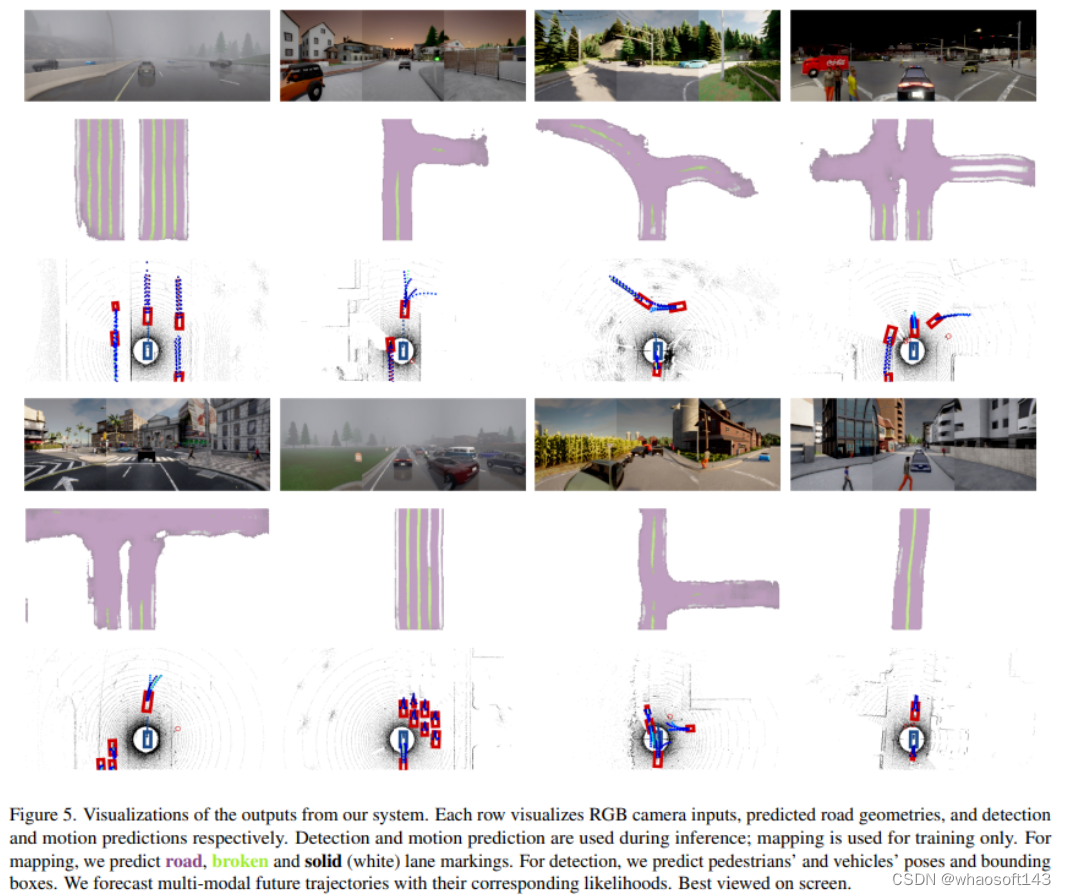

整体框架

训练pipeline,(a) 使用检测和语义映射作为监督信号来训练3D感知模型。这两个任务都有助于学习视点不变的空间表示。检测还可以预测其他车辆的姿态,使用这些姿态来预测它们在推断时的未来轨迹,感知模块产生用于运动规划的车辆独立特征表示。(b) 同时训练一个GT感知的运动规划器,使用附近所有车辆的轨迹对模型进行训练,并使用它们的未来轨迹作为监督。(c) 最后,使用蒸馏将(a)和(b)中学习的模型结合起来,该模型仅使用ego-vehicles传感器输入来学习所有车辆如何以端到端的方式进行规划。

训练pipeline,(a) 使用检测和语义映射作为监督信号来训练3D感知模型。这两个任务都有助于学习视点不变的空间表示。检测还可以预测其他车辆的姿态,使用这些姿态来预测它们在推断时的未来轨迹,感知模块产生用于运动规划的车辆独立特征表示。(b) 同时训练一个GT感知的运动规划器,使用附近所有车辆的轨迹对模型进行训练,并使用它们的未来轨迹作为监督。(c) 最后,使用蒸馏将(a)和(b)中学习的模型结合起来,该模型仅使用ego-vehicles传感器输入来学习所有车辆如何以端到端的方式进行规划。

实 验

实 验

COOPERNAUT:端到端

驾驶与网络车辆的协助感知

论文名称:COOPERNAUT: End-to-End Driving with Cooperative Perception for Networked Vehicles

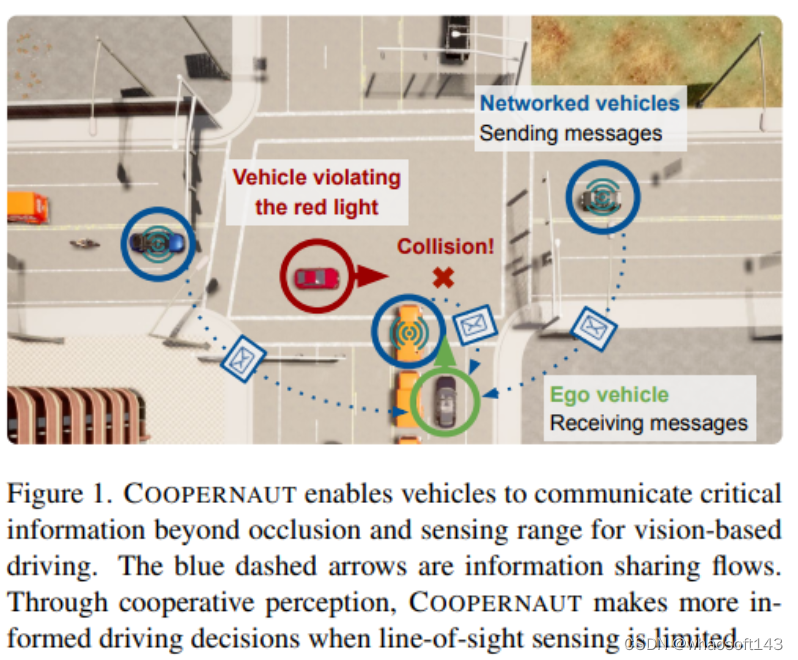

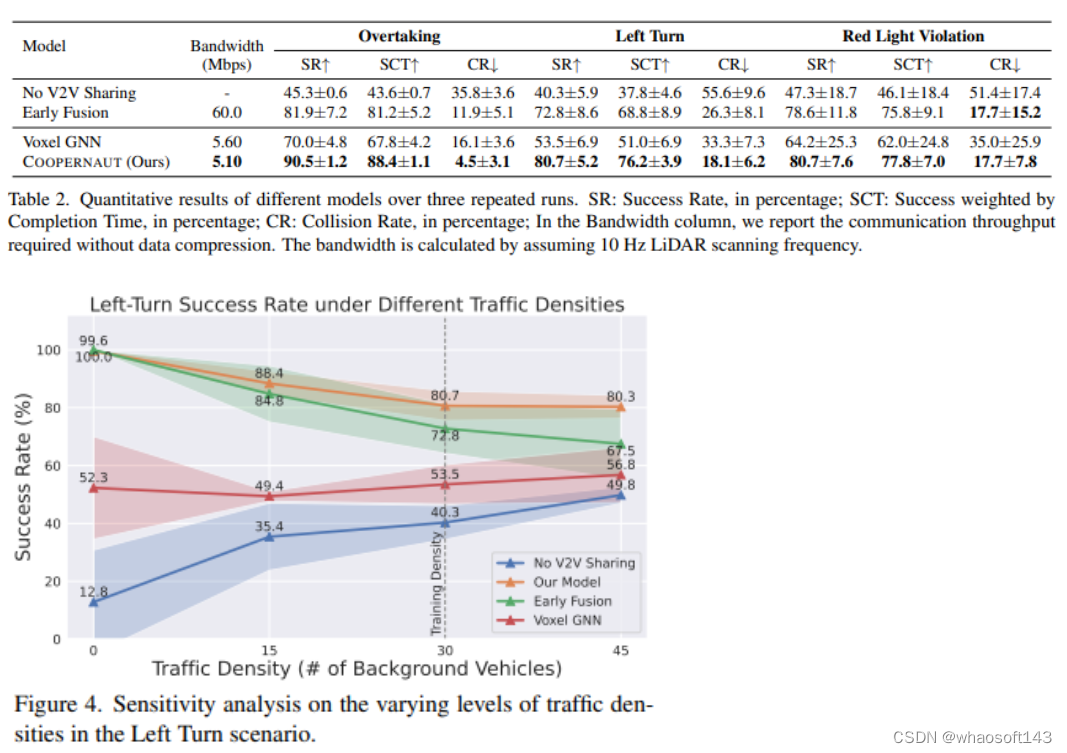

用于自动驾驶汽车的光学传感器和学习算法在过去几年中取得了巨大的进步。尽管如此,当今自动驾驶汽车的可靠性受到视线感知能力有限和数据驱动方法在处理极端情况时的脆弱性的阻碍。随着电信技术的最新发展,与车对车通信的协作感知已成为在危险或紧急情况下增强自动驾驶的一个有前途的范例。本文介绍了COOPERNAUT,这是一种端到端的学习模型,它使用跨车辆感知进行基于视觉的协作驾驶。模型将LiDAR信息编码为紧凑的基于点的表示,可以通过真实的无线信道在车辆之间作为消息传输。为了评估模型,作者开发了AUTOCASTSIM,这是一个网络增强的驾驶模拟框架,具有示例事故多发场景。在AUTOCASTSIM上的实验表明,提出的协作感知驾驶模型在这些具有挑战性的驾驶情况下比以egocentric驾驶模型平均成功率提高了40%,带宽需求比先前的V2VNet小5倍!!!

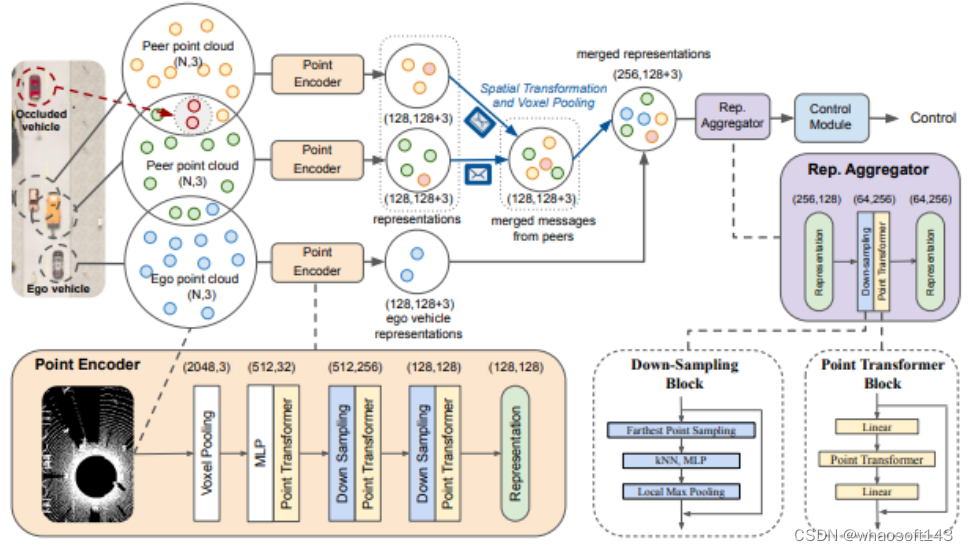

模型结构

模型结构

COOPERNAUT是用于联网车辆的端到端基于视觉的驾驶模型。它包含一个用于本地提取关键信息以供共享的点编码器,一个用于合并多车辆消息的表示聚合器,以及一个用于推理联合消息的控制模块。编码器产生的每个消息具有128个关键点坐标及其相关特征,然后,信息在空间上转化为ego框架。自我载体通过体素最大池化合并传入消息并计算聚合表示。最后,聚合器合成来自ego 车辆及其所有邻居的联合表示,然后将其传递给控制模块以产生控制决策,括号中的数字表示数据维度。

实 验

实 验

论文首先讨论评估方法和实验设置,然后简要概述基线,接下来将根据基线给出本文方法的主要定量评估结果。最后,提供了进一步的分析和可视化,以了解学习的模型质量!

端到端自动驾驶的轨迹引导控制预测

端到端自动驾驶的轨迹引导控制预测

一个简单但强大的基线

论文名称:Trajectory-guided Control Prediction for End-to-end Autonomous Driving: A Simple yet Strong Baseline(NIPS2022)

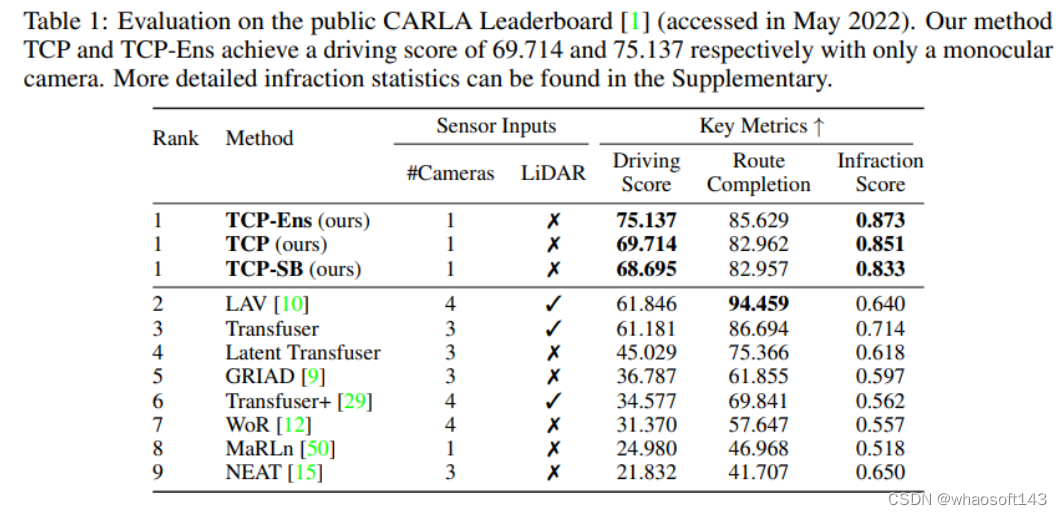

当前的端到端自动驾驶方法要么基于计划的轨迹运行控制器,要么直接执行控制预测,这已经跨越了两个单独研究的研究领域。鉴于它们彼此潜在的互惠互利,本文主动探索这两个的结合。具体来说,论文的综合方法有两个分支,分别用于轨迹规划和直接控制。轨迹分支预测未来轨迹,而控制分支涉及一种新颖的多步预测方案,从而可以推断当前动作和未来状态之间的关系。这两个分支被连接,使得控制分支在每个时间步从轨迹分支接收相应的引导,然后将两个分支的输出融合以实现互补优势。使用CARLA模拟器在具有挑战性场景的闭环城市驾驶环境中评估结果,即使使用单目相机输入,所提出的方法在官方CARLA排行榜上排名第一,以大幅度超过其他具有多传感器或融合机制的复杂候选方法!

代码:https://github.com/OpenPerceptionX/TCP

利用来自两个分支的预测轨迹和控制信号,作者提出了一种基于情况的融合方案,根据实验结果和先验知识,以自集成的方式自适应地组合这两种形式,以形成最终输出。它结合了这两种形式中的最佳形式,从而进一步提高了不同场景下的性能。当在CARLA驾驶模拟器中进行验证时,TCP显示出优异的性能,论文的方法仅使用单目摄像头,驾驶成绩达到75.137分,在公共CARLA排行榜上排名第一,甚至超过了使用多个摄像头和激光雷达的现有最先进方法13.291分。本文的主要贡献包括:

1.研究了端到端自动驾驶的两种主要模式:轨迹规划和直接控制,并建议将它们结合在一个集成的学习pipelines中,这是第一次联合学习和融合这两个分支进行预测。

2.设计了具有时间模块和轨迹引导注意力的多步骤控制预测分支,以实现时间推理,为了结合两个分支的优点,作者设计了一个基于情境的方案来融合两个输出。

3.作为一个简单但强大的基线,本文的方法仅使用单目摄像头作为输入,在CARLA排行榜上实现了新的最先进水平,许多竞争对手使用了多个传感器。作者进行了充分的消融研究,以验证方法的有效性。

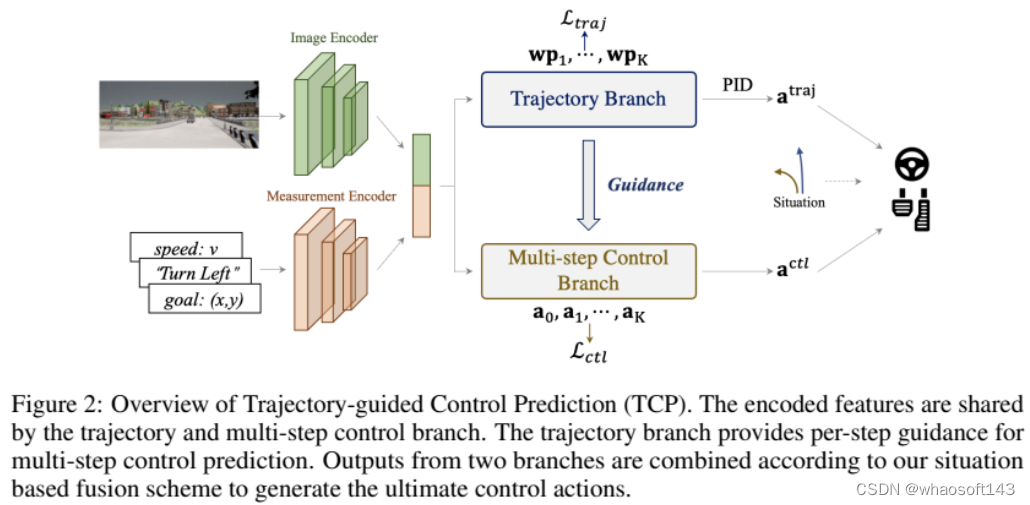

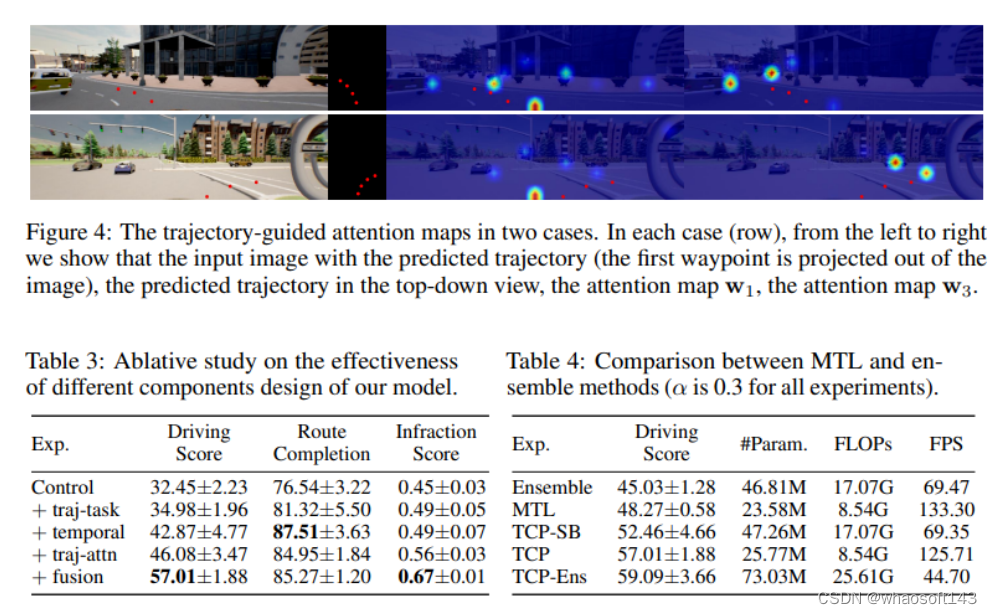

整体框架

轨迹制导控制预测(TCP)概述,轨迹和多步控制分支共享编码特征。轨迹分支为多步控制预测提供每步指导,两个分支的输出根据基于情况的融合方案进行组合,以生成最终的控制动作。

概述如图2所示,整个架构由输入编码级和两个后续分支组成。输入图像i经过基于CNN的图像编码器,例如ResNet,以生成特征图F。同时,导航信息g与当前速度v连接以形成测量输入m,然后基于MLP的测量编码器将m作为其输入并输出测量特征jm。编码的特征然后由两个分支共享,用于后续的轨迹和控制预测。具体而言,控制分支是一种新颖的多步预测设计,具有轨迹分支的指导。最后,采用基于情境的融合方案来结合两种输出范式中的最佳。

实 验

实 验

为了评估我们的方法,我们使用 Kinect Azure 构建了一个真实世界数据集,并获取了 ground truth 深度。因为这种深度相机功耗较

本文的方法在CARLA驾驶模拟器中进行了验证和测试,给定由一系列稀疏导航点以及高级命令(直行、左转/右转、变道和车道跟随)定义的路线,闭环驾驶任务要求自动驾驶者朝着目的地行驶。它旨在模拟现实的交通状况,包括不同的挑战场景,如避障、穿越无信号交叉口和突然失去控制。有三个主要指标:驾驶得分、路线完成和违规得分。Route Completion是自治代理完成的路由的百分比,违规分数衡量道路沿线的违规次数,包括行人、车辆、道路布局、红灯等。驾驶分数是主要指标,是路线完成和违规分数的乘积。

数据集:使用随机天气条件下随机生成的路线,在CARLA模拟器提供的8个公共城镇中收集420K个数据。在8个城镇(Town01、Town03、Town04和Town06)中的4个城镇中训练了189K数据的TCP,以进行消融,并使用所有420K数据进行训练,以提交在线排行榜。

公共CARLA排行榜评估,本文的方法TCP和TCP Ens仅使用单目相机就分别获得了69.714和75.137的驾驶分数。

高,所以噪声会减少,深度质量也会比手机的 ToF 模块好得多。在将手机和 Azure Kinect 固定在一个联合安装座上后,将手机的 ToF 模块和超广角相机分别与Kinect深度相机进行标定。一旦标定完成,就可以将Kinect深度图重新投影到超广角相机和手机 ToF 相机进行比较。我们捕获了 4 个场景,总共 200 张快照。

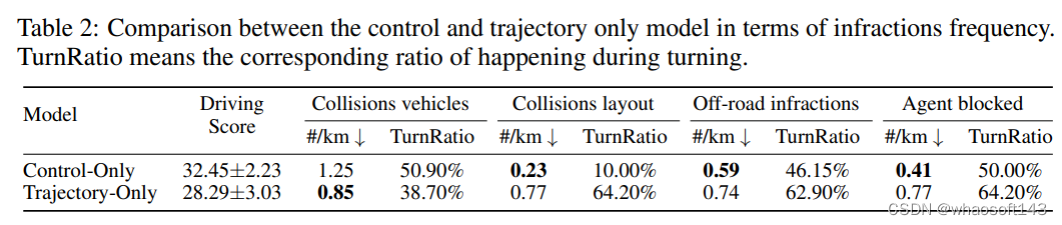

在违规频率方面,控制和仅轨迹模型之间的比较,TurnRatio是指转弯过程中发生的相应比率。

在违规频率方面,控制和仅轨迹模型之间的比较,TurnRatio是指转弯过程中发生的相应比率。

whaosoft aiot http://143ai.com

#关键技术与发展趋势

随着以ChatGPT为代表的生成式人工智能的发展,端到端自动驾驶系统得到了广泛关注,有望为通用场景的驾驶智能带来革命性突破。以全部模块神经网络化为特征的端到端系统对专家规则的依赖度低,功能的集约性与实时性强,具备智能涌现能力和跨场景应用潜力,是实现数据驱动自进化驾驶能力的重要途径。

近期,来自于清华大学的李升波等学者的论文,讨论了端到端汽车自动驾驶系统的关键技术与发展趋势。论文介绍了生成式人工智能的技术现状,总结了端到端自动驾驶的关键技术,归纳了该类自动驾驶系统的发展现状,并总结了生成式人工智能与自动驾驶融合发展的技术挑战。

论文地址:

https://aiview.cbpt.cnki.net/WKD/WebPublication/paperDigest.aspx?paperID=60ba64c1-3dee-4986-bed9-f86b98006872

下载链接:

https://kns.cnki.net/kcms/detail/detail.aspx?filename=DKJS202305001&dbname=cjfdtotal&dbcode=CJFD&v=MjMyODFTYkJmYkc0SE5MTXFvOUZaWVI2RGc4L3poWVU3enNPVDNpUXJSY3pGckNVUjdtZVplWnJGeXJsVjd2Skk=

1 生成式人工智能的技术现状

数据、算力和算法是大模型发展的支柱,其中算法是大模型的核心技术体现。现有大模型多以Transformer结构为基础,采用“预训练(Pre-training)+微调(Fine-tune)”技术进行参数学习,使之适配不同领域的具体任务,经剪枝压缩后完成最终部署。本节将围绕网络架构、预训练、微调和剪枝压缩四个方面对大模型关键技术进行介绍。

1.1 神经网络的架构设计

大模型的出现得益于深度学习浪潮中深度神经网络的发展。深层网络的学习建模能力更强,有利于模型的性能提升。

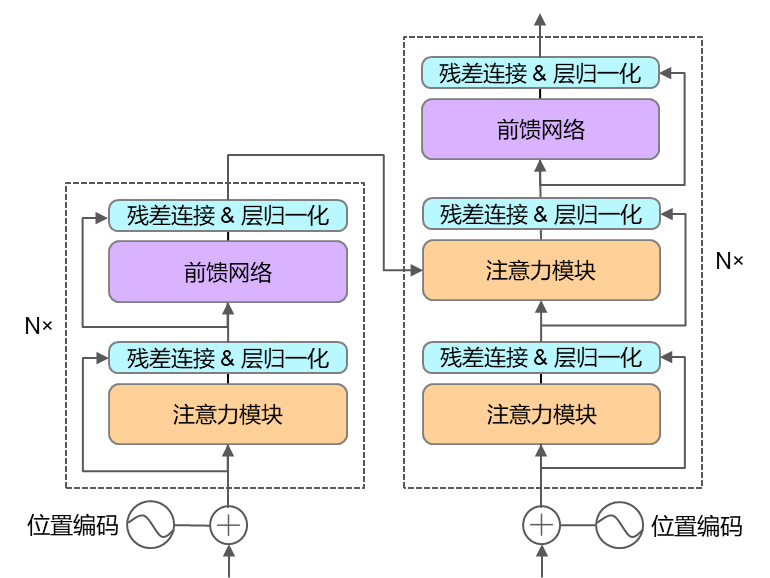

在2017年,Google提出了神经网络结构Transformer(图1),大幅提升了网络表达能力,在CV、NLP等多个领域大放异彩,Transformer现已成为大模型的基础网络结构之一。Transformer是以注意力机制为核心的编解码器结构,其主要结构为注意力、位置编码、残差连接、层归一化模块。Transformer被广泛应用于NLP、CV、RL等领域的大模型中。

图1 Transformer网络结构

1.2 预训练与微调技术

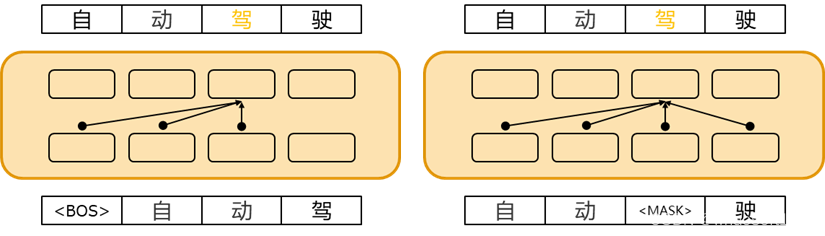

预训练是使大模型获得通用知识并加速模型在微调阶段收敛的关键步骤。根据序列建模的方式,语言模型可以分为自回归语言模型和自编码语言模型(图2)。自回归语言模型使用Transformer的解码器结构,根据前文预测下一个词,从而对序列的联合概率进行单向建模。自编码语言模型则利用Transformer的编码器结构,通过预测序列中的某个词来双向建模序列的联合概率。

图2两类语言模型示意图

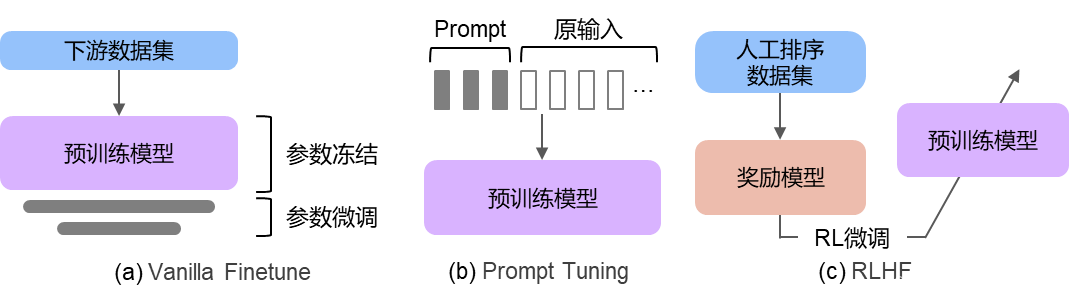

微调是指将预训练好的大模型在下游任务中进行调整,使之与具体任务更加适配。微调后的大模型与预训练大模型相比,在下游任务中性能通常大幅提升。随着模型规模不断增大,微调所有参数变得十分困难,因此近年来出现了多种高效微调方法,包括Vanilla Finetune、Prompt Tuning以及Reinforcement Learning from Human Feedback(RLHF)等方法(图3)。

图3 三种微调方法示意图

1.3 模型的剪枝与压缩

训练好的大模型需要部署在算力和内存受限的系统上,因此需要对大模型进行剪枝和压缩,减小模型中的冗余结构和信息,使其能在受限的计算资源上进行快速推理,同时尽量减小对模型精度的影响。大模型的压缩方法主要包括模型剪枝、知识蒸馏和量化。

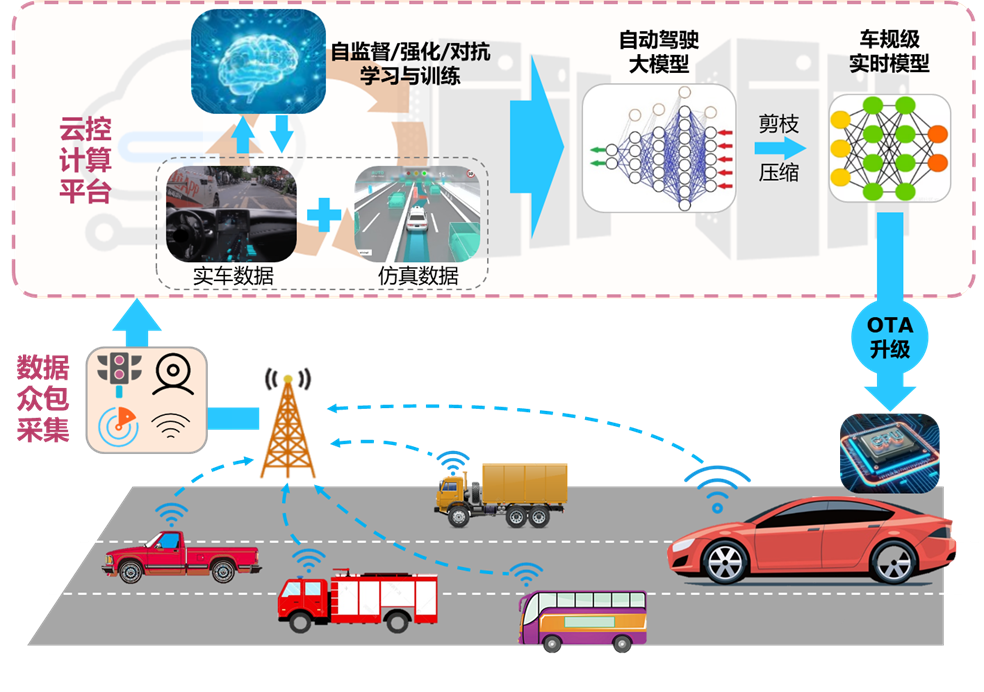

2 端到端自动驾驶的关键技术

人工智能技术与自动驾驶技术的融合,关键在于打通以车云协同为核心的边缘场景数据采集和自动驾驶模型训练的在线循环迭代路径。图4展示了车云协同的自动驾驶大模型开发方案:由一定规模具有网联功能的车辆进行众包数据采集,数据清洗和筛选之后上传至云控计算平台;利用云控平台的充足算力,生成海量仿真驾驶数据;融合虚实数据进行场景构建,利用自监督学习、强化学习、对抗学习等方法对自动驾驶大模型进行在线迭代优化;所学大模型经剪枝压缩后得到车规级实时模型,并通过OTA方式下载到车载芯片,完成车端驾驶策略的自进化学习。

图4 车云协同的自动驾驶大模型开发方案

具体研究内容包括:(1)面向自动驾驶的大模型基础理论;(2)自动驾驶感知认知通用基础大模型;(3)自动驾驶决策控制通用基础大模型;(4)自动驾驶大数据采集生成与自动标注;(5)车云协同的基础大模型持续进化;(6)自主可控的车用集成部署工具链与平台。

3 端到端自动驾驶的技术发展趋势

随着大模型技术的不断发展,以ChatGPT为代表的大模型技术展现出令人惊叹的效果。大模型已在多项工业实践中得到初步应用中,有望成为实体经济新的增长引擎。

3.1 感知大模型

自动驾驶的感知模块利用传感器采集的数据,实时动态地生成驾驶环境的感知结果。感知大模型是提升车辆自动驾驶能力的核心驱动力之一,这些模型能识别和理解道路、交通标志、行人、车辆等信息,为自动驾驶车辆提供环境感知,继而用于车辆自主决策。

目前在自动驾驶感知方面已有相关应用,例如百度文心UFO 2.0视觉大模型、华为盘古CV以及商汤的INTERN大模型等。

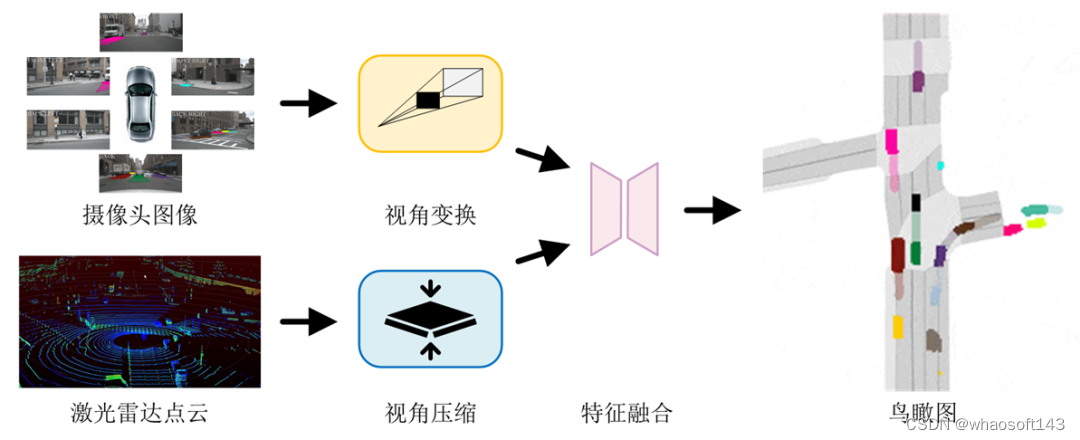

鸟瞰图感知(Bird's Eye View,BEV)是当前主流感知方案之一,它将摄像头、雷达等多源传感器的感知信息转换至鸟瞰视角,并行地完成目标检测、图像分割、跟踪和预测等多项感知任务,如图5所示。典型工作如特斯拉的BEV感知,百度的UniBEV和商汤的FastBEV。

图5 鸟瞰图感知流程

3.2 预测大模型

预测是自动驾驶的关键组成部分,它主要涉及对周边交通参与者未来运动状态的预测,也称为轨迹预测。轨迹预测综合考虑道路结构、历史轨迹以及与其他交通参与者的交互关系等信息,输出一条或多条未来可能行驶的轨迹,供下游决策控制任务参考。数据驱动型的轨迹预测方法通常采用编码-解码架构,包括信息表示、场景编码和多模态解码等主要环节。代表工作包括谷歌Wayformer、清华SEPT和毫末智行DriveGPT等。

3.3 决控大模型

自主决策与运动控制是自动驾驶的核心功能,决策与控制水平的高低决定了自动驾驶汽车的智能程度。自动驾驶决控系统的技术方案主要经过了三个发展阶段:专家规则型、模仿学习型以及类脑学习型。自动驾驶决策控制大模型的目标是构建以深度学习与强化学习为代表、数据驱动与知识引导相结合的决策控制通用基础模型训练算法,为自动驾驶智能性突破提供解决方案。

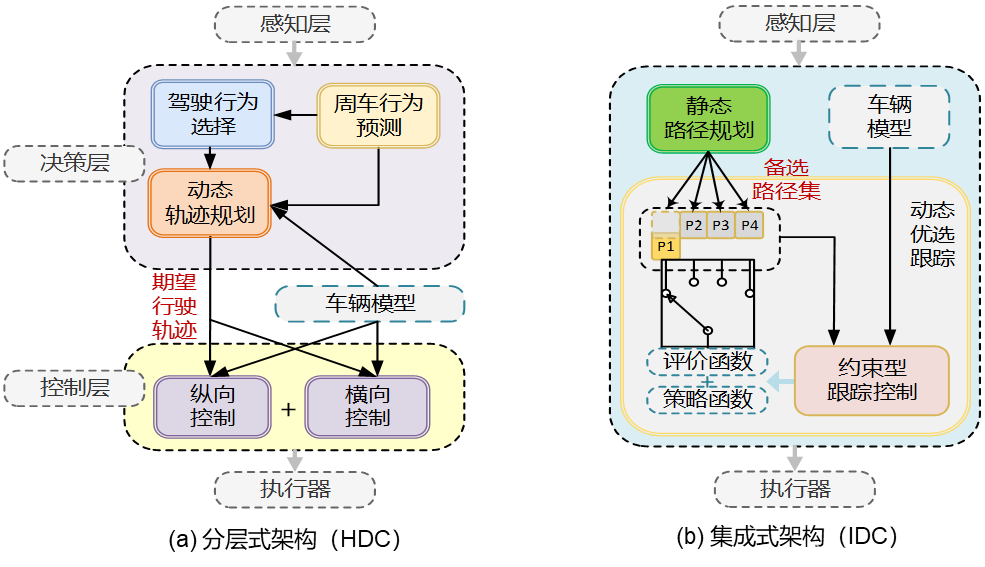

目前工业界尚缺乏用于自动驾驶的决策与控制一体化大模型。由清华大学提出的集成式架构(IDC)将决策与控制整合为统一的约束型最优控制问题,利用数据驱动算法求解评价模型与策略模型,它以环境感知结果为输入,直接输出油门、制动、转向等控制指令。IDC 具有在线计算效率高、可解释性强、无需人工标注数据、可自回归地预测下一个动作等优点,为大模型应用于自动驾驶决控奠定了基础。图6为传统专家分层式和集成式决控架构示意图。

图6 两种决控架构示意图

3.4 端到端训练的自动驾驶模型

端到端的自动驾驶方案将输入的原始传感器数据直接映射输出为轨迹点或低级控制命令,与分层式架构相比,其具有简洁的方案结构与巨大的性能潜力。端到端方案的工业应用面临着数据短缺、学习效率低下和鲁棒性差等问题,尤其无法保障任何极端情况下模型输出的安全性,这将成为其应用于自动驾驶领域的最大挑战。代表工作有上海人工智能实验室的UniAD和特斯拉FSD Beta V12。

随着算力发展与大模型技术的兴起,端到端的自动驾驶将为行业带来新的突破。针对端到端方案,不断降低其技术门槛、进行可解释性研究、以及提出更多保障端到端自动驾驶安全的算法,将是未来热门的研究方向。

4 总结

以大模型为代表的生成式人工智能是智能网联汽车发展的战略前瞻方向。这需要进一步突破:适用于驾驶大数据的大模型预训练方法和学习理论;泛场景、泛对象、跨模态适用的感知认知和决策控制通用基础模型;仿真环境数据与真实场景数据结合的大规模数据采集与标注系统;车云协同的基础大模型持续进化技术与车用集成部署工具链与平台等。以上技术的攻关将打通以车云协同为核心的驾驶大数据和自动驾驶大模型算法在线循环迭代路径,推动端到端自动驾驶技术在全场景的落地应用。