- 1NoSQL数据库全方面概述_nosql与云计算紧密融合对吗

- 2WebView通过网络请求加载html_qwebview必须要联网才能读取html文件吗

- 3一篇文档教会你使用truffle合约测试(迁移脚本和测试脚本)

- 4transformer、tokenizer在大语言模型LLM中的作用和示例代码_transformer tokenizer

- 5【LoRa模块】关键参数记录_lora rssi 值 多少到多少

- 6低代码平台的坑有哪些?_低代码平台开发过程中的问题

- 7前端导出文件详细方法_前端get请求 导出文件

- 8测试用例方法---场景法(黑盒)_测试对象:ic卡加油机应用系统 描述:软件系统几乎都是用事件触发来控制流程的,事件

- 9【建议收藏】Android面试必备:掌握常见题型和答题技巧_安卓开发面试问题回答技巧

- 10Java中的测试驱动开发(TDD)实践

本地部署chatGLM3-6b教程_chatglm3-6b本地部署

赞

踩

之前一直用的chatGLM2,将FastGPT本地化跑通后,现在试试将chatGLM2升级为chatGLM3。升级就比较顺利了,过程如下,该过程参考了哔哩哔哩网站的一个视频。连接如下:

23 本地化部署ChatGLM3-6B模型_哔哩哔哩_bilibili

21 OpenAI风格API调用_哔哩哔哩_bilibili

1、用conda建立虚拟环境

conda create --name chatglm3_multi python-3.11

切换到虚拟环境:

conda activate chatglm3_multi

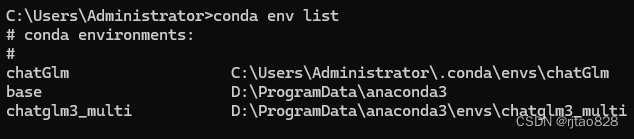

可以使用conda env list查看已经创建的虚拟环境:

2、pytorch-GPU版本安装

Previous PyTorch Versions | PyTorch

安装命令(根据自己电脑的cuda版本进行选择):

conda install pytorch==2.2.2 torchvision==0.17.2 torchaudio==2.2.2 pytorch-cuda=12.1 -c pytorch -c nvidia

测试是否安装成功:

在python解释器下运行:

- import torch

-

- print(torch.cuda.is_available())

如果是Ture则安装成功。

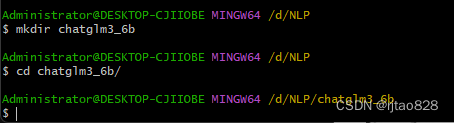

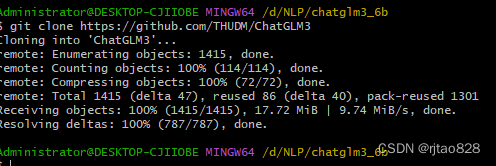

3、克隆项目文件

打开git bash

git clone https://github.com/THUDM/ChatGLM3

更新pip工具

python -m pip install --upgrade pip

用conda那个终端切换到项目文件:

cd D:\NLP\chatglm3_6b\ChatGLM3

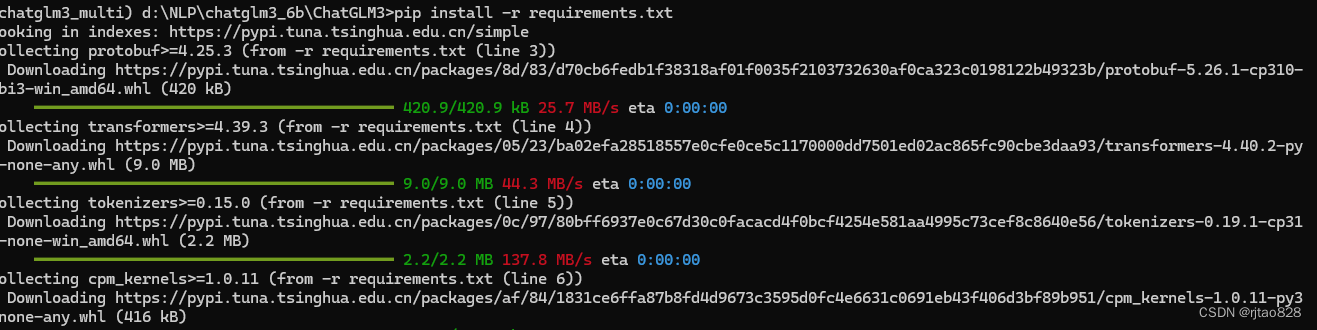

安装依赖:

pip install -r requirements.txt

4、下载模型

chatglm3-6b · 模型库 (modelscope.cn)

首先安装下载工具:

pip install modelscope

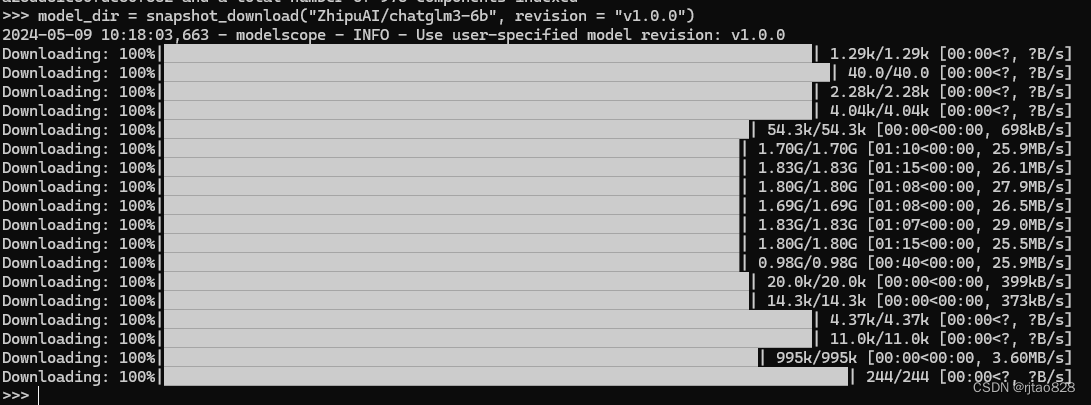

在终端中进入python命令行。输入:

from modelscope import snapshot_download

model_dir = snapshot_download("ZhipuAI/chatglm3-6b", revision = "v1.0.0")

下载完毕:

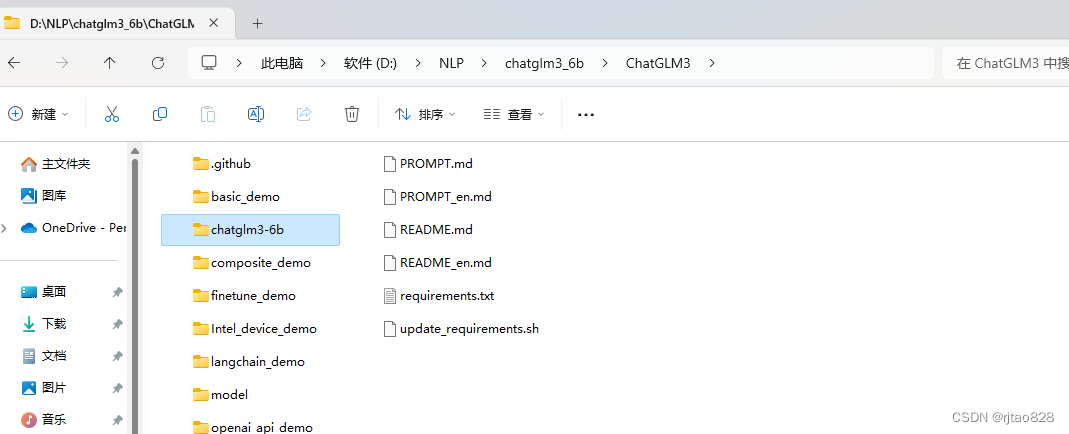

模型会默认下载到(windows):

C:\Users\Administrator.cache\modelscope\hub\ZhipuAI

复制到项目文件中去:

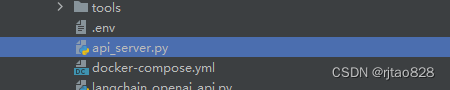

5、启动openai-api

运行api_server.py

会报错:

OSError: We couldn't connect to 'https://huggingface.co' to load this file,

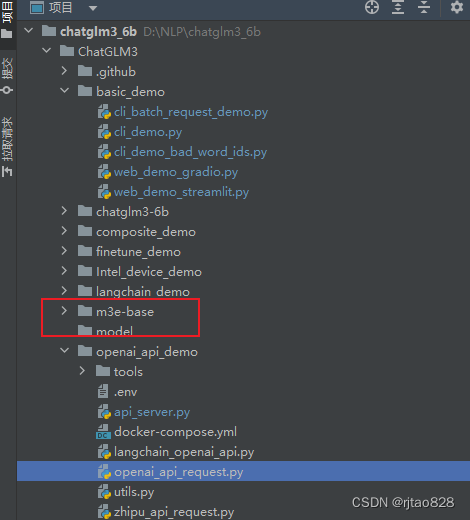

无法连接到hf中的词嵌入模型,需要在本地部署M3E模型。

到modelscore去下载模型,网址如下:

M3E Models · 模型库 (modelscope.cn)

参考网页介绍下载,到本地去找到模型,复制到项目文件:

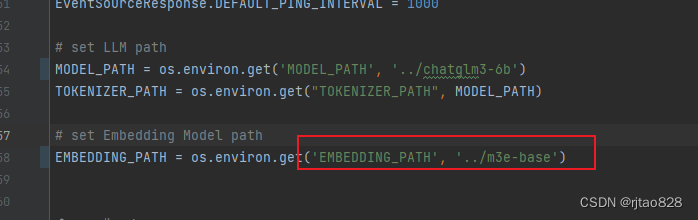

修改词嵌入路径为本地:

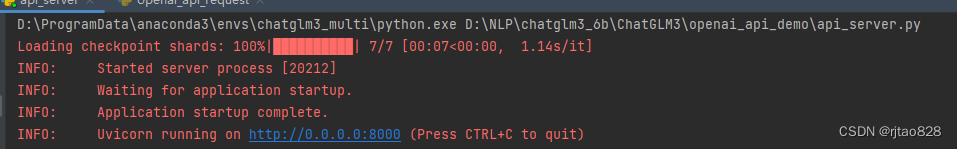

再次运行:

成功启动

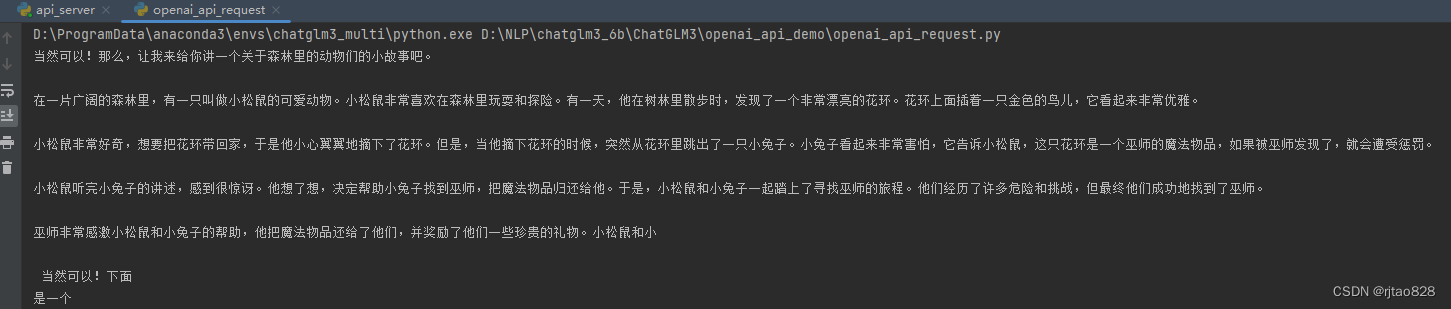

再运行测试接口:

正常访问

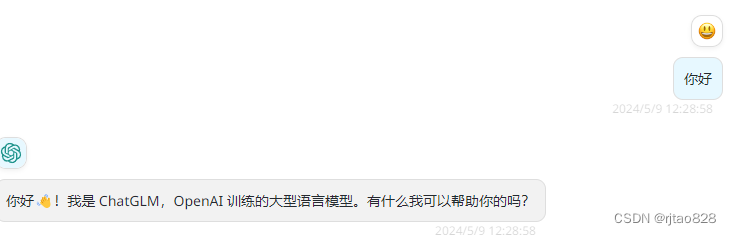

用NextChat试试:

完全没有问题。