热门标签

热门文章

- 1点云补全综述 Comprehensive Review of Deep Learning-Based 3D Point Clouds Completion Processing and Analys

- 2tiktok日本版iOS免拔卡国内可用(2024年最新教程)_2024tiktok ipa

- 3程序员、架构师、技术经理、技术总监和CTO有啥区别?_技术领导和架构的区别

- 4华南农业大学Linux课程实验三——Linux中安装并使用telnet服务和ftp服务_实验三 1. 利 ssh客户端远程登录root 户; 2. 参考ppt内容,安装并启动telnet

- 5C++下使用OpenCV实现人脸检测_opencv通过c++及vs实现人脸识别

- 6Helix 按键映射_zelix怎么绑定按键

- 7android drawable-hdpi xhdpi xxhdpi xxxhdpi 的理解

- 8YOLO V5 实现课堂行为检测_yolov5学生课堂行为检测

- 9ubuntu2004自动更新内核导致nvidia驱动无法正常启动的问题

- 10【springboot+vue项目(一)】项目开发流程和技术_如何用springboot与vue快速搭建项目

当前位置: article > 正文

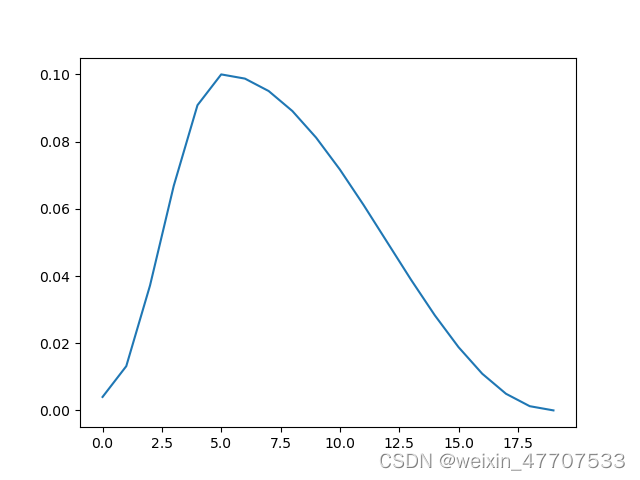

torch.optim.lr_scheduler.OneCycleLR

作者:凡人多烦事01 | 2024-03-28 03:56:02

赞

踩

torch.optim.lr_scheduler.onecyclelr

1.引入库

代码如下(示例):

import matplotlib.pyplot as plt

import os

os.environ['KMP_DUPLICATE_LIB_OK'] = 'TRUE'

- 1

- 2

- 3

2.读入数据

代码如下(示例):

import matplotlib.pyplot as plt import os os.environ['KMP_DUPLICATE_LIB_OK'] = 'TRUE' model = torch.nn.Linear(2, 1) optimizer = torch.optim.SGD(model.parameters(), lr=0.1) scheduler = torch.optim.lr_scheduler.OneCycleLR(optimizer, max_lr=0.1, steps_per_epoch=2, epochs=10) lrs = [] for i in range(20): optimizer.step() lrs.append(optimizer.param_groups[0]["lr"]) # print("Factor = ",i," , Learning Rate = ",optimizer.param_groups[0]["lr"]) scheduler.step() plt.plot(lrs) plt.show()

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/凡人多烦事01/article/detail/328465

推荐阅读

相关标签