热门标签

热门文章

- 1【嵌入式培训】第一天——用CubeMX与MDK实现点灯操作_mdk cubemx

- 2#QT(MP3播放器-部分界面)

- 3【无标题】_java实现上位机

- 4中国AI之父的199人工智能课我帮你们做小白鼠了

- 5OpenCV视频流的C++多线程处理方式_c++ cv::mat 多线程

- 6云计算「半步巅峰」

- 7在vue3中,新的组合式API中没有this,那我们如果需要用到this怎么办?_this.$api在vue3

- 8linux trim raid,CentOS7下组建软Raid磁盘阵列并开启Trim|延长SSD寿命

- 9OCR_文字识别_ocr 'width': 4294967168.0,

- 10Jenkins远程部署Linux服务器_jenkins pipeline 远程传输文件到linux

当前位置: article > 正文

lda 可以处理中文_中文分词(jieba)和语料库制作(gensim)

作者:凡人多烦事01 | 2024-03-21 14:21:58

赞

踩

lda jieba分词

本文的内容为以下两个部分:

- 文本分词(jieba)

- 语料库制作(gensim)

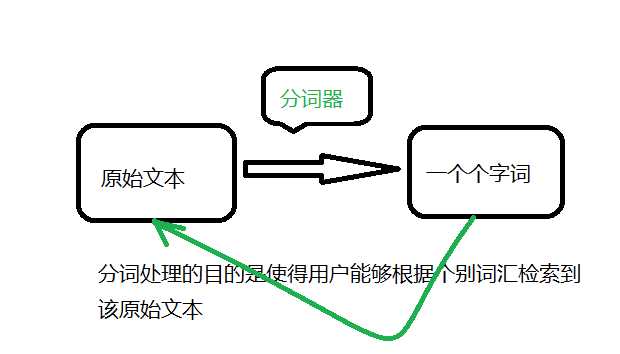

结巴(jieba)分词

在自然语言处理领域中,分词和提取关键词都是对文本处理时通常要进行的步骤。用Python语言对英文文本进行预处理时可选择NLTK库,中文文本预处理可选择jieba库。结巴分词是基于统计的分词方法,它对给出大量已经分词的文本,利用统计机器学习模型学习词语切分的规律(称为训练),从而实现对未知文本的切分。例如最大概率分词方法和最大熵分词方法等。随着大规模语料库的建立,统计机器学习方法的研究和发展,基于统计的中文分词方法渐渐成为了主流方法。

jieba分词的三种模式:

- 精确模式:将句子最精确的分开,适合文本分析

- 全模式:句子中所有可以成词的词语都扫描出来,速度快,不能解决歧义

- 搜索引擎模式:在精确的基础上,对长词再次切分,提高召回

结巴分词的其他特点诸如:支持繁体分词,支持自定义词典,基于Trie树结构实现高效的词图扫描,采用了动态规划查找最大概率路径等特点。

jieba库中分词函数

1、jieba.cut

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/凡人多烦事01/article/detail/281543

推荐阅读

相关标签