- 1macos安装iterm2_mac安装iterm2

- 2基于PaddleOCR的身份证文字识别的实现_身份证数据集

- 3Spring Boot实战:无缝对接通义千问_通义千问 streamcallwithcallback方法怎么返回给前端

- 4Xilinx 7系列SelectIO结构之SelectIO逻辑资源(二)_odelaye2

- 5【AI 大模型】函数调用 Function Calling ② ( Plugins、Actions 扩展 | 函数调用 Function Calling 引入 | 函数调用开发流程 | 代码示例 )

- 6JavaScript中的拷贝技术探秘:浅拷贝与深拷贝的奥秘

- 7AList搭建与使用(Win、Linux云服务器)_alist搭建教程

- 8云计算day04-Docker容器_sudo apt-get install -y nvidia-docker2 sudo pkill (5)_sudo apt install -y nvidia-docker2

- 9Django+Vue+AntDesign搭建的系统后台框架_antdesign 后台框架

- 10基于大模型来构建自己非结构化数据集的问答数据对_大模型数据集构建

基于趋动云快速部署ChatGLM3-6B模型

赞

踩

随着人工智能技术的日趋炽热,自然语言处理领域也渐渐崭露头角。ChatGLM,一款基于Transformer架构的语言模型,彰显了出色的自然语言生成与对话能力。然而,对于众多企业和开发者来说,从零开始训练和部署ChatGLM模型既耗时又费力。

为了迎解这一问题,趋动云提供了快速部署ChatGLM3-6B的服务,使得开发者能够轻松地利用该模型进行应用开发。趋动云,一家基于云计算的人工智能平台,为开发者提供了多元化的AI应用开发工具和服务。

在趋动云上,开发者可以轻松部署ChatGLM3-6B模型,并根据自身需求进行个性化配置。通过趋动云的自动化训练和调优,开发者能获得更出色的模型性能,并能显著缩短开发周期。

以下是趋动云上快速部署ChatGLM3-6B的步骤:

- 注册并登录趋动云平台(通过 DataWhale专属链接注册领取免费算力:https://growthdata.virtaicloud.com/t/vs),创建一个新的AI应用。

- 在AI应用中选择合适的镜像和ChatGLM3-6B预训练模型,运行项目并拉取代码。

- 根据自身需求,进行模型配置和微调代码,最终通过 gradio 或者 streamlit 部署。

通过趋动云的自动化训练和部署流程,开发者能快速获得高性能的ChatGLM3-6B模型,并便捷地进行应用开发和部署。同时,趋动云还提供了丰富的API接口和工具库,使得开发者能更轻松地进行模型调用和控制。基于趋动云快速部署ChatGLM3-6B是一种高效、便捷的解决方案,为需要使用语言模型的开发者提供了强有力的支持。通过趋动云的自动化训练和部署流程,开发者能快速获得高性能的ChatGLM3-6B模型,并方便地进行应用开发和部署。这对于加速自然语言处理领域的发展和应用具有不可忽视的重要意义。

接下来,我们实操一下。

白票普惠算力,项目创建无忧

平台注册:

◦ 注册即送168元算力金

◦ Datawhale专属注册链接:https://growthdata.virtaicloud.com/t/3s

所谓的开服就送浮力,算力羊毛薅不停。群里很多小伙伴也反馈这个浮力真香!按照官网的换算,实打实的 168 软妹币啊!

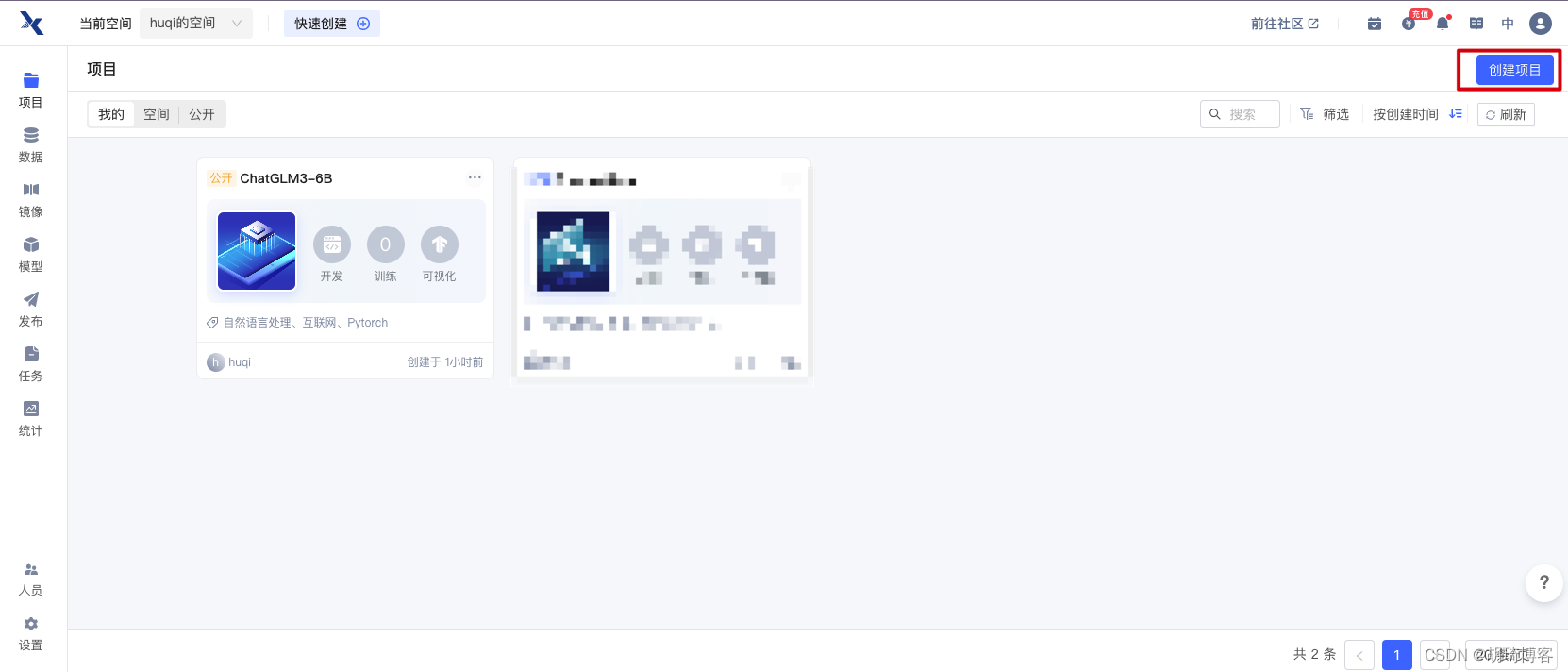

注册好帐号之后,进入带自己的空间,点击右上角【创建项目】进入到项目的新建页。

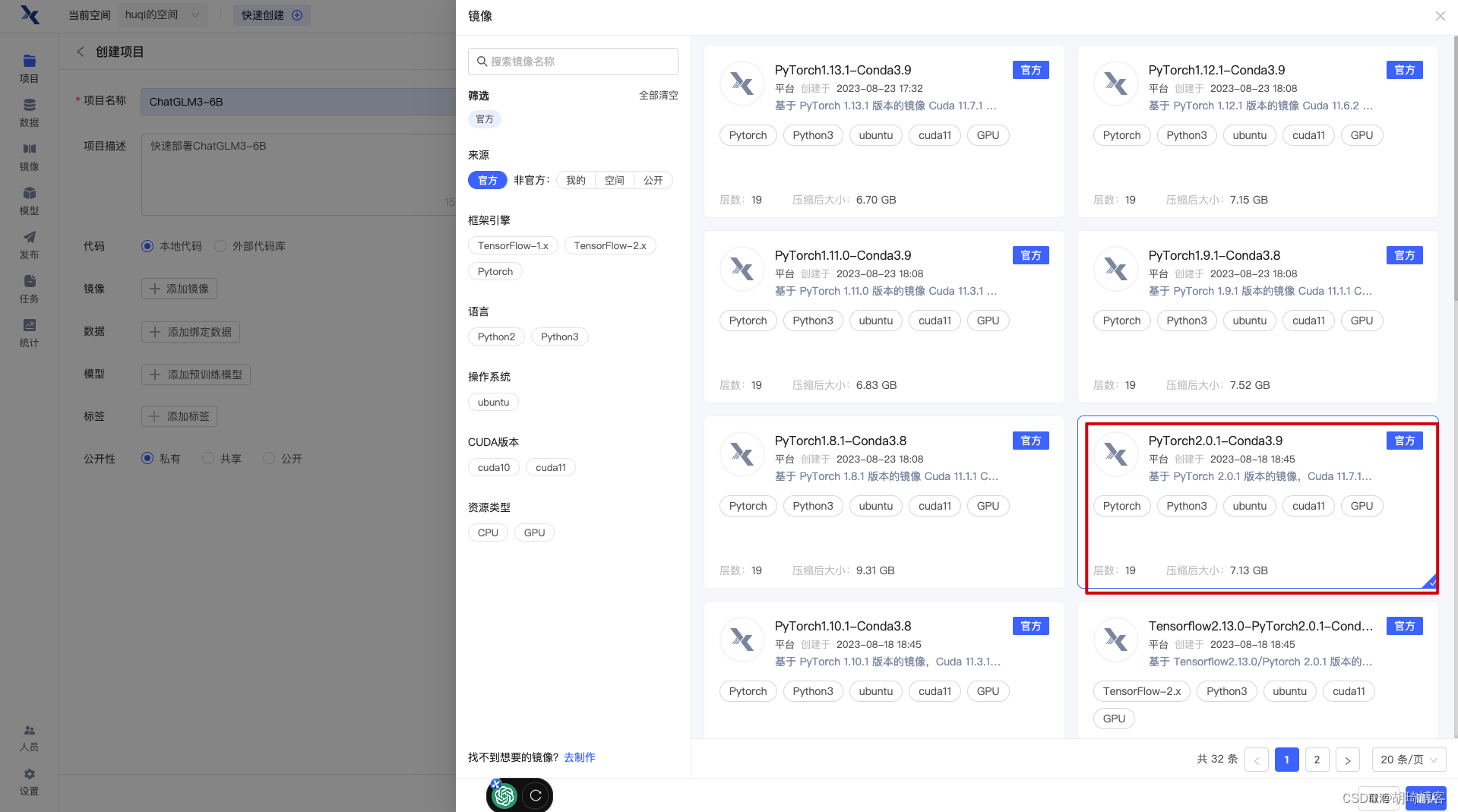

项目名称: ChatGLM3-6B (或者您想要的名字)

项目描述:快速部署ChatGLM3-6B (可为空)

代码: 选择本地代码

镜像: 选择官方的PyTorch2.0.1-Conda3.9

数据: 可为空

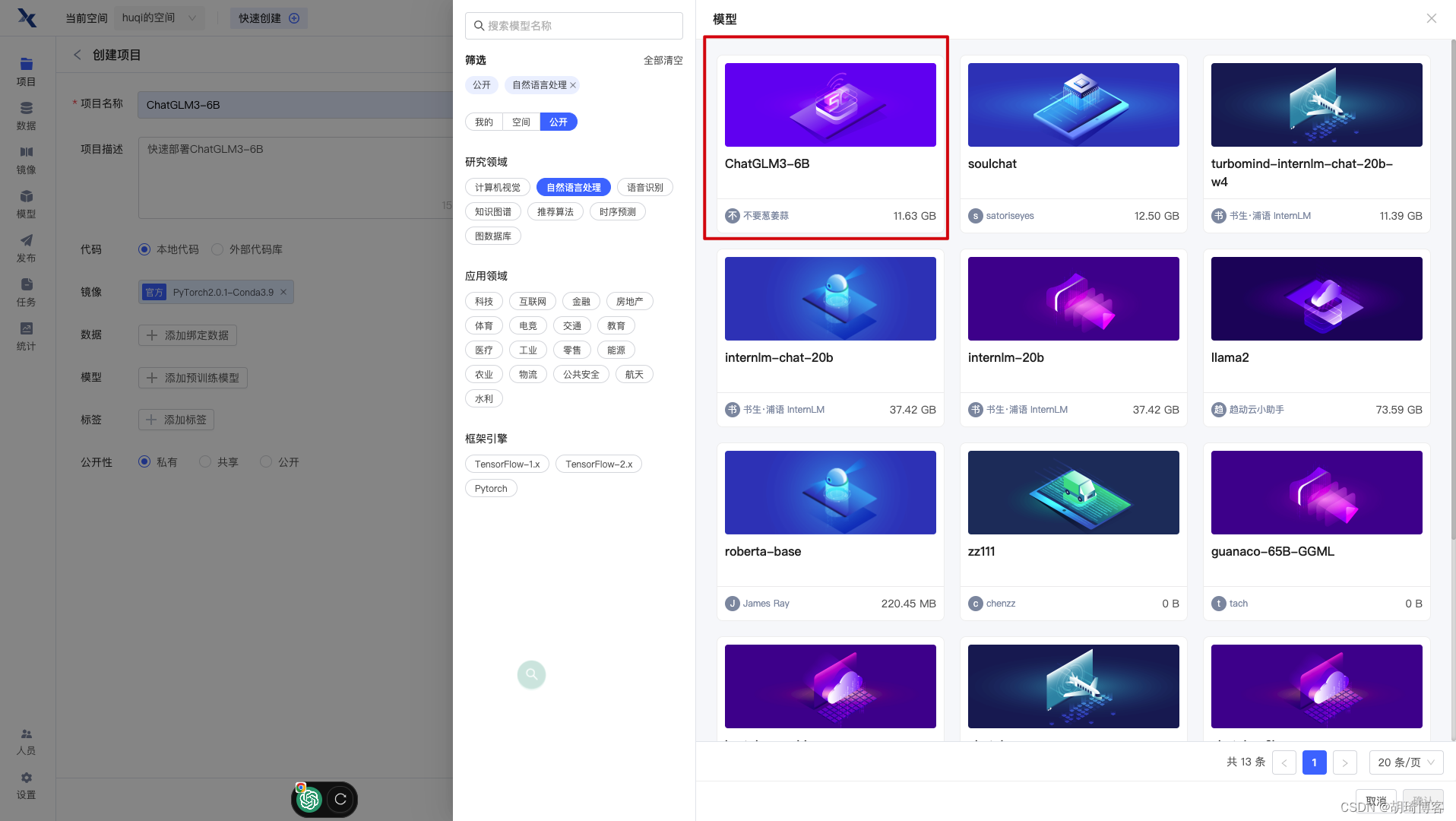

模型: 选择不加葱姜蒜大大的 ChatGLM3-6B

标签: 可为空,推荐选择 自然语言处理 互联网 Pytorch

公开性: 按需选择,如果是开放的推荐选择公开

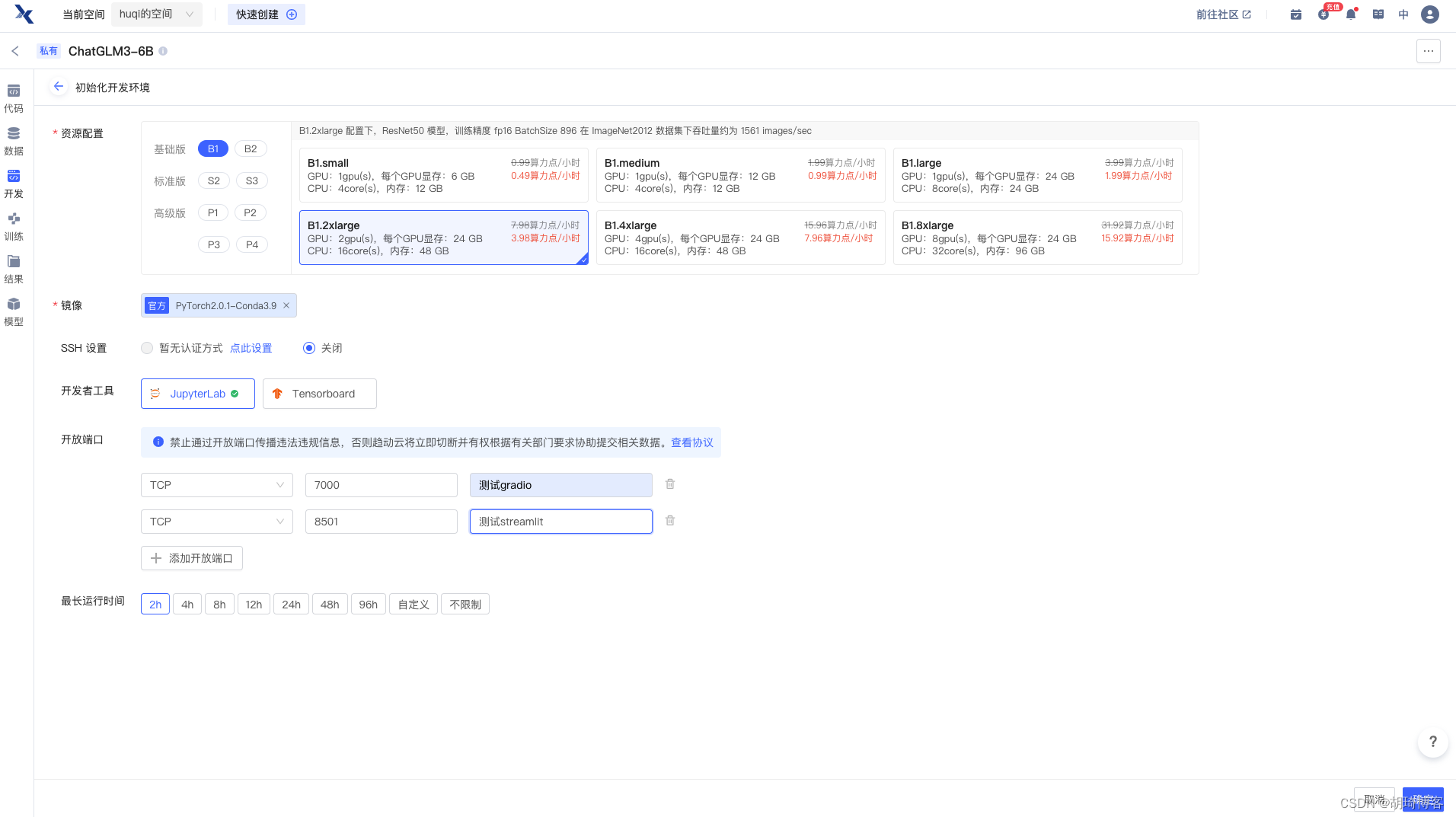

配置好项目之后,点击左下角的【创建】按钮,弹出上传代码的弹窗,我们点击【暂不上传】,接着点击右上角的【运行代码】,这里的操作其实是为了选择运行环境所需的算力。

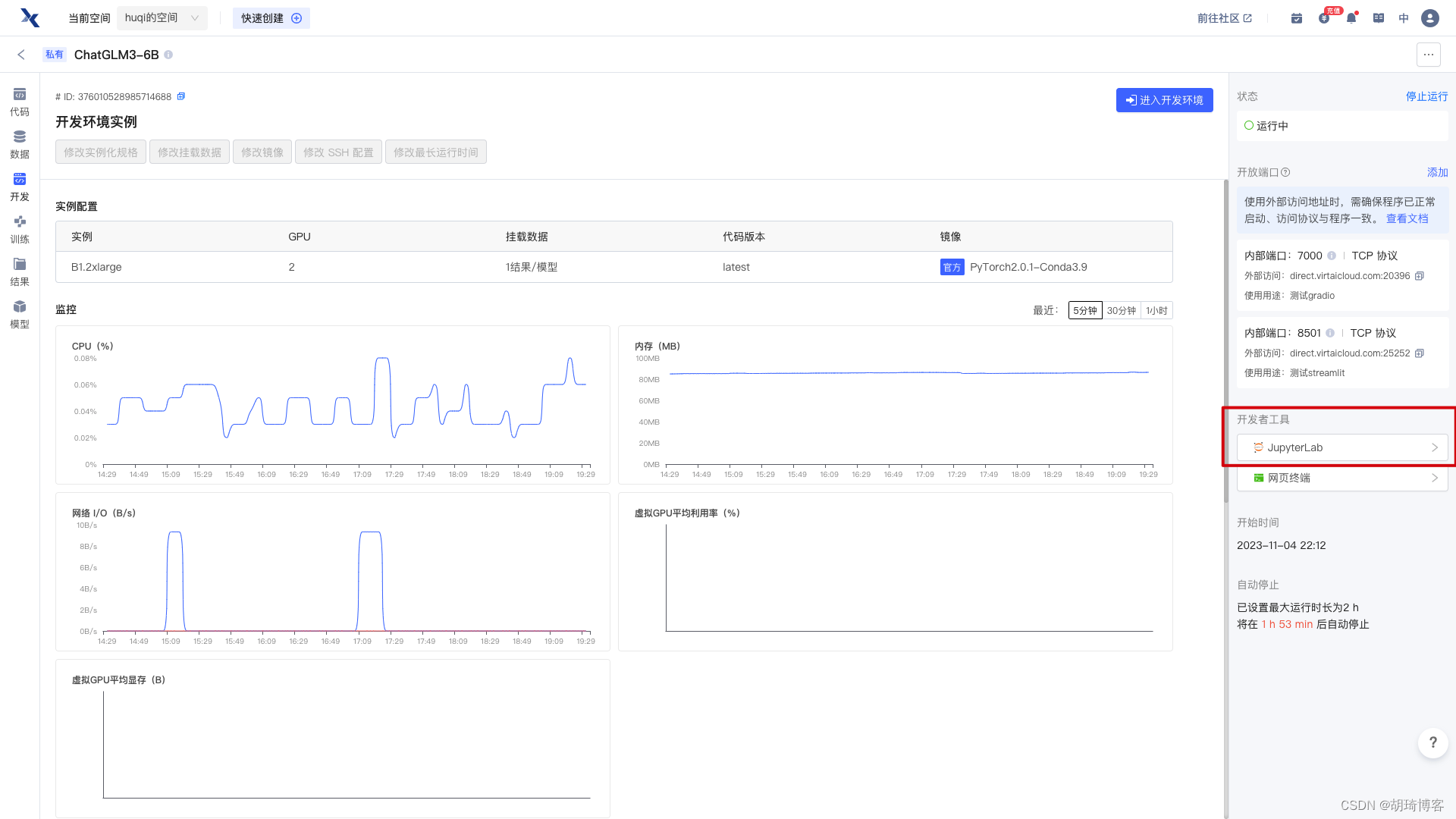

资源配置: B1.2xlarge

镜像:官方PyTorch2.0.1-Conda3.9

SSH 设置: 默认关闭

开发者工具:JupyterLab

开放端口: TCP 7000 测试gradio

TCP 8501 测试streamlit

最长运行时间: 2h

点击右下角【确定】按钮之后,等待环境创建完毕即可点击右侧【开发者工具-JupyterLab】

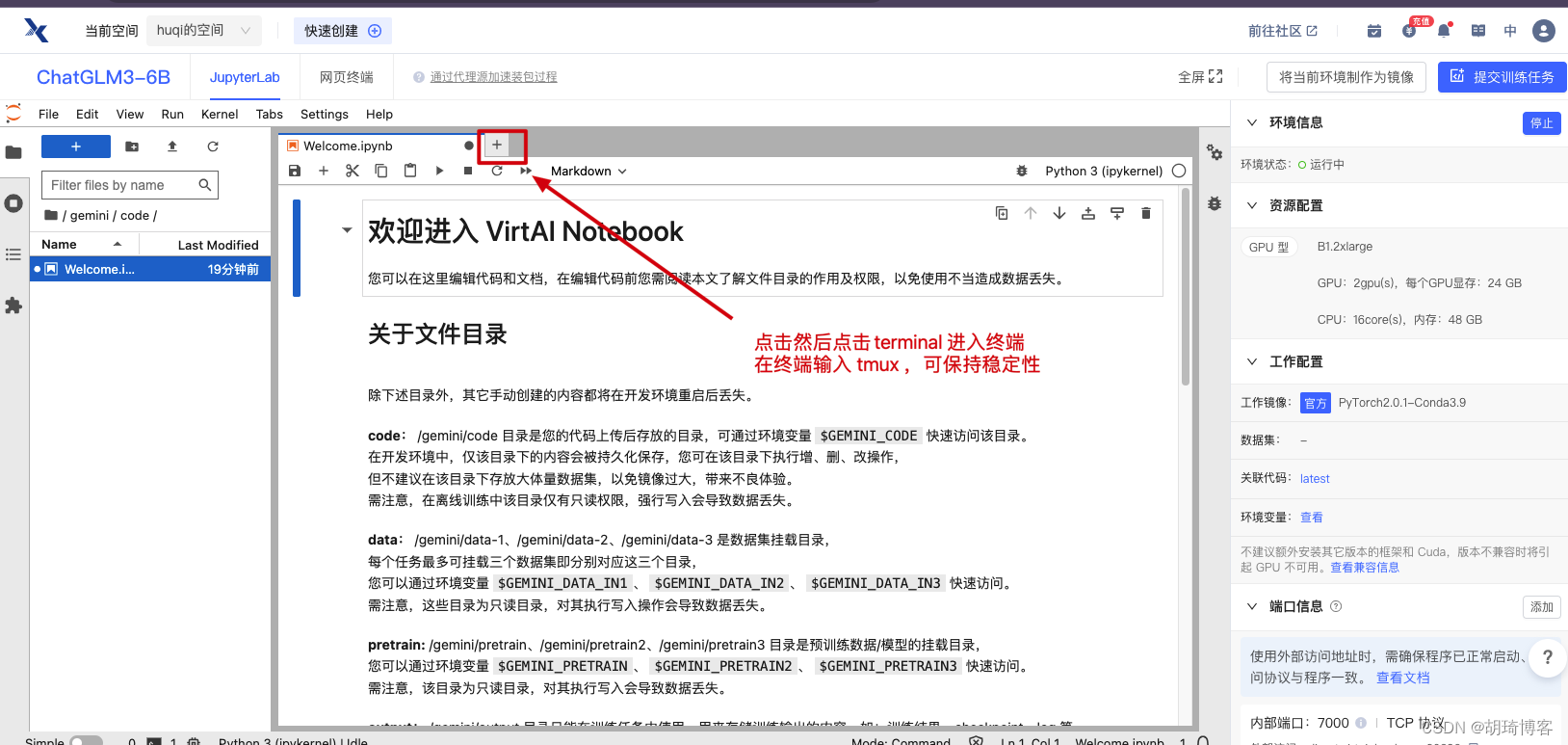

当JupyterLab 环境运行成功之后,我们进入环境点击 + 打开新的页签点击 terminal 创建终端,在终端敲入 tmux 命令,保持终端的稳定性。

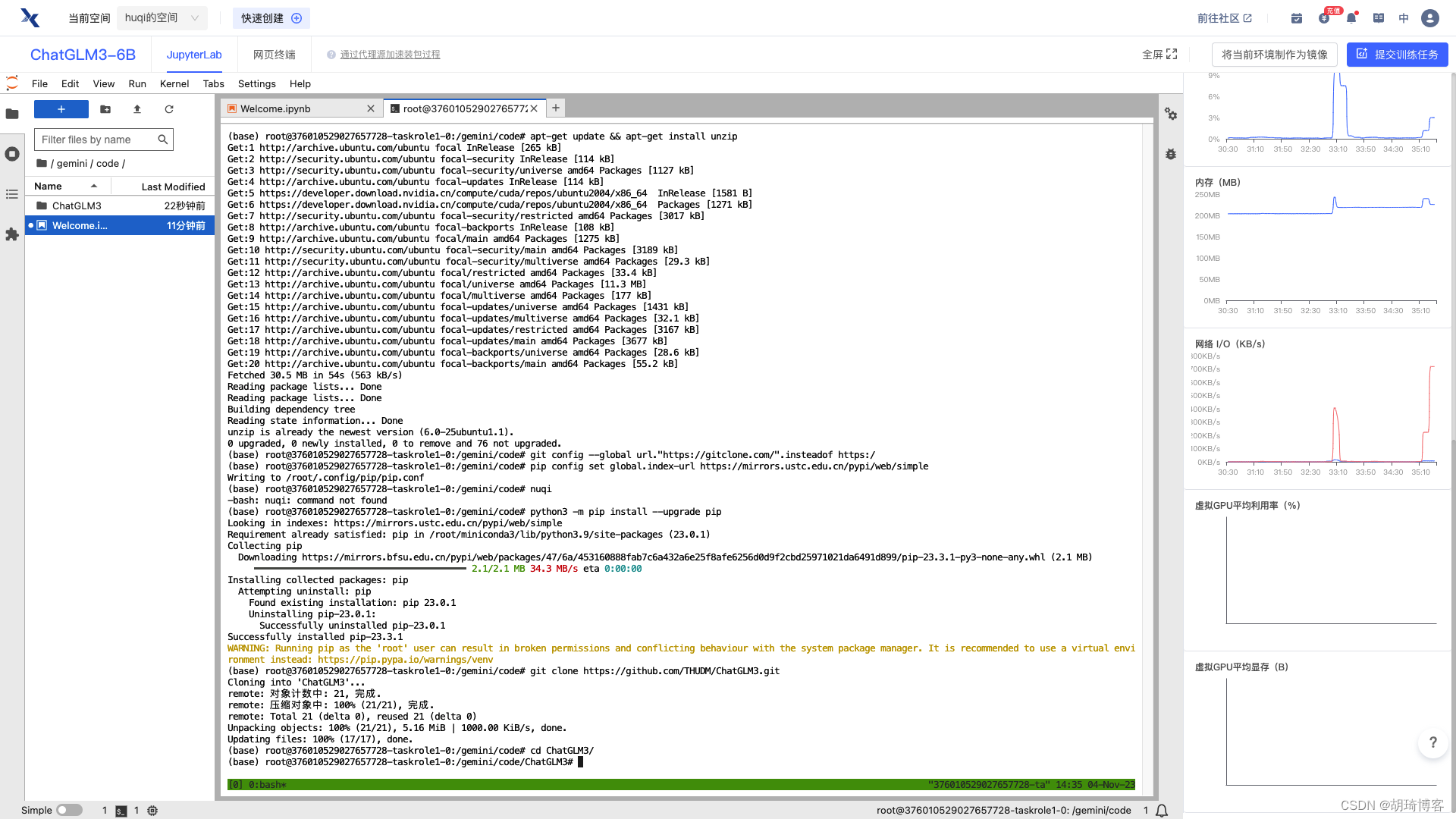

接着在终端命令行工具中一顿操作猛如虎:

# 升级 apt ,安装解压神器 unzip

apt-get update && apt-get install unzip

# 设置镜像源,升级 pip

git config --global url."https://gitclone.com/".insteadof https:/

pip config set global.index-url https://mirrors.ustc.edu.cn/pypi/web/simple

python3 -m pip install --upgrade pip

# git clone 项目并进入项目

git clone https://github.com/THUDM/ChatGLM3.git

cd ChatGLM3

- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

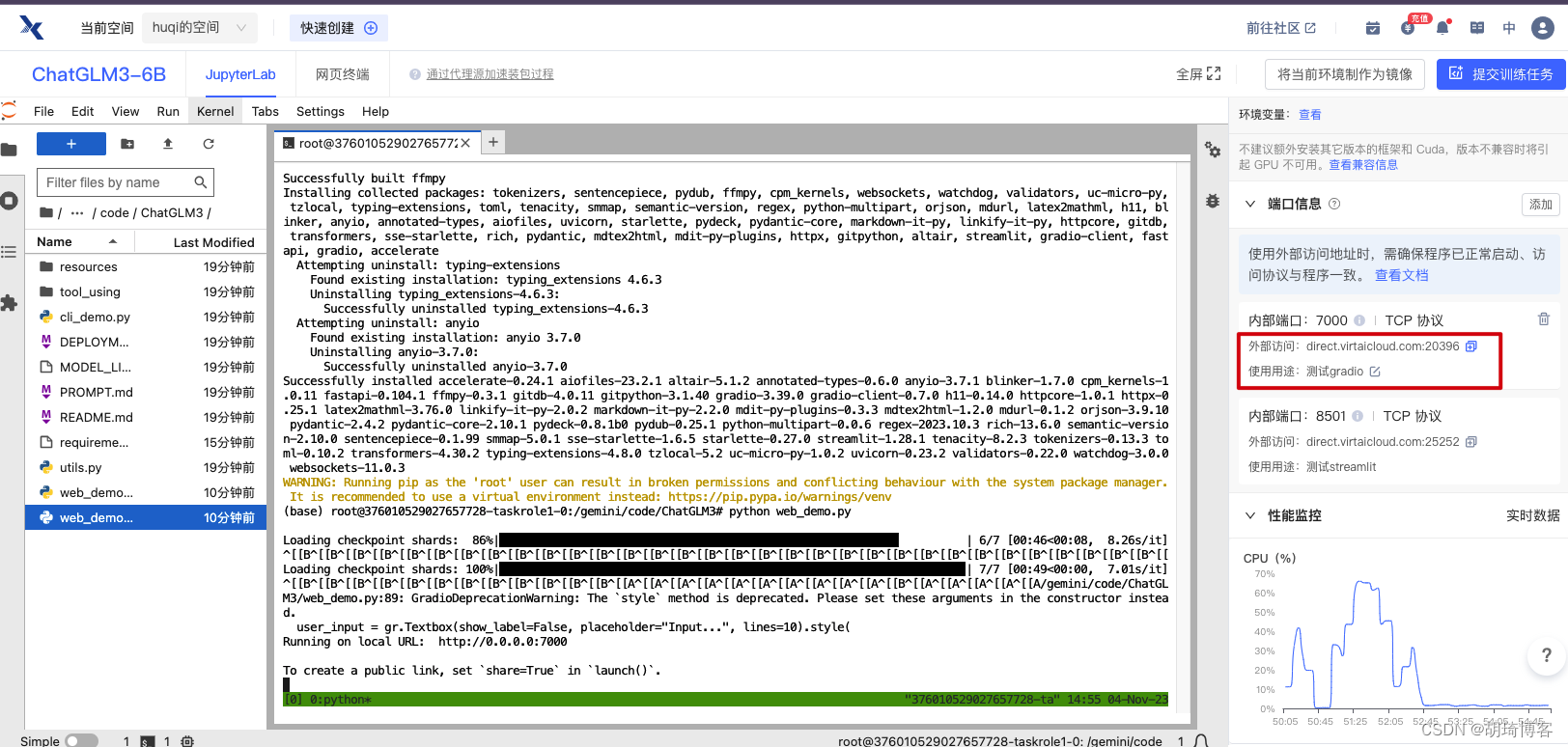

接下来我们分别修改 requirements.txt 、web_demo.py、web_demo2.py 这三个文件的五处。

• requirements.txt 第4行移除 torch,因为我们镜像环境中已经有这个依赖包了

• web_demo.py 第6行、第7行的 THUDM/chatglm3-6b 替换为 ../../pretrain ,因为我们已经下载了预训练模型。此外第 108 行修改为demo.queue().launch(share=False, inbrowser=True, server_name="0.0.0.0", server_port=7000) 这个文件是 gradio 部署。

• web_demo2.py 第14行、第15行的 THUDM/chatglm3-6b 替换为 ../../pretrain。 这个文件是streamlit 部署。

修改完毕记得保存。

接着我们运行命令安装依赖:

pip install -r requirements.txt

- 1

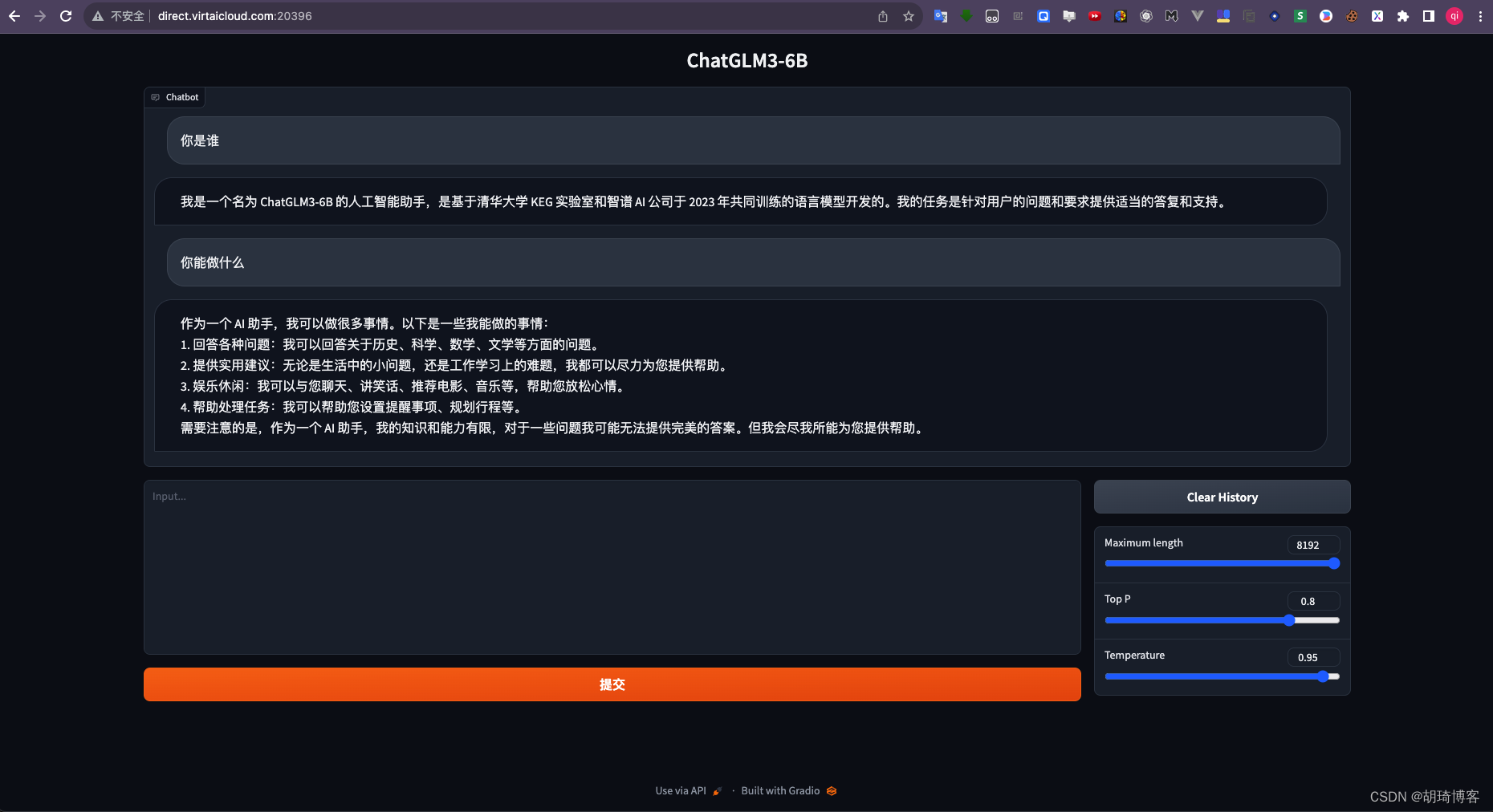

通过 gradio 部署

python web_demo.py

- 1

可在浏览器新窗口打开映射的地址,如: direct.virtaicloud.com:20396

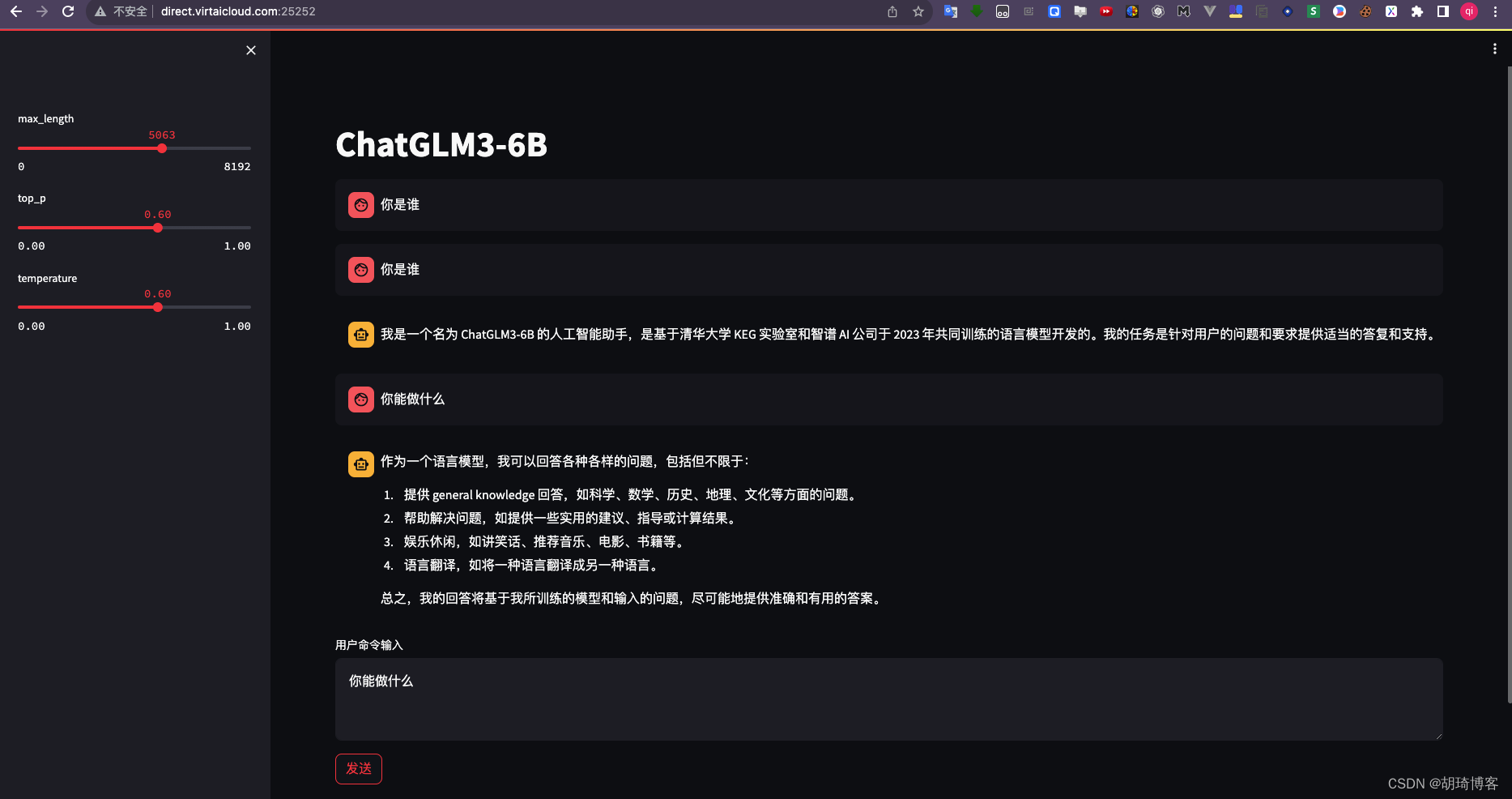

接着我们 ctrl + c 停止服务,执行命令启动 streamlit 部署

streamlit run web_demo2.py

- 1

至此,我们已经完美实践完毕!

如您对文章有任何建议和意见欢迎与我交流~

公众号: 胡琦