热门标签

热门文章

- 1RocketMQ与RabbitMQ的区别:技术选型指南_rocketmq和rabbitmq区别

- 2微软蓝屏”事件暴露了网络安全哪些问题?_微软“蓝屏”事件折射全球 网络安全治理体系亟待完善

- 3Win11打不开安全中心怎么解决_win11安全中心打不开

- 4OpenAI API调用

- 5GlobalPointer NER实体提取

- 6中海油某海上平台轨道巡检机器人解决方案

- 7git 推送报错解决办法,Updates were rejected because the remote contains work that you do_windows提示:更新被拒绝,因为远程包含您所做的工作

- 8园区AR导航系统构建详解:从三维地图构建到AR融合导航的实现_ar技术构建全厂区实景模型

- 9超越流水线,企业研发规范落地新思路

- 10【计算机网络】OSPF单区域实验

当前位置: article > 正文

9.大模型高效微调工具 Hugging Face PEFT_hugging face perf

作者:从前慢现在也慢 | 2024-08-10 22:25:49

赞

踩

hugging face perf

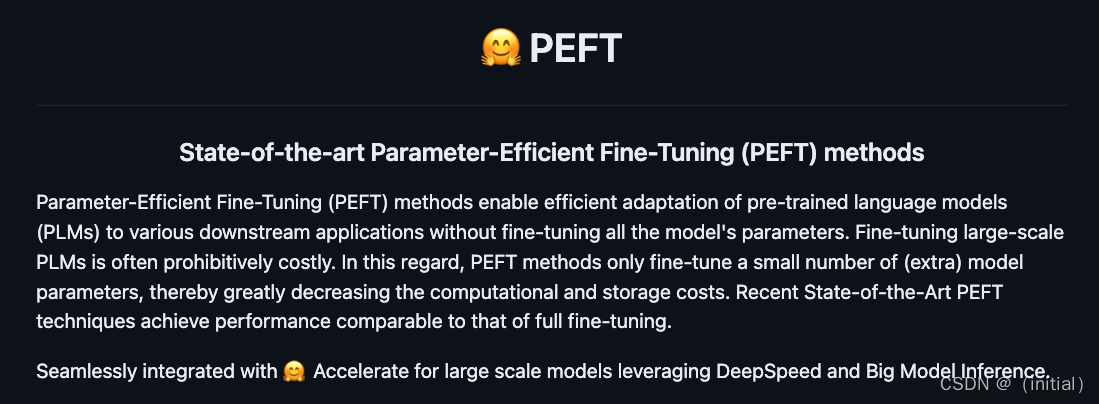

Hugging Face PEFT 库

PEFT 是一个为大型预训练模型提供多种高效微调方法的Python 库。

微调传统范式是针对每个下游任务微调模型参数。大模型参数总量庞大,这种方式变得极其昂贵和不切实际。

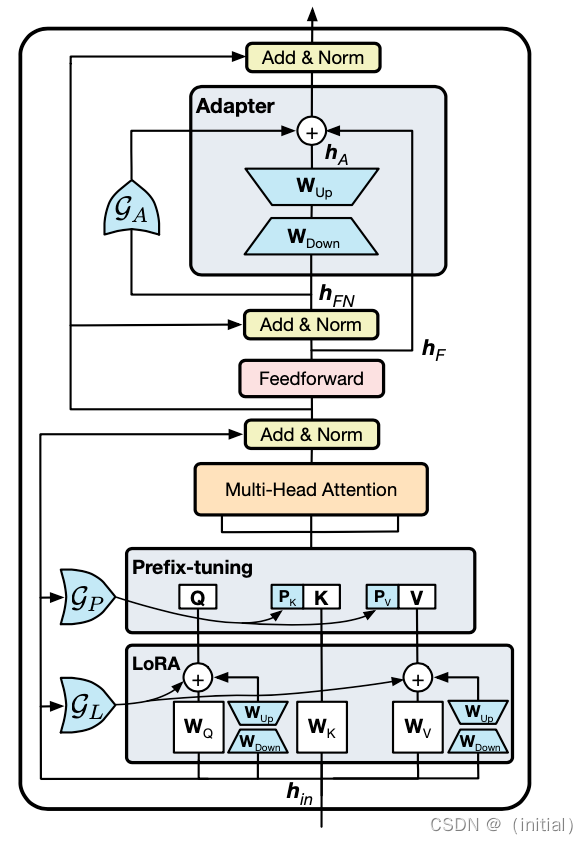

PEFT 采用的高效做法是训练少量提示参数(Prompt Tuning)或使用低秩适应(LoRA)等重新参数化方法来减少微调时训练参数的数量。

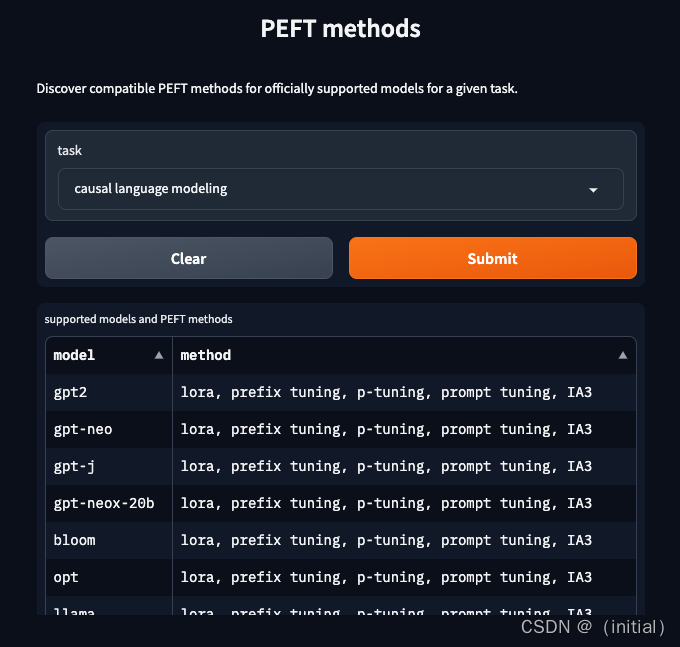

Hugging Face PEFT 库支持的模型和微调方法

## PEFT 与Transformers 如何集成?

## PEFT 与Transformers 如何集成?

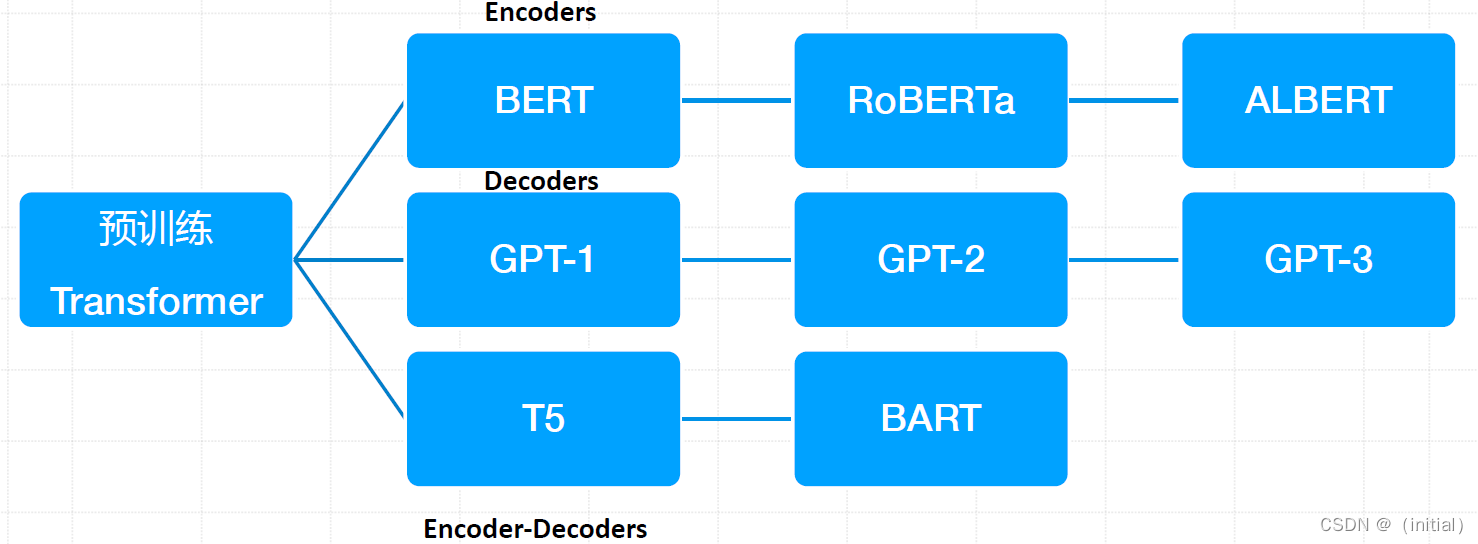

复习:Transformer 预训练模型常见分类

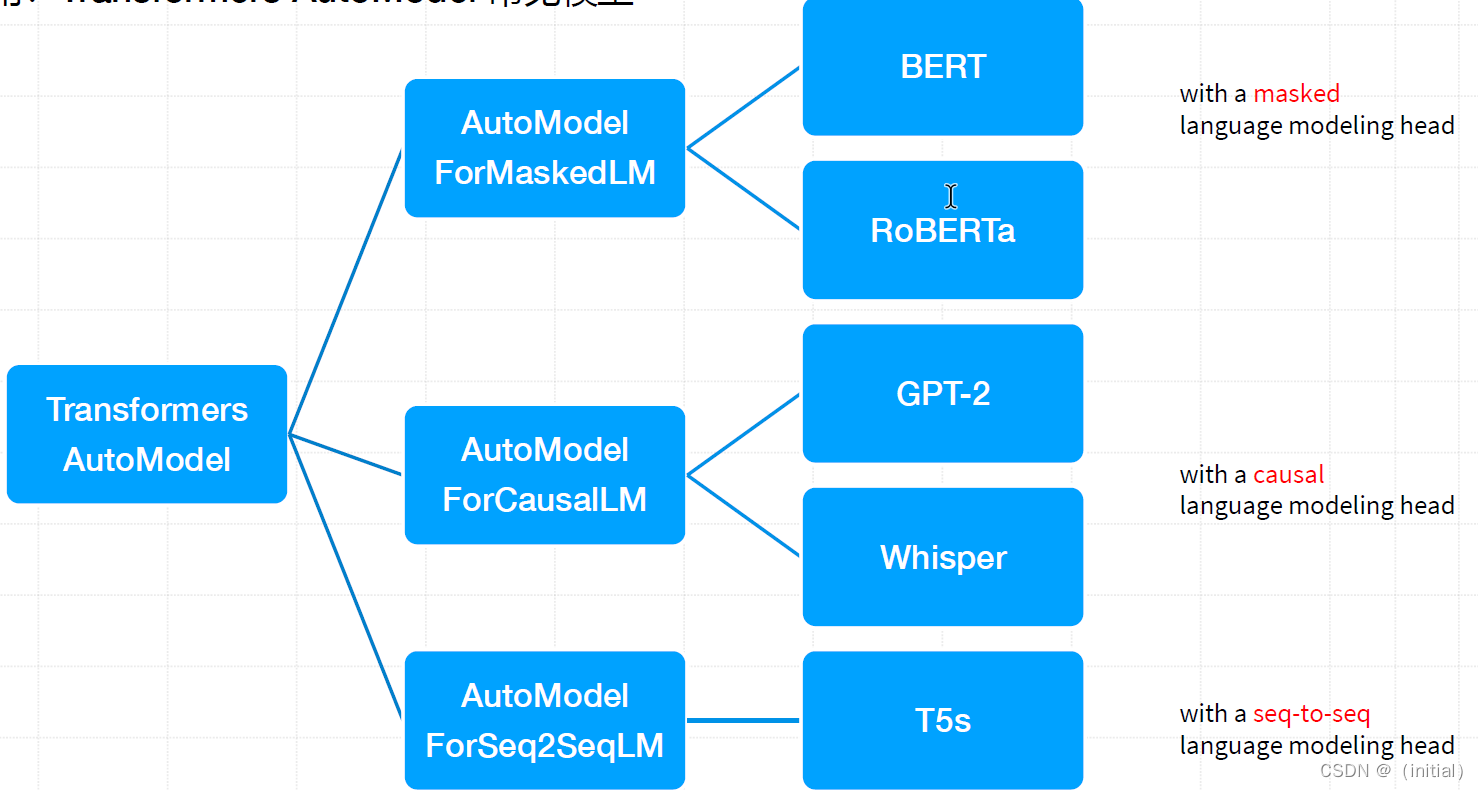

应用:Transformers AutoModel 常见模型

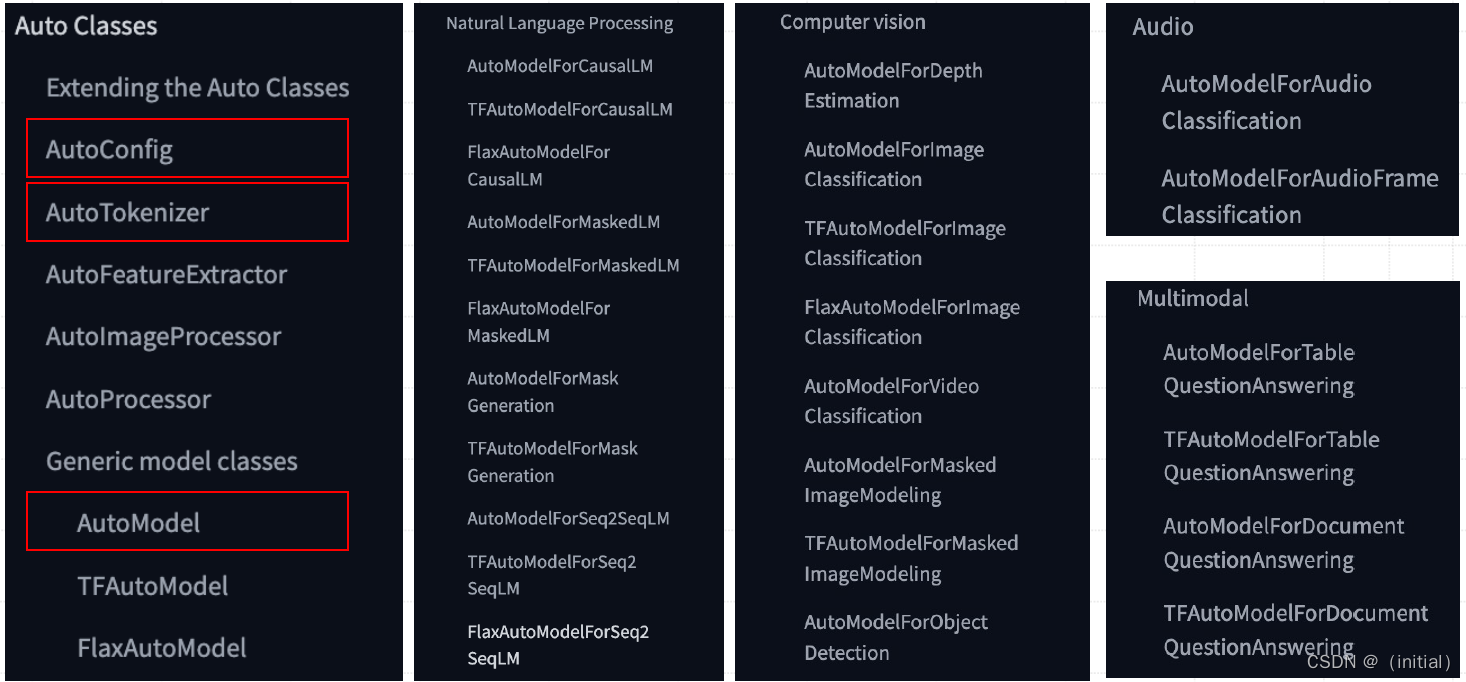

Transformers Auto Classes 设计

AutoClasses 旨在通过全局统一的接口from_pretrained() ,实现基于名称(路径)自动检索预训练权重(模

型)、配置文件、词汇表等所有与模型相关的抽象。

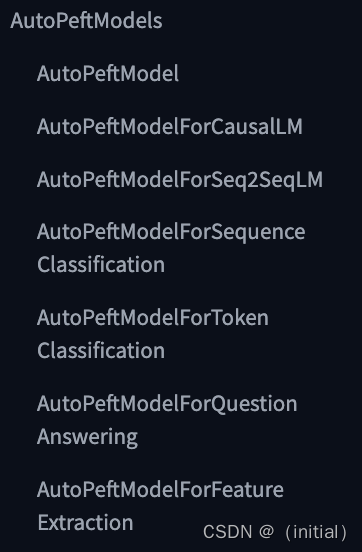

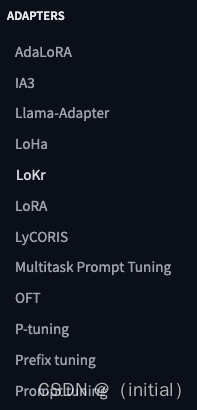

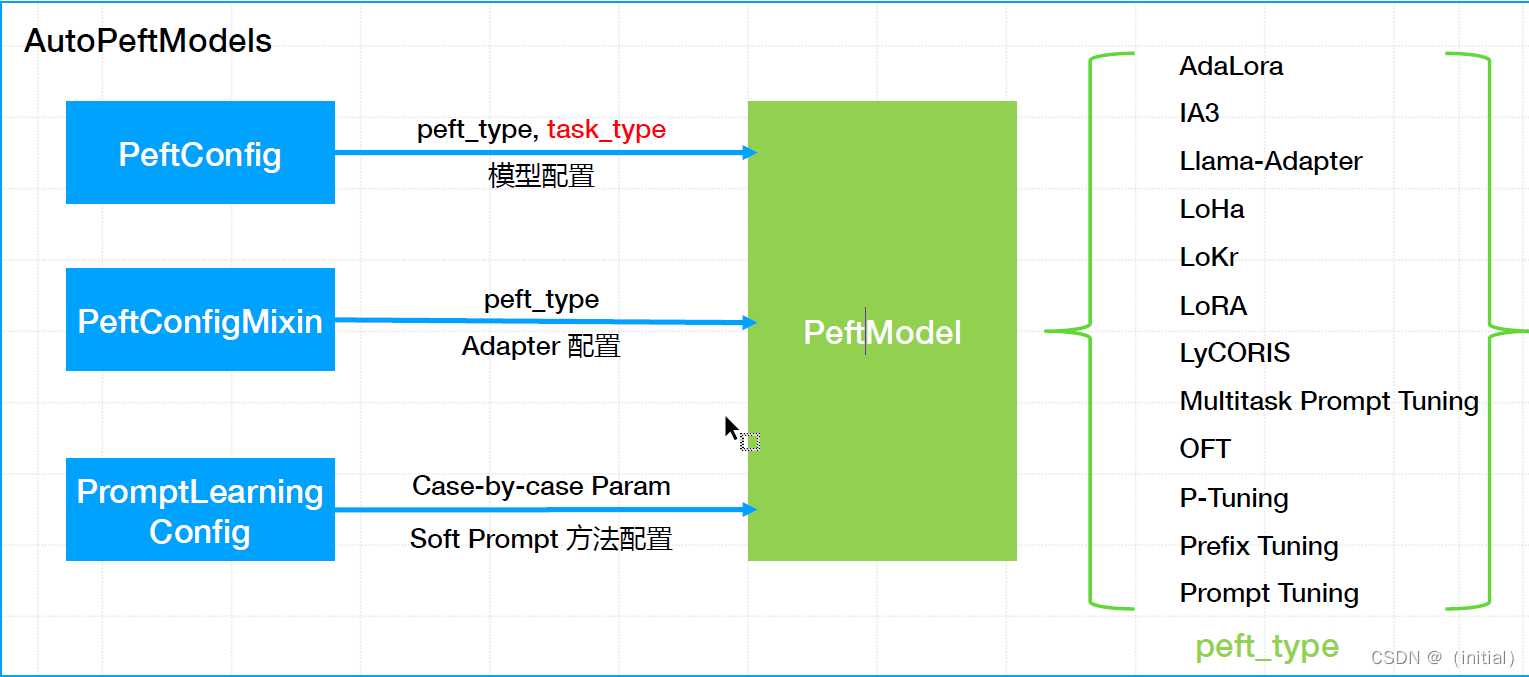

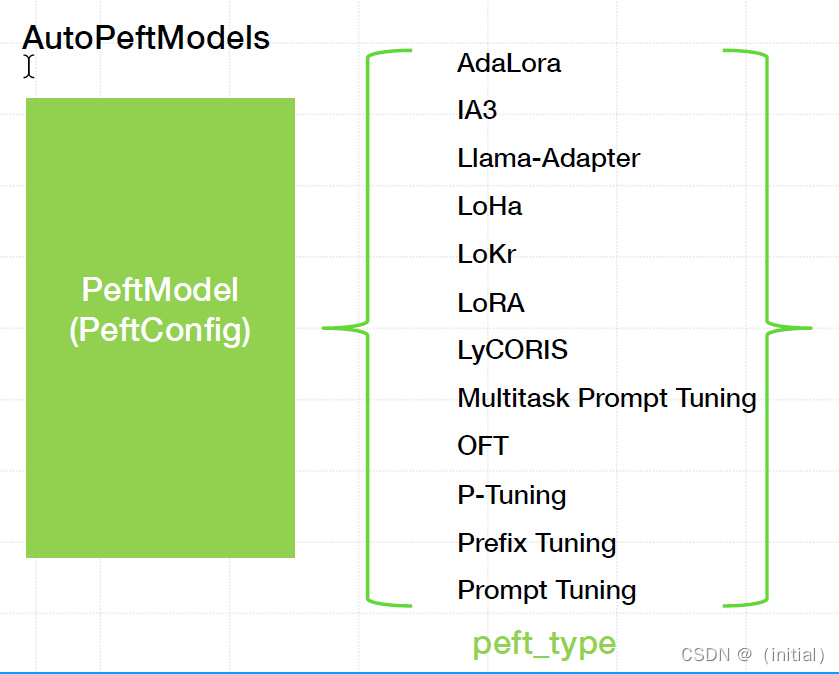

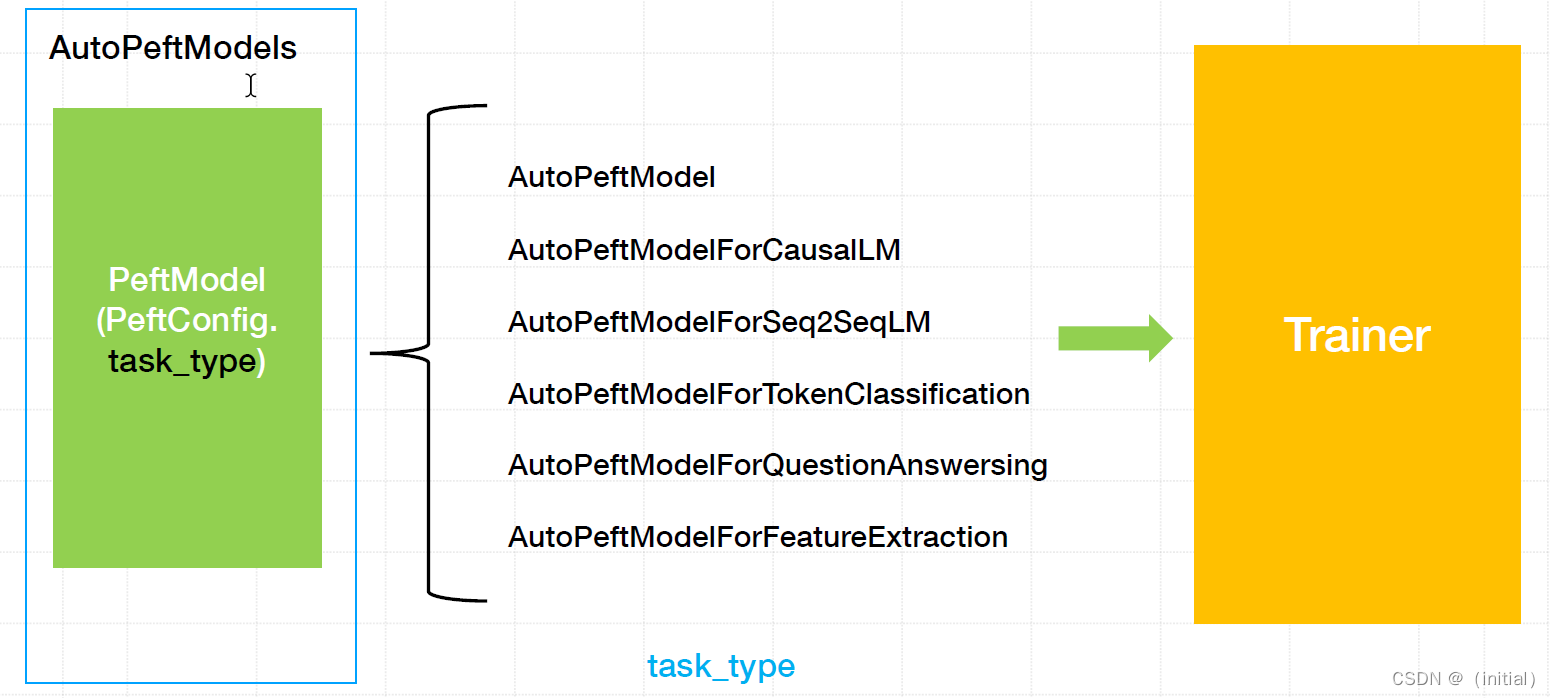

PEFT AutoPeftModels 与Adapters 设计

AutoPeftModel 通过从配置文件中自动推断任务类型来加载适当的PEFT模型。旨在以一行代码便捷加载一个PEFT模型,而无需担心需要哪个确切的模型类或手动加载PeftConfig。

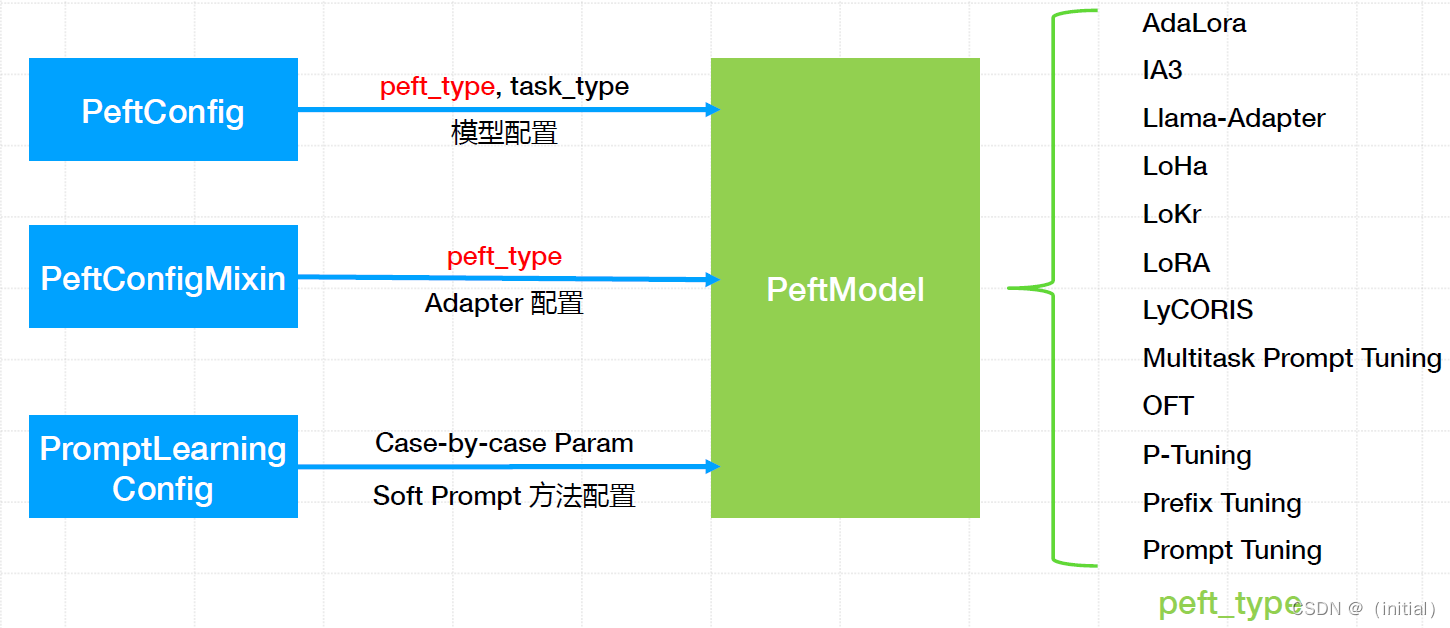

PEFT 类型配置与PeftModel 实例化

AutoPeftModels 简化流程

AutoPeftModels 简化流程

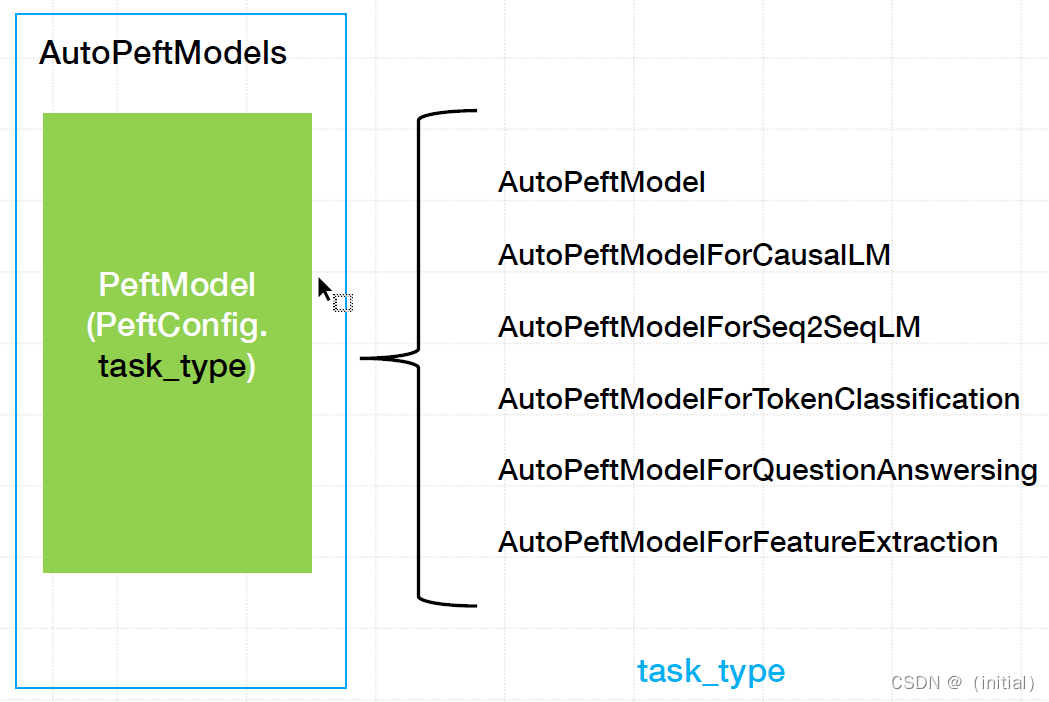

以task_type 为核心简化PEFT 流程

PEFT 无缝对接Transformers Trainer 训练模型

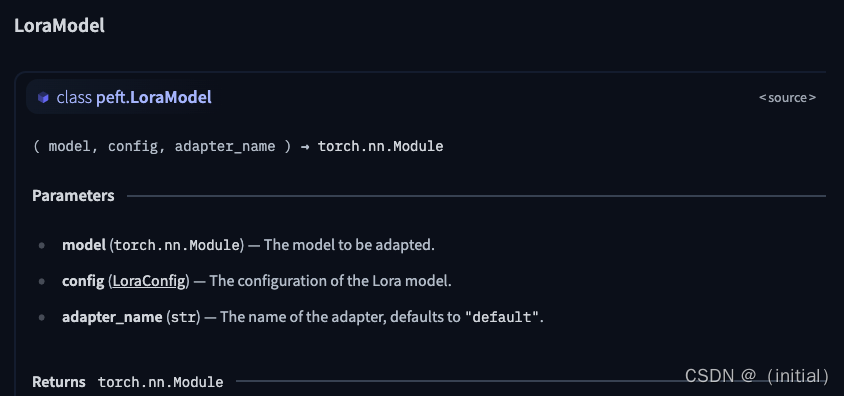

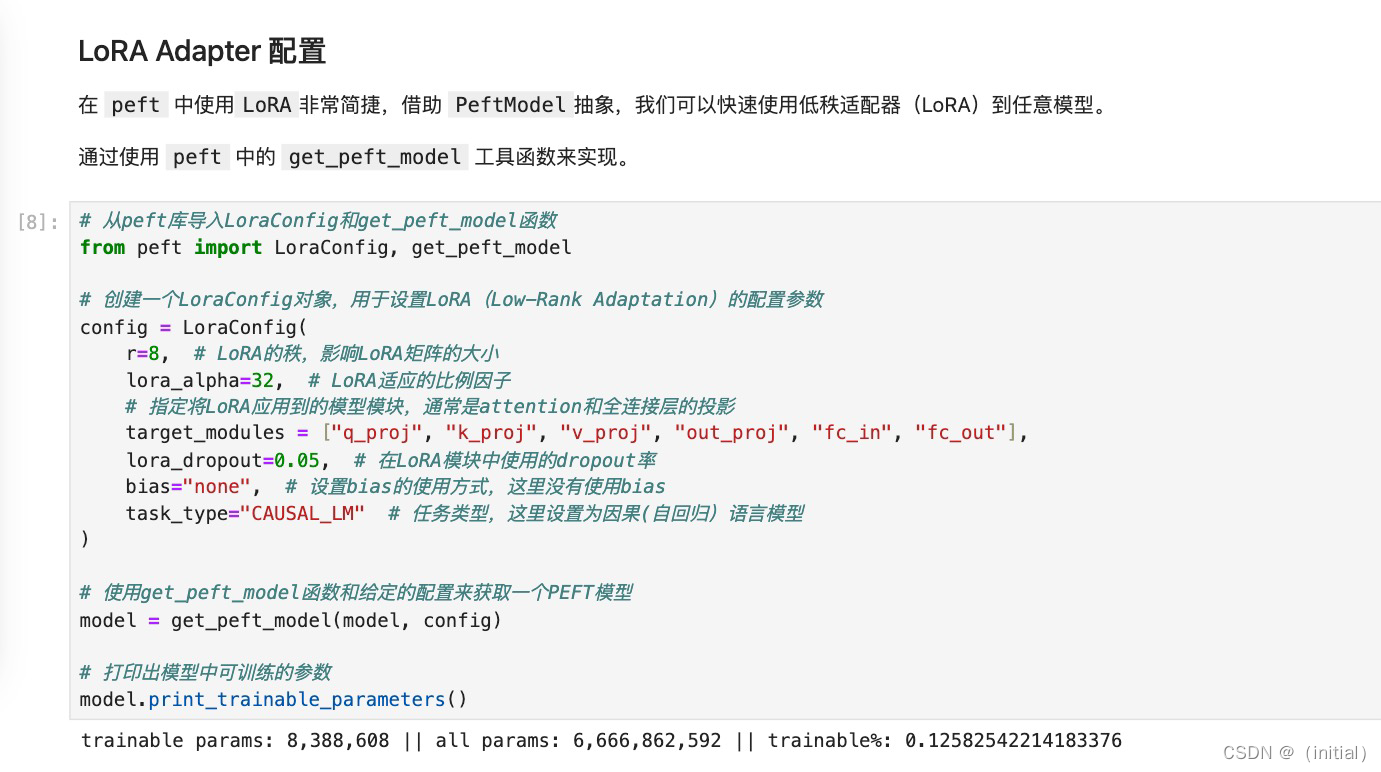

PEFT 库微调工作原理与最佳实践(以LoRA 为例)

PEFT 库微调工作原理与最佳实践(以LoRA 为例)

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/从前慢现在也慢/article/detail/960768

推荐阅读

相关标签