热门标签

热门文章

- 1EXO-chatgpt_api 解释

- 2Matlab得到无背景透明图片_matlab怎么保存为透明图

- 3Linux文件权限_混乱家庭1234

- 4为什么用Python开发桌面应用程序_用python做桌面应用

- 5Flutter报错-Unable to find git in your_flutter -version error: unable to find git in your

- 6Java微信小程序支付篇_wx-java-pay-spring-boot-starter

- 7重载全局和成员new/delete_全局重载

- 8linux7.4安装桌面,centos7.4安装图形界面并远程桌面连接

- 9密码学:对称加密算法、非对称加密算法、哈希算法_非哈希加密

- 10【Citespace】从Citespace开始的引文可视化分析_citespace csdn

当前位置: article > 正文

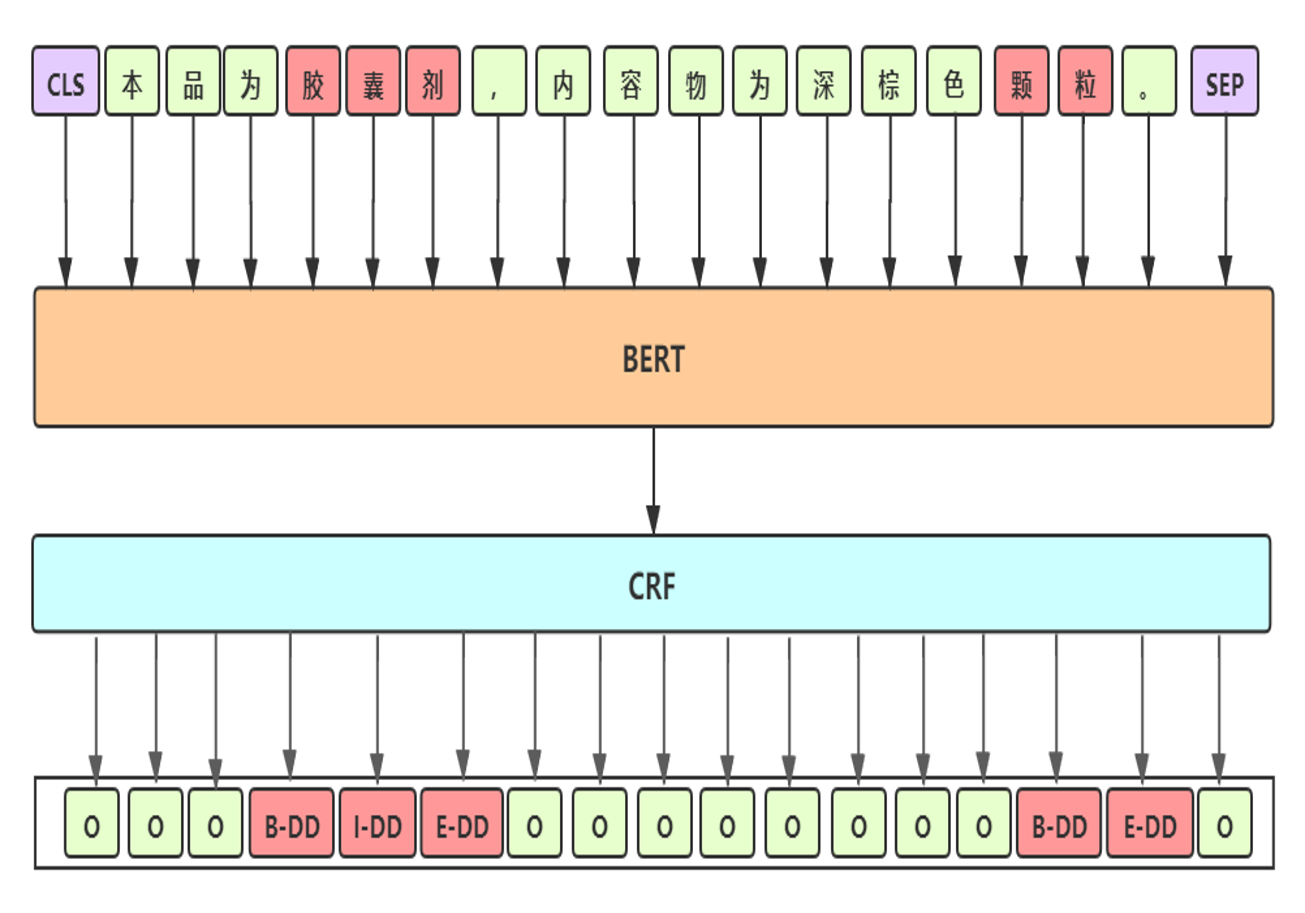

NER范式(一)-序列标注:BERT+CRF【标签:给每个token设置一目标BIO标签】【前向计算时计算每个token的BIO分类标签】【损失函数=-log(真实路径的分数/所有可能路径的总分数)】_序列标注bert+crf

作者:人工智能uu | 2024-07-15 01:01:53

赞

踩

序列标注bert+crf

- Baseline 细节

- 预训练模型:选用 UER-large-24 layer[1],UER在RoBerta-wwm 框架下采用大规模优质中文语料继续训练,CLUE 任务中单模第一

- 差分学习率:BERT层学习率2e-5;其他层学习率2e-3

- 参数初始化:模型其他模块与BERT采用相同的初始化方式

- 滑动参数平均:加权平均最后几个epoch模型的权重,得到更加平滑和表现更优的模型

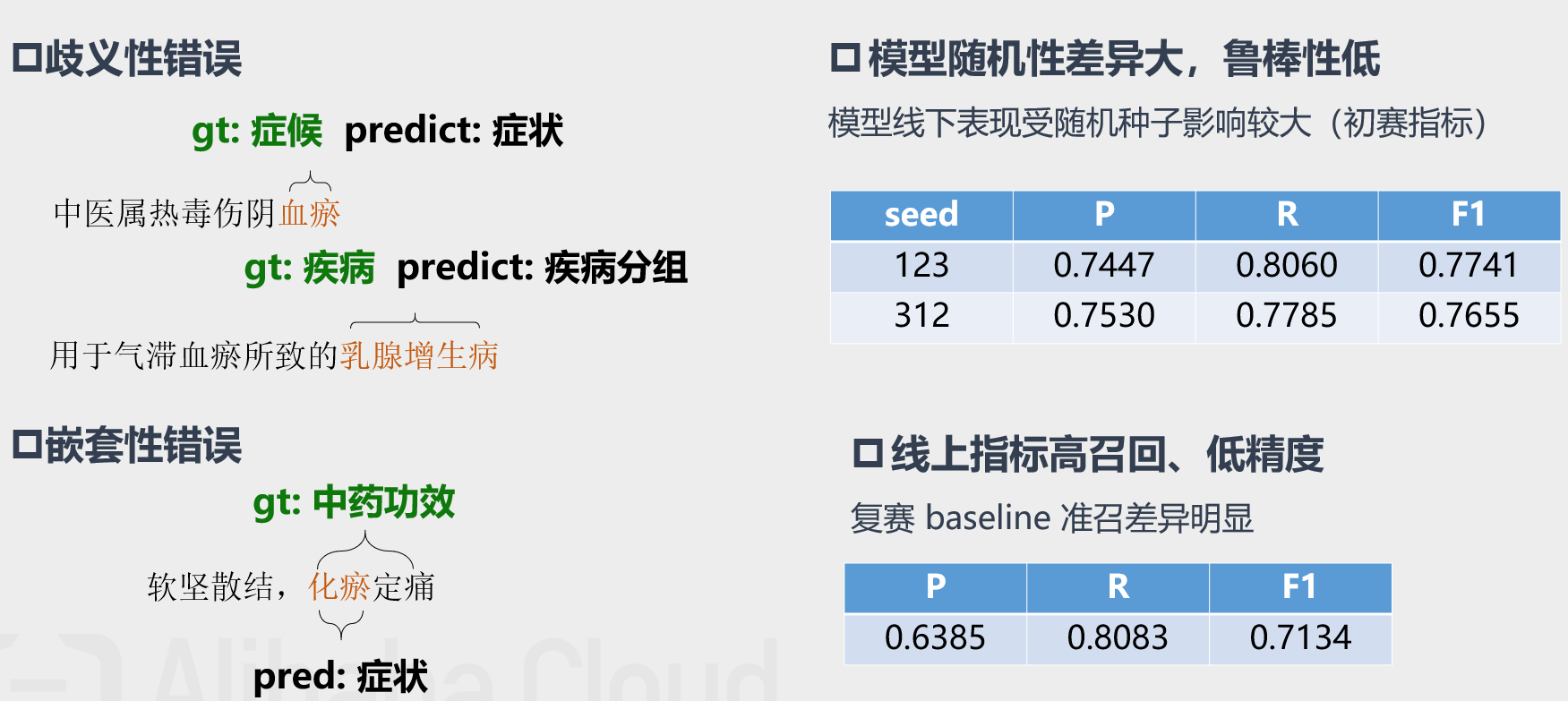

- Baseline bad-case分析

“万创杯”中医药天池大数据竞赛——中药说明书实体识别挑战_算法大赛_天池大赛-阿里云天池

中医药天池大数据竞赛--中药说明书实体识别挑战 | SiriBlog

NLP系列之实体识别/关系抽取(一):如何用BERT+CRF在比赛中获奖——天池中药说明书实体识别挑战亚军分享 - 知乎

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/人工智能uu/article/detail/827160

推荐阅读

相关标签