- 1【C/C++ 应用开发 数据库】入门 Qt数据库编程:从基本操作到高级技巧_qt数据库开发

- 2【中项】系统集成项目管理工程师-第2章 信息技术发展-2.2新一代信息技术及应用-2.2.1物联网与2.2.2云计算

- 3〔009〕Stable Diffusion 之 老照片高清修复 篇_stable diffusion老照片修复

- 4webSocket+定时任务--->实现前后端交互,定时刷新前端列表页面_websocket 添加定时器

- 5【EI级】多头注意力机制多变量时间序列预测TCN-LSTM-Multihead-Attention【含Matlab源码 4697期】_lstm多注意力机制

- 6PostgreSQL 获取当前日期时间及注意事项_postgres current

- 7华为OD机试2023(JS,C++,JAVA,PYTHON)-速战速决or士兵突击_华为od速战速决

- 8L1-002 打印沙漏 (20分)_l1-002 打印沙漏分数 20作者 陈越单位 浙江大学本题要求你写个程序把给定的符号

- 9Midjourney 还是 Stable Diffusion?(两者有什么区别?哪个更适合你?)_midjourney和stable diffusion

- 10FPGA之zynq以太网(2)_zynq串口配置以太网ip

010-AutoCoder 如何在公司级别使用

赞

踩

AutoCoder 如果是程序员用的话,一般 AutoCoder + SaaS 大模型,都会运行在程序员自己的电脑上。程序员还可以通过 human as model 模式,使用 Web 版本的模型。

但是这种方式存在一定泄露源码的风险。

如果公司想给自家的程序员统一使用 AutoCoder,并且对代码隐私有较高的要求,那么我们可以考虑私有化部署 AutoCoder 使用的大模型。

私有化部署大模型

Byzer-LLM 可以快速的帮助企业部署生产可用的大模型集群,支持主流的SaaS,开源大模型,并且支持多模态类的大模型。具体参考 https://github.com/allwefantasy/byzer-llm。

第一步是把公司的服务器,使用 Ray 组成一个集群,可以参考 https://docs.ray.io/en/latest/。Ray 可以运行在裸机上,也可以

运行云上,还可以运行在 k8s 上。这个具体看公司的IT基础设施要求。

接着就可以执行下面命令在 Ray 上启动一个大模型:

- byzerllm deploy --model_path /home/byzerllm/models/openbuddy-llama2-13b64k-v15 \

- --pretrained_model_type custom/auto \

- --gpu_gpus_per_worker 4 \

- --num_workers 1 \

- --model llama2_chat

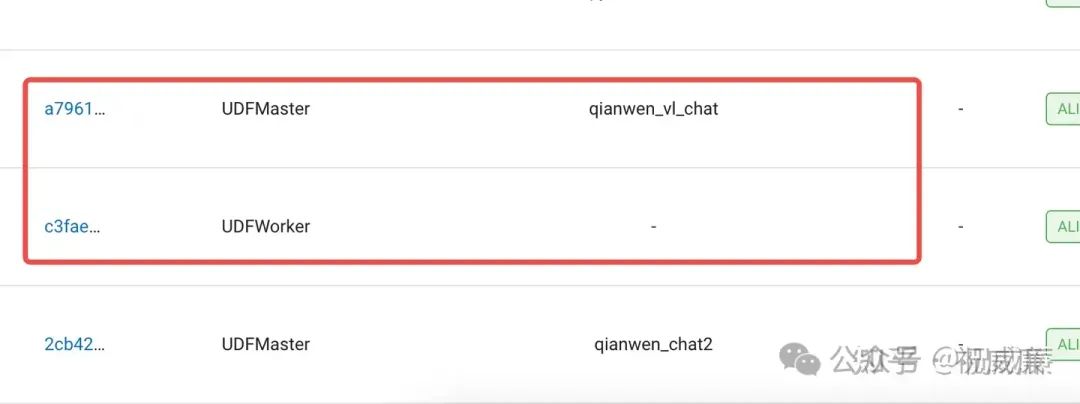

然后在 Ray 的dashboard上,可以看到启动的大模型:

上面的命令表示,我们使用了一个自定义的模型,模型的路径是 `/home/byzerllm/models/openbuddy-llama2-13b64k-v15`,这个模型是一个 13B 的模型,使用了 4 个 GPU,启动了一个 worker。如果你设置了两个worker,那就相当于使用8块卡。

注意,如果想让AutoCoder 效果好,开源的,推荐至少 72B Qwen 模型,并且需要长窗口版本。

值得一提的事,我们提供了快速在连显卡驱动都没有的服务器上进行环境配置的工具: https://github.com/allwefantasy/byzer-llm?tab=readme-ov-file#raw-machine

实际上,Byzer-LLM 对私有大模型和SaaS模型都一视同仁,都会在Ray 集群启动Worker,区别是 SaaS模型不消耗GPU, 而在连接 SaaS模型也通过 Byzer-LLM的一个重要原因是可以具有更好的可控性,比如审计,同时也可以更好的控制模型的版本,比如需要切换一个模型,只需要服务器做修改即可,而不需要客户端做修改。

AutoCoder 客户端配置

一旦服务器部署完成后,程序在自己电脑上安装好AutoCoder 客户端后,就可以连接 Byzer-LLM 集群,具体有两种方式:

第一种方式,是按如下方式启动一个客户端代理:

ray start --address='公司Byzer-LLM集群地址'然后你就可以正常使用 AutoCoder 了,比如:

- source_dir: /home/winubuntu/projects/ByzerRawCopilot

- target_file: /home/winubuntu/projects/ByzerRawCopilot/output.txt

-

- model: qianwen_short_chat

- model_max_length: 2000

- anti_quota_limit: 5

- skip_build_index: true

-

- project_type: "copilot/.py"

- query: |

- 优化 copilot 里的 get_suffix_from_project_type 函数并更新原文件

这个时候,AutoCoder 会自动连接 Byzer-LLM 集群中部署好的 `qianwen_short_chat` 来进行驱动。

第二种方式,是通过配置文件的方式来指定公司的 Byzer-LLM 集群地址:

- source_dir: /home/winubuntu/projects/ByzerRawCopilot

- target_file: /home/winubuntu/projects/ByzerRawCopilot/output.txt

-

- ray_address: 公司Byzer-LLM集群地址

-

- model: qianwen_short_chat

- model_max_length: 2000

- anti_quota_limit: 5

- skip_build_index: true

-

- project_type: "copilot/.py"

- query: |

- 优化 copilot 里的 get_suffix_from_project_type 函数并更新原文件

用户可以根据自己的需求选择其中一种方式。

总结

AutoCoder 通过私有化部署大模型,可以满足公司对代码隐私的要求,同时也可以让程序员使用到最新的大模型。