- 1【iosH5开发】IOS浏览器对于Vue3 Element-plus el-input中,input.value.focus无法聚焦问题_element plus el-input focus函数不存在

- 2Java 多线程(一)—— 概念的引入

- 3CSS【详解】层叠 z-index (含 z-index 的层叠规则,不同样式的层叠效果)

- 4常见经典目标检测算法_最流行的目标检测算法

- 52023软件测试的4个技术等级,你在哪个级别?_软件测试工程师职级评定

- 6云计算基础:理解AWS、Azure和Google Cloud_对云服务(如aws,azure,阿里云等)的理解如何?

- 7Python 学到什么程度才可以去找工作?掌握这四点足够了!_python学到什么程度可以找工作

- 82024年Android最新Android过渡动画,发现掘金小秘密(1),数据结构与算法面试题库_android过渡动画leash

- 9Flutter完整开发实战详解(一、Dart语言和Flutter基础)

- 10SM4加密算法原理以及C语言实现_sm4算法如何将一个字分成4个字节c语言

Linux上进行Hadoop单机部署_linux hdfs 搭建单机版

赞

踩

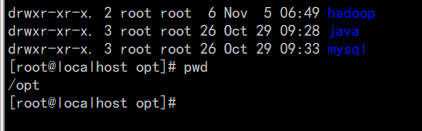

我们在/opt目录下新建文件夹hadoop

利用第三方工具进行上传hadoop安装包

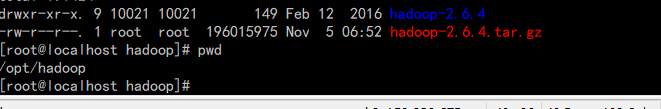

进行解压:

tar -zxvf hadoop-2.6.4.tar.gz

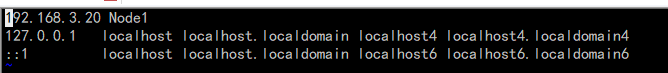

进行hosts设置,在目录/etc/hosts下添加本地IP

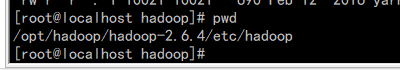

修改配置文件:

../hadoop2.6.4/etc/hadoop/目录下,hadoop-env.sh,core-site.xml,mapred-site.xml.template,hdfs-site.xml文件

1)core-site.xml 配置:其中的hadoop.tmp.dir的路径可以根据自己的习惯进行设置。

在hadoop-2.6.4下建立tmp文件夹

输入 vi core-site.xml

- <configuration>

-

- <property>

-

- <name>hadoop.tmp.dir</name>

-

- <value>file:/opt/hadoop/hadoop-2.6.4/tmp</value>

-

- <description>Abase for other temporary directories.</description>

-

- </property>

-

- <property>

-

- <name>fs.defaultFS</name>

-

- <value>hdfs://Node1:9000</value>

-

- </property>

-

- </configuration>

mapred-site.xml.template配置:

vi mapred-site.xml.template

- <configuration>

-

- <property>

-

- <name>mapred.job.tracker</name>

-

- <value>Node1:9001</value>

-

- </property>

-

- </configuration>

hdfs-site.xml配置:

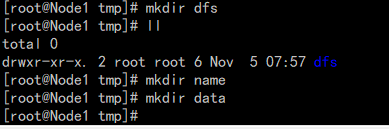

新建 tmp/dfs/name 以及tmp/dfs/data文件夹,可根据自己配置

vi hdfs-site.xml

- <configuration>

-

- <property>

-

- <name>dfs.replication</name>

-

- <value>1</value>

-

- </property>

-

- <property>

-

- <name>dfs.namenode.name.dir</name>

-

- <value>file:/opt/hadoop/hadoop-2.6.4/tmp/dfs/name</value>

-

- </property>

-

- <property>

-

- <name>dfs.datanode.data.dir</name>

-

- <value>file:/opt/hadoop/hadoop-2.6.4/tmp/dfs/data</value>

-

- </property>

-

- </configuration>

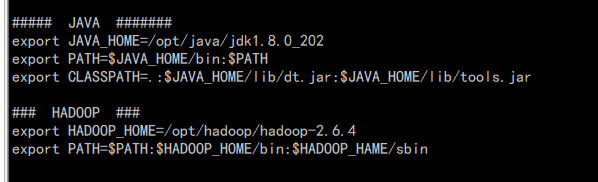

hadoop-env.sh配置:

指定JDK位置

vi hadoop-env.sh

hadoop环境变量配置

-

- ##### JAVA #######

- export JAVA_HOME=/opt/java/jdk1.8.0_202

- export PATH=$JAVA_HOME/bin:$PATH

- export CLASSPATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar

-

- ### HADOOP ###

- export HADOOP_HOME=/opt/hadoop/hadoop-2.6.4

- export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HAME/sbin

运行hadoop

初始化HDFS系统

在hadop2.6.4目录下执行命令:

hdfs namenode -format初始化成功

启动hadoop

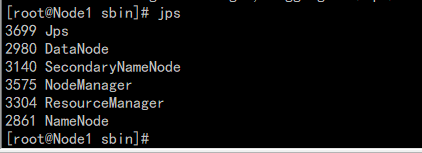

使用jps命令查看进程信息:

若出现如图所示结果,则说明DataNode和NameNode都已经开启

查看web界面

在浏览器中输入 http://192.168.3.20:50070 ,即可查看相关信息,截图如下

至此,hadoop的环境就已经搭建好了。

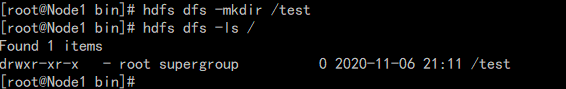

测试

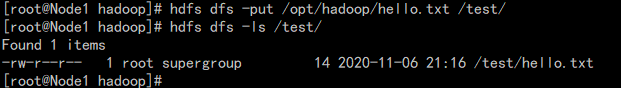

在hdfs的根目录下建立了一个test目录

进入bin目录下输入下面命令

hdfs dfs -mkdir /test# 查看HDFS根目录下的目录结构

将本地hello.txt文件上传到test目录中

上传:

hdfs dfs -put /opt/hadoop/hello.txt /test/查看:

hdfs dfs -ls /test/

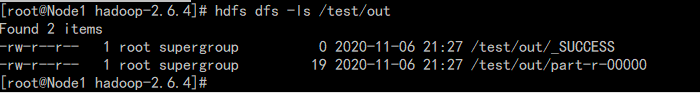

运行wordcount demo

将运行结果保存在/test/out目录下

输入到/opt/hadoop/hadoop-2.6.4

hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-2.6.4.jar wordcount /test/hello.txt /test/out

查看/test/out文件:

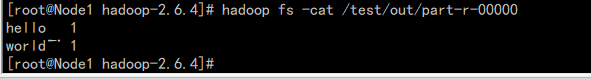

查看part-r-00000中的运行结果:

hadoop fs -cat /test/out/part-r-00000

至此,wordcount demo 运行结束。

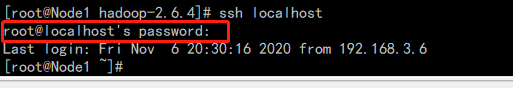

安装ssh服务

在我们启动hadoop中会输入密码:我们可以设置ssh服务,也可以创建用户去设置ssh服务,这里只是在root用户下去设置:

运行ssh localhost进行验证

需要输入密码。我们开始设置

输入

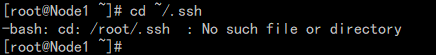

cd ~/.ssh # 如果找不到这个文件夹,先执行一下 "ssh localhost"

输入

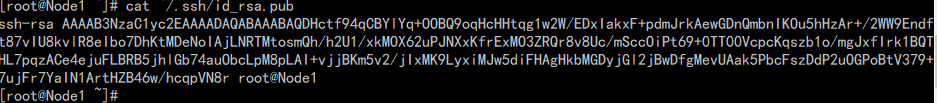

ssh-keygen -t rsa输入:

cp id_rsa.pub authorized_keys查看

cat ~/.ssh/id_rsa.pub

至此ssh配置完成。我们来重新启动hadoop则不需要密码

进入/opt/hadoop/hadoop-2.6.4/sbin目录下

![]()

先关闭hadoop,输入./stop-all.sh

启动:

至此所有完成。祝你好运!!!