- 1Linux下如何设置系统定时任务_linux 怎么定时任务每30秒

- 2linux中的ip命令_linux ip link

- 3基于cpolar的macOS的内网穿透_cpolar 内网穿透原理

- 4SLAM---初识SLAM_slam技术

- 5新手微商如何快速成为引流高手?

- 6Linux中NFS的配置和使用_linux nfs

- 7九州未来十二周年丨聚力同行,奔赴智能新未来

- 8【数据结构】—— 二叉树(C)_二叉树模型c是什么意思啊

- 97月,一个新方向爆了,70k很稳......

- 10Spring MVC学习笔记之Spring MVC组件HandlerAdapter_handlerfunctionadapter类是做什么

基于ChatGLM-6B 部署本地私有化ChatGPT

赞

踩

基于ChatGLM-6B 部署本地私有化ChatGPT

一、开源模型

1、ChatGLM-6B介绍

- 清华大学知识工程 (KEG) 实验室和智谱AI公司与于2023年共同训练的语言模型;ChatGLM-6B 参考了 ChatGPT 的设计思路,在千 亿基座模型 GLM-130B 中注入了代码预训练,通过有监督微调等技术实现与人类意图对齐(即让机 器的回答符合人类的期望和价值观);

- ChatGLM-6B 是一个开源的、支持中英双语的对话语言模型,基于 General Language Model (GLM) 架构,具有 62 亿参数;

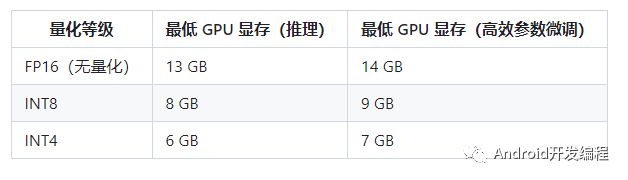

- 结合模型量化技术,用户可以在消费级的显卡上进行本地部署(INT4 量化级别下最低只需 6GB 显存);

- ChatGLM-6B 使用了和 ChatGPT 相似的技术,针对中文问答和对话进行了优化。经过约 1T 标识符的中英双语训练,辅以监督微调、反馈自助、人类反馈强化学习等技术的加持,62 亿参数的 ChatGLM-6B 已经能生成相当符合人类偏好的回答;

2、ChatGLM-6B 有如下特点

- 充分的中英双语预训练:ChatGLM-6B 在 1:1 比例的中英语料上训练了 1T 的 token 量,兼具双语能力;

- 优化的模型架构和大小:吸取 GLM-130B 训练经验,修正了二维 RoPE 位置编码实现,使用传统FFN结构。6B(62亿)的参数大小,也使得研究者和个人开发者自己微调和部署 ChatGLM-6B 成为可能;

- 较低的部署门槛:FP16 半精度下,ChatGLM-6B 需要至少 13GB 的显存进行推理,结合模型量化技术,这一需求可以进一步降低到 10GB(INT8) 和 6GB(INT4), 使得 ChatGLM-6B 可以部署在消费级显卡上;

- 更长的序列长度:相比 GLM-10B(序列长度1024),ChatGLM-6B 序列长度达 2048,支持更长对话和应用;

- 人类意图对齐训练:使用了监督微调(Supervised Fine-Tuning)、反馈自助(Feedback Bootstrap)、人类反馈强化学习(Reinforcement Learning from Human Feedback) 等方式,使模型初具理解人类指令意图的能力。输出格式为 markdown,方便展示;因此,ChatGLM-6B 具备了一定条件下较好的对话与问答能力;

3、ChatGLM-6B 也有相当多已知的局限和不足

- 模型容量较小:6B 的小容量,决定了其相对较弱的模型记忆和语言能力;在面对许多事实性知识任务时,ChatGLM-6B 可能会生成不正确的信息;

- 她也不擅长逻辑类问题(如数学、编程)的解答;

- 可能会产生有害说明或有偏见的内容:ChatGLM-6B 只是一个初步与人类意图对齐的语言模型,可能会生成有害、有偏见的内容;

- 较弱的多轮对话能力:ChatGLM-6B 的上下文理解能力还不够充分,在面对长答案生成,以及多轮对话的场景时,可能会出现上下文丢失和理解错误的情况;

- 英文能力不足:训练时使用的指示大部分都是中文的,只有一小部分指示是英文的。因此在使用英文指示时,回复的质量可能不如中文指示的回复,甚至与中文指示下的回复矛盾;

- 易被误导:ChatGLM-6B 的“自我认知”可能存在问题,很容易被误导并产生错误的言论。例如当前版本模型在被误导的情况下,会在自我认知上发生偏差。即使该模型经过了1万亿标识符(token)左右的双语预训练,并且进行了指令微调和人类反馈强化学习(RLHF),但是因为模型容量较小,所以在某些指示下可能会产生有误导性的内容;

二、系统部署

1、硬件需求

2、系统环境

操作系统:CentOS 7.6/Ubuntu (内存:32G)

显卡配置:2x NVIDIA Gefore 3070Ti 8G (共16G显存)

Python 3.8.13 (版本不要高于3.10,否则有些依赖无法下载,像paddlepaddle 2.4.2在高版本Python还不支持)

3、部署ChatGLM 6B

3.1下载源码

直接下载chatGLM-6B https://github.com/THUDM/ChatGLM-6B

git下载 git clone https://github.com/THUDM/ChatGLM-6B

3.2安装依赖

进入ChatGLM-6B目录

使用 pip 安装依赖:pip install -r requirements.txt,其中 transformers 库版本推荐为 4.27.1,但理论上不低于 4.23.1 即可。

此外,如果需要在 cpu 上运行量化后的模型,还需要安装 gcc 与 openmp。多数 Linux 发行版默认已安装。对于 Windows ,可在安装 TDM-GCC 时勾选 openmp。Windows 测试环境 gcc 版本为 TDM-GCC 10.3.0, Linux 为 gcc 11.3.0

3.3下载模型

从 Hugging Face Hub 下载

可以手动下载https://huggingface.co/THUDM/chatglm-6b/tree/main

git下载 git clone https://huggingface.co/THUDM/chatglm-6b

将模型下载到本地之后,将以上代码中的 THUDM/chatglm-6b 替换为你本地的 chatglm-6b 文件夹的路径,即可从本地加载模型;

在chatglm-6b文件下创建一个model文件夹放模型文件

3.4代码调用

可以通过如下代码调用 ChatGLM-6B 模型来生成对话:

模型的实现仍然处在变动中。如果希望固定使用的模型实现以保证兼容性,可以在 from_pretrained 的调用中增加 revision=“v1.1.0” 参数

>>> from transformers import AutoTokenizer, AutoModel

>>> tokenizer = AutoTokenizer.from_pretrained("THUDM/chatglm-6b", trust_remote_code=True)

>>> model = AutoModel.from_pretrained("THUDM/chatglm-6b", trust_remote_code=True).half().cuda()

>>> model = model.eval()

>>> response, history = model.chat(tokenizer, "你好", history=[])

>>> print(response)

你好声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/Guff_9hys/article/detail/908647Copyright © 2003-2013 www.wpsshop.cn 版权所有,并保留所有权利。