- 1AI 绘画Stable Diffusion 研究(十二)SD数字人制作工具SadTlaker插件安装教程_sadtalker插件安装

- 2【技术美术图形部分】AO理论及优化 AO贴图如何参与渲染

- 3鸿蒙系统与Android有何不同?_华为和安卓的区别

- 475道经典AI面试题,我就想把你们安排的明明白白的!(含答案)_ai面试题库及答案

- 5Android 自定义View 之 Dialog弹窗_android 自定义dialog

- 6Python小白逆袭大神Day03课程总结_inflating: home/aistudio/data/data31557/20200422.j

- 7Android将Widget添加到自己的应用程序_android 自己的app怎么使用其他app的widget

- 8JAVA如何把一个float四舍五入到小数点后2位,4位,或者其它指定位数._将float四舍五入保留2位,怎么做

- 9Linux开发板循环显示红绿蓝_linux显示三种颜色代码

- 10YOLOv5结合BiFPN:BiFPN网络结构调整,BiFPN训练模型训练技巧_yolov5+bifpn修改

SemEval-2022 Task 6 有意讽刺检测_semeval比赛 task6

赞

踩

YNU-HPCC at SemEval-2022 Task 6: Transformer-based Model for Intended Sarcasm Detection in English and Arabic

本篇随便讲下论文,这是我们在SemEval-2022 Task6的相关工作,本篇论文在Task6榜单上取得了 12/43 (21/32), 11/22, and 3/16 (8/13) 的排名。

任务介绍

官方的主页:semeval2022-isarcasmeval

其实就是三个在英语、阿拉伯语数据集下的分类任务:

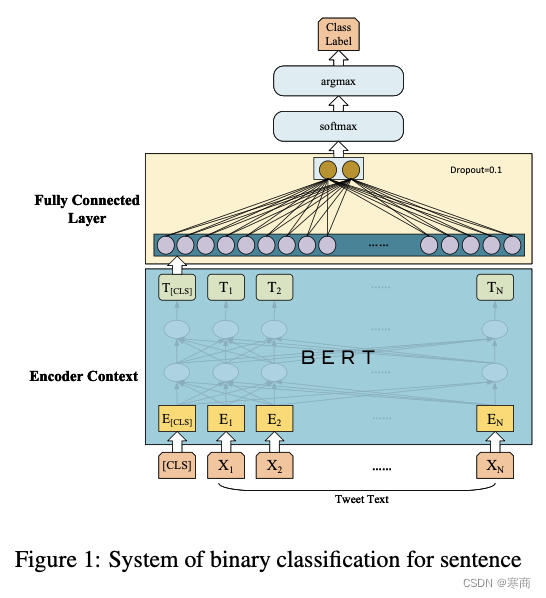

- Task A:很简单的二分类任务,给定句子,判断是否具有讽刺意义

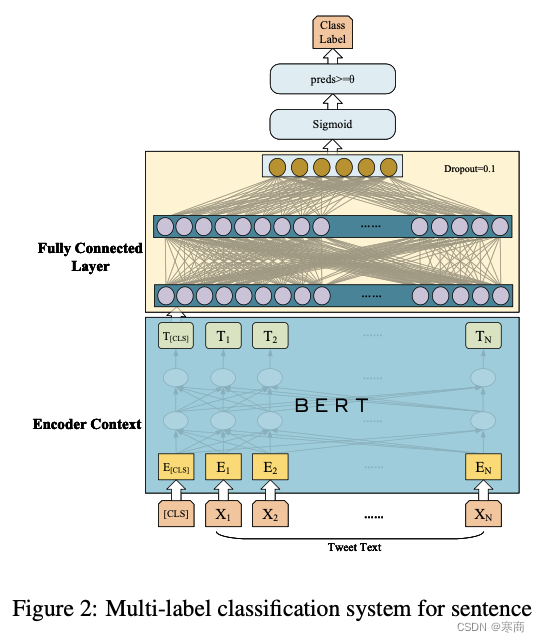

- Task B:与A类似,不过是多标签分类任务,且只有英语数据

- Task C:给定两个句子,一个是有讽刺的句子,一个是同义但无讽刺的转述,判断讽刺句子的位置。是个句子对分类任务。

模型介绍

没做多大的创新,正如主办方所言,

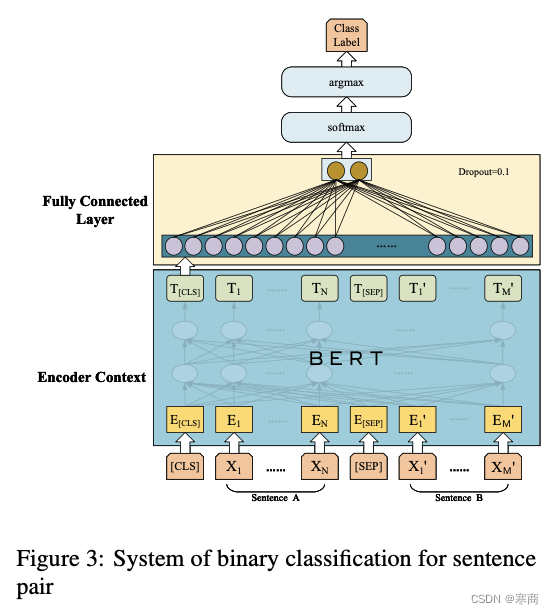

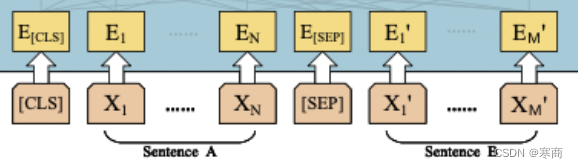

我们使用的和其他参赛者并无多大区别,都是BERT及其变种,预训练+Fine-tuning的两段式,差异主要在数据处理上。结构如下图所示,

主要难点及解决方案

难点:

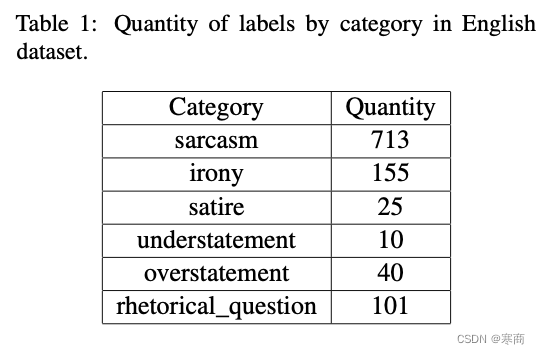

数据高度不平衡,体现在Task B中,Task B的标签数据分布如下所示:

标签数量差异十分巨大,且除此之外还有大量的非讽刺标签存在。

解决方案:

当时考虑过独立训练每个标签,缺点是丧失了标签之间的关联性(虽然我也不知道他们之间的关联性是啥),相对来说在训练每个独立二分类器的时候,还是比较容易选取相对平衡的训练集。然而这个方案对于标签太少的(如understatement)依旧没啥办法。

也考虑过数据增强,然而数据增强可能会损失句子的讽刺意义,担心引入太多脏数据,所以没有采用。

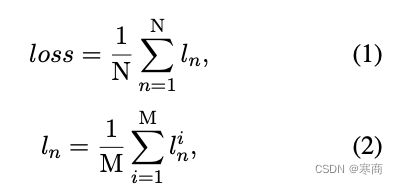

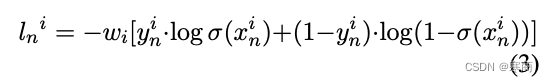

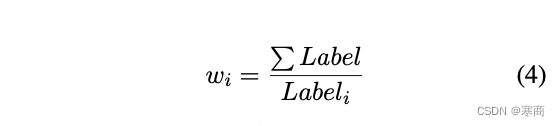

最后效果比较好的,还是采用了Label-Power(就是一个分类器来输出多个标签)方案。训练数据选取上只用了一小部分非讽刺标签,避免模型过度关注非讽刺标签。另外就是在损失函数上使用了WBCE(带有权重的BCE),来增大模型对数量少的标签的关注度。WBCE以及权重计算方法如下所示:

Task C的训练集构造

这个也讲讲吧,这个任务是最平衡的了,果然我处理不平衡不如别人,只在这个任务上取得了还不错的排名。

我们设有讽刺的文本为tweet,无讽刺的转述为rephrase,无非就两种可能的句子对,(tweet,rephrase)或(rephrase,tweet)。

数据集中有tweet列和rephrase列,那就很好办了,在模型介绍里我们看到了Task C输入部分的样子。

显然,我们需要两个句子来输入,tweet、rephrase作为Sentence A、B(B、A),然后给对应的标签0(1),即

- (tweet,rephrase) as 0

- (rephrase,tweet) as 1

结果

实验细节和结果分析不想讲太多,论文和代码都有。

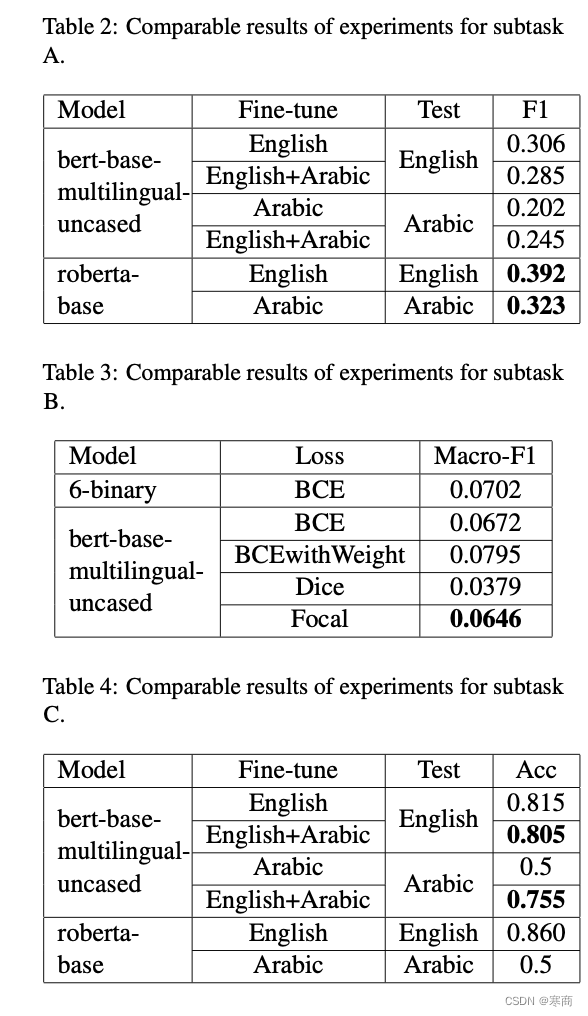

官方给的主要评估指标:

- SubTask A: F1-score for the sarcastic class.

- SubTask B: Macro-F1 score.

- SubTask C: Accuracy.

我们尝试的各种方法结果如下所示,加粗的是我提交上去的结果,不一定是我们实验中最好的方案(他只记最后一次提交的结果,我还以为是最好的,,,,坑啊)