- 1PlatformIO开发之STM32点灯(基于arduino框架)

- 2业务中台建设与应用_终于有人把前台、中台、后台都讲明白了

- 3握手信号学习记录_握手信号的打拍

- 4原来R语言还有这些不为人知的用处!

- 5【SpringMVC】Spring Web MVC入门(一)

- 6挑战杯 基于深度学习的人脸表情识别

- 7【华为OD机考 统一考试机试C卷】生成哈夫曼树(C++ Java JavaScript Python C语言)_华为od机试 - 生成哈夫曼树(java & js & python & c)

- 8XSS渗透与防御

- 9git 跳过 ssl_git ssl跳过

- 10ssh连接出现的错误及解决方法!!!!!!!_ssh 链接以后两个×

GFS分布式文件系统概述以及集群部署

赞

踩

目录

7.4 分布式条带卷(Distribute Stripe volume)

7.5 分布式复制卷(Distribute Replica volume)

7.6 条带复制卷(Stripe Replca volume)

7.7 分布式条带复制卷(Distribute Stripe Replicavolume)

8.5 安装GFS

一、GlusterFS简介

- GFS是一个可扩展的分布式文件系统,用于大型的、分布式的、对大量数据进行访问的应用。它运行于廉价的普通硬件上,并提供容错功能。它可以给大量的用户提供总体性能较高的服务。

- GlusterFS 是一个开源的分布式文件系统。

- 由存储服务器、客户端以及NFS/Samba 存储网关(可选,根据需要选择使用)组成。

- 没有元数据服务器组件,这有助于提升整个系统的性能、可靠性和稳定性。

传统的分布式文件系统和GlusterFS的区别

- 传统的分布式文件系统大多通过元服务器来存储元数据,元数据包含存储节点上的目录信息、目录结构等。这样的设计在浏览目录时效率高,但是也存在一些缺陷,例如单点故障。一旦元数据服务器出现故障,即使节点具备再高的冗余性,整个存储系统也将崩溃。

- GlusterFS 分布式文件系统是基于无元服务器的设计,数据横向扩展能力强,具备较高的可靠性及存储效率。

- GlusterFs同时也是Scale-Out(横向扩展)存储解决方案Gluster的核心,在存储数据方面具有强大的横向扩展能力,通过扩展能够支持数PB存储容量和处理数千客户端。

- GlusterFS支持借助TCP/IP或InfiniBandRDMA网络 (一种支持多并发链接的技术,具有高带宽、低时延、高扩展性的特点)将物理分散分布的存储资源汇聚在一起,统一提供存储服务,并使用统一全局命名空间来管理数据。

二、GlusterFS特点

2.1 扩展性和高性能

- GlusterFS利用双重特性来提供高容量存储解决方案。

- Scale-Out架构允许通过简单地增加存储节点的方式来提高存储容量和性能(磁盘、计算和I/O资源都可以独立增加),支持10GbE和InfiniBand等高速网络互联。

- Gluster弹性哈希(ElasticHash) 解决了GlusterFS对元数据服务器的依赖,改善了单点故障和性能瓶颈,真正实现了并行化数据访问。GlusterFS采用弹性哈希算法在存储池中可以智能地定位任意数据分片(将数据分片存储在不同节点上),不需要查看索引或者向元数据服务器查询。

2.2 高可用性

- GlusterFS可以对文件进行自动复制,如镜像或多次复制,从而确保数据总是可以访问,甚至是在硬件故障的情况下也能正常访问当数据出现不一致时,自我修复功能能够把数据恢复到正确的状态,数据的修复是以增量的方式在后台执行,几乎不会产生性能负载。

- GlusterFS可以支持所有的存储,因为它没有设计自己的私有数据文件格式,而是采用操作系统中主流标准的磁盘文件系统(如EXT3、XFS等)来存储文件,因此数据可以使用传统访问磁盘的方式被访问。

2.3 全局统一命名空间

- 分布式存储中,将所有节点的命名空间整合为统一命名空间,将整个系统的所有节点的存储容量组成一个大的虛拟存储池,供前端主机访问这些节点完成数据读写操作。

2.4 弹性卷管理

- GlusterFs通过将数据储存在逻辑卷中,逻辑卷从逻辑存储池进行独立逻辑划分而得到。

- 逻辑存储池可以在线进行增加和移除,不会导致业务中断。逻辑卷可以根据需求在线增长和缩减,并可以在多个节点中实现负载均衡。

- 文件系统配置也可以实时在线进行更改并应用,从而可以适应工作负载条件变化或在线性能调优。

2.5 基于标准协议

- Gluster存储服务支持NFS、CIFS、HTTP、FTP、SMB 及Gluster原生协议,完全与POSIX标准(可移植操作系统接口)兼容。

- 现有应用程序不需要做任何修改就可以对Gluster中的数据进行访问,也可以使用专用API进行访问。

三、GlusterFS术语

使用GFS会使用的虚拟文件系统

- Brick(块存储服务器)实际存储用户数据的服务器

- Volume(逻辑卷)本地文件系统的"分区"

- FUSE用户空间的文件系统(类别EXT4),”这是一个伪文件系统“,用户端的交换模块

- VFS(虚拟端口)内核态的虚拟文件系统,用户是提交请求给VFS 然后VFS交给FUSH,再交给GFS客户端,最后由客户端交给远端的存储

- Glusterd(服务)是运行再存储节点的进程(客户端运行的是gluster client)GFS使用过程中整个GFS之间的交换由Gluster client 和glusterd完成

四、模块化堆栈式架构

- GlusterFS 采用模块化、堆栈式的架构。

- 通过对模块进行各种组合,即可实现复杂的功能。例如 Replicate 模块可实现 RAID1,Stripe 模块可实现 RAID0, 通过两者的组合可实现 RAID10 和 RAID01,同时获得更高的性能及可靠性。

五、GlusterFS 的工作流程

- 外来一个请求,例:用户端申请创建一个文件,客户端或应用程序通过GFS的挂载点访问数据

- linux系统内容通过VFSAPI收到请求并处理

- VFS将数据递交给FUSE内核文件系统,fuse文件系统则是将数据通过/dev/fuse设备文件递交给了GlusterFS client端

- GlusterFS client端收到数据后,会根据配置文件的配置对数据进行处理

- 再通过网络,将数据发送给远端的ClusterFS server,并将数据写入到服务器储存设备上

- server再将数据转交给VFS伪文件系统,再由VFS进行转存处理,最后交给EXT3

六、弹性 HASH 算法

- 弹性 HASH 算法是 Davies-Meyer 算法的具体实现,通过 HASH 算法可以得到一个 32 位的整数范围的 hash 值,

- 假设逻辑卷中有 N 个存储单位 Brick,则 32 位的整数范围将被划分为 N 个连续的子空间,每个空间对应一个 Brick。

- 当用户或应用程序访问某一个命名空间时,通过对该命名空间计算 HASH 值,根据该 HASH 值所对应的 32 位整数空间定位数据所在的 Brick。

弹性 HASH 算法的优点:

- 保证数据平均分布在每一个 Brick 中。

- 解决了对元数据服务器的依赖,进而解决了单点故障以及访问瓶颈。

七、GFS支持的七种卷

7.1 分布式卷(Distribute volume)

- 文件通过HASH算法分布到所有Brick Server上,这种卷是GlusterFS的默认卷;以文件为单位根据HASH算法散列到不同的Brick,其实只是扩大了磁盘空间,如果有一块磁盘损坏,数据也将丢失,属于文件级的RAID0,不具有容错能力。

- 在该模式下,并没有对文件进行分块处理,文件直接存储在某个Server节点上。

- 由于直接使用本地文件系统进行文件存储,所以存取效率并没有提高,反而会因为网络通信的原因而有所降低。

分布式卷具有如下特点:

- 文件分布在不同的服务器,不具备冗余性。

- 更容易和廉价地扩展卷的大小。

- 单点故障会造成数据丢失。

- 依赖底层的数据保护。

7.2 条带卷(Stripe volume)

- 类似RAID0,文件被分成数据块并以轮询的方式分布到多个Brick Server上,文件存储以数据块为单位,支持大文件存储,文件越大,读取效率越高,但是不具备冗余性。

条带卷特点:

- 数据被分割成更小块分布到块服务器群中的不同条带区。

- 分布减少了负载且更小的文件加速了存取的速度。

- 没有数据冗余。

7.3 复制卷(Replica volume)

- 将文件同步到多个Brick上,使其具备多个文件副本,属于文件级RAID 1,具有容错能力。因为数据分散在多个Brick中,所以读性能得到很大提升,但写性能下降。

- 复制卷具备冗余性,即使一个节点损坏,也不影响数据的正常使用。但因为要保存副本,所以磁盘利用率较低。

复制卷特点:

- 卷中所有的服务器均保存一个完整的副本。

- 卷的副本数量可由客户创建的时候决定,但复制数必须等于卷中Brick所包含的存储服务器数。

- 至少由两个块服务器或更多服务器。

- 具备冗余性。

7.4 分布式条带卷(Distribute Stripe volume)

- BrickServer数量是条带数(数据块分布的Brick数量)的倍数,兼具分布式卷和条带卷的特点。

- 主要用于大文件访问处理,创建一个分布式条带卷最少需要4台服务器。

- 创建一个名为dis-stripe的分布式条带卷,配置分布式的条带卷时,卷中Brick所包含的存储服务器数必须是条带数的倍数(>=2倍)。Brick的数量是4 (Server1:/dir1、Server2:/dir2、Server3:/dir3和Server4:/dir4),条带数为2(stripe 2)

- 创建卷时,存储服务器的数量如果等于条带或复制数,那么创建的是条带卷或者复制卷:如果存储服务器的数量是条带或复制数的2倍甚至更多,那么将创建的是分布式条带卷或分布式复制卷。

7.5 分布式复制卷(Distribute Replica volume)

- Brick Server数量是镜像数(数据副本数量)的倍数,兼具分布式卷和复制卷的特点。主要用于需要冗余的情况下。

- 创建一个名为dis-rep的分布式复制卷,配置分布式的复制卷时,卷中Brick所包含的存储服务器数必须是复制数的倍数(>=2倍)。Brick的数量是4 (Server1:/dir1、Server2:/dir2、Server3:/dir3 和Server4:/dir4),复制数为2(replica 2)

7.6 条带复制卷(Stripe Replca volume)

- 类似RAID10,同时具有条带卷和复制卷的特点。

7.7 分布式条带复制卷(Distribute Stripe Replicavolume)

- 三种基本卷的复合卷,通常用于类Map Reduce应用。

八、GFS部署

8.1 集群环境

- Node1节点:node1/192.168.19.3 磁盘: /dev/sdb1 挂载点: /data/sdb1

- /dev/sdc1 /data/sdc1

- /dev/sdd1 /data/sdd1

- /dev/sde1 /data/sde1

-

- Node2节点:node2/192.168.19.4 磁盘: /dev/sdb1 挂载点: /data/sdb1

- /dev/sdc1 /data/sdc1

- /dev/sdd1 /data/sdd1

- /dev/sde1 /data/sde1

-

- Node3节点:node3/192.168.19.5 磁盘: /dev/sdb1 挂载点: /data/sdb1

- /dev/sdc1 /data/sdc1

- /dev/sdd1 /data/sdd1

- /dev/sde1 /data/sde1

-

- Node4节点:node4/192.168.19.6 磁盘: /dev/sdb1 挂载点: /data/sdb1

- /dev/sdc1 /data/sdc1

- /dev/sdd1 /data/sdd1

- /dev/sde1 /data/sde1

-

- =====客户端节点:192.168.19.7=====

- 首先,每台节点添加四块磁盘,仅做实验,无需太大

- 然后,重启服务器,准备开始部署

8.2 更改节点名称

node1(192.168.19.3)

- hostnamectl set-hostname node1

- bash

node2(192.168.19.4)

- hostnamectl set-hostname node2

- bash

node3(192.168.19.5)

- hostnamectl set-hostname node3

- bash

node4(192.168.19.6)

- hostnamectl set-hostname node4

- bash

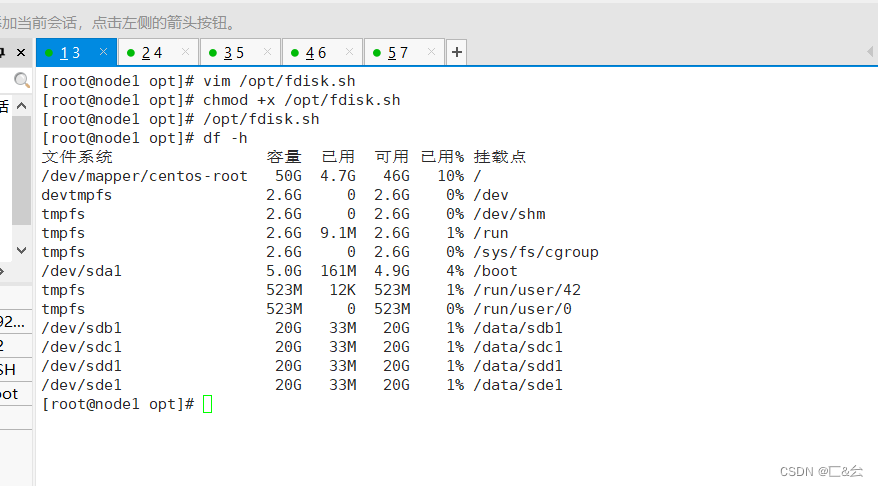

8.3 节点进行磁盘挂载,安装本地源

所有节点(这里使用node1作为示范)

- 关闭防火墙

- systemctl stop firewalld

- setenforce 0

-

- 磁盘分区,并挂载

- vim /opt/fdisk.sh

- #!/bin/bash

- #获取sdb,sdc,sdd,sde

- NEWDEV=`ls /dev/sd* | grep -o 'sd[b-z]' | uniq`

-

- for VAR in $NEWDEV

- do

- #免交互分区

- echo -e "n\np\n\n\n\nw\n" | fdisk /dev/$VAR &> /dev/null

-

- #刷新分区表

- partprobe &> /dev/null

-

- #格式化

- mkfs.xfs /dev/${VAR}"1" &> /dev/null

-

- #创建挂载点

- mkdir -p /data/${VAR}"1" &> /dev/null

-

- #在 /etc/fstab配置开机自动挂载

- echo "/dev/${VAR}"1" /data/${VAR}"1" xfs defaults 0 0" >> /etc/fstab

- done

- #检测并挂载

- mount -a &> /dev/null

8.4 配置/etc/hosts文件

- 以Node1节点为例:

- hostnamectl set-hostname node1

- su

-

- echo "192.168.19.3 node1" >> /etc/hosts

- echo "192.168.19.4 node2" >> /etc/hosts

- echo "192.168.19.5 node3" >> /etc/hosts

- echo "192.168.19.6 node4" >> /etc/hosts

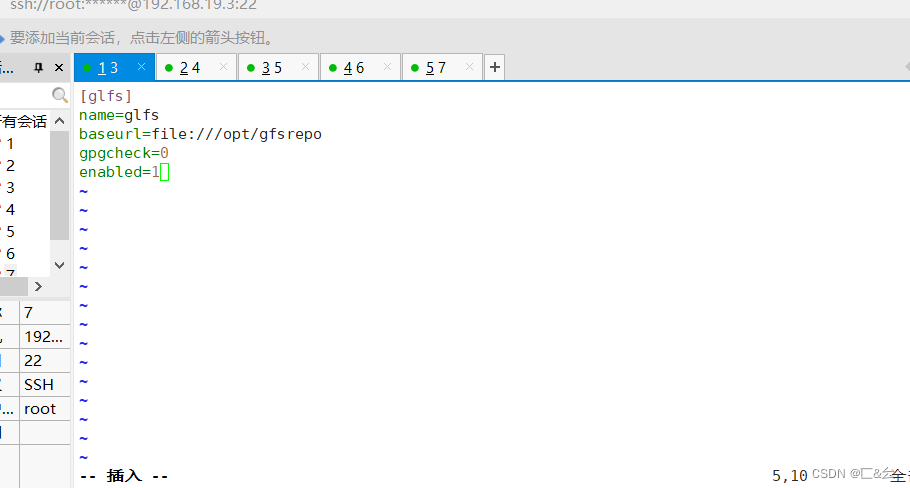

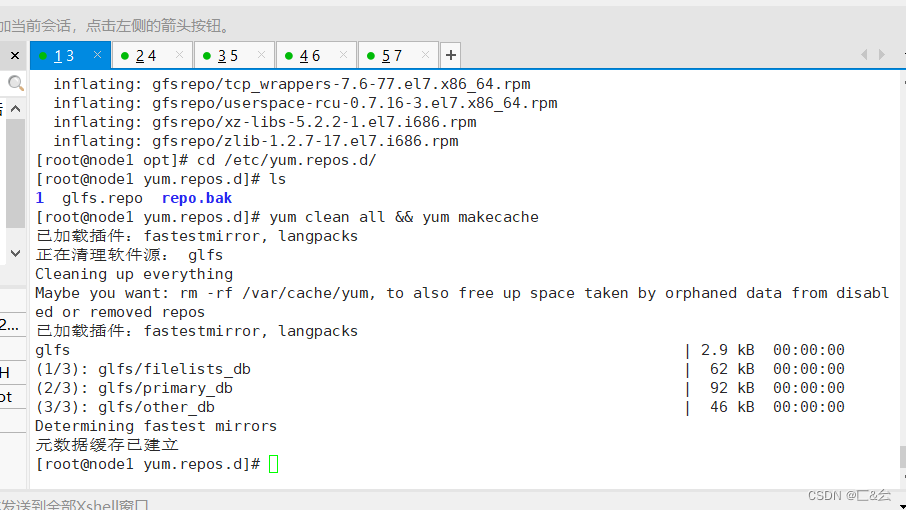

8.5 安装GFS

- #将gfsrepo 软件上传到/opt目录下

- cd /etc/yum.repos.d/

- mkdir repo.bak

- mv *.repo repo.bak

- vim glfs.repo

- [glfs]

- name=glfs

- baseurl=file:///opt/gfsrepo

- gpgcheck=0

- enabled=1

-

- yum clean all && yum makecache

-

- #yum -y install centos-release-gluster #如采用官方 YUM 源安装,可以直接指向互联网仓库

- yum -y install glusterfs glusterfs-server glusterfs-fuse glusterfs-rdma

-

- systemctl start glusterd.service

- systemctl enable glusterd.service

- systemctl status glusterd.service

-

- 故障原因是版本过高导致

- yum remove glusterfs-api.x86_64 glusterfs-cli.x86_64 glusterfs.x86_64 glusterfs-libs.x86_64 glusterfs-client-xlators.x86_64 glusterfs-fuse.x86_64 -y

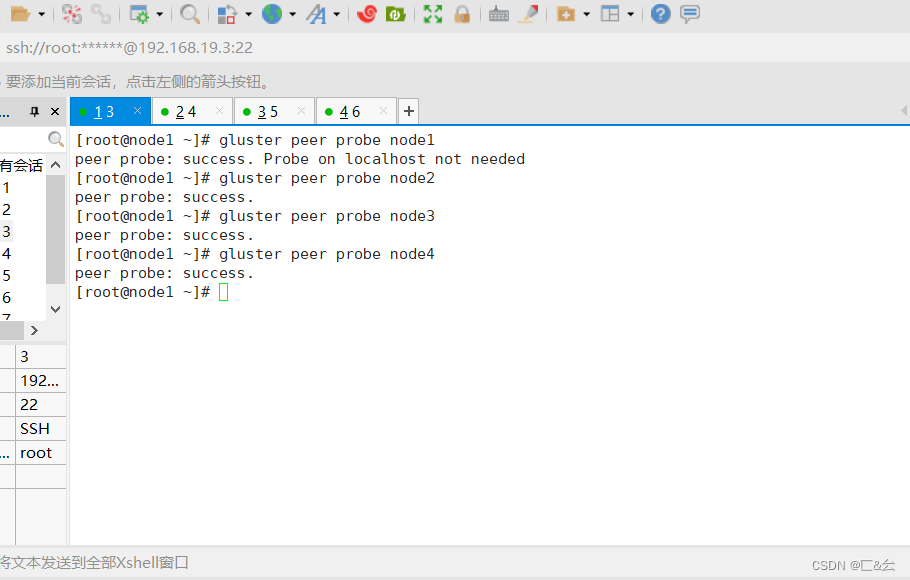

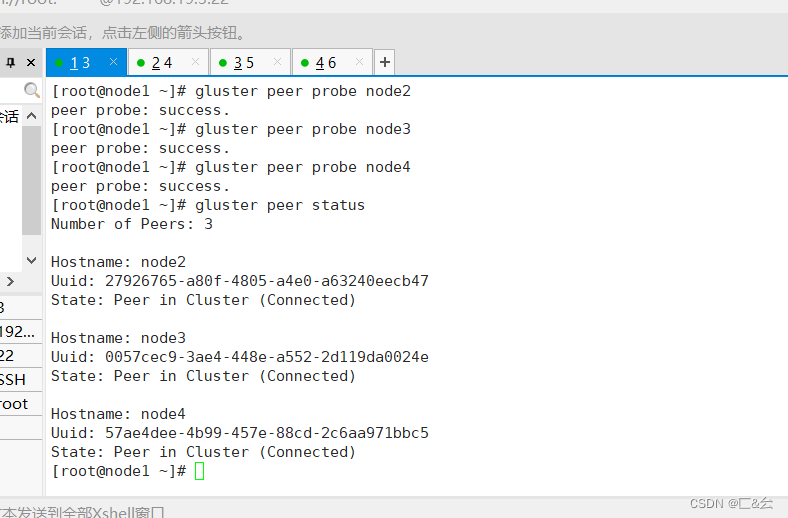

8.6 添加节点到存储信任池中

- 只要在一台Node节点上添加其它节点即可

- gluster peer probe node1

- gluster peer probe node2

- gluster peer probe node3

- gluster peer probe node4

-

- #在每个Node节点上查看群集状态

- gluster peer status

在任意Node节点查看集群状态

九、创建卷

| 卷名 | 卷类型 | Brick |

|---|---|---|

| dis-volume | 分布式卷 | node1(/data/sdb1), node2(/data/sdb1) |

| stripe-volume | 条带卷 | node1(/data/sdc1)、node2(/data/sdc1) |

| 卷名 | 卷类型 | Brick |

| dis-volume | 分布式卷 | node1(/data/sdb1), node2(/data/sdb1) |

| stripe-volume | 条带卷 | node1(/data/sdc1)、node2(/data/sdc1) |

在任意node主机都可以操作。因为都关联起来了.

9.1 分布式卷

创建分布式卷,没有指定类型,默认创建的是分布式卷.。在没有指传输协议时,默认使用tcp

- #创建分布式卷,没有指定类型,默认创建的是分布式卷

- gluster volume create dis-volume node1:/data/sdb1 node2:/data/sdb1 force

![]()

- #查看卷列表

- gluster volume list

-

- #启动新建分布式卷

- gluster volume start dis-volume

-

- #查看创建分布式卷信息

- gluster volume info dis-volume

9.2 条带卷

指定类型为 stripe ,数值为2,且后面跟了2 个 Brick Server,所以创建的是条带卷

- #指定类型为 stripe,数值为 2,且后面跟了 2 个 Brick Server,所以创建的是条带卷

- gluster volume create stripe-volume stripe 2 node1:/data/sdc1 node2:/data/sdc1 force

- gluster volume start stripe-volume

- gluster volume info stripe-volume

9.3 创建复制卷

指定类型为replica ,数值为2 ,且后面跟了2 个 Brick Server,所以创建的是复制卷

- #指定类型为 replica,数值为 2,且后面跟了 2 个 Brick Server,所以创建的是复制卷

- gluster volume create rep-volume replica 2 node3:/data/sdb1 node4:/data/sdb1 force

- gluster volume start rep-volume

- gluster volume info rep-volume

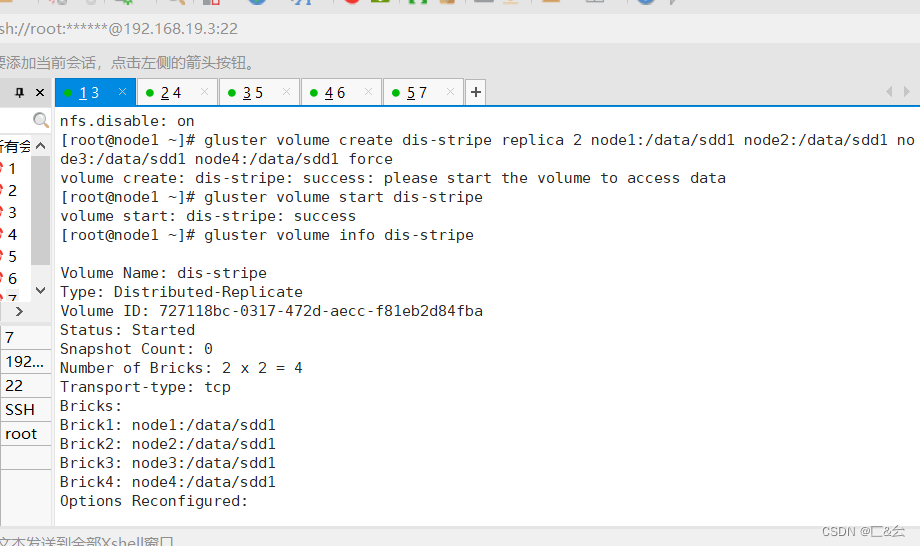

9.4 创建分布式条带卷

指定类型为stripe ,数值为2,后面跟了4个brick Server,是2的两倍。所以创建的是分布式条带卷

- #指定类型为 stripe,数值为 2,而且后面跟了 4 个 Brick Server,是 2 的两倍,所以创建的是分布式条带卷

- gluster volume create dis-stripe stripe 2 node1:/data/sdd1 node2:/data/sdd1 node3:/data/sdd1 node4:/data/sdd1 force

- gluster volume start dis-stripe

- gluster volume info dis-stripe

9.5 创建分布式复制卷

指定类型为 replica,数值为 2,而且后面跟了 4 个 Brick Server,是 2 的两倍,所以创建的是分布式复制

- 指定类型为 replica,数值为 2,而且后面跟了 4 个 Brick Server,是 2 的两倍,所以创建的是分布式复制卷

- gluster volume create dis-rep replica 2 node1:/data/sde1 node2:/data/sde1 node3:/data/sde1 node4:/data/sde1 force

- gluster volume start dis-rep

- gluster volume info dis-rep

9.6 查看当前所有卷列表

- #查看当前所有卷的列表

- gluster volume list

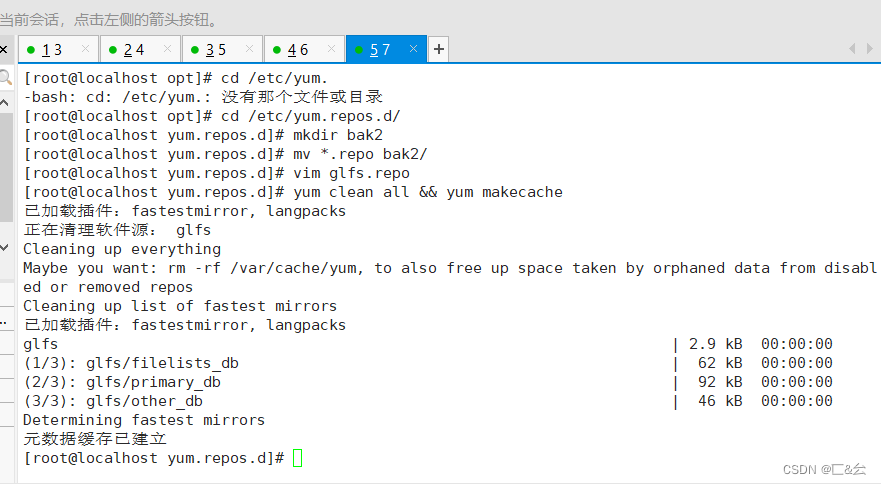

十、部署Gluster 客户端

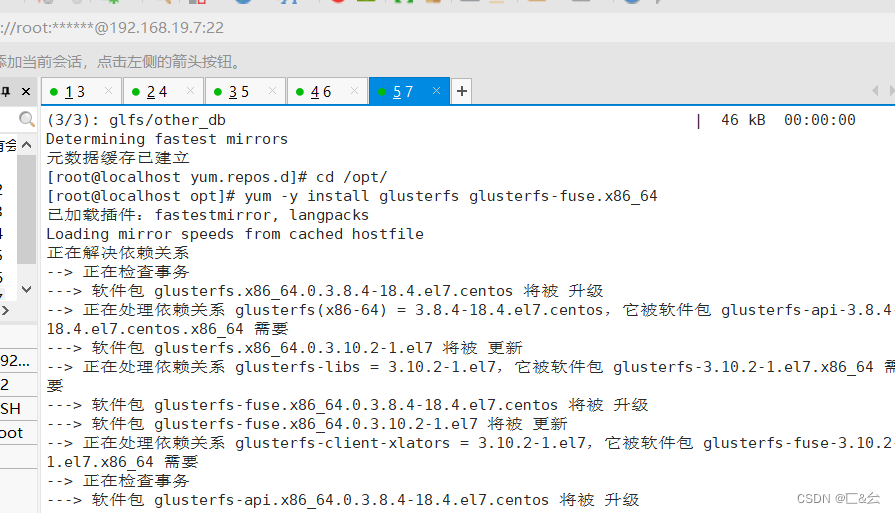

10.1 安装部客户端软件

将gfsrepo 软件上传到 /opt 目录下(可以解压后压缩为zip 格式上传到linux中)

- #将gfsrepo 软件上传到/opt目下

- cd /etc/yum.repos.d/

- mkdir repo.bak

- mv *.repo repo.bak

- vim glfs.repo

- [glfs]

- name=glfs

- baseurl=file:///opt/gfsrepo

- gpgcheck=0

- enabled=1

-

- yum clean all && yum makecache

-

- yum -y install glusterfs glusterfs-fuse

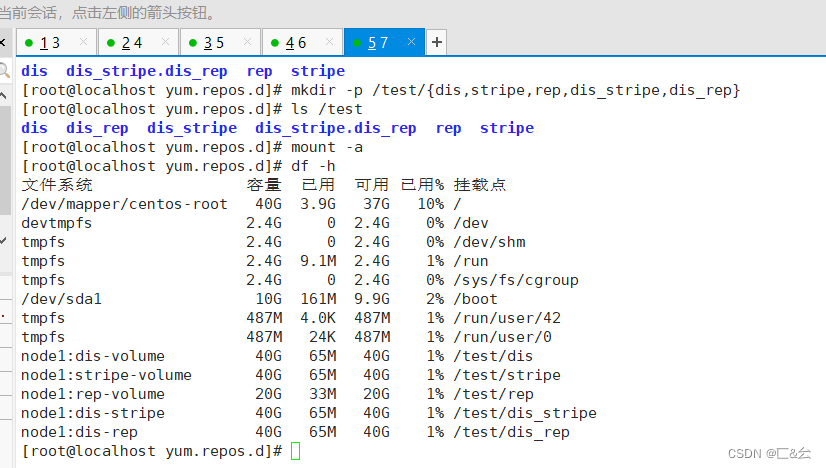

10.2 创建挂载点目录,配置主机名映射,挂载卷

- mkdir -p /test/{dis,stripe,rep,dis_stripe,dis_rep}

- ls /test

-

- 配置 /etc/hosts 文件

- echo "192.168.19.3 node1" >> /etc/hosts

- echo "192.168.19.4 node2" >> /etc/hosts

- echo "192.168.19.5 node3" >> /etc/hosts

- echo "192.168.19.6 node4" >> /etc/hosts

- 挂载 Gluster 文件系统

- #临时挂载

- mount.glusterfs node1:dis-volume /test/dis

- mount.glusterfs node1:stripe-volume /test/stripe

- mount.glusterfs node1:rep-volume /test/rep

- mount.glusterfs node1:dis-stripe /test/dis_stripe

- mount.glusterfs node1:dis-rep /test/dis_rep

-

- df -Th

-

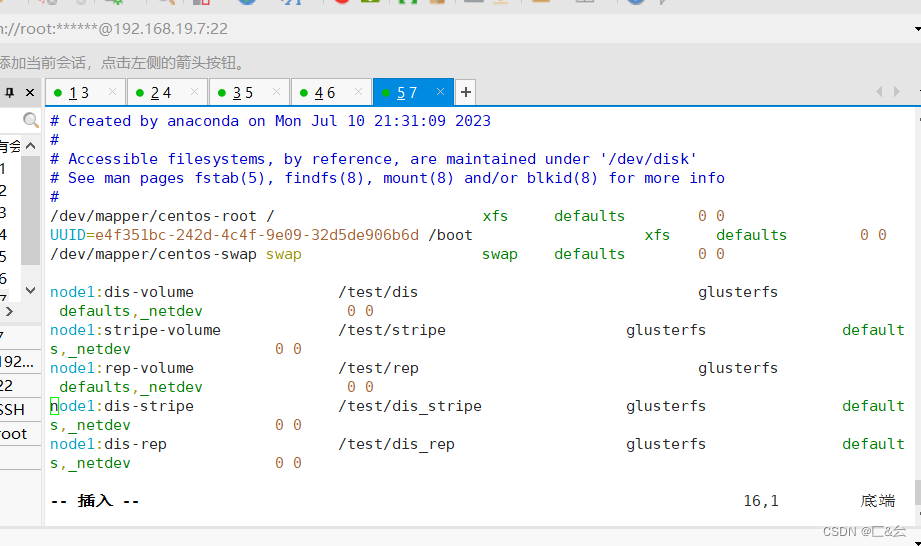

- #永久挂载

- vim /etc/fstab

- node1:dis-volume /test/dis glusterfs defaults,_netdev 0 0

- node1:stripe-volume /test/stripe glusterfs defaults,_netdev 0 0

- node1:rep-volume /test/rep glusterfs defaults,_netdev 0 0

- node1:dis-stripe /test/dis_stripe glusterfs defaults,_netdev 0 0

- node1:dis-rep /test/dis_rep glusterfs defaults,_netdev 0 0

十一、测试GlusterFS 文件系统

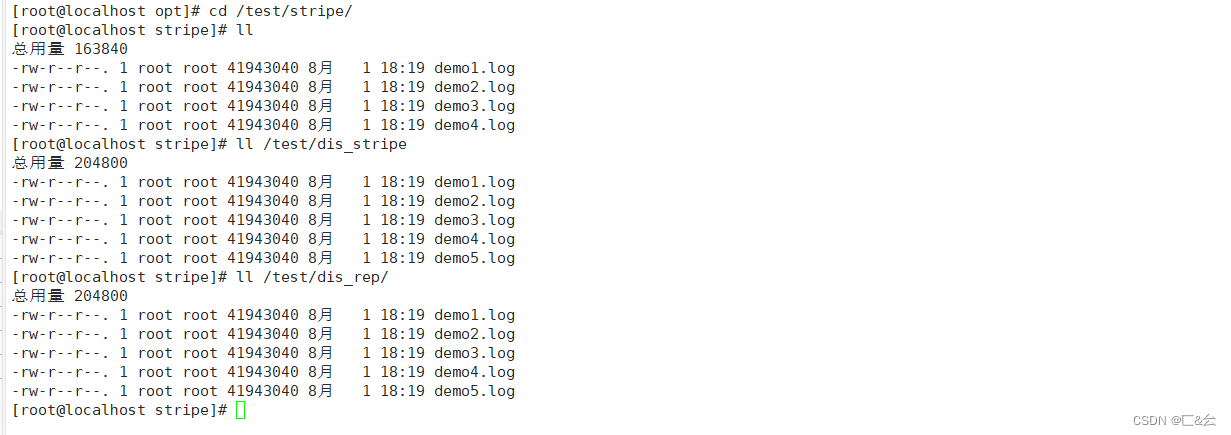

11.1 卷中写入文件,客户端操作

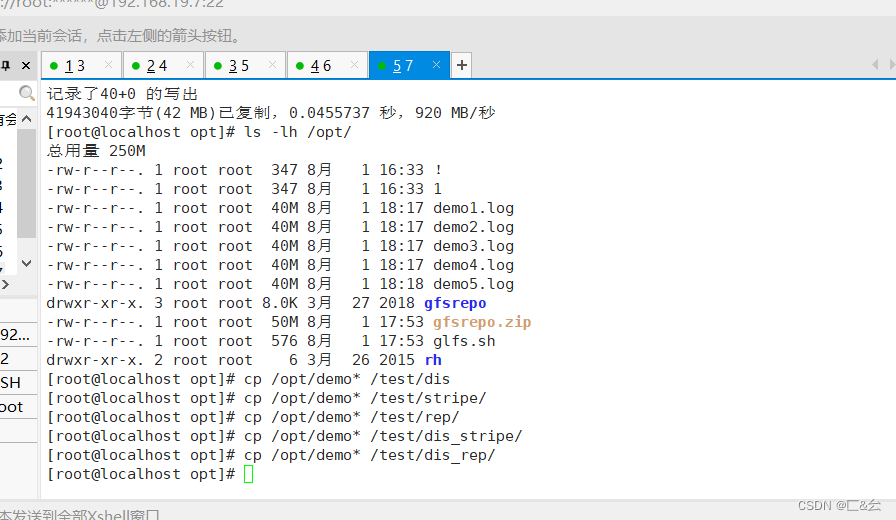

- 卷中写入文件,客户端操作

- cd /opt

- dd if=/dev/zero of=/opt/demo1.log bs=1M count=40

- dd if=/dev/zero of=/opt/demo2.log bs=1M count=40

- dd if=/dev/zero of=/opt/demo3.log bs=1M count=40

- dd if=/dev/zero of=/opt/demo4.log bs=1M count=40

- dd if=/dev/zero of=/opt/demo5.log bs=1M count=40

-

- ls -lh /opt

-

- cp /opt/demo* /test/dis

- cp /opt/demo* /test/stripe/

- cp /opt/demo* /test/rep/

- cp /opt/demo* /test/dis_stripe/

- cp /opt/demo* /test/dis_rep/

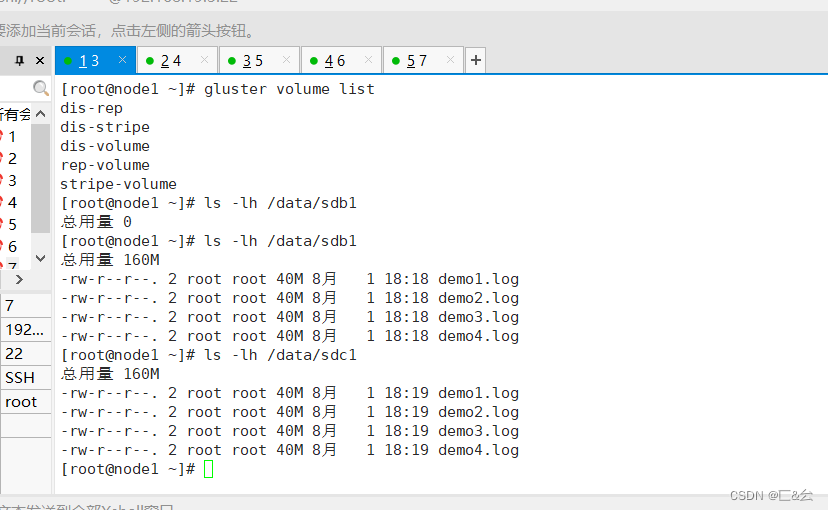

11.2 查看文件分布

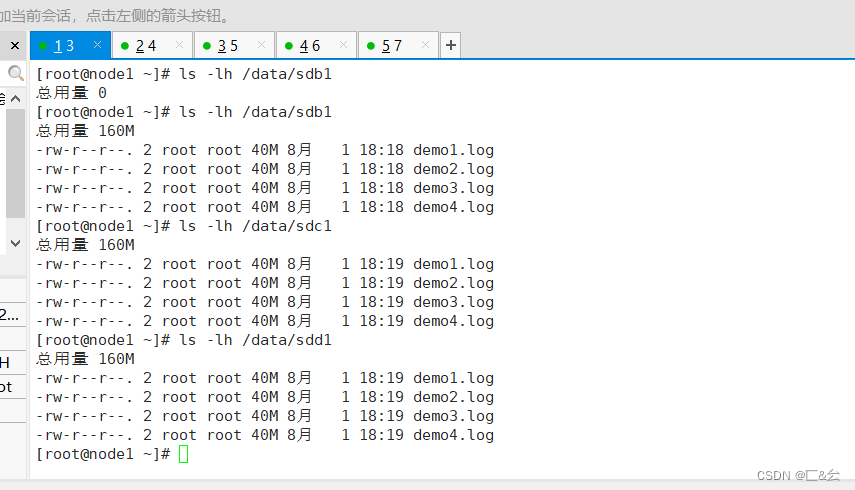

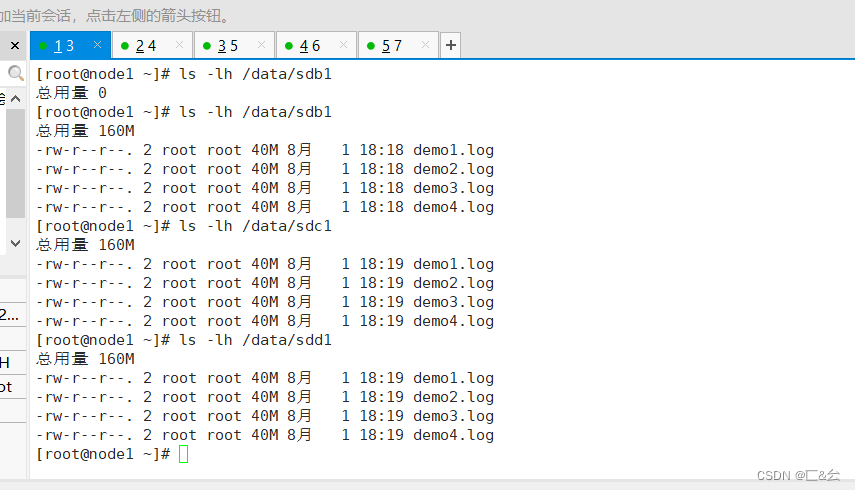

- 查看文件分布

- #查看分布式文件分布

- ls -lh /data/sdb1

- #查看条带卷文件分布

- ls -lh /data/sdc1

- #查看复制卷分布

- ll -h /data/sdb1

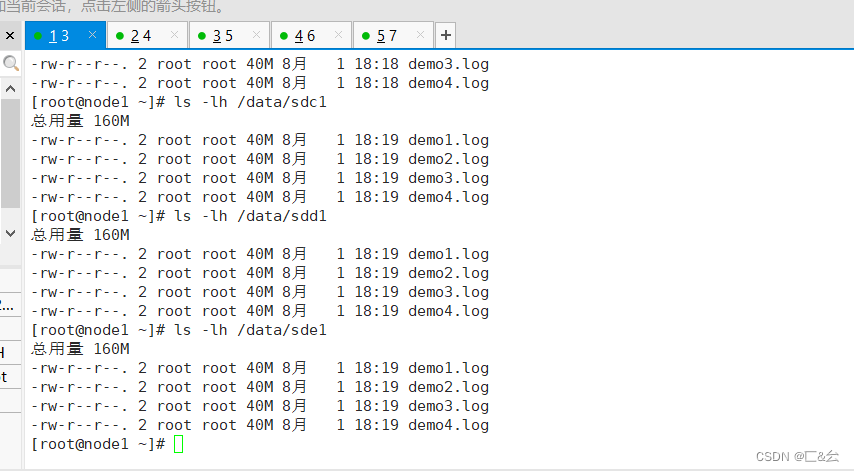

- 查看分布式条带卷分布

- ll -h /data/sdd1

- #查看分布式复制卷分布

- ll -h /data/sde1

十二、破坏性测试

- #挂起 node2 节点或者关闭glusterd服务来模拟故障

- systemctl stop glusterd.service

-

- #在客户端上查看文件是否正常

- #分布式卷数据查看

- ll /test/dis/ #在客户机上发现少了demo5.log文件,这个是在node2上的

-

-

- #条带卷

- cd /test/stripe/ #无法访问,条带卷不具备冗余性

-

- #分布式条带卷

- ll /test/dis_stripe/ #无法访问,分布条带卷不具备冗余性

-

- #分布式复制卷

- ll /test/dis_rep/ #可以访问,分布式复制卷具备冗余性

十三、拓展

- 扩展其他的维护命令:

- 1.查看GlusterFS卷

- gluster volume list

-

- 2.查看所有卷的信息

- gluster volume info

-

- 3.查看所有卷的状态

- gluster volume status

-

- 4.停止一个卷

- gluster volume stop dis-stripe

-

- 5.删除一个卷,注意:删除卷时,需要先停止卷,且信任池中不能有主机处于宕机状态,否则删除不成功

- gluster volume delete dis-stripe

-

- 6.设置卷的访问控制

- #仅拒绝

- gluster volume set dis-rep auth.deny 192.168.19.100

-

- #仅允许

- gluster volume set dis-rep auth.allow 192.168.19.* #设置192.168.19.0网段的所有IP地址都能访问dis-rep卷(分布式复制卷)