热门标签

热门文章

- 1maven项目创建可执行jar的6种方法_mvn命令构建jar包

- 2CMake与vs的配置对应(常规->附加包含目录,链接器->输入)_cmake如何对应到vs链接器输入中.lib

- 3【opencv】教程代码 —ImgProc (10)图像平滑处理

- 49. 什么是 SAP ABAP 为 Fiori 专门设计的编程模型(Programming Model)_abapfiori开发模式有哪些

- 5ChatGPT丨使用tiktoken计算tokens

- 6计算机领域国际会议分区表_sdm24是什么会议

- 7论文笔记:ShuffleNet v1_shufflenetv1论文

- 8postcss的安装与使用

- 9Could not allocate CursorWindow size due to error -12 错误解决方法

- 10incredbuild,msbuild 命令行调用实现自动化编译_incredibuild命令行

当前位置: article > 正文

NLP自然语言处理(二)—— 语料及词性标注 & 分词 & TFIDF_语料标注

作者:羊村懒王 | 2024-04-06 12:22:32

赞

踩

语料标注

通常,NLP无法一下子处理完整的段落或句子,因此,第一步往往是分句和分词

分词的话,对于英语句子,可以使用NLTK中的word_tokenize函数,对于中文句子,则可使用jieba模块

语料及词性标注

词性标注就是给每个词打上词类标签,如形容词、动词、名词等

常见的中文词性编码

词性标注的分类

词性标注的方法

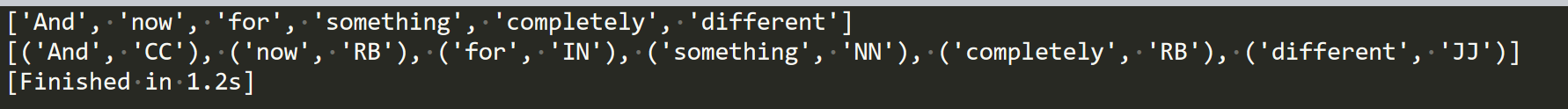

NLTK

Jieba (中文)

NLTK

Jieba

只要你想做中文的分词,jieba分词肯定要用到,不用怀疑

分词

把句子切分成词

分词难点

①分词标准

②切分歧义

切分歧义是由于分词细粒度不同造成的

或者这个句子本身就真正存在歧义

③新词

分词工具也要更新迭代

分词的算法

①基于词典的分词算法

②基于统计的分词算法

TF-IDF

TF-IDF(term frequency–inverse document frequency)是一种用于信息检索与数据挖掘的常用加权技术。

TF是词频(Term Frequency),IDF是逆文本频率指数(Inverse Document Frequency)。

TF-IDF实际上就是:TF * IDF

TF-IDF是一种统计方法,用以评估一字词对于一个文件集或一个语料库中的其中一份文件的重要程度。字词的重要性随着它在文件中出现的次数成正比增加,但同时会随着它在语料库中出现的频率成反比下降

TFIDF的主要思想是:如果某个词或短语在一篇文章中出现的频率TF高,并且在其他文章中很少出现,则认为此词或者短语具有很好的类别区分能力,适合用来分类

TF-IDF的计算

即

TF-IDF的作用

提取文本向量的特征

TF-IDF也有缺点

用词频来衡量文章中一个词的重要性不够全面

因为有些关键词可能就出现几次,但是对文章来说其重要性却是非常大的

sklearn可以用TF-IDF

NLTK可以用TF-IDF

声明:本文内容由网友自发贡献,不代表【wpsshop博客】立场,版权归原作者所有,本站不承担相应法律责任。如您发现有侵权的内容,请联系我们。转载请注明出处:https://www.wpsshop.cn/w/羊村懒王/article/detail/371852?site

推荐阅读

相关标签