- 1MVC与MVVM:两种前端架构模式对比

- 2LLM与通用智能体的思考与归纳_llm通用智能

- 3修改element-ui主题颜色_elementui更改主题颜色

- 4简单谈下 怎么避免游戏检测非法调用call _call被检测

- 5android studio 没有SDK Location选项问题_android studio没有sdk location

- 6javascript学习笔记最全

- 718个最热深度学习Github项目逐一介绍_github网络模型逐行解释代码

- 8华为AP5030DN FAT 固件 升级至 AP5030DN-FAT-V200R008C10SPC500-20180615_华为ap5030dn初始密码

- 9meteor方法

- 10使用python时import sklearn导入出错问题解决

YOLO剪枝模型部署到边缘终端设备jeston-orin-nano方法_yolov5 部署 边缘设备

赞

踩

中间遇到了不少坑,最近才把实验中的bug都搞完,记录一下

1前言

TensorRT是英伟达官方提供的一个高性能深度学习推理优化库,支持C++和Python两种编程语言API。通常情况下深度学习模型部署都会追求效率,尤其是在嵌入式平台上,所以一般会选择使用C++来做部署。

2导出ONNX模型

YOLOv5使用PyTorch框架进行训练,可以使用官方代码仓库中的export.py脚本把PyTorch模型转换为ONNX模型:

python export.py --weights yolov5x.pt --include onnx --imgsz 640 640

3准备模型输入数据

如果想用YOLOv5对图像做目标检测,在将图像输入给模型之前还需要做一定的预处理操作,预处理操作应该与模型训练时所做的操作一致。YOLOv5的输入是RGB格式的3通道图像,图像的每个像素需要除以255来做归一化,并且数据要按照CHW的顺序进行排布。所以YOLOv5的预处理大致可以分为两个步骤:

- 将原始输入图像缩放到模型需要的尺寸,比如

640x640。这一步需要注意的是,原始图像是按照等比例进行缩放的,如果缩放后的图像某个维度上比目标值小,那么就需要进行填充。举个例子:假设输入图像尺寸为768x576,模型输入尺寸为640x640,按照等比例缩放的原则缩放后的图像尺寸为640x480,那么在y方向上还需要填充640-480=160(分别在图像的顶部和底部各填充80)。来看一下实现代码: -

- cv::Mat input_image = cv::imread("dog.jpg");

- cv::Mat resize_image;

- const int model_width = 640;

- const int model_height = 640;

- const float ratio = std::min(model_width / (input_image.cols * 1.0f),

- model_height / (input_image.rows * 1.0f));

- // 等比例缩放

- const int border_width = input_image.cols * ratio;

- const int border_height = input_image.rows * ratio;

- // 计算偏移值

- const int x_offset = (model_width - border_width) / 2;

- const int y_offset = (model_height - border_height) / 2;

- cv::resize(input_image, resize_image, cv::Size(border_width, border_height));

- cv::copyMakeBorder(resize_image, resize_image, y_offset, y_offset, x_offset,

- x_offset, cv::BORDER_CONSTANT, cv::Scalar(114, 114, 114));

- // 转换为RGB格式

- cv::cvtColor(resize_image, resize_image, cv::COLOR_BGR2RGB);

对图像像素做归一化操作,并按照CHW的顺序进行排布。这一步的操作比较简单

- input_blob = new float[model_height * model_width * 3];

- const int channels = resize_image.channels();

- const int width = resize_image.cols;

- const int height = resize_image.rows;

- for (int c = 0; c < channels; c++) {

- for (int h = 0; h < height; h++) {

- for (int w = 0; w < width; w++) {

- input_blob[c * width * height + h * width + w] =

- resize_image.at<cv::Vec3b>(h, w)[c] / 255.0f;

- }

- }

- }

4ONNX模型部署

要使用TensorRT的C++ API来部署模型,首先需要包含头文件NvInfer.h。

#include "NvInfer.h"

TensorRT所有的编程接口都被放在命名空间nvinfer1中,并且都以字母I为前缀,比如ILogger、IBuilder等。使用TensorRT部署模型首先需要创建一个IBuilder对象,创建之前还要先实例化ILogger接口:

- lass MyLogger : public nvinfer1::ILogger {

- public:

- explicit MyLogger(nvinfer1::ILogger::Severity severity =

- nvinfer1::ILogger::Severity::kWARNING)

- : severity_(severity) {}

-

- void log(nvinfer1::ILogger::Severity severity,

- const char *msg) noexcept override {

- if (severity <= severity_) {

- std::cerr << msg << std::endl;

- }

- }

- nvinfer1::ILogger::Severity severity_;

- };

上面的代码默认会捕获级别大于等于WARNING的日志信息并在终端输出。实例化ILogger接口后,就可以创建IBuilder对象:

- MyLogger logger;

- nvinfer1::IBuilder *builder = nvinfer1::createInferBuilder(logger);

创建IBuilder对象后,优化一个模型的第一步是要构建模型的网络结构。

- const uint32_t explicit_batch = 1U << static_cast<uint32_t>(

- nvinfer1::NetworkDefinitionCreationFlag::kEXPLICIT_BATCH);

- nvinfer1::INetworkDefinition *network = builder->createNetworkV2(explicit_batch);

模型的网络结构有两种构建方式,一种是使用TensorRT的API一层一层地去搭建,这种方式比较麻烦;另外一种是直接从ONNX模型中解析出模型的网络结构,这需要ONNX解析器来完成。由于我们已经有现成的ONNX模型了,所以选择第二种方式。TensorRT的ONNX解析器接口被封装在头文件NvOnnxParser.h中,命名空间为nvonnxparser。创建ONNX解析器对象并加载模型的代码如下:

- const std::string onnx_model = "yolov5m.onnx";

- nvonnxparser::IParser *parser = nvonnxparser::createParser(*network, logger);

- parser->parseFromFile(model_path.c_str(),

- static_cast<int>(nvinfer1::ILogger::Severity::kERROR))

- // 如果有错误则输出错误信息

- for (int32_t i = 0; i < parser->getNbErrors(); ++i) {

- std::cout << parser->getError(i)->desc() << std::endl;

- }

模型解析成功后,需要创建一个IBuilderConfig对象来告诉TensorRT该如何对模型进行优化。这个接口定义了很多属性,其中最重要的一个属性是工作空间的最大容量。在网络层实现过程中通常会需要一些临时的工作空间,这个属性会限制最大能申请的工作空间的容量,如果容量不够的话会导致该网络层不能成功实现而导致错误。另外,还可以通过这个对象设置模型的数据精度。TensorRT默认的数据精度为FP32,我们还可以设置FP16或者INT8,前提是该硬件平台支持这种数据精度。

- nvinfer1::IBuilderConfig *config = builder->createBuilderConfig();

- config->setMemoryPoolLimit(nvinfer1::MemoryPoolType::kWORKSPACE, 1U << 25);

- if (builder->platformHasFastFp16()) {

- config->setFlag(nvinfer1::BuilderFlag::kFP16);

- }

设置IBuilderConfig属性后,就可以启动优化引擎对模型进行优化了,这个过程需要一定的时间,在嵌入式平台上可能会比较久一点。经过TensorRT优化后的序列化模型被保存到IHostMemory对象中,我们可以将其保存到磁盘中,下次使用时直接加载这个经过优化的模型即可,这样就可以省去漫长的等待模型优化的过程。我一般习惯把序列化模型保存到一个后缀为.engine的文件中。

- nvinfer1::IHostMemory *serialized_model =

- builder->buildSerializedNetwork(*network, *config);

-

- // 将模型序列化到engine文件中

- std::stringstream engine_file_stream;

- engine_file_stream.seekg(0, engine_file_stream.beg);

- engine_file_stream.write(static_cast<const char *>(serialized_model->data()),

- serialized_model->size());

- const std::string engine_file_path = "yolov5m.engine";

- std::ofstream out_file(engine_file_path);

- assert(out_file.is_open());

- out_file << engine_file_stream.rdbuf();

- out_file.close();

由于IHostMemory对象保存了模型所有的信息,所以前面创建的IBuilder、IParser等对象已经不再需要了,可以通过delete进行释放。

- delete config;

- delete parser;

- delete network;

- delete builder;

IHostMemory对象用完后也可以通过delete进行释放。

2. 模型反序列化

通过上一步得到优化后的序列化模型后,如果要用模型进行推理,那么还需要创建一个IRuntime接口的实例,然后通过其模型反序列化接口去创建一个ICudaEngine对象:

- nvinfer1::IRuntime *runtime = nvinfer1::createInferRuntime(logger);

- nvinfer1::ICudaEngine *engine = runtime->deserializeCudaEngine(

- serialized_model->data(), serialized_model->size());

-

- delete serialized_model;

- delete runtime;

如果是直接从磁盘中加载.engine文件也是差不多的步骤,首先从.engine文件中把模型加载到内存中,然后再通过IRuntime接口对模型进行反序列化即可。

- const std::string engine_file_path = "yolov5m.engine";

- std::stringstream engine_file_stream;

- engine_file_stream.seekg(0, engine_file_stream.beg);

- std::ifstream ifs(engine_file_path);

- engine_file_stream << ifs.rdbuf();

- ifs.close();

-

- engine_file_stream.seekg(0, std::ios::end);

- const int model_size = engine_file_stream.tellg();

- engine_file_stream.seekg(0, std::ios::beg);

- void *model_mem = malloc(model_size);

- engine_file_stream.read(static_cast<char *>(model_mem), model_size);

-

- nvinfer1::IRuntime *runtime = nvinfer1::createInferRuntime(logger);

- nvinfer1::ICudaEngine *engine = runtime->deserializeCudaEngine(model_mem, model_size);

-

- delete runtime;

- free(model_mem);

3. 模型推理

ICudaEngine对象中存放着经过TensorRT优化后的模型,不过如果要用模型进行推理则还需要通过createExecutionContext()函数去创建一个IExecutionContext对象来管理推理的过程:

nvinfer1::IExecutionContext *context = engine->createExecutionContext();

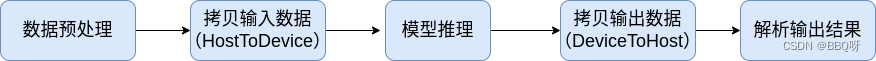

现在让我们先来看一下使用TensorRT框架进行模型推理的完整流程:

- 对输入图像数据做与模型训练时一样的预处理操作。

- 把模型的输入数据从

CPU拷贝到GPU中。 - 调用模型推理接口进行推理。

- 把模型的输出数据从

GPU拷贝到CPU中。 - 对模型的输出结果进行解析,进行必要的后处理后得到最终的结果。

由于模型的推理是在GPU上进行的,所以会存在搬运输入、输出数据的操作,因此有必要在GPU上创建内存区域用于存放输入、输出数据。模型输入、输出的尺寸可以通过ICudaEngine对象的接口来获取,根据这些信息我们可以先为模型分配输入、输出缓存区。

- void *buffers[2];

- // 获取模型输入尺寸并分配GPU内存

- nvinfer1::Dims input_dim = engine->getBindingDimensions(0);

- int input_size = 1;

- for (int j = 0; j < input_dim.nbDims; ++j) {

- input_size *= input_dim.d[j];

- }

- cudaMalloc(&buffers[0], input_size * sizeof(float));

-

- // 获取模型输出尺寸并分配GPU内存

- nvinfer1::Dims output_dim = engine->getBindingDimensions(1);

- int output_size = 1;

- for (int j = 0; j < output_dim.nbDims; ++j) {

- output_size *= output_dim.d[j];

- }

- cudaMalloc(&buffers[1], output_size * sizeof(float));

-

- // 给模型输出数据分配相应的CPU内存

- float *output_buffer = new float[output_size]();

到这一步,如果你的输入数据已经准备好了,那么就可以调用TensorRT的接口进行推理了。通常情况下,我们会调用IExecutionContext对象的enqueueV2()函数进行异步地推理操作,该函数的第二个参数为CUDA流对象,第三个参数为CUDA事件对象,这个事件表示该执行流中输入数据已经使用完,可以挪作他用了。如果对CUDA的流和事件不了解,可以参考我之前写的这篇文章。

- cudaStream_t stream;

- cudaStreamCreate(&stream);

- // 拷贝输入数据

- cudaMemcpyAsync(buffers[0], input_blob,input_size * sizeof(float),

- cudaMemcpyHostToDevice, stream);

- // 执行推理

- context->enqueueV2(buffers, stream, nullptr);

- // 拷贝输出数据

- cudaMemcpyAsync(output_buffer, buffers[1],output_size * sizeof(float),

- cudaMemcpyDeviceToHost, stream);

-

- cudaStreamSynchronize(stream);

模型推理成功后,其输出数据被拷贝到output_buffer中,接下来我们只需按照YOLOv5的输出数据排布规则去解析即可。