- 1鸿蒙HarmonyOS实战-ArkTS语言基础类库(并发)_arkts线程_harmonyos arkts代码例子

- 2共识机制汇总ing_21.共识机制结果值目标值的判定是如何判定

- 3linux查看zookeep进程,zookeeper可以查看进程启动,但是状态显示报错:Error contacting service. It is probably not running...

- 4【Hydro】SCS-CN方法中径流曲线数的确定(下)_scs曲线

- 5RK3568-emmc控制器_emmc adma3

- 6海思SD3403,SS928/926,hi3519dv500,hi3516dv500移植yolov7,yolov8(3)_ss928移植

- 7消费者人群画像—信用智能评分 :信用分预测_一、消费者人群画像—信用智能评分器

- 8Go语言框架中如何快速集成限流中间件_goframe 限流中间件

- 9datawhale动手学大模型应用开发-第一章-大模型简介_datawhale rag

- 10Java面试宝典-2017_java面试宝典是什么

【InternLM 大模型实战】第一课_interlm

赞

踩

前言

环境背景

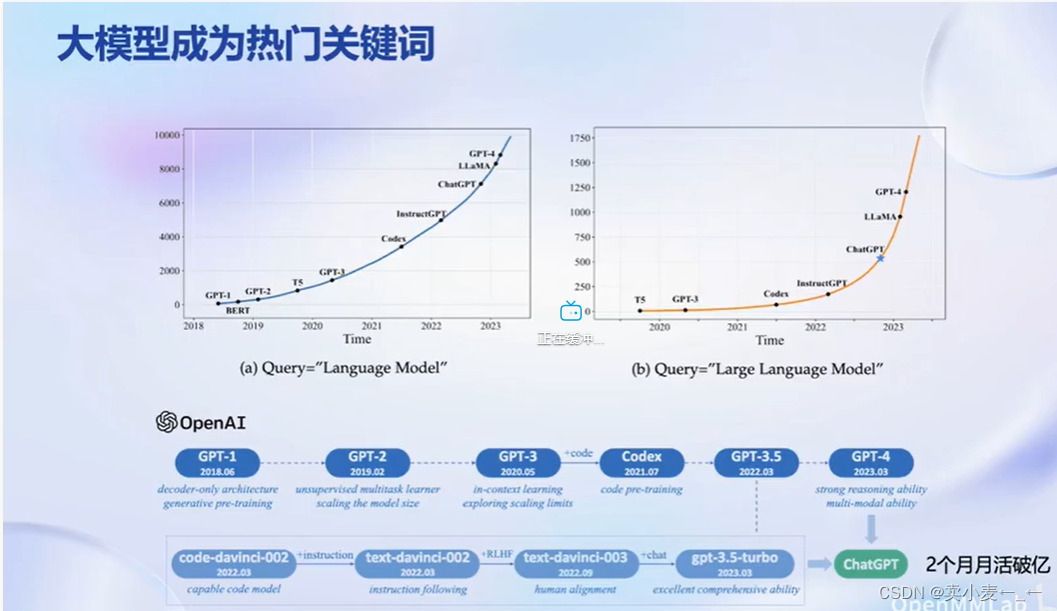

大模型受到广泛关注,chatgpt发布后两个月内月活破亿。

大模型是通向人工智能的关键,是从专用模型到通用模型的重要途径。

专用模型是针对单一任务,而通用大模型是则是面向多任务,多模态,是面向更高阶的智能的潜在途径。

开源历程

上海人工智能发布的大模型——书生浦语的开源历程

开源模型

到目前书生浦语大模型一共发布三个模型,分别是7B,20B,123B

7B:70亿参数,小巧轻便方便部署,并且支持8k长语境长度,是当前社区低成本可用最佳规模,

20B: 200亿参数,在模型推理能力与推理代价间取得平衡,采用深而窄的结构,降低推理计算量但提高了推理能力。虽只有LIama2-70B的三分之一不到的参数量,但性能却直逼Llama2-70B,是一款商业场景下可开发定制高精度较小规模模型。

123B:千亿参数量使得该模型具备极强的推理能力,全面的只是覆盖面以及超强的理解能力和对话能力

应用

大模型应用方向:智能客服、个人助手和行业应用

从模型到应用

如果业务场景不太复杂,例如想简单的对话,那就直接将模型部署应用即可

如果业务场景比较复杂,那就需要对模型进行微调,并且还要考虑算力能否支持全面微调,如果不支持就要去坐部分微调(如lora)

如果业务场景还有环境交互的需求,那就还需要构建智能体

全链条开源开放体系

数据

1、书生万卷

多模态融合,精细化处理,价值观对齐

2、 openDatalab

丰富多样的开放数据平台,除了文本,图像和视频外还有音频等数据

预训练

1、高可扩展

支持多卡甚至千卡训练

2、极致性能优化

采用Hybrid Zero独特技术+极致优化,加速50%

3、兼容主流

无缝接入huggingFace灯技术生态

4、开箱即用

微调

在大语言模型的下游应用中,增量续训和有监督微调是经常会用到两种方式。

1、增量续训

使用场景:让基座模型学习到一些新知识,例如某个垂直领域知识

训练数据:文章,书籍,代码等

2、有监督微调

使用场景:让模型学会理解和遵循各种指令,或注入少量领域知识

训练数据:高质量的对话、问答数据

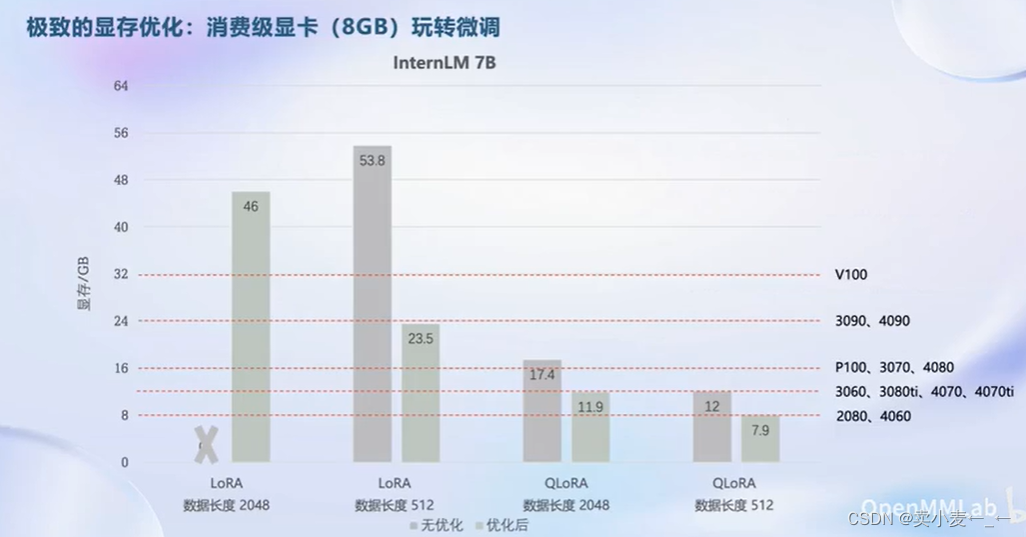

高效微调框架 XTuner

1、适配多种生态:

支持多种微调算法

适配多种开原生态,如huggingface和modelScope

自动优化加速

2、适配多种硬件

支持nvidia20系以上所有显卡。

只需8g显存即可微调7b模型

评测

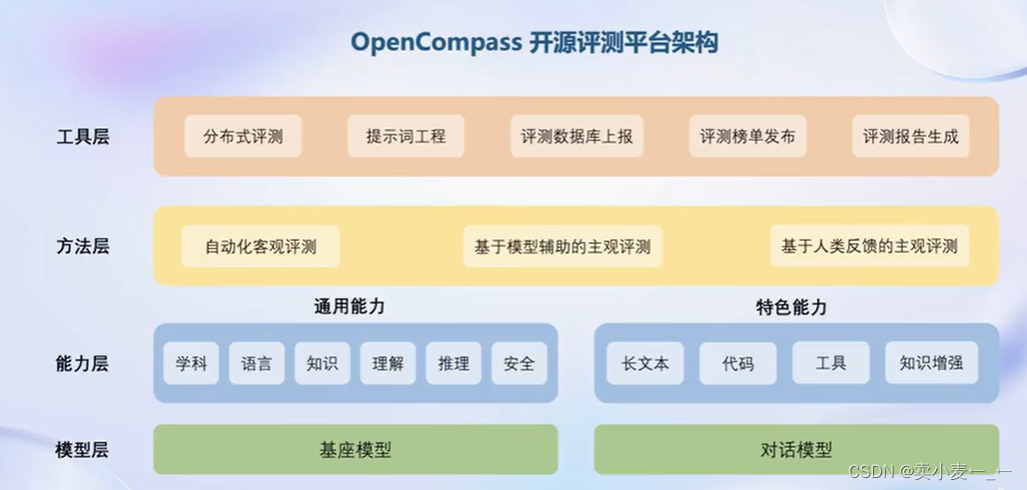

全球比较领先的开源大模型评测体系

OpenCompass 开源评测平台架构

1、丰富的模型支持

可做一站式的评测

2、分布式高效评测

支持迁移参数在海量数据集上分布式评测

3、便捷的数据集接口

支持用户根据自身需求去修改或添加评测内容

4、敏捷的能力迭代

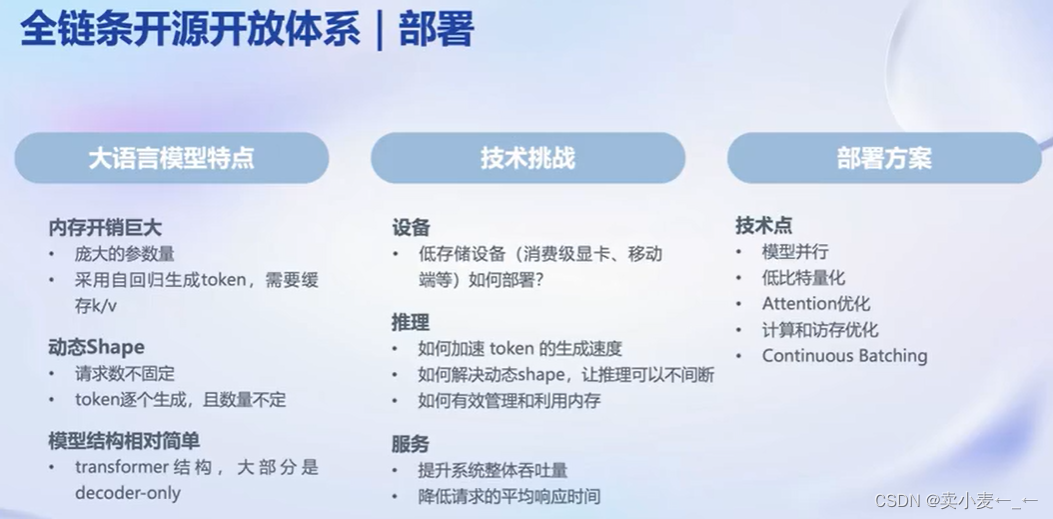

部署

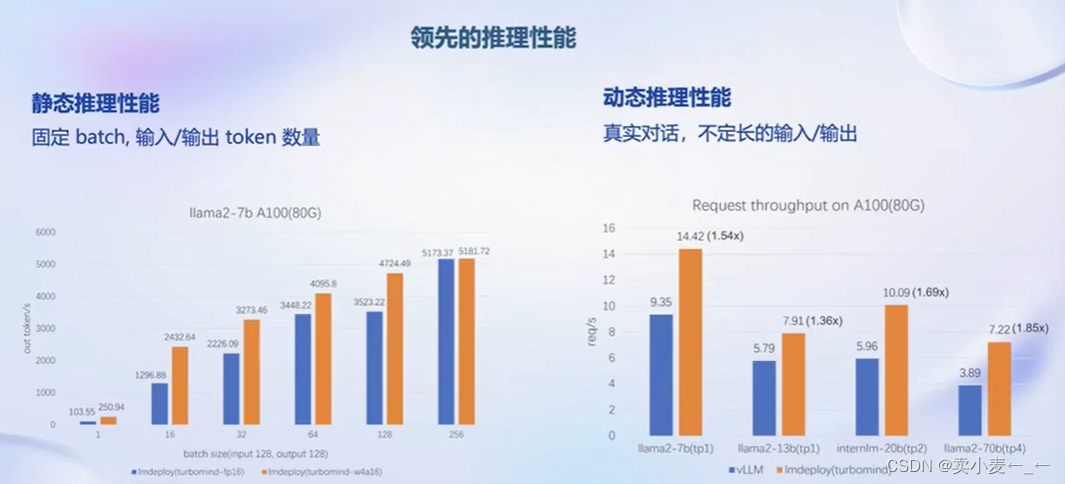

LMdeploy 大模型部署的全流程解决方案

1、高效推理引擎

持续的批处理策略

高效的k/v缓存管理

2、完备易用的工具链

量化,推理,服务全流程

和openai接口高度兼容的api server

LMdeploy 推理性能

智能体

大语言模型的局限性

最新信息和知识的获取

回复的可靠性

数学计算

工具使用和交互

轻量级智能体框架 Lagent

1、灵活支持多种大语言模型

例如gpt-3.5/4 Llama huggingface

2、简单易拓展,支持丰富的工具

3、支持多种类型的智能体能力

例如ReAct,ReWoo,AutoGPT

AgentLego 多模态智能体工具箱